1.解压安装包

--解压hive安装包

tar -zxvf apache-hive-3.1.2-bin.tar.gz -C /opt/softs/

--修改名字

mv apache-hive-3.1.2-bin/ hive3.1.2

2.配置Hive路径

vim /etc/profile

--修改配置文件

#HIVE_HOME

export HIVE_HOME=/opt/softs/hive3.1.2

export PATH=$PATH:$HIVE_HOME/bin

export PATH=$PATH:$HIVE_HOME/sbin

source /etc/profile

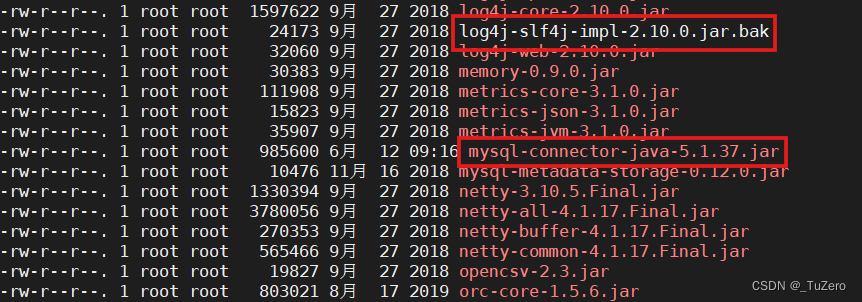

echo $HIVE_HOME2.在 /opt/softs/hive3.1.2/lib/下添加文件

--修改名称

mv log4j-slf4j-impl-2.10.0.jar log4j-slf4j-impl-2.10.0.jar .bak

--添加文件

cp /opt/jar/mysql-connector-java-5.1.37.jar /opt/softs/hiv e3.1.2/lib/

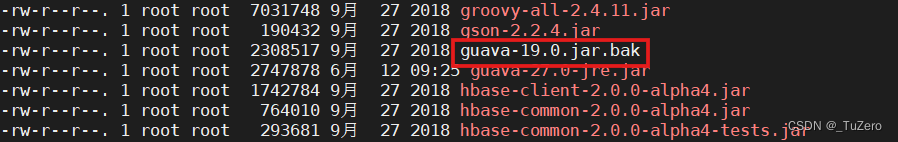

cp /opt/softs/hadoop3.1.3/share/hadoop/common/lib/guava-27 .0-jre.jar /opt/softs/hive3.1.2/lib/

--修改名称 .jar改为.jar.bak

mv guava-19.0.jar guava-19.0.jar.bak

2.添加配置文件

(1)在/opt/softs/hive3.1.2/conf/中添加hive-site.xml

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<!-- jdbc 连接的 URL hostname根据实际进行修改 -->

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://bigdata02:3306/hive?createDatabaseIfNotExist=true&useSSL=false&useUnicode=true&characterEncoding=UTF-8</value>

</property>

<!-- jdbc 连接的 Driver-->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<!-- jdbc 连接的 username-->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<!-- jdbc 连接的 password root密码根据实际修改-->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<!-- Hive 默认在 HDFS 的工作目录 -->

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<!-- 指定 hiveserver2 连接的 host hive的安装host根据实际进行修改 -->

<property>

<name>hive.server2.thrift.bind.host</name>

<value>bigdata02</value>

</property>

<!-- 指定 hiveserver2 连接的端口号 -->

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

</property>

<!-- yarn作业获取到的hiveserver2用户都为hive用户 -->

<property>

<name>hive.server2.enable.doAs</name>

<value>false</value>

</property>

<!-- hiveserver2的高可用参数,开启此参数可以提高hiveserver2的启动速度 -->

<property>

<name>hive.server2.active.passive.ha.enable</name>

<value>true</value>

</property>

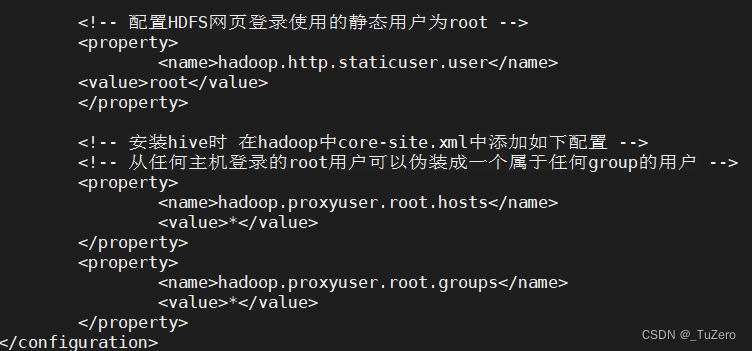

</configuration>(2)在/opt/softs/hadoop3.1.3/etc/hadoop/core-site.xml中添加代码

<!-- 安装hive时 在hadoop中core-site.xml中添加如下配置 -->

<!-- 从任何主机登录的root用户可以伪装成一个属于任何group的用户 -->

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

--复制到另外两台虚拟机

scp core-site.xml root@bigdata03:/opt/softs/hadoop3.1.3/etc/hadoop/core-site.xml

scp core-site.xml root@bigdata04:/opt/softs/hadoop3.1.3/etc/hadoop/core-site.xml

--检查是否复制成功

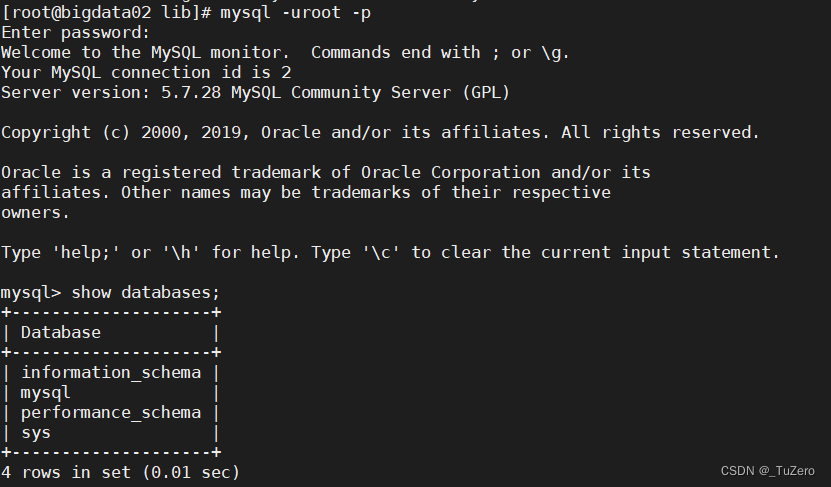

cat /opt/softs/hadoop3.1.3/etc/hadoop/core-site.xml4.初始化元数据库

-- 初始化hive的元数据库(mysql启动状态下)

schematool -dbType mysql -initSchema

![]()

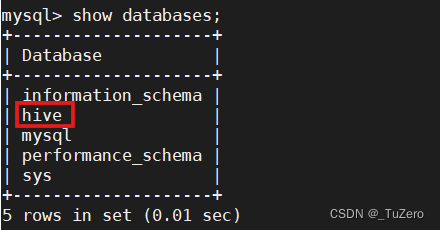

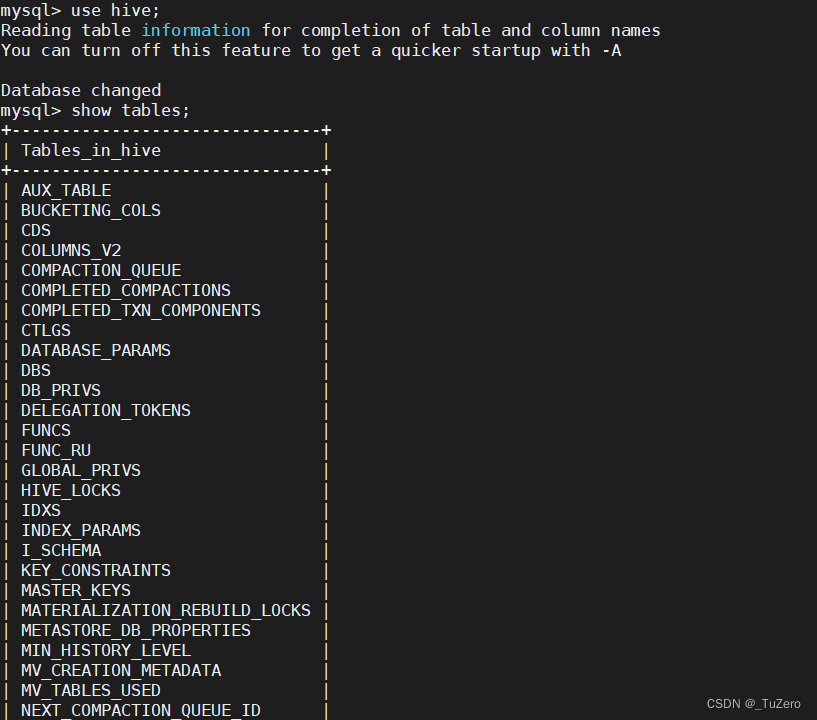

3.查看MySQL数据库

初始化hive的元数据库后

查看表

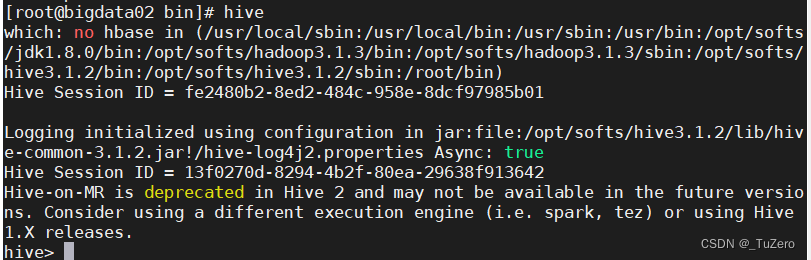

5.启动hive

--先启动dfs

start-dfs.sh

--启动hive

hive

--退出hive

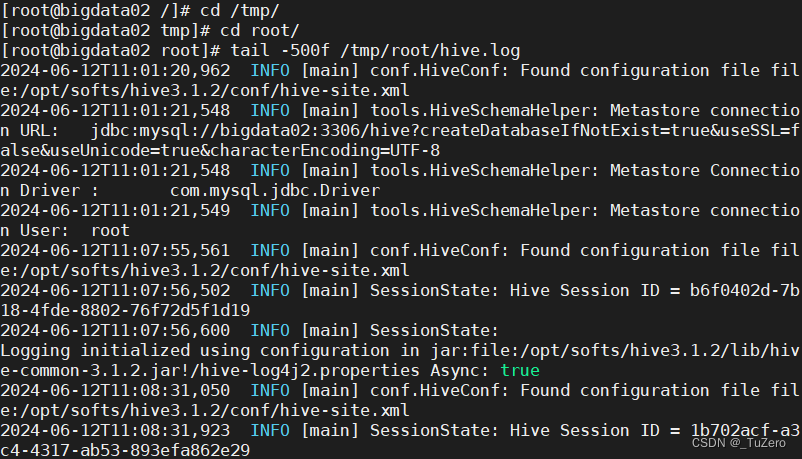

hive> quit;6.可以在tmp中查看hive日志

tail -500f /tmp/root/hive.log

261

261

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?