1.部署hadoop

下载hadoop,本案例用到2.7.7版本

官网下载 hadoop-2.7.7.tar.gz

解压 tar -zxvf hadoop-2.7.7.tar.gz /usr/local/

修改名称 mv hadoop-2.7.7 hadoop

配置全局变量

vi /etc/profile 最后面添上

#hadoop

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

保存:wq 最后 source /etc/profile 更新文件生效

cd /usr/local/hadoop/etc/hadoop 如下目录

在core-site.xml最后添加如下配置

<configuration>

<!-- 指定HDFSMaster(namenode)的通信地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://0.0.0.0:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储路径 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/larry/hadoop/temp</value>

</property>

</configuration>

在hdfs-stie.xml最后添加如下配置

<configuration>

<!--设置hdfs副本数量 -->

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

</configuration>

hadoop-env.sh配置文件

最后面加

export JAVA_HOME=/usr/local/java/jdk1.8.0_291

hadoop需要依赖jdk环境

启动hadoop

cd /usr/local/hadoop/sbin

./start-all.sh

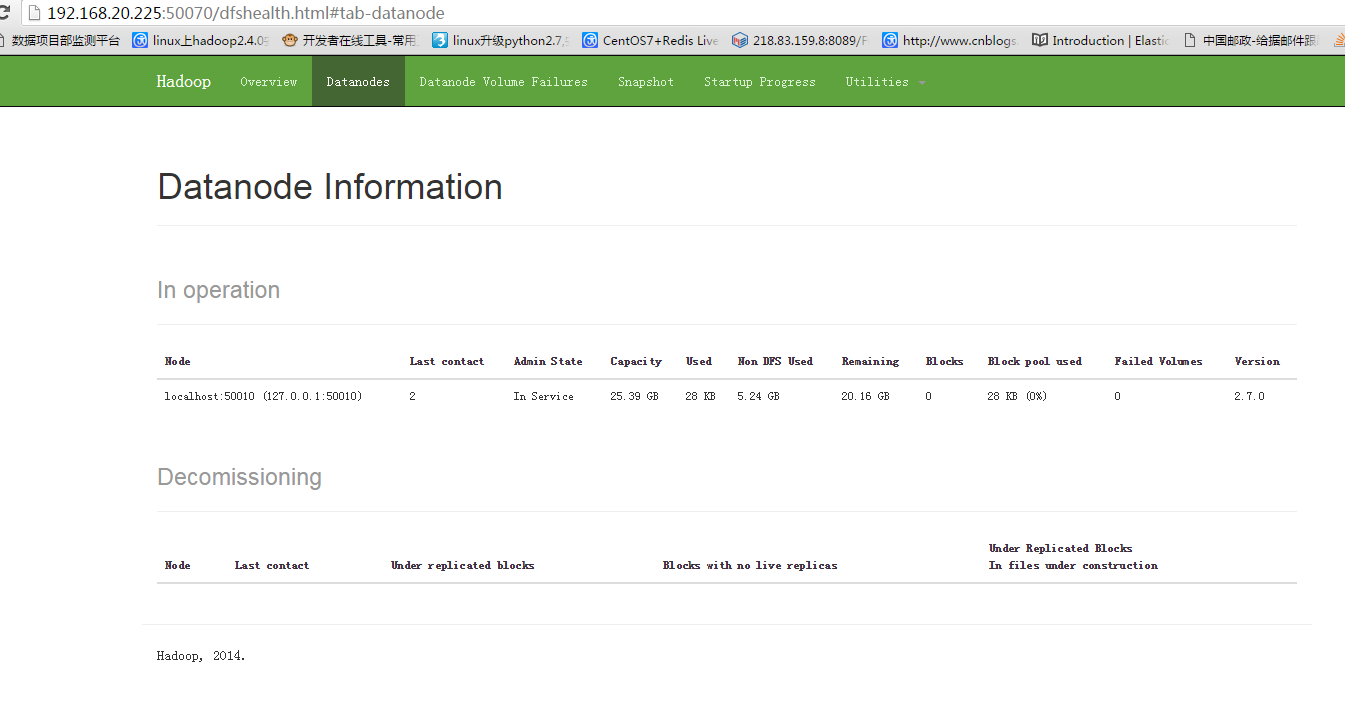

看到此界面就算部署完成

2.部署spark

下载spark2.3.2

官网下载 spark-2.3.2-bin-hadoop2.7.tgz

同样是解压到/usr/local

配置下全局变量

官网下载 scala

配置方式很简单,不多说。

找到 spark-env.sh

最后面添加

export JAVA_HOME=/usr/local/java/jdk1.8.0_291

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop

export SCALA_HOME=/usr/local/scala

export SPARK_HOME=/usr/local/spark

export SPARK_MASTER_IP=127.0.0.1

export SPARK_MASTER_PORT=7077

export SPARK_MASTER_WEBUI_PORT=8099

export SPARK_WORKER_CORES=3

export SPARK_WORKER_INSTANCES=1

export SPARK_WORKER_MEMORY=5G

export SPARK_WORKER_WEBUI_PORT=8081

export SPARK_EXECUTOR_CORES=1

export SPARK_EXECUTOR_MEMORY=1G

export LD_LIBRARY_PATH=${LD_LIBRARY_PATH}:$HADOOP_HOME/lib/native

之后启动spark

./start-all.sh

成功之后出现如下界面

配置完环境之后需要开始实战开发应用

1.本次实战应用是统计文章出现最多的10个单词,找个英文的文档格式txt

源码如下

链接:https://pan.baidu.com/s/1dAasVc5S6x_6FAGD2l2EiQ

提取码:lary

//hdfs创建input文件夹

/hadoop/bin/hdfs dfs -mkdir input

//hdfs创建output文件夹

/hadoop/bin/hdfs dfs -mkdir output

//把需要统计的文章上传服务器

/hadoop/bin/hdfs dfs -put xxxxx.txt /input

在target目录下生成文件sparkwordcount-1.0-SNAPSHOT.jar,上传spark服务器 /jars 目录下

假设我的spark 192.168.133.128

spark/bin/spark-submit \

--master spark://192.168.133.128:7077 \

--class com.bolingcavalry.sparkwordcount.WordCount \

--executor-memory 1g \

--total-executor-cores 2 \

/usr/local/spark/jars/sparkwordcount-1.0-SNAPSHOT.jar \

192.168.133.128 \

9000 \

xxxx.txt

1370

1370

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?