一、数据读取

import pandas as pd

train_df=pd.read_csv('D:/AIproject/NLP_news_paper_classific/data/train_set.csv/train_set.csv',sep='\t',nrows=100)

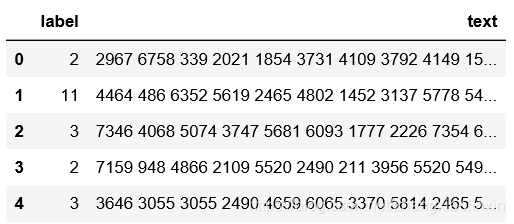

train_df.head()

二、数据分析

数据分析的目的:

(1)获得赛题数据中新闻文本的长度

(2)获得赛题数据类别分类的分布

(3)获得赛题数据字符的分布

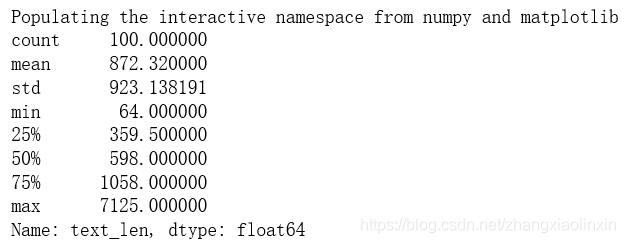

1、句子长度分析

观察前5行数据可知每行句子中的字符用空格隔开,可通过统计单词个数来计算每个句子长度。

%pylab inline

train_df['text_len'] = train_df['text'].apply(lambda x: len(x.split(' ')))

print(train_df['text_len'].describe())

绘制句子长度直方图

plt.hist(train_df['text_len'], bins=200)

plt.xlabel('Text char count')

plt.title("Histogram of char count")

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?