一、线性回归

1.线性回归的数学假设:假设输入的x和y是线性关系,输入的x和y满足,其中e为误差,满足均值为0,方差为某一确定值的正太分布

2.线性回归的建模:

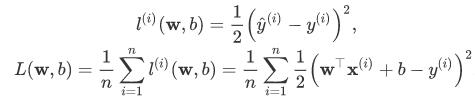

3.损失函数:简单的损失函数可以选择为平方损失

二、Softmax

对于神经网络中,直接使用输出层的输出有两个问题:

- 一方面,由于输出层的输出值的范围不确定,我们难以直观上判断这些值的意义。例如,刚才举的例子中的输出值10表示“很置信”图像类别为猫,因为该输出值是其他两类的输出值的100倍。但如果o1=o3=103o1=o3=103,那么输出值10却又表示图像类别为猫的概率很低。

- 另一方面,由于真实标签是离散值,这些离散值与不确定范围的输出值之间的误差难以衡量。

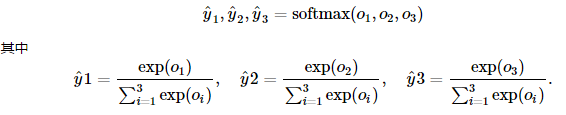

因此,softmax将输出值归一化为0到1的概率值:

三、交叉熵

训练目标可以设为预测概率分布尽可能接近真实的

. 由于我们其实并不需要预测概率完全等于标签概率,而平方损失则过于严格为了改进这个问题是使用更适合衡量两个概率分布差异的测量函数。其中,交叉熵(cross entropy)是一个常用的衡量方法:

![]()

交叉熵只关心对正确类别的预测概率,因为只要其值足够大,就可以确保分类结果正确。当然,遇到一个样本有多个标签时,例如图像里含有不止一个物体时,我们并不能做这一步简化。但即便对于这种情况,交叉熵同样只关心对图像中出现的物体类别的预测概率。

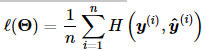

假设训练数据集的样本数为nn,交叉熵损失函数定义为:

其中Θ代表模型参数。

四、多层感知机

多层感知机(MLP,Multilayer Perceptron)也叫人工神经网络(ANN

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

512

512

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?