1_JAVA_并发

并发:

volatile: 内存可见性 、 防止指令重排序

volatile 使用场景:

1. 写入变量时不依赖变量当前值; 或者能够确保只有单一的线程修改变量的值

2. 变量不需要与其他的状态变量共同参与不变约束

3. 访问变量时,没有其他的原因需要加锁

乐观锁: 版本 , CAS 算法

悲观锁: synchronized , ReentrantLock

线程池 , ThreadLocal

ThreadPoolExecutor(

int corePoolSize,//核心线程数

int maximumPoolSize,//最大线程数

long keepAliveTime,//存活时间

TimeUnit unit,//单位

BlockingQueue workQueue,//阻塞队列

ThreadFactory threadFactory,//线程工厂

RejectedExecutionHandler handler//拒绝策略

)

// 拒绝策略

Abort 抛异常

Discard 悄悄扔掉

DiscardOld 扔掉最先的任务

CallerRuns 谁提交任务谁来执行

各个参数的配置

实现多线程的三种方式

Thread

Runnable

Callable

每个线程都有自己的程序计数器,栈,本地变量

编写线程安全的代码, 本质上都是管理对状态的访问,而且通常是共享的,可变的状态

线程安全: 在不可控的并发访问中保护数据

同步:

synchronized

volatile

显式锁

原子变量:

AtomicInteger

AtomicLong

AtomicReference

原子变量, 各个原子变量必须是独立的,更新一个变量时候要在同一个原子操作中更新其他几个

为了保护状态的一致性,要在单一的原子操作中更新互相关联的状态变量

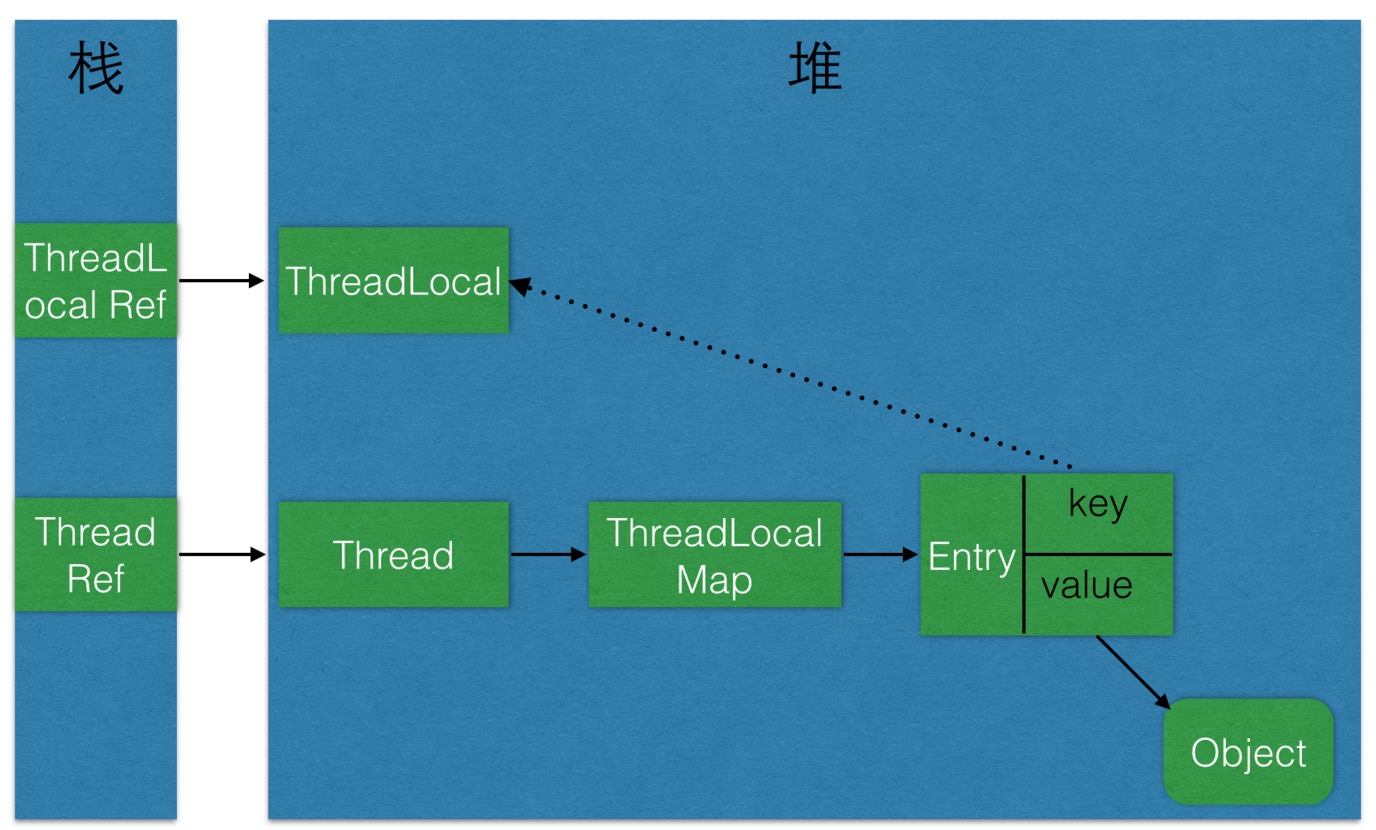

ThreadLocal

检查再运行 --> 惰性初始化

竞争条件

活跃度

性能

弱并发 poor concurrency

共享对象

内存可见性

非原子的64位操作: volatile

JVM

-server 模式

-client 模式

加锁 可以保证 可见性和原子性

volatile 只能保证可见性, 不保证原子性

发布和溢出

如果希望在构造函数中注册一个监听器或者启动线程, 可以创建一个私有的构造方法和一个公有的工厂方法

线程封闭

池化技术

Ad-hoc 线程限制

栈限制

不可变对象永远是线程安全的

1 、在java中守护线程和本地线程区别?

java中分为 守护线程(Daemon Thread)和用户线程(UserThread), 只要有一个用户线程在运行, 守护线程就

会一直运行,当所有用户线程都停止工作之后,守护线程就会随着JVM一起停止工作, 典型的守护线程就是

垃圾收集线程(GC)

thread.setDaemon(true); //必须在start线程之前就设置, 否则会出现 IllegalThreadStateException

守护线程中产生的新线程也是Daemon的

不是所有的应用都可以分配给Daemon来进行服务的,比如读写操作或者计算逻辑,一旦User退出了,

数据还没有来得及读入或者写出,计算任务也可能多次运行结果不一样.

2 、线程与进程的区别?

线程的概念

概念:线程是进程中执行运算最小的单位,是进程中的一个实体,是被系统独立调度和分配的,线程不自己拥有系统资源,只拥有运行中必不可少的资源,但是它可与同属于一个进程中其它线程共享所拥有的资源

一个线程可以创建和撤销另一个线程,同一进程中多个线程可以并发执行

线程和进程的区别

一个线程只属于一个进程,但是一个进程可以拥有多个线程,但至少一个线程

资源分配个进程,同一进程中所有线程共享该进程的所有资源。

3 、什么是多线程中的上下文切换?

从任务保存到再加载的过程就是一次上下文切换

如何减少上下文切换

既然上下文切换会导致额外的开销,因此减少上下文切换次数便可以提高多线程程序的运行效率。减少上下文切换的方法有无锁并发编程、CAS算法、使用最少线程和使用协程。

无锁并发编程。多线程竞争时,会引起上下文切换,所以多线程处理数据时,可以用一些办法来避免使用锁,如将数据的ID按照Hash取模分段,不同的线程处理不同段的数据

CAS算法。Java的Atomic包使用CAS算法来更新数据,而不需要加锁

使用最少线程。避免创建不需要的线程,比如任务很少,但是创建了很多线程来处理,这样会造成大量线程都处于等待状态

协程。在单线程里实现多任务的调度,并在单线程里维持多个任务间的切换

4 、死锁与活锁的区别,死锁与饥饿的区别?

死锁:是指两个或两个以上的进程(或线程)在执行过程中,因争夺资源而造成的一种互相等待的现象,若无外力作用,它们都将无法推进下去。

产生死锁的必要条件:

互斥条件:所谓互斥就是进程在某一时间内独占资源。

请求与保持条件:一个进程因请求资源而阻塞时,对已获得的资源保持不放。

不剥夺条件:进程已获得资源,在末使用完之前,不能强行剥夺。

循环等待条件:若干进程之间形成一种头尾相接的循环等待资源关系。

活锁:任务或者执行者没有被阻塞,由于某些条件没有满足,导致一直重复尝试,失败,尝试,失败。

活锁和死锁的区别在于,处于活锁的实体是在不断的改变状态,所谓的“活”, 而处于死锁的实体表现为等待;活锁有可能自行解开,死锁则不能。

饥饿:一个或者多个线程因为种种原因无法获得所需要的资源,导致一直无法执行的状态。

Java中导致饥饿的原因:

高优先级线程吞噬所有的低优先级线程的CPU时间。

线程被永久堵塞在一个等待进入同步块的状态,因为其他线程总是能在它之前持续地对该同步块进行访问。

线程在等待一个本身也处于永久等待完成的对象(比如调用这个对象的wait方法),因为其他线程总是被持续地获得唤醒。

5 、Java中用到的线程调度算法是什么?

抢占式。一个线程用完CPU之后,操作系统会根据线程优先级、线程饥饿情况等数据算出一个总的优先级并分配下一个时间片给某个线程执行

6 、什么是线程组,为什么在Java中不推荐使用?

之所以要提出“线程组”的概念,一般认为,是由于“安全”或者“保密”方面的理由。根据Arnold和Gosling的说法:“线程组中的线程可以修改组内的其他线程,包括那些位于分层结构最深处的。一个线程不能修改位于自己所在组或者下属组之外的任何线程”

线程组ThreadGroup对象中的stop,resume,suspend会导致安全问题,主要是死锁问题,已经被官方废弃,多以价值已经大不如以前。

线程组ThreadGroup不是线程安全的,在使用过程中不能及时获取安全的信息。

7 、为什么使用Executor框架?

什么是 Executor框架?

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ZK2Gea3O-1618135569555)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404093819705.png)]

oskernel操作系统核心包括操作系统软件和应用,只是操作系统最基本的功能,例如内存管理,进程管理,硬件驱动等

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ap8rsqc2-1618135569557)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404094308329.png)]

Executors 框架类图, 涉及的核心类:

Executor 接口

ExecutorService extends Executor 接口

//等待之前提交的任务执行完成之后就关闭,不接受新提交的任务

void shutdowm();

//

List shutdownNow();

// 是否已经关闭

boolean isShutdown();

//如果在shutdown之后,所有任务都完成,返回true, 如果在这之前没有调用 shutdown() 或者shutdownNow() 则返回false

boolean isTerminated();

//

boolean awaitTermination(long timeout,TimeUnit unit) throws InterruptedException;

Future submit(Callable task);

Future submit(Runnable task , T result);

Future<?> submit(Runnable task);

List<Future> invokeAll(Collection<? extends Callable> tasks) throws InterruptedException;

List<Future> invokeAll(Collection<? extends Callable> tasks,

long timeout, TimeUnit unit)

throws InterruptedException;

T invokeAny(Collection<? extends Callable> tasks) throws

InterruptedException,ExecutionException;

T invokeAny(Collection<? extends Callable> tasks, long timeout, TimeUnit unit)

throws InterruptedException, ExecutionException, TimeoutException;

ScheduledExecutorService

Executors

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Q8P7RVS9-1618135569558)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404111149473.png)]

public static ExecutorService newFixedThreadPool(int nThreads) {

return new ThreadPoolExecutor(nThreads, nThreads,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue());

}

1、如果当前运行的线程数少于corePoolSize,则创建新线程来执行任务。

2、在线程池完成预热之后(当前运行的线程数等于corePoolSize),将任务加入LinkedBlockingQueue。

3、线程执行完1中的任务后,会在循环中反复从LinkedBlockingQueue获取任务来执行。

FixedThreadPool使用无界队列LinkedBlockingQueue作为线程池的工作队列(队列的容量为Integer.MAX_VALUE)。使用无界队列作为工作队列会对线程池带来如下影响

1、当线程池中的线程数达到corePoolSize后,新任务将在无界队列中等待,因此线程池中的线程数不会超过corePoolSize。

2、由于1,使用无界队列时maximumPoolSize将是一个无效参数。

3、由于1和2,使用无界队列时keepAliveTime将是一个无效参数。

4、由于使用无界队列,运行中的FixedThreadPool(未执行方法shutdown()或shutdownNow())不会拒绝任务(不会调用RejectedExecutionHandler.rejectedExecution方法)。

fixedThreadPool 使用场景

FixedThreadPool适用于为了满足资源管理的需求,而需要限制当前线程数量的应用场景,它适用于负载比较重的服务器

singleThreadExecutor

public static ExecutorService newSingleThreadExecutor() {

return new FinalizableDelegatedExecutorService

(new ThreadPoolExecutor(1, 1,0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue()));

}

public static ExecutorService newSingleThreadExecutor(ThreadFactory threadFactory) {

return new FinalizableDelegatedExecutorService

(new ThreadPoolExecutor(1, 1,0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue(),threadFactory));

}

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-14ZyDNiX-1618135569559)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404114346358.png)]

1、如果当前运行的线程数少于corePoolSize(即线程池中无运行的线程),则创建一个新线程来执行任务。

2、在线程池完成预热之后(当前线程池中有一个运行的线程),将任务加入LinkedBlockingQueue。

3、线程执行完1中的任务后,会在一个无限循环中反复从LinkedBlockingQueue获取任务来执行。

使用场景

SingleThreadExecutor适用于需要保证顺序地执行各个任务;并且在任意时间点,不会有多个线程是活动的应用场景。

CachedThreadPool

public static ExecutorService newCachedThreadPool() {

return new ThreadPoolExecutor(0, Integer.MAX_VALUE,

60L, TimeUnit.SECONDS,

new SynchronousQueue());

}

public static ExecutorService newCachedThreadPool(ThreadFactory threadFactory) {

return new ThreadPoolExecutor(0, Integer.MAX_VALUE,

60L, TimeUnit.SECONDS,

new SynchronousQueue(),

threadFactory);

}

CachedThreadPool的corePoolSize被设置为0,即corePool为空;maximumPoolSize被设置为Integer.MAX_VALUE,即maximumPool是无界的。这里把keepAliveTime设置为60L,意味着CachedThreadPool中的空闲线程等待新任务的最长时间为60秒,空闲线程超过60秒后将会被终止。

FixedThreadPool和SingleThreadExecutor使用无界队列LinkedBlockingQueue作为线程池的工作队列。CachedThreadPool使用没有容量的SynchronousQueue作为线程池的工作队列,但CachedThreadPool的maximumPool是无界的。这意味着,如果主线程提交任务的速度高于maximumPool中线程处理任务的速度时,CachedThreadPool会不断创建新线程。极端情况下,CachedThreadPool会因为创建过多线程而耗尽CPU和内存资源

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-YhJvlS8v-1618135569560)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404115557110.png)]

SynchronousQueue

1、首先执行SynchronousQueue.offer(Runnable task)。如果当前maximumPool中有空闲线程正在执行SynchronousQueue.poll(keepAliveTime,TimeUnit.NANOSECONDS),那么主线程执行offer操作与空闲线程执行的poll操作配对成功,主线程把任务交给空闲线程执行,execute()方法执行完成;否则执行下面的步骤2)。

2、当初始maximumPool为空,或者maximumPool中当前没有空闲线程时,将没有线程执行SynchronousQueue.poll

(keepAliveTime,TimeUnit.NANOSECONDS)。这种情况下,步骤1)将失败。此时CachedThreadPool会创建一个新线程执行任务,execute()方法执行完成。

3、在步骤2)中新创建的线程将任务执行完后,会执行SynchronousQueue.poll(keepAliveTime,

TimeUnit.NANOSECONDS)。这个poll操作会让空闲线程最多在SynchronousQueue中等待60秒钟。如果60秒钟内主线程提交了一个新任务(主线程执行步骤1)),那么这个空闲线程将执行主线程提交的新任务;否则,这个空闲线程将终止。由于空闲60秒的空闲线程会被终止,因此长时间保持空闲的CachedThreadPool不会使用任何资源。

前面提到过,SynchronousQueue是一个没有容量的阻塞队列。每个插入操作必须等待另一个线程的对应移除操作,反之亦然。CachedThreadPool使用SynchronousQueue,把主线程提交的任务传递给空闲线程执行。CachedThreadPool中任务传递的示意图如下图所示:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-oPzkqfy6-1618135569561)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404120303997.png)]

使用场景

看名字我们可以知道cached缓存,CachedThreadPool可以创建一个可根据需要创建新线程的线程池,但是在以前构造的线程可用时将重用它们,对于执行很多短期异步任务的程序而言,这些线程池通常可提高程序性能。调用 execute 将重用以前构造的线程(如果线程可用)。如果现有线程没有可用的,则创建一个新线程并添加到池中。

CachedThreadPool是大小无界的线程池,适用于执行很多的短期异步任务的小程序,或者是负载较轻的服务器。

ThreadFactory

AbstractExecutorService

ThreadPoolExecutor

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue workQueue) {

this(corePoolSize, maximumPoolSize, keepAliveTime, unit, workQueue,

Executors.defaultThreadFactory(), defaultHandler);

}

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue workQueue,

ThreadFactory threadFactory) {

this(corePoolSize, maximumPoolSize, keepAliveTime, unit, workQueue,

threadFactory, defaultHandler);

}

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue workQueue,

RejectedExecutionHandler handler) {

this(corePoolSize, maximumPoolSize, keepAliveTime, unit, workQueue,

Executors.defaultThreadFactory(), handler);

}

public ThreadPoolExecutor(int corePoolSize,

int maximumPoolSize,

long keepAliveTime,

TimeUnit unit,

BlockingQueue workQueue,

ThreadFactory threadFactory,

RejectedExecutionHandler handler)

BlockingQueue

Queue

ScheduledThreadPoolExecutor

ScheduledThreadPoolExecutor继承自ThreadPoolExecutor。它主要用来在给定的延迟之后运行任务,或者定期执行任务。ScheduledThreadPoolExecutor的功能与Timer类似,但ScheduledThreadPoolExecutor功能更强大、更灵活。Timer对应的是单个后台线程,而ScheduledThreadPoolExecutor可以在构造函数中指定多个对应的后台线程数

Executors中创建:

public static ScheduledExecutorService newScheduledThreadPool(int corePoolSize) {

return new ScheduledThreadPoolExecutor(corePoolSize);

}

ScheduledThreadPoolExecutor 构造器

public ScheduledThreadPoolExecutor(int corePoolSize) {

super(corePoolSize, Integer.MAX_VALUE, 0, NANOSECONDS, new DelayedWorkQueue());

}

public ScheduledThreadPoolExecutor(int corePoolSize,

RejectedExecutionHandler handler) {

super(corePoolSize, Integer.MAX_VALUE, 0, NANOSECONDS, new DelayedWorkQueue(), handler);

}

public ScheduledThreadPoolExecutor(int corePoolSize,

ThreadFactory threadFactory) {

super(corePoolSize, Integer.MAX_VALUE, 0, NANOSECONDS, new DelayedWorkQueue(), threadFactory);

}

public ScheduledThreadPoolExecutor(int corePoolSize,

ThreadFactory threadFactory,

RejectedExecutionHandler handler) {

super(corePoolSize, Integer.MAX_VALUE, 0, NANOSECONDS,

new DelayedWorkQueue(), threadFactory, handler);

}

SingleThreadScheduledExecutor

public static ScheduledExecutorService newSingleThreadScheduledExecutor() {

return new DelegatedScheduledExecutorService (new ScheduledThreadPoolExecutor(1));

}

public static ScheduledExecutorService newSingleThreadScheduledExecutor(ThreadFactory threadFactory) {

return new DelegatedScheduledExecutorService (new ScheduledThreadPoolExecutor(1, threadFactory));

}

运行过程

DelayQueue是一个无界队列,所以ThreadPoolExecutor的maximumPoolSize在ScheduledThreadPoolExecutor中没有什么意义(设置maximumPoolSize的大小没有什么效果)。ScheduledThreadPoolExecutor的执行主要分为两大部分。

1、当调用ScheduledThreadPoolExecutor的scheduleAtFixedRate()方法或者scheduleWithFixedDelay()方法时,会向ScheduledThreadPoolExecutor的DelayQueue添加一个实现了RunnableScheduledFuture接口的ScheduledFutureTask。

2、线程池中的线程从DelayQueue中获取ScheduledFutureTask,然后执行任务。

下面看看ScheduedThreadPoolExecutor运行过程示意图

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-9sJzs6d9-1618135569562)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404160320483.png)]

ScheduledThreadPoolExecutor为了实现周期性的执行任务,对ThreadPoolExecutor做了如下

的修改。

1、使用DelayQueue作为任务队列。

2、获取任务的方式不同。

3、执行周期任务后,增加了额外的处理。

实现过程分析

ScheduledThreadPoolExecutor会把待调度的任务(ScheduledFutureTask)放到一个DelayQueue中。ScheduledFutureTask主要包含3个成员变量,如下。

1、long time,表示这个任务将要被执行的具体时间。

2、long sequenceNumber,表示这个任务被添加到ScheduledThreadPoolExecutor中的序号。

3、long period,表示任务执行的间隔周期。

DelayQueue封装了一个PriorityQueue,这个PriorityQueue会对队列中的ScheduledFutureTask进行排序。排序时,time小的排在前面(时间早的任务将被先执行)。如果两个ScheduledFutureTask的time相同,就比较sequenceNumber,sequenceNumber小的排在前面(也就是说,如果两个任务的执行时间相同,那么先提交的任务将被先执行)。首先,让我们看看ScheduledThreadPoolExecutor中的线程执行周期任务的过程。如下图所示

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-JU4uQ5LT-1618135569562)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404160544316.png)]

1、线程1从DelayQueue中获取已到期的ScheduledFutureTask(DelayQueue.take())。到期任务是指ScheduledFutureTask的time大于等于当前时间。

2、线程1执行这个ScheduledFutureTask。

3、线程1修改ScheduledFutureTask的time变量为下次将要被执行的时间。

4、线程1把这个修改time之后的ScheduledFutureTask放回DelayQueue中(DelayQueue.add())。

DelayQueue.take()的源码是如何实现的

public E take() throws InterruptedException {

final ReentrantLock lock = this.lock;

lock.lockInterruptibly(); // 1

try {

for (;😉 {

E first = q.peek();

if (first == null) {

available.await(); // 2.1

} else {

long delay = first.getDelay(TimeUnit.NANOSECONDS);

if (delay > 0) {

long tl = available.awaitNanos(delay); // 2.2

} else {

E x = q.poll(); // 2.3.1

assert x != null;

if (q.size() != 0)

available.signalAll(); // 2.3.2

return x;

}

}

}

} finally {

lock.unlock(); // 3

}

}

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-VDtkO5wX-1618135569563)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404160745097.png)]

1、获取Lock。

2、获取周期任务。

a、如果PriorityQueue为空,当前线程到Condition中等待;否则执行下面的2.2。

b、如果PriorityQueue的头元素的time时间比当前时间大,到Condition中等待到time时间;否则执行下面的2.3。

c、获取PriorityQueue的头元素(2.3.1);如果PriorityQueue不为空,则唤醒在Condition中等待的所有线程(2.3.2)。

3、释放Lock。

ScheduledThreadPoolExecutor在一个循环中执行步骤2,直到线程从PriorityQueue获取到一个元素之后(执行2.3.1之后),才会退出无限循环(结束步骤2)。

下面我来看看DelayQueue.add()源码实现

public boolean offer(E e) {

final ReentrantLock lock = this.lock;

lock.lock(); // 1

try {

E first = q.peek();

q.offer(e); // 2.1

if (first == null || e.compareTo(first) < 0)

available.signalAll(); // 2.2

return true;

} finally {

lock.unlock(); // 3

}

}

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-zvjGvl8o-1618135569564)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404161000576.png)]

1、获取Lock。

2、添加任务。

a、向PriorityQueue添加任务。

b、如果在上面2.1中添加的任务是PriorityQueue的头元素,唤醒在Condition中等待的所有线程。

3、释放Lock。

使用场景

SingleThreadScheduledExecutor适用于需要单个后台线程执行周期任务,同时需要保证顺序地执行各个任务的应用场景。

DelayedWorkQueue

RejectedExecutionHandler

Future

Runnable

RunnableAdapter

Callable

RunnableFuture

FutureTask

ReentrantLock

LinkedBlockingQueue

无界队列

8 、在Java中Executor和Executors的区别?

Executor 接口对象能执行我们的线程任务;

Executors 工具类的不同方法按照我们的需求创建了不同的线程池,来满足业务的需求。

ExecutorService 接口继承了Executor接口并进行了扩展,提供了更多的方法,我们能够获得任务执行的状态并且可以获取任务的返回值。

9 、如何在Windows和Linux上查找哪个线程使用的CPU时间最长?

Linux

(1)获取项目的pid,jps 或者 ps -ef | grep java

(2)top -H -p pid,顺序不能改变

这样就可以打印出当前的项目,每条线程占用CPU时间的百分比。注意这里打出的是LWP,也就是操作系统原生线程的线程号

使用”top -H -p pid”+”jps pid”可以很容易地找到某条占用CPU高的线程的线程堆栈,从而定位占用CPU高的原因,一般是因为不当的代码操作导致了死循环。

最后提一点,”top -H -p pid”打出来的LWP是十进制的,”jps pid”打出来的本地线程号是十六进制的,转换一下,就能定位到占用CPU高的线程的当前线程堆栈了。

windows

10 、什么是原子操作 ? 在JavaConcurrencyAPI中有哪些原子类?

原子操作 : 一个或多个操作在CPU执行过程中不被中断的特性 , 需要分清楚针对的是CPU指令级别还是高级语言级别。

比如:经典的银行转账场景,是语言级别的原子操作;

而当我们说volatile修饰的变量的复合操作,其原子性不能被保证,指的是CPU指令级别。二者的本质是一致的。

“原子操作”的实质其实并不是指“不可分割”,这只是外在表现,本质在于多个资源之间有一致性的要求,操作的中间态对外不可见。

比如:在32位机器上写64位的long变量有中间状态(只写了64位中的32位);银行转账操作中也有中间状态(A向B转账,A扣钱了,B还没来得及加钱)

原子类

AtomicBoolean

把 Boolean转成整型,再使用 compareAndSwapInt 进行操作的

AtomicInteger

AtomicIntegerArray

AtomicIntegerFieldUpdater

原子更新整型的字段的更新器

//创建原子更新器,并设置需要更新的对象类和对象的属性

private static AtomicIntegerFieldUpdater<User> ai = AtomicIntegerFieldUpdater.newUpdater(User.class, "age");

public static void main(String[] args) {

User u1 = new User("pangHu", 18);

//原子更新年龄,+1

System.out.println(ai.getAndIncrement(u1));

System.out.println(u1.getAge());

}

static class User {

private String name;

public volatile int age;

public User(String name, int age) {

this.name = name;

this.age = age;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public int getAge() {

return age;

}

public void setAge(int age) {

this.age = age;

}

}

代码详解

要想原子地更新字段类需要两步。第一步,因为原子更新字段类都是抽象类,每次使用的时候必须使用静态方法newUpdater()创建一个更新器,并且需要设置想要更新的类和属性。第二步,更新类的字段必须使用 public volatile 修饰

AtomicLong

AtomicLongArray

AtomicLongFieldUpdater

原子更新长整型字段的更新器

AtomicMarkableReference

原子更新带有标记位的引用类型,可以使用构造方法更新一个布尔类型的标记位和引用类型

AtomicReference

AtomicReferenceArray

AtomicReferenceFieldUpdater

原子更新引用类型的字段

AtomicStampedReference

原子更新带有版本号的引用类型

// JDK8 中新增加的原子类

DoubleAccumulator

DoubleAdder

LongAccumulator

LongAdder

这些类对应把 AtomicLong 等类的改进。比如 LongAccumulator 与 LongAdder 在高并发环境下比 AtomicLong 更高效。

Atomic、Adder在低并发环境下,两者性能很相似。但在高并发环境下,Adder 有着明显更高的吞吐量,但是有着更高的空间复杂度。

LongAdder其实是LongAccumulator的一个特例,调用LongAdder相当使用下面的方式调用LongAccumulator。

sum() 方法在没有并发的情况下调用,如果在并发情况下使用会存在计数不准。

LongAdder不可以代替AtomicLong ,虽然 LongAdder 的 add() 方法可以原子性操作,但是并没有使用 Unsafe 的CAS算法,只是使用了CAS的思想。

LongAdder其实是LongAccumulator的一个特例,调用LongAdder相当使用下面的方式调用LongAccumulator,LongAccumulator提供了比LongAdder更强大的功能,构造函数其中accumulatorFunction一个双目运算器接口,根据输入的两个参数返回一个计算值,identity则是LongAccumulator累加器的初始值。

11 、JavaConcurrencyAPI中的Lock接口(Lockinterface)是什么?对比同步它有什么优势?

已经在 jdk1.6 对 synchronized 做了优化, 性能提升了不少, 为啥还要使用Lock呢?

synchronized加锁是无法主动释放锁的,这就会涉及到死锁的问题

什么是死锁?

四个必要条件, 缺一不可: 互斥 、 不可剥夺 、 请求与保持 、 循环等待

互斥: 在一段时间内某资源仅为一个线程所占有。此时若有其他线程请求该资源,则请求线程只能等待

**不可剥夺:**线程所获得的资源在未使用完毕之前,不能被其他线程强行夺走,即只能由获得该资源的线程自己来释放(只能是主动释放)

**请求与保持:**线程已经保持了至少一个资源,但又提出了新的资源请求,而该资源已被其他线程占有,此时请求线程被阻塞,但对自己已获得的资源保持不放

**循环等待:**在发生死锁时必然存在一个进程等待队列{P1,P2,…,Pn},其中P1等待P2占有的资源,P2等待P3占有的资源,…,Pn等待P1占有的资源,形成一个进程等待环路,环路中每一个进程所占有的资源同时被另一个申请,也就是前一个进程占有后一个进程所申请的资源

synchronized的局限性: 如果我们的程序使用synchronized关键字发生了死锁时,synchronized关键是是无法破坏“不可剥夺”这个死锁的条件的。这是因为synchronized申请资源的时候, 如果申请不到, 线程直接进入阻塞状态了, 而线程进入阻塞状态, 啥都干不了, 也释放不了线程已经占有的资源。

然而,在大部分场景下,我们都是希望“不可剥夺”这个条件能够被破坏。也就是说对于“不可剥夺”这个条件,占用部分资源的线程进一步申请其他资源时, 如果申请不到, 可以主动释放它占有的资源, 这样不可剥夺这个条件就破坏掉了

锁设计: 响应中断 、 支持超时 、 非阻塞

(1)能够响应中断。 synchronized的问题是, 持有锁A后, 如果尝试获取锁B失败, 那么线程就进入阻塞状态, 一旦发生死锁, 就没有任何机会来唤醒阻塞的线程。 但如果阻塞状态的线程能够响应中断信号, 也就是说当我们给阻塞的线程发送中断信号的时候, 能够唤醒它, 那它就有机会释放曾经持有的锁A。 这样就破坏了不可剥夺条件了。

(2)支持超时。 如果线程在一段时间之内没有获取到锁, 不是进入阻塞状态, 而是返回一个错误, 那这个线程也有机会释放曾经持有的锁。 这样也能破坏不可剥夺条件。

(3)非阻塞地获取锁。 如果尝试获取锁失败, 并不进入阻塞状态, 而是直接返回, 那这个线程也有机会释放曾经持有的锁。 这样也能破坏不可剥夺条件。

// 支持中断的API

void lockInterruptibly() throws InterruptedException;

// 支持超时的API

boolean tryLock(long time, TimeUnit unit) throws InterruptedException;

// 支持非阻塞获取锁的API

boolean tryLock();

12 、什么是Executors框架?

为什么要引入Executor?

JDK1.5 引入, 解耦任务本身和任务的执行

Executor接口有哪些实现类?

DirectExecutor: 对于传入的任务,只有执行完成后execute才会有返回,同步执行任务

ThreadPerTaskExecutor: 对于每个任务,执行器都会创建一个新的线程去执行任务,异步执行任务

SerialExecutor: 对任务进行排队执行,会对传入的任务进行排队(FIFO顺序),然后从队首取出一个任务执行

ExecutorService

Executor接口提供的功能很简单,为了对它进行增强,出现了ExecutorService接口,ExecutorService继承了Executor,它在Executor的基础上增强了对任务的控制,同时包括对自身生命周期的管理,主要有四类:

关闭执行器,禁止任务的提交;

监视执行器的状态;

提供对异步任务的支持;

提供对批处理任务的支持。

对于Future,Future对象提供了对任务异步执行的支持,也就是说调用线程无需等待任务执行完成,提交待执行的任务后,就会立即返回往下执行。然后,可以在需要时检查Future是否有结果了,如果任务已执行完毕,通过Future.get()方法可以获取到执行结果——Future.get()是阻塞方法。

ScheduledExecutorService

ScheduledExecutorService 提供了一系列schedule方法,可以在给定的延迟后执行提交的任务,或者每个指定的周期执行一次提交的任务, 该接口继承了 ExecutorService

线程池作用

ThreadPoolExecutor是用来创建线程池的Executor,线程池概念与数据库连接池类似。

当有任务需要执行时,线程池会给该任务分配线程,如果当前没有可用线程,一般会将任务放进一个队列中,当有线程可用时,再从队列中取出任务并执行

线程池的引入,主要解决以下问题:

减少系统因为频繁创建和销毁线程所带来的开销;

自动管理线程,对使用方透明,使其可以专注于任务的构建。

Executors工厂可以创建不同类型的线程池,其中有以下几个参数:

maximumPoolSize限定了整个线程池的大小,

corePoolSize限定了核心线程池的大小,

corePoolSize≤maximumPoolSize(当相等时表示为固定线程池);

maximumPoolSize-corePoolSize表示非核心线程池。

线程池状态

ThreadPoolExecutor一共定义了5种线程池状态

RUNNING : 接受新任务, 且处理已经进入阻塞队列的任务

SHUTDOWN : 不接受新任务 , 但处理已经进入阻塞队列的任务

STOP : 不接受新任, 且不处理已经进入阻塞队列的任务, 同时中断正在运行的任务

TIDYING : 所有任务都已终止 , 工作线程数为0 , 线程转化为TIDYING状态并准备调用terminated方法

TERMINATED : terminated方法已经执行完成

各个状态之间的流转图:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-MKzNW9r4-1618135569564)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404211913063.png)]

Worker工作线程

当我们向线程池提交一个任务时,将创建一个工作线程——我们称之为Worker,Worker在逻辑上从属于【核心线程池】或【非核心线程池】,具体属于哪一种,要根据corePoolSize、maximumPoolSize、Worker总数进行判断。ThreadPoolExecutor中只有一种类型的线程,名叫Worker,它是ThreadPoolExecutor定义的内部类,同时封装着Runnable任务和执行该任务的Thread对象,我们称它为【工作线程】,它也是ThreadPoolExecutor唯一需要进行维护的线程

每个Worker对象都有一个Thread线程对象与它相对应 , 当任务需要执行的时候,实际是调用内部Thread对象的start方法,而Thread对象是在Worker的构造器中通过getThreadFactory().newThread(this)方法创建的,创建的Thread将Worker自身作为任务,所以当调用Thread的start方法时,最终实际是调用了Worker.run()方法,该方法内部委托给runWorker方法执行任务

工作线程的创建

execute方法内部调用了addWorker方法来添加工作线程并执行任务,整个addWorker的逻辑并不复杂,分为两部分:

第一部分是一个自旋操作,主要是对线程池的状态进行一些判断,如果状态不适合接受新任务,或者工作线程数超出了限制,则直接返回false。

第二部分才真正去创建工作线程并执行任务:首先将Runnable任务包装成一个Worker对象,然后加入到一个工作线程集合中(名为workers的HashSet),最后调用工作线程中的Thread对象的start方法执行任务,其实最终是委托到Worker的下面方法执行:

Doug Lea 在 ThreadPoolExecutor 中 写的 addWorker方法:

private boolean addWorker(Runnable firstTask, boolean core) {

retry:

for (;;) {

int c = ctl.get();

int rs = runStateOf(c);

// Check if queue empty only if necessary.

if (rs >= SHUTDOWN &&

! (rs == SHUTDOWN &&

firstTask == null &&

! workQueue.isEmpty()))

return false;

for (;;) {

int wc = workerCountOf(c);

if (wc >= CAPACITY ||

wc >= (core ? corePoolSize : maximumPoolSize))

return false;

if (compareAndIncrementWorkerCount(c))

break retry;

c = ctl.get(); // Re-read ctl

if (runStateOf(c) != rs)

continue retry;

// else CAS failed due to workerCount change; retry inner loop

}

}

boolean workerStarted = false;

boolean workerAdded = false;

Worker w = null;

try {

w = new Worker(firstTask);

final Thread t = w.thread;

if (t != null) {

final ReentrantLock mainLock = this.mainLock;

mainLock.lock();

try {

// Recheck while holding lock.

// Back out on ThreadFactory failure or if

// shut down before lock acquired.

int rs = runStateOf(ctl.get());

if (rs < SHUTDOWN ||

(rs == SHUTDOWN && firstTask == null)) {

if (t.isAlive()) // precheck that t is startable

throw new IllegalThreadStateException();

workers.add(w);

int s = workers.size();

if (s > largestPoolSize)

largestPoolSize = s;

workerAdded = true;

}

} finally {

mainLock.unlock();

}

if (workerAdded) {

t.start();

workerStarted = true;

}

}

} finally {

if (! workerStarted)

addWorkerFailed(w);

}

return workerStarted;

}

其中 用到了标签 retry:

break label直接跳出到标签处,不再执行循环代码;continue label,只是结束本轮循环,跳转到标签处,继续下一轮循环(本质上与单层循环的break和continue类似)

public class RetryDemo {

public static void main(String[] args) {

retryTest1();

//retryTest2();

}

public static void retryTest2(){

int count = 0;

retry:

for (int i=0; i<3; i++) {

for (int j=0; j<5; j++) {

count++;

if (count == 4) {

break retry;

}

System.out.print(count + " ");

}

}

}

public static void retryTest1(){

int count = 0;

retry:

for (int i=0; i<3; i++) {

for (int j=0; j<5; j++) {

count++;

if (count == 4) {

continue retry;

}

System.out.print(count + " ");

}

}

}

}

工作线程的执行

runWoker用于执行任务,整体流程如下:

while循环不断地通过getTask()方法从队列中获取任务(如果工作线程自身携带着任务,则执行携带的任务);

控制执行线程的中断状态,保证如果线程池正在停止,则线程必须是中断状态,否则线程必须不是中断状态;

调用task.run()执行任务;

处理工作线程的退出工作。

该方法确保正在停止的线程池(STOP/TIDYING/TERMINATED)不再接受新任务,如果有新任务那么该任务的工作线程一定是中断状态;确保正常状态的线程池(RUNNING/SHUTDOWN),其所执行的任务都是不能被中断的。

另外,getTask方法用于从任务队列中获取一个任务,如果获取不到任务,会跳出while循环,最终会通过processWorkerExit方法清理工作线程。

工作线程的清理

processWorkerExit的作用就是将该退出的工作线程清理掉,然后看下线程池是否需要终止。processWorkerExit执行完之后,整个工作线程的生命周期也结束了,可以通过下图来回顾下它的整个生命周期:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-vposoJ3g-1618135569565)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404224515487.png)]

线程池的调度流程

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-tfApiyv9-1618135569565)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210404224351733.png)]

execute的整个执行流程关键是下面两点:

如果工作线程数小于核心线程池上限(CorePoolSize),则直接新建一个工作线程并执行任务;

如果工作线程数大于等于CorePoolSize,则尝试将任务加入到队列等待以后执行。如果加入队列失败了(比如队列已满的情况),则在总线程池未满的情况下(CorePoolSize ≤ 工作线程数 < maximumPoolSize)新建一个工作线程立即执行任务,否则执行拒绝策略。

任务队列

阻塞队列就是在我们构建ThreadPoolExecutor对象时,在构造器中指定的。由于队列是外部指定的,所以根据阻塞队列的特性不同,Worker工作线程调用getTask方法获取任务的执行情况也不同

直接提交

即直接将任务提交给等待的工作线程,这时可以选择SynchronousQueue。因为SynchronousQueue是没有容量的,而且采用了无锁算法,所以性能较好,但是每个入队操作都要等待一个出队操作,反之亦然。

使用SynchronousQueue时,当核心线程池满了以后,如果不存在空闲的工作线程,则试图把任务加入队列将立即失败(execute方法中使用了队列的offer方法进行入队操作,而SynchronousQueue在调用offer时如果没有另一个线程等待出队操作,则会立即返回false),因此会构造一个新的工作线程(未超出最大线程池容量时)。

由于,核心线程池是很容易满的,所以当使用SynchronousQueue时,一般需要将 maximumPoolSizes设置得比较大,否则入队很容易失败,最终导致执行拒绝策略,这也是为什么Executors工作默认提供的缓存线程池使用SynchronousQueue作为任务队列的原因。

无界任务队列

无界任务队列我们的选择主要有LinkedTransferQueue、LinkedBlockingQueue(近似无界,构造时不指定容量即可),从性能角度来说LinkedTransferQueue采用了无锁算法,高并发环境下性能相对更好,但如果只是做任务队列使用相差并不大。

使用无界队列需要特别注意系统资源的消耗情况,因为当核心线程池满了以后,会首先尝试将任务放入队列,由于是无界队列所以几乎一定会成功,那么系统瓶颈其实就是硬件了。如果任务的创建速度远快于工作线程处理任务的速度,那么最终会导致系统资源耗尽。Executors工厂中创建固定线程池的方法内部就是用了LinkedBlockingQueue。

有界任务队列

有界任务队列,比如ArrayBlockingQueue ,可以防止资源耗尽的情况。当核心线程池满了以后,如果队列也满了,则会创建归属于非核心线程池的工作线程,如果非核心线程池也满了 ,才会执行拒绝策略。

拒绝策略

ThreadPoolExecutor在以下两种情况下会执行拒绝策略:

当核心线程池满了以后,如果任务队列也满了,首先判断非核心线程池有没满,没有满就创建一个工作线程(归属非核心线程池), 否则就会执行拒绝策略;

提交任务时,ThreadPoolExecutor已经关闭了。

所谓拒绝策略,就是在构造ThreadPoolExecutor时,传入的RejectedExecutionHandler对象

ThreadPoolExecutor一共提供了4种拒绝策略:

AbortPolicy(默认):抛出一个RejectedExecutionException异常

DiscardPolicy:无为而治,什么都不做,等任务自己被回收

DiscardOldestPolicy:丢弃任务队列中的最近一个任务,并执行当前任务

CallerRunsPolicy:以自身线程来执行任务,这样可以减缓新任务提交的速度

线程池的关闭

ExecutorService接口提供两种方法来关闭线程池,这两种方法的区别主要在于是否会继续处理已经添加到任务队列中的任务。

shutdown方法将线程池切换到SHUTDOWN状态(如果已经停止,则不用切换),并调用interruptIdleWorkers方法中断所有空闲的工作线程,最后调用tryTerminate尝试结束线程池,注意,如果执行Runnable任务的线程本身不响应中断,那么也就没有办法终止任务。

shutdownNow方法的主要不同之处就是,它会将线程池的状态至少置为STOP,同时中断所有工作线程(无论该线程是空闲还是运行中),同时返回任务队列中的所有任务。

配置核心线程池的大小

如果任务是 CPU 密集型(需要进行大量计算、处理,比如计算圆周率、对视频进行高清解码等等),则应该配置尽量少的线程,比如 CPU 个数 + 1,这样可以避免出现每个线程都需要使用很长时间但是有太多线程争抢资源的情况;

如果任务是 IO密集型(主要时间都在 I/O,即网络、磁盘IO,CPU 空闲时间比较多),则应该配置多一些线程,比如 CPU 数的两倍,这样可以更高地压榨 CPU。

公式:最佳线程数目 = ((线程等待时间+线程CPU时间)/线程CPU时间 ) CPU数目*

比如*平均每个线程CPU运行时间为0.5s,而线程等待时间(非CPU运行时间,比如IO)为1.5s,CPU核心数为8,那么根据上面这个公式估算得到:((0.5+1.5)/0.5)8=32。

固定线程池

创建一个定长线程池,可控制线程最大并发数,超出的线程会在队列中等待。

ExecutorService newFixedThreadPool = Executors.newFixedThreadPool(3);

for (int i = 0; i < 10; i++) {

int temp = i;

newFixedThreadPool.execute(new Runnable() {

@Override

public void run() {

System.out.println(Thread.currentThread().getName() + ",i:" + temp);

}

});

}

单线程线程池

创建一个单线程化的线程池,它只会用唯一的工作线程来执行任务,保证所有任务按照指定顺序(FIFO, LIFO, 优先级)执行。 类似:newSingleThreadScheduledExecutor()

可缓存的线程池

如果线程池长度超过处理需要,可灵活回收空闲线程,若无可回收,则新建线程。

// 1.可缓存的线程池 重复利用

ExecutorService newCachedThreadPool = Executors.newCachedThreadPool();

for (int i = 0; i < 10; i++) {

int temp = i;

newCachedThreadPool.execute(new Runnable() {

@Override

public void run() {

System.out.println("threadName:" + Thread.currentThread().getName() +

",i:" + temp);

}

});

}

可延时/周期调度的线程池

ScheduledThreadPoolExecutor,它是对普通线程池ThreadPoolExecutor的扩展,增加了延时调度、周期调度任务的功能。概括下ScheduledThreadPoolExecutor的主要特点:

对Runnable任务进行包装,封装成ScheduledFutureTask,该类任务支持任务的周期执行、延迟执行;

采用DelayedWorkQueue作为任务队列。该队列是无界队列,所以任务一定能添加成功,但是当工作线程尝试从队列取任务执行时,只有最先到期的任务会出队,如果没有任务或者队首任务未到期,则工作线程会阻塞;

ScheduledThreadPoolExecutor的任务调度流程与ThreadPoolExecutor略有区别,最大的区别就是,先往队列添加任务,然后创建工作线程执行任务。

创建一个定长线程池,支持定时及周期性任务执行。

ScheduledExecutorService newScheduledThreadPool = Executors.newScheduledThreadPool(3);

for (int i = 0; i < 10; i++) {

int temp = i;

newScheduledThreadPool.schedule(new Runnable() {

@Override

public void run() {

System.out.println(Thread.currentThread().getName() + ",i:" + temp);

}

},3, TimeUnit.SECONDS);

}

逻辑和算数操作

public static void main(String[] args) {

// 20

System.out.println(10 << 1);

// -20

System.out.println(-10 << 1);

// 5

System.out.println(10 >> 1);

// -5

System.out.println(-10 >> 1);

// 5

System.out.println(10 >>> 1);

// 2147483643

System.out.println(-10 >>> 1);

}

我们都知道对于有符号数据类型,二进制最左端的数字为符号位,0代表正,1代表负,这里先介绍几个概念

逻辑左移=算术左移:高位溢出,低位补0

逻辑右移:低位溢出,高位补0

算术右移:低位溢出,高位用符号位的值补

比如一个有符号位的8位二进制数10101010,[]是添加的数字

逻辑左移一位:0101010[0]

逻辑左移两位:101010[00]

算术左移一位:0101010[0]

算术左移两位:101010[00]

逻辑右移一位:[0]1010101

逻辑右移两位:[00]101010

算术右移一位:[1]1010101

算术右移两位:[11]101010

算术左移和算术右移主要用来进行有符号数的倍增、减半

逻辑左移和逻辑右移主要用来进行无符号数的倍增、减半

(Java中是没有无符号数据类型的,C和C++中有)

num<< n : 相当于 num×2nnum×2n,算数左移(逻辑左移)

num>>n: 相当于num2nnum2n,算数右移

num>>>n: 逻辑右移,当num为正数和算术右移一个效果

Feature模式

Future模式是Java多线程设计模式中的一种常见模式,它的主要作用就是异步地执行任务,并在需要的时候获取结果。我们知道,一般调用一个函数,需要等待函数执行完成,调用线程才会继续往下执行,如果是一些计算密集型任务,需要等待的时间可能就会比较长。

Future模式可以让调用方立即返回,然后它自己会在后面慢慢处理,此时调用者拿到的仅仅是一个凭证,调用者可以先去处理其它任务,在真正需要用到调用结果的场合,再使用凭证去获取调用结果。这个凭证就是这里的Future。

看下时序图来理解下两者的区别:

传统的数据获取方式:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-svCodSL6-1618135569566)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405092434937.png)]

Future模式下的数据获取:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-t69GG5ci-1618135569566)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405092512768.png)]z

Feature 实现通知功能

package future;

import java.util.concurrent.CancellationException;

import java.util.concurrent.Future;

import java.util.concurrent.TimeUnit;

/**

* The result of an asynchronous operation.

*

* @author lixiaohui

* @param <V> 执行结果的类型参数

*/

public interface IFuture<V> extends Future<V> {

boolean isSuccess(); // 是否成功

V getNow(); //立即返回结果(不管Future是否处于完成状态)

Throwable cause(); //若执行失败时的原因

boolean isCancellable(); //是否可以取消

IFuture<V> await() throws InterruptedException; //等待future的完成

boolean await(long timeoutMillis) throws InterruptedException; // 超时等待future的完成

boolean await(long timeout, TimeUnit timeunit) throws InterruptedException;

IFuture<V> awaitUninterruptibly(); //<span style="line-height: 1.5;">等待future的完成,不响应中断</span>

boolean awaitUninterruptibly(long timeoutMillis);<span style="line-height: 1.5;">//超时</span><span style="line-height: 1.5;">等待future的完成,不响应中断</span>

boolean awaitUninterruptibly(long timeout, TimeUnit timeunit);

IFuture<V> addListener(IFutureListener<V> l); //当future完成时,会通知这些加进来的监听器

IFuture<V> removeListener(IFutureListener<V> l);

}

当线程调用了IFuture.await()等一系列的方法时,如果Future还未完成,那么就调用future.wait() 方法使线程进入WAITING状态。而当别的线程设置Future为完成状态(注意这里的完成状态包括正常结束和异常结束)时,就需要调用future.notifyAll()方法来唤醒之前因为调用过wait()方法而处于WAITING状态的那些线程。完整的实现如下

package future;

import java.util.Collection;

import java.util.concurrent.CancellationException;

import java.util.concurrent.CopyOnWriteArrayList;

import java.util.concurrent.ExecutionException;

import java.util.concurrent.TimeUnit;

import java.util.concurrent.TimeoutException;

/**

* <pre>

* 正常结束时, 若执行的结果不为null, 则result为执行结果; 若执行结果为null, 则result = {@link AbstractFuture#SUCCESS_SIGNAL}

* 异常结束时, result为 {@link CauseHolder} 的实例;若是被取消而导致的异常结束, 则result为 {@link CancellationException} 的实例, 否则为其它异常的实例

* 以下情况会使异步操作由未完成状态转至已完成状态, 也就是在以下情况发生时调用notifyAll()方法:

* <ul>

* <li>异步操作被取消时(cancel方法)</li>

* <li>异步操作正常结束时(setSuccess方法)</li>

* <li>异步操作异常结束时(setFailure方法)</li>

* </ul>

* </pre>

* @param <V>

* 异步执行结果的类型

*/

public class AbstractFuture<V> implements IFuture<V> {

protected volatile Object result; // 需要保证其可见性

/**

* 监听器集

*/

protected Collection<IFutureListener<V>> listeners = new CopyOnWriteArrayList<IFutureListener<V>>();

/**

* 当任务正常执行结果为null时, 即客户端调用{@link AbstractFuture#setSuccess(null)}时,

* result引用该对象

*/

private static final SuccessSignal SUCCESS_SIGNAL = new SuccessSignal();

@Override

public boolean cancel(boolean mayInterruptIfRunning) {

if (isDone()) { // 已完成了不能取消

return false;

}

synchronized (this) {

if (isDone()) { // double check

return false;

}

result = new CauseHolder(new CancellationException());

notifyAll(); // isDone = true, 通知等待在该对象的wait()的线程

}

notifyListeners(); // 通知监听器该异步操作已完成

return true;

}

@Override

public boolean isCancellable() {

return result == null;

}

@Override

public boolean isCancelled() {

return result != null && result instanceof CauseHolder && ((CauseHolder) result).cause instanceof CancellationException;

}

@Override

public boolean isDone() {

return result != null;

}

@Override

public V get() throws InterruptedException, ExecutionException {

await(); // 等待执行结果

Throwable cause = cause();

if (cause == null) { // 没有发生异常,异步操作正常结束

return getNow();

}

if (cause instanceof CancellationException) { // 异步操作被取消了

throw (CancellationException) cause;

}

throw new ExecutionException(cause); // 其他异常

}

@Override

public V get(long timeout, TimeUnit unit) throws InterruptedException, ExecutionException, TimeoutException {

if (await(timeout, unit)) {// 超时等待执行结果

Throwable cause = cause();

if (cause == null) {// 没有发生异常,异步操作正常结束

return getNow();

}

if (cause instanceof CancellationException) {// 异步操作被取消了

throw (CancellationException) cause;

}

throw new ExecutionException(cause);// 其他异常

}

// 时间到了异步操作还没有结束, 抛出超时异常

throw new TimeoutException();

}

@Override

public boolean isSuccess() {

return result == null ? false : !(result instanceof CauseHolder);

}

@SuppressWarnings("unchecked")

@Override

public V getNow() {

return (V) (result == SUCCESS_SIGNAL ? null : result);

}

@Override

public Throwable cause() {

if (result != null && result instanceof CauseHolder) {

return ((CauseHolder) result).cause;

}

return null;

}

@Override

public IFuture<V> addListener(IFutureListener<V> listener) {

if (listener == null) {

throw new NullPointerException("listener");

}

if (isDone()) { // 若已完成直接通知该监听器

notifyListener(listener);

return this;

}

synchronized (this) {

if (!isDone()) {

listeners.add(listener);

return this;

}

}

notifyListener(listener);

return this;

}

@Override

public IFuture<V> removeListener(IFutureListener<V> listener) {

if (listener == null) {

throw new NullPointerException("listener");

}

if (!isDone()) {

listeners.remove(listener);

}

return this;

}

@Override

public IFuture<V> await() throws InterruptedException {

return await0(true);

}

private IFuture<V> await0(boolean interruptable) throws InterruptedException {

if (!isDone()) { // 若已完成就直接返回了

// 若允许终端且被中断了则抛出中断异常

if (interruptable && Thread.interrupted()) {

throw new InterruptedException("thread " + Thread.currentThread().getName() + " has been interrupted.");

}

boolean interrupted = false;

synchronized (this) {

while (!isDone()) {

try {

wait(); // 释放锁进入waiting状态,等待其它线程调用本对象的notify()/notifyAll()方法

} catch (InterruptedException e) {

if (interruptable) {

throw e;

} else {

interrupted = true;

}

}

}

}

if (interrupted) {

// 为什么这里要设中断标志位?因为从wait方法返回后, 中断标志是被clear了的,

// 这里重新设置以便让其它代码知道这里被中断了。

Thread.currentThread().interrupt();

}

}

return this;

}

@Override

public boolean await(long timeoutMillis) throws InterruptedException {

return await0(TimeUnit.MILLISECONDS.toNanos(timeoutMillis), true);

}

@Override

public boolean await(long timeout, TimeUnit unit) throws InterruptedException {

return await0(unit.toNanos(timeout), true);

}

private boolean await0(long timeoutNanos, boolean interruptable) throws InterruptedException {

if (isDone()) {

return true;

}

if (timeoutNanos <= 0) {

return isDone();

}

if (interruptable && Thread.interrupted()) {

throw new InterruptedException(toString());

}

long startTime = timeoutNanos <= 0 ? 0 : System.nanoTime();

long waitTime = timeoutNanos;

boolean interrupted = false;

try {

synchronized (this) {

if (isDone()) {

return true;

}

if (waitTime <= 0) {

return isDone();

}

for (;;) {

try {

wait(waitTime / 1000000, (int) (waitTime % 1000000));

} catch (InterruptedException e) {

if (interruptable) {

throw e;

} else {

interrupted = true;

}

}

if (isDone()) {

return true;

} else {

waitTime = timeoutNanos - (System.nanoTime() - startTime);

if (waitTime <= 0) {

return isDone();

}

}

}

}

} finally {

if (interrupted) {

Thread.currentThread().interrupt();

}

}

}

@Override

public IFuture<V> awaitUninterruptibly() {

try {

return await0(false);

} catch (InterruptedException e) { // 这里若抛异常了就无法处理了

throw new java.lang.InternalError();

}

}

@Override

public boolean awaitUninterruptibly(long timeoutMillis) {

try {

return await0(TimeUnit.MILLISECONDS.toNanos(timeoutMillis), false);

} catch (InterruptedException e) {

throw new java.lang.InternalError();

}

}

@Override

public boolean awaitUninterruptibly(long timeout, TimeUnit unit) {

try {

return await0(unit.toNanos(timeout), false);

} catch (InterruptedException e) {

throw new java.lang.InternalError();

}

}

protected IFuture<V> setFailure(Throwable cause) {

if (setFailure0(cause)) {

notifyListeners();

return this;

}

throw new IllegalStateException("complete already: " + this);

}

private boolean setFailure0(Throwable cause) {

if (isDone()) {

return false;

}

synchronized (this) {

if (isDone()) {

return false;

}

result = new CauseHolder(cause);

notifyAll();

}

return true;

}

protected IFuture<V> setSuccess(Object result) {

if (setSuccess0(result)) { // 设置成功后通知监听器

notifyListeners();

return this;

}

throw new IllegalStateException("complete already: " + this);

}

private boolean setSuccess0(Object result) {

if (isDone()) {

return false;

}

synchronized (this) {

if (isDone()) {

return false;

}

if (result == null) { // 异步操作正常执行完毕的结果是null

this.result = SUCCESS_SIGNAL;

} else {

this.result = result;

}

notifyAll();

}

return true;

}

private void notifyListeners() {

for (IFutureListener<V> l : listeners) {

notifyListener(l);

}

}

private void notifyListener(IFutureListener<V> l) {

try {

l.operationCompleted(this);

} catch (Exception e) {

e.printStackTrace();

}

}

private static class SuccessSignal {

}

private static final class CauseHolder {

final Throwable cause;

CauseHolder(Throwable cause) {

this.cause = cause;

}

}

}

我们就可以定制各种各样的异步结果了。下面模拟一下一个延时的任务

package future.test;

import future.IFuture;

import future.IFutureListener;

/**

* 延时加法

* @author lixiaohui

*

*/

public class DelayAdder {

public static void main(String[] args) {

new DelayAdder().add(3 * 1000, 1, 2).addListener(new IFutureListener<Integer>() {

@Override

public void operationCompleted(IFuture<Integer> future) throws Exception {

System.out.println(future.getNow());

}

});

}

/**

* 延迟加

* @param delay 延时时长 milliseconds

* @param a 加数

* @param b 加数

* @return 异步结果

*/

public DelayAdditionFuture add(long delay, int a, int b) {

DelayAdditionFuture future = new DelayAdditionFuture();

new Thread(new DelayAdditionTask(delay, a, b, future)).start();

return future;

}

private class DelayAdditionTask implements Runnable {

private long delay;

private int a, b;

private DelayAdditionFuture future;

public DelayAdditionTask(long delay, int a, int b, DelayAdditionFuture future) {

super();

this.delay = delay;

this.a = a;

this.b = b;

this.future = future;

}

@Override

public void run() {

try {

Thread.sleep(delay);

Integer i = a + b;

// TODO 这里设置future为完成状态(正常执行完毕)

future.setSuccess(i);

} catch (InterruptedException e) {

// TODO 这里设置future为完成状态(异常执行完毕)

future.setFailure(e.getCause());

}

}

}

}

package future.test;

import future.AbstractFuture;

import future.IFuture;

//只是把两个方法对外暴露

public class DelayAdditionFuture extends AbstractFuture<Integer> {

@Override

public IFuture<Integer> setSuccess(Object result) {

return super.setSuccess(result);

}

@Override

public IFuture<Integer> setFailure(Throwable cause) {

return super.setFailure(cause);

}

}

可以看到客户端不用主动去询问future是否完成, 而是future完成时自动回调operationCompleted方法,客户端只需在回调里实现逻辑即可

并发包中Future模式中的各个组件

真实的任务类

首先我们需要类可以返回线程的执行结果,而传统实现Runnable接口的线程是获取不了返回值的

于是,JDK提供了另一个接口——Callable,表示一个具有返回结果的任务:

所以,最终我们自定义的任务类一般都是实现了Callable接口。以下定义了一个具有复杂计算过程的任务,最终返回一个Double值:

public class ComplexTask implements Callable<Double> {

@Override

public Double call() {

// complex calculating...

return ThreadLocalRandom.current().nextDouble();

}

}

凭证

Future模式可以让调用方获取任务的一个凭证,以便将来拿着凭证去获取任务结果,凭证需要具有以下特点:

在将来某个时间点,可以通过凭证获取任务的结果;

可以支持取消。

并发包中提供了Future接口和它的实现类——FutureTask来满足我们的需求

所以我们可以将上面的代码改造成:

ComplexTask task = new ComplexTask();

Future<Double> future = new FutureTask<Double>(task);

上面的FutureTask就是真实的“凭证”,Future则是该凭证的接口(从面向对象的角度来讲,调用方应面向接口操作)。那既然要执行任务,FutureTask这个类其实除了实现了Future凭证接口外,还实现了Runable接口

FutureTask既可以包装Callable任务,也可以包装Runnable任务,但最终都是将Runnable转换成Callable任务,其实是一个适配过程。 最终,调用方可以以下面这种方式使用Future模式,异步地获取任务的执行结果。

public static void main(String[] args) throws ExecutionException, InterruptedException {

ComplexTask task = new ComplexTask();

Future<Double> future = new FutureTask<Double>(task);

// time passed...

Double result = future.get();

}

通过上面的分析,可以看到,整个Future模式其实就三个核心组件:

真实任务/数据类(通常任务执行比较慢,或数据构造需要较长时间),即示例中的ComplexTask

Future接口(调用方使用该凭证获取真实任务/数据的结果),即Future接口

Future实现类(用于对真实任务/数据进行包装),即FutureTask实现类

注意:

FutureTask虽然支持任务的取消(cancel方法),但是只有当任务是初始化(NEW状态)时才有效,否则cancel方法直接返回false;

当执行任务时(run方法),无论成功或异常,都会先过渡到COMPLETING状态,直到任务结果设置完成后,才会进入响应的终态。

FutureTask

既然是任务,就有状态,FutureTask一共给任务定义了7种状态:

NEW: 表示任务的初始化状态;

COMPLETING:表示任务已执行完成(正常完成或异常完成),但任务结果或异常原因还未设置完成,属于中间状态;

NORMAL:表示任务已经执行完成(正常完成),且任务结果已设置完成,属于最终状态;

EXCEPTIONAL:表示任务已经执行完成(异常完成),且任务异常已设置完成,属于最终状态;

CANCELLED:表示任务还没开始执行就被取消(非中断方式),属于最终状态;

INTERRUPTING:表示任务还没开始执行就被取消(中断方式),正式被中断前的过渡状态,属于中间状态;

INTERRUPTED:表示任务还没开始执行就被取消(中断方式),且已被中断,属于最终状态。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-nqzS5bbD-1618135569567)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405093208331.png)]

结果获取

FutureTask可以通过get方法获取任务结果,如果需要限时等待,可以调用get(long timeout, TimeUnit unit)。如果当前任务的状态是NEW或COMPLETING,会调用awaitDone阻塞线程。否则会认为任务已经完成,直接通过report方法映射结果

ScheduledFutureTask

ScheduledFutureTask是ScheduledThreadPoolExecutor这个线程池的默认调度任务类。

ScheduledFutureTask在普通FutureTask的基础上增加了周期执行/延迟执行的功能

Fork/Join框架

分治思想

算法领域有一种基本思想叫做“分治”,所谓“分治”就是将一个难以直接解决的大问题,分割成一些规模较小的子问题,以便各个击破,分而治之。

比如:对于一个规模为N的问题,若该问题可以容易地解决,则直接解决;否则将其分解为K个规模较小的子问题,这些子问题互相独立且与原问题性质相同,递归地解这些子问题,然后将各子问题的解合并得到原问题的解,这种算法设计策略叫做分治法。

许多基础算法都运用了“分治”的思想,比如二分查找、快速排序等等。

基于“分治”的思想,J.U.C在JDK1.7时引入了一套Fork/Join框架。Fork/Join框架的基本思想就是将一个大任务分解(Fork)成一系列子任务,子任务可以继续往下分解,当多个不同的子任务都执行完成后,可以将它们各自的结果合并(Join)成一个大结果,最终合并成大任务的结果:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-I5UDFbXP-1618135569567)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405093434916.png)]

工作窃取算法

从上述Fork/Join框架的描述可以看出,我们需要一些线程来执行Fork出的任务,在实际中,如果每次都创建新的线程执行任务,对系统资源的开销会很大,所以Fork/Join框架利用了线程池来调度任务。

另外,这里可以思考一个问题,既然由线程池调度,根据我们之前学习普通/计划线程池的经验,必然存在两个要素:

工作线程

任务队列

一般的线程池只有一个任务队列,但是对于Fork/Join框架来说,由于Fork出的各个子任务其实是平行关系,为了提高效率,减少线程竞争,应该将这些平行的任务放到不同的队列中去,如上图中,大任务分解成三个子任务:子任务1、子任务2、子任务3,那么就创建三个任务队列,然后再创建3个工作线程与队列一一对应。

由于线程处理不同任务的速度不同,这样就可能存在某个线程先执行完了自己队列中的任务的情况,这时为了提升效率,我们可以让该线程去“窃取”其它任务队列中的任务,这就是所谓的工作窃取算法。

“工作窃取”的示意图如下,当线程1执行完自身任务队列中的任务后,尝试从线程2的任务队列中“窃取”任务:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-vwlh4E0u-1618135569568)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405093556471.png)]

对于一般的队列来说,入队元素都是在“队尾”,出队元素在“队首”,要满足“工作窃取”的需求,任务队列应该支持从“队尾”出队元素,这样可以减少与其它工作线程的冲突(因为正常情况下,其它工作线程从“队首”获取自己任务队列中的任务),满足这一需求的任务队列其实就是双端阻塞队列——LinkedBlockingDeque。

当然,出于性能考虑,J.U.C中的Fork/Join框架并没有直接利用LinkedBlockingDeque作为任务队列,而是自己重新实现了一个。

Fork/Join组件

该框架主要涉及三大核心组件:ForkJoinPool(线程池)、ForkJoinTask(任务)、ForkJoinWorkerThread(工作线程),外加WorkQueue(任务队列):

ForkJoinPool:ExecutorService的实现类,负责工作线程的管理、任务队列的维护,以及控制整个任务调度流程;

ForkJoinTask:Future接口的实现类, fork是其核心方法, 用于分解任务并异步执行;而join方法在任务结果计算完毕之后才会运行,用来合并或返回计算结果;

ForkJoinWorkerThread:Thread的子类,作为线程池中的工作线程(Worker)执行任务;

WorkQueue:任务队列,用于保存任务;

ForkJoinPool

它作为Executors框架的一员,是ExecutorService的一个实现类

ForkJoinPool的主要工作如下:

接受外部任务的提交(外部调用ForkJoinPool的invoke/execute/submit方法提交任务);

接受ForkJoinTask自身fork出的子任务的提交;

任务队列数组(WorkQueue[])的初始化和管理;

工作线程(Worker)的创建/管理。

ForkJoinPool提供了3类外部提交任务的方法:invoke、execute、submit,它们的主要区别在于任务的执行方式上。

通过invoke方法提交的任务,调用线程直到任务执行完成才会返回,也就是说这是一个同步方法,且有返回结果;

通过execute方法提交的任务,调用线程会立即返回,也就是说这是一个异步方法,且没有返回结果;

通过submit方法提交的任务,调用线程会立即返回,也就是说这是一个异步方法,且有返回结果(返回Future实现类,可以通过get获取结果)。

ForkJoinTask

从Fork/Join框架的描述上来看,“任务”必须要满足一定的条件:

支持Fork,即任务自身的分解

支持Join,即任务结果的合并

ForkJoinTask就是符合这种条件的任务。

ForkJoinTask实现了Future接口,是一个异步任务,我们在使用Fork/Join框架时,一般需要使用线程池来调度任务,线程池内部调度的其实都是ForkJoinTask任务

除了ForkJoinTask,Fork/Join框架还提供了两个ForkJoinTask的抽象实现,我们在自定义ForkJoin任务时,一般继承这两个类:

RecursiveAction:表示具有返回结果的ForkJoin任务

RecursiveTask:表示没有返回结果的ForkJoin任务

其它组件就不说了

使用示例

假设有个非常大的long[]数组,通过FJ框架求解数组所有元素的和。

任务类定义,因为需要返回结果,所以继承RecursiveTask,并覆写compute方法。任务的fork通过ForkJoinTask的fork方法执行,join方法方法用于等待任务执行后返回.

代码大致的意思就是:

ArraySumTask类初始化时会传入需要计算的数组,和begin,end。通过设置的THRESHOLD 阈值来与begin,end比较.

如果end - begin + 1 < THRESHOLD,那么不需要分段,

如果end - begin + 1 >THRESHOLD, 就需要分段计算了,怎么分呢?就再次创建两个ArraySumTask 任务,一个处理array的index为0-500的数据,一个处理501-1000的数据。然后再次调用fork方法,会执行新任务的compute方法,那么由于刚创建的两个任务还是比阈值100大,所以分别又会创建任务,就一直递归创建任务,直到end-begin小于阈值。然后分别执行任务,跳出递归,执行join方法,将结果统一相加

public class ArraySumTask extends RecursiveTask<Long> {

private final int[] array;

private final int begin;

private final int end;

private static final int THRESHOLD = 100;

public ArraySumTask(int[] array, int begin, int end) {

this.array = array;

this.begin = begin;

this.end = end;

}

@Override

protected Long compute() {

long sum = 0;

if (end - begin + 1 < THRESHOLD) { // 小于阈值, 直接计算

for (int i = begin; i <= end; i++) {

sum += array[i];

}

} else {

int middle = (end + begin) / 2;

ArraySumTask subtask1 = new ArraySumTask(this.array, begin, middle);

ArraySumTask subtask2 = new ArraySumTask(this.array, middle + 1, end);

subtask1.fork();

subtask2.fork();

long sum1 = subtask1.join();

long sum2 = subtask2.join();

sum = sum1 + sum2;

}

return sum;

}

}

调用方如下:

public class Main {

public static void main(String[] args) {

ForkJoinPool executor = new ForkJoinPool();

ArraySumTask task = new ArraySumTask(new int[10000], 0, 9999);

ForkJoinTask future = executor.submit(task);

// some time passed...

if (future.isCompletedAbnormally()) {

System.out.println(future.getException());

}

try {

System.out.println("result: " + future.get());

} catch (InterruptedException e) {

e.printStackTrace();

} catch (ExecutionException e) {

e.printStackTrace();

}

}

}

注意:ForkJoinTask在执行的时候可能会抛出异常,但是没办法在主线程里直接捕获异常,所以ForkJoinTask提供了isCompletedAbnormally()方法来检查任务是否已经抛出异常或已经被取消了,并且可以通过ForkJoinTask的getException方法获取异常.

13 、什么是阻塞队列?阻塞队列的实现原理是什么?如何使用阻塞队列来实现生产者-消费者模型?

什么是阻塞队列?

阻塞队列是一个支持阻塞的插入和移除的队列。

- 支持阻塞的插入方法:意思是当队列满时,队列会阻塞插入元素的线程,直到队列不满。

- 支持阻塞的移除方法:意思是队列为空时,获取元素(同时移除元素)的线程会被阻塞,等到队列变为非空。

阻塞队列用法:

阻塞队列常用于生产者和消费者的场景,生产者是向队列里添加元素的线程,消费者是从队列里获取元素的线程。

当阻塞队列不可用时,会有四种相应的处理方式:

| 处理方式 | 抛出异常 | 返回特殊值 | 一直阻塞 | 超时退出 |

|---|---|---|---|---|

| 插入操作 | add(e) | offer(e) | put(e) | offer(e,time,unit) |

| 移除操作 | remove() | poll() | take() | poll(time,unit) |

| 获取操作 | element() | peek() | 不可用 | 不可用 |

四组不同的行为方式解释:

- 抛异常:如果试图的操作无法立即执行,抛一个异常。

- 特定值:如果试图的操作无法立即执行,返回一个特定的值(常常是 true / false)。

- 阻塞:如果试图的操作无法立即执行,该方法调用将会发生阻塞,直到能够执行。

- 超时:如果试图的操作无法立即执行,该方法调用将会发生阻塞,直到能够执行,但等待时间不会超过给定值。返回一个特定值以告知该操作是否成功(典型的是true / false)。

无法向一个 BlockingQueue 中插入 null。如果你试图插入 null,BlockingQueue 将会抛出一个 NullPointerException。

可以访问到 BlockingQueue 中的所有元素,而不仅仅是开始和结束的元素。比如说,你将一个对象放入队列之中以等待处理,但你的应用想要将其取消掉。那么你可以调用诸如 remove(o) 方法来将队列之中的特定对象进行移除。但是这么干效率并不高(基于队列的数据结构,获取除开始或结束位置的其他对象的效率不会太高),因此你尽量不要用这一类的方法,除非你确实不得不那么做。

- 返回特殊值:插入元素时,会返回是否插入成功,成功返回true。如果是移除方法,则是从队列中取出一个元素,没有则返回null。

- 一直阻塞:当阻塞队列满时,如果生产者线程往队列里面put元素,则生产者线程会被阻塞,知道队列不满或者响应中断退出。当队列为空时,如果消费者线程从队列里take元素。

- 超时退出:当阻塞队列满时,如果生产者线程往队列里插入元素,队列会阻塞生产者线程一段时间,如果超过了指定时间,生产者线程就会退出。

如果是无界阻塞队列,队列不会出现满的情况

阻塞队列

-

ArrayBlockingQueue:一个由数组结构组成的有界阻塞队列 。 ArrayBlockingQueue 是一个有界的阻塞队列,其内部实现是将对象放到一个数组里。有界也就意味着,它不能够存储无限多数量的元素。它有一个同一时间能够存储元素数量的上限。你可以在对其初始化的时候设定这个上限,但之后就无法对这个上限进行修改了, 因为它是基于数组实现的,也就具有数组的特性:一旦初始化,大小就无法修改 。

-

LinkedBlockingQueue:一个由链表结构组成的有界阻塞队列,LinkedBlockingQueue 内部以一个链式结构(链接节点)对其元素进行存储。如果需要的话,这一链式结构可以选择一个上限。如果没有定义上限,将使用 Integer.MAX_VALUE 作为上限。

-

PriorityBlockingQueue:一个支持优先级排序的无界阻塞队列,PriorityBlockingQueue 是一个无界的并发队列。它使用了和类 java.util.PriorityQueue 一样的排序规则。你无法向这个队列中插入 null 值。所有插入到 PriorityBlockingQueue 的元素必须实现 java.lang.Comparable 接口。因此该队列中元素的排序就取决于你自己的 Comparable 实现。

-

DelayQueue:一个使用优先级队列实现的无界阻塞队列,DelayQueue 对元素进行持有直到一个特定的延迟到期。注入其中的元素必须实现 java.util.concurrent.Delayed 接口。

-

SynchronousQueue:一个不存储元素的阻塞队列,SynchronousQueue 是一个特殊的队列,它的内部同时只能够容纳单个元素。如果该队列已有一元素的话,试图向队列中插入一个新元素的线程将会阻塞,直到另一个线程将该元素从队列中抽走。同样,如果该队列为空,试图向队列中抽取一个元素的线程将会阻塞,直到另一个线程向队列中插入了一条新的元素。据此,把这个类称作一个队列显然是夸大其词了。它更多像是一个汇合点。

-

LinkedTransferQueue:一个由链表结构组成的无界阻塞队列

-

- LinkedBlockingDeque:一个由链表结构组成的双向阻塞队列

阻塞队列的实现原理:

如果队列是空的,消费者会一直等待,当生产者添加元素时,消费者是如何知道当前队列有元素的呢?

使用通知模式实现。所谓通知模式,就是当生产者往满的队列添加元素时会阻塞住生产者,当消费者消费了一个队列中的元素后,会通知生产者当前队列可用。

其实阻塞队列实现阻塞同步的方式很简单,使用的就是是lock锁的多条件(condition)阻塞控制。使用BlockingQueue封装了根据条件阻塞线程的过程,而我们就不用关心繁琐的await/signal操作了。

下面是Jdk 1.7中ArrayBlockingQueue部分代码:

public ArrayBlockingQueue(int capacity, boolean fair) {

if (capacity <= 0)

throw new IllegalArgumentException();

//创建数组

this.items = new Object[capacity];

//创建锁和阻塞条件

lock = new ReentrantLock(fair);

notEmpty = lock.newCondition();

notFull = lock.newCondition();

}

//添加元素的方法

public void put(E e) throws InterruptedException {

checkNotNull(e);

final ReentrantLock lock = this.lock;

lock.lockInterruptibly();

try {

while (count == items.length)

notFull.await();

//如果队列不满就入队

enqueue(e);

} finally {

lock.unlock();

}

}

//入队的方法

private void enqueue(E x) {

final Object[] items = this.items;

items[putIndex] = x;

if (++putIndex == items.length)

putIndex = 0;

count++;

notEmpty.signal();

}

//移除元素的方法

public E take() throws InterruptedException {

final ReentrantLock lock = this.lock;

lock.lockInterruptibly();

try {

while (count == 0)

notEmpty.await();

return dequeue();

} finally {

lock.unlock();

}

}

//出队的方法

private E dequeue() {

final Object[] items = this.items;

@SuppressWarnings("unchecked")

E x = (E) items[takeIndex];

items[takeIndex] = null;

if (++takeIndex == items.length)

takeIndex = 0;

count--;

if (itrs != null)

itrs.elementDequeued();

notFull.signal();

return x;

}

双端阻塞队列(BlockingDeque)

concurrent包下还提供双端阻塞队列(BlockingDeque),和BlockingQueue是类似的,只不过BlockingDeque提供从任意一端插入或者抽取元素的队列。

阻塞队列的使用场景

import java.util.Random;

import java.util.concurrent.BlockingQueue;

import java.util.concurrent.LinkedBlockingQueue;

import java.util.concurrent.TimeUnit;

public class BlockingQueueTest {

//生产者

public static class Producer implements Runnable{

private final BlockingQueue<Integer> blockingQueue;

private volatile boolean flag;

private Random random;

public Producer(BlockingQueue<Integer> blockingQueue) {

this.blockingQueue = blockingQueue;

flag=false;

random=new Random();

}

public void run() {

while(!flag){

int info=random.nextInt(100);

try {

blockingQueue.put(info);

System.out.println(Thread.currentThread().getName()+" produce "+info);

Thread.sleep(50);

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

public void shutDown(){

flag=true;

}

}

//消费者

public static class Consumer implements Runnable{

private final BlockingQueue<Integer> blockingQueue;

private volatile boolean flag;

public Consumer(BlockingQueue<Integer> blockingQueue) {

this.blockingQueue = blockingQueue;

}

public void run() {

while(!flag){

int info;

try {

info = blockingQueue.take();

System.out.println(Thread.currentThread().getName()+" consumer "+info);

Thread.sleep(50);

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

public void shutDown(){

flag=true;

}

}

public static void main(String[] args){

BlockingQueue<Integer> blockingQueue = new LinkedBlockingQueue<Integer>(10);

Producer producer=new Producer(blockingQueue);

Consumer consumer=new Consumer(blockingQueue);

//创建5个生产者,5个消费者

for(int i=0;i<10;i++){

if(i<5){

new Thread(producer,"producer"+i).start();

}else{

new Thread(consumer,"consumer"+(i-5)).start();

}

}

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

producer.shutDown();

consumer.shutDown();

}

}

14 、什么是Callable和Future?

一个产生结果,一个拿到结果

public class CallableAndFuture {

public static void main(String[] args) {

Callable<Integer> callable = new Callable<Integer>() {

public Integer call() throws Exception {

return new Random().nextInt(100);

}

};

FutureTask<Integer> future = new FutureTask<Integer>(callable);

new Thread(future).start();

try {

Thread.sleep(5000);// 可能做一些事情

System.out.println(future.get());

} catch (InterruptedException e) {

e.printStackTrace();

} catch (ExecutionException e) {

e.printStackTrace();

}

}

}

15 、什么是FutureTask? 使用ExecutorService启动任务。

什么是 FutureTask

FutureTask 实现了 RunnableFuture 接口 , RunnableFutrue接口 集成了 Runnable 和 Future

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-nXsjldtD-1618135569568)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405203259514.png)]

从上面可以看出 FutureTask 既有 Runnable 的特点又有 Future 的特点。可以看出设计者就是通过在线程周期中去进行异步计算并对异步计算进行状态控制和结果获取。而且我们上一文在对 Future 异步计算的不同状态在 FutureTask 中使用了状态机来进行状态描述:

从源码注释中也注明了 FutureTask 的状态转换流程,简单画了一张图来更加清晰的描述其中的关系:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-HVKeN10M-1618135569569)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405203410700.png)]

上面的状态流程贯穿 FutureTask 的整个生命周期。接下来来对这些状态的流转进行一些分析。

FutureTask 的状态

NEW

该状态就是 FutureTask 利用构造初始化的状态。FutureTask 共有两个构造函数,一个是 Callable 作为参数的构造函数;另一个则是 Runnable 和泛型结果容器 result 作为参数的构造函数,其中 Runnable 最终也被转成了 Callable 。NEW 状态干了三件事:

初始化 FutureTask。

初始化执行任务的逻辑线程 Callable。

将当前状态设置为 NEW 。

CANCELLED

这个其实在讲Future 接口时已经说了,将计算取消意味着异步计算生命周期的结束。详情可以看上一篇文章相关的说明。但是我们还是想来看看是如何取消的:

public boolean cancel(boolean mayInterruptIfRunning) {

//如果正处于NEW状态,希望请求正在运行也希望中断就设置为INTERRUTPTING,否则直接设置CANCELLED

if (!(state == NEW &&

UNSAFE.compareAndSwapInt(this, stateOffset, NEW,

mayInterruptIfRunning ? INTERRUPTING : CANCELLED)))

return false;

try { // in case call to interrupt throws exception

if (mayInterruptIfRunning) {

try {

Thread t = runner;

if (t != null)

t.interrupt();

} finally {

// 更新到最终的打断状态

UNSAFE.putOrderedInt(this, stateOffset, INTERRUPTED);

}

}

} finally {

// 唤醒等待线程 来处理结束的状态

finishCompletion();

}

return true;

}

这里用了 CAS 原子操作来尝试进行取消。 当前如果是 NEW 状态然后结合另一个策略参数 mayInterruptIfRunning 来看看是不是正在中断或者已经取消,决定是否进行取消操作。如果允许运行时中断首先将状态更新为 INTERRUPTING 状态,然后线程中断的会把状态更新为 INTERRUPTED

COMPLETING

正在完成中,开始我以为是任务正在进行,然而我错了,该状态意思是计算已经完毕,但是没有暴露出去,而且正在设置给暴露的 outcome 变量。那么 RUNNING 状态哪里去了?

The run state transitions to a terminal state only in methods set,setException, and cancel.

这是相关的注释说明,RUN 状态仅仅是所有的 set 方法和 cancel 时的一个过度状态。其实想想也对运行状态如果不变其实也没有什么需要我们关心的。isDone() 方法说明了一切,只要不是 NEW 状态就任务任务完成了,但是没有结束。

NORMAL

当状态由 NEW 转为 COMPLETING (这又是一个CAS 操作)后,计算结果暴露出去赋值给 outcome ,然后使用自旋锁去不停向等待队列发出已经计算完毕的信号。有个地方非常有趣,作者的结束逻辑写的非常巧妙:

private void finishCompletion() {

// 已经 断言当前状态 肯定是已经开始执行任务了,即不是初始化 NEW 状态

// assert state > COMPLETING;

// 当前有线程挂起在等着拿结果

for (WaitNode q; (q = waiters) != null;) {

// 抢占线程 这里跟 for 结合的很巧妙 直接设置null 简单实用

if (UNSAFE.compareAndSwapObject(this, waitersOffset, q, null)) {

// 不停的自旋 ,当然 LockSupport和Thread. interrupted搭配必须要自旋

for (;;) {

Thread t = q.thread;

if (t != null) {

q.thread = null;

LockSupport.unpark(t);

}

WaitNode next = q.next;

if (next == null)

break;

// 优化回收

q.next = null; // unlink to help gc

// 赋值以快速获取线程快速拿到结果 这里也很巧妙

q = next;

}

break;

}

}

// 空方法 你可以覆写来做一些记录

done();

callable = null; // to reduce footprint

}

EXCEPTIONAL

当抛出中断异常或者其它异常时发出设置异常状态

INTERRUPTING

其它线程在得知当前的状态为 INTERRUPTING 时,通过 Thread.yield 让出当前的 CPU 时间片,并重新就绪竞争 CPU 调度权。就像发现某件事情正在处理,我们先出去重新等待,等人家处理完我们再来试一试一样。

INTERRUPTED

参见对 CANCELLED 的分析。

FutureTask 如何运作

FutureTask 除了控制状态外,其他都是根据状态来进行判断进而执行具体的策略。我们实际用到的有以下两个方法。

run

异步任务主要在该方法中进行计算,记住计算是另外一个线程中进行计算的。

public void run() {

// 如果当前不是NEW,或者当前任务已经有了其他执行线程执行 就不再重复

if (state != NEW ||

!UNSAFE.compareAndSwapObject(this, runnerOffset,

null, Thread.currentThread()))

return;

try {

// 在另一个线程中进行计算 并记录结果 处理异常

Callable<V> c = callable;

if (c != null && state == NEW) {

V result;

boolean ran;

try {

result = c.call();

ran = true;

} catch (Throwable ex) {

result = null;

ran = false;

setException(ex);

}

if (ran)

set(result);

}

} finally {

// runner must be non-null until state is settled to

// prevent concurrent calls to run()

// runner 用来执行 callable 并进行 cas

// 状态被设置后 runner 被设置为null

// 防止 run 方法并发

runner = null;

// state must be re-read after nulling runner to prevent

// leaked interrupts

// 设置 runner 为 null 后需要检查一下状态 防止泄露中断

int s = state;

if (s >= INTERRUPTING)

handlePossibleCancellationInterrupt(s);

}

}

get

get 方法就是一个等待任务结果的过程 核心方法为 awaitDone, 当异步任务执行时线程会挂起要么直接等到任务完成,要么直接等到超时放弃。具体看下面的源码分析:

private int awaitDone(boolean timed, long nanos)

throws InterruptedException {

final long deadline = timed ? System.nanoTime() + nanos : 0L;

WaitNode q = null;

boolean queued = false;

for (;;) {

// 如果当前线程被中断就不停尝试移除等待队列

if (Thread.interrupted()) {

removeWaiter(q);

throw new InterruptedException();

}

int s = state;

// 完成 取消或者发生异常 直接返回 不再等待

if (s > COMPLETING) {

if (q != null)

q.thread = null;

return s;

}

// 如果还在完成中 就先让出调度继续等待 yield 效率要高 它会继续抢占调度来尝试

else if (s == COMPLETING) // cannot time out yet

Thread.yield();

// 如果刚刚进入等待状态就 初始化一个等待队列

else if (q == null)

q = new WaitNode();

// 尝试将没有入队的等待线程加入等待队列 基于cas

else if (!queued)

queued = UNSAFE.compareAndSwapObject(this, waitersOffset,

q.next = waiters, q);

// 处理超时逻辑

else if (timed) {

nanos = deadline - System.nanoTime();

if (nanos <= 0L) {

removeWaiter(q);

return state;

}

LockSupport.parkNanos(this, nanos);

}

else

// 不设置超时将一直阻塞到当前等待结果线程

LockSupport.park(this);

}

}

16 、什么是并发容器的实现?

同步容器

在 Java 中,同步容器主要包括 2 类:

-

Vector、Stack、HashTable

- Vector 实现了 List 接口,Vector 实际上就是一个数组,和 ArrayList 类似,但是 Vector 中的方法都是 synchronized 方法,即进行了同步措施。

- Stack 也是一个同步容器,它的方法也用 synchronized 进行了同步,它实际上是继承于 Vector 类。

- HashTable 实现了 Map 接口,它和 HashMap 很相似,但是 HashTable 进行了同步处理,而 HashMap 没有。

-

Collections 类中提供的静态工厂方法创建的类(由 Collections.synchronizedXxxx 等方法)

同步容器的缺陷

同步容器的同步原理就是在方法上用 synchronized 修饰。那么,这些方法每次只允许一个线程调用执行。

性能问题

由于被 synchronized 修饰的方法,每次只允许一个线程执行,其他试图访问这个方法的线程只能等待。显然,这种方式比没有使用 synchronized 的容器性能要差。

安全问题

同步容器真的一定安全吗?

答案是:未必。同步容器未必真的安全。在做复合操作时,仍然需要加锁来保护。

常见复合操作如下:

迭代:反复访问元素,直到遍历完全部元素;

跳转:根据指定顺序寻找当前元素的下一个(下 n 个)元素;

条件运算:例如若没有则添加等;

不安全的示例

public class Test {

static Vector<Integer> vector = new Vector<Integer>();

public static void main(String[] args) throws InterruptedException {

while(true) {

for(int i=0;i<10;i++)

vector.add(i);

Thread thread1 = new Thread(){

public void run() {

for(int i=0;i<vector.size();i++)

vector.remove(i);

};

};

Thread thread2 = new Thread(){

public void run() {

for(int i=0;i<vector.size();i++)

vector.get(i);

};

};

thread1.start();

thread2.start();

while(Thread.activeCount()>10) {

}

}

}

}

执行时可能会出现数组越界错误。

Vector 是线程安全的,为什么还会报这个错?很简单,对于 Vector,虽然能保证每一个时刻只能有一个线程访问它,但是不排除这种可能:

当某个线程在某个时刻执行这句时:

for(int i=0;i<vector.size();i++)

vector.get(i);

假若此时 vector 的 size 方法返回的是 10,i 的值为 9

然后另外一个线程执行了这句:

for(int i=0;i<vector.size();i++)

vector.remove(i);

将下标为 9 的元素删除了。

那么通过 get 方法访问下标为 9 的元素肯定就会出问题了。

安全示例

因此为了保证线程安全,必须在方法调用端做额外的同步措施,如下面所示:

public class Test {

static Vector<Integer> vector = new Vector<Integer>();

public static void main(String[] args) throws InterruptedException {

while(true) {

for(int i=0;i<10;i++)

vector.add(i);

Thread thread1 = new Thread(){

public void run() {

synchronized (Test.class) { //进行额外的同步

for(int i=0;i<vector.size();i++)

vector.remove(i);

}

};

};

Thread thread2 = new Thread(){

public void run() {

synchronized (Test.class) {

for(int i=0;i<vector.size();i++)

vector.get(i);

}

};

};

thread1.start();

thread2.start();

while(Thread.activeCount()>10) {

}

}

}

}

ConcurrentModificationException 异常

在对 Vector 等容器并发地进行迭代修改时,会报 ConcurrentModificationException 异常,关于这个异常将会在后续文章中讲述。

但是在并发容器中不会出现这个问题。

并发容器

JDK 的 java.util.concurrent 包(即 juc)中提供了几个非常有用的并发容器。

- CopyOnWriteArrayList - 线程安全的 ArrayList

- CopyOnWriteArraySet - 线程安全的 Set,它内部包含了一个 CopyOnWriteArrayList,因此本质上是由 CopyOnWriteArrayList 实现的。

- ConcurrentSkipListSet - 相当于线程安全的 TreeSet。它是有序的 Set。它由 ConcurrentSkipListMap 实现。

- ConcurrentHashMap - 线程安全的 HashMap。采用

分段锁实现高效并发。 - ConcurrentSkipListMap - 线程安全的有序 Map。使用跳表实现高效并发。

- ConcurrentLinkedQueue - 线程安全的无界队列。底层采用单链表。支持 FIFO。

- ConcurrentLinkedDeque - 线程安全的无界双端队列。底层采用双向链表。支持 FIFO 和 FILO。

- ArrayBlockingQueue - 数组实现的阻塞队列。

- LinkedBlockingQueue - 链表实现的阻塞队列。

- LinkedBlockingDeque - 双向链表实现的双端阻塞队列。

ConcurrentHashMap

要点

作用:ConcurrentHashMap 是线程安全的 HashMap。

原理:JDK6 与 JDK7 中,ConcurrentHashMap 采用了分段锁机制。JDK8 中,摒弃了锁分段机制,改为利用 CAS 算法。

源码JDK7

ConcurrentHashMap 类在 jdk1.7 中的设计,其基本结构如图所示:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-NGHsZ045-1618135569569)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405210754122.png)]

每一个 segment 都是一个 HashEntry<K,V>[] table, table 中的每一个元素本质上都是一个 HashEntry 的单向队列。比如 table[3]为首节点,table[3]->next 为节点 1,之后为节点 2,依次类推。

public class ConcurrentHashMap<K, V> extends AbstractMap<K, V>

implements ConcurrentMap<K, V>, Serializable {

// 将整个hashmap分成几个小的map,每个segment都是一个锁;与hashtable相比,这么设计的目的是对于put, remove等操作,可以减少并发冲突,对

// 不属于同一个片段的节点可以并发操作,大大提高了性能

final Segment<K,V>[] segments;

// 本质上Segment类就是一个小的hashmap,里面table数组存储了各个节点的数据,继承了ReentrantLock, 可以作为互拆锁使用

static final class Segment<K,V> extends ReentrantLock implements Serializable {

transient volatile HashEntry<K,V>[] table;

transient int count;

}

// 基本节点,存储Key, Value值

static final class HashEntry<K,V> {

final int hash;

final K key;

volatile V value;

volatile HashEntry<K,V> next;

}

}

JDK8

jdk8 中主要做了 2 方面的改进

- 取消 segments 字段,直接采用 transient volatile HashEntry<K,V>[] table 保存数据,采用 table 数组元素作为锁,从而实现了对每一行数据进行加锁,进一步减少并发冲突的概率。

- 将原先 table 数组+单向链表的数据结构,变更为 table 数组+单向链表+红黑树的结构。对于 hash 表来说,最核心的能力在于将 key hash 之后能均匀的分布在数组中。如果 hash 之后散列的很均匀,那么 table 数组中的每个队列长度主要为 0 或者 1。但实际情况并非总是如此理想,虽然 ConcurrentHashMap 类默认的加载因子为 0.75,但是在数据量过大或者运气不佳的情况下,还是会存在一些队列长度过长的情况,如果还是采用单向列表方式,那么查询某个节点的时间复杂度为 O(n);因此,对于个数超过 8(默认值)的列表,jdk1.8 中采用了红黑树的结构,那么查询的时间复杂度可以降低到 O(logN),可以改进性能。

final V putVal(K key, V value, boolean onlyIfAbsent) {

if (key == null || value == null) throw new NullPointerException();

int hash = spread(key.hashCode());

int binCount = 0;

for (Node<K,V>[] tab = table;;) {

Node<K,V> f; int n, i, fh;

// 如果table为空,初始化;否则,根据hash值计算得到数组索引i,如果tab[i]为空,直接新建节点Node即可。注:tab[i]实质为链表或者红黑树的首节点。

if (tab == null || (n = tab.length) == 0)

tab = initTable();

else if ((f = tabAt(tab, i = (n - 1) & hash)) == null) {

if (casTabAt(tab, i, null,

new Node<K,V>(hash, key, value, null)))

break; // no lock when adding to empty bin

}

// 如果tab[i]不为空并且hash值为MOVED,说明该链表正在进行transfer操作,返回扩容完成后的table。

else if ((fh = f.hash) == MOVED)

tab = helpTransfer(tab, f);

else {

V oldVal = null;

// 针对首个节点进行加锁操作,而不是segment,进一步减少线程冲突

synchronized (f) {

if (tabAt(tab, i) == f) {

if (fh >= 0) {

binCount = 1;

for (Node<K,V> e = f;; ++binCount) {

K ek;

// 如果在链表中找到值为key的节点e,直接设置e.val = value即可。

if (e.hash == hash &&

((ek = e.key) == key ||

(ek != null && key.equals(ek)))) {

oldVal = e.val;

if (!onlyIfAbsent)

e.val = value;

break;

}

// 如果没有找到值为key的节点,直接新建Node并加入链表即可。

Node<K,V> pred = e;

if ((e = e.next) == null) {

pred.next = new Node<K,V>(hash, key,

value, null);

break;

}

}

}

// 如果首节点为TreeBin类型,说明为红黑树结构,执行putTreeVal操作。

else if (f instanceof TreeBin) {

Node<K,V> p;

binCount = 2;

if ((p = ((TreeBin<K,V>)f).putTreeVal(hash, key,

value)) != null) {

oldVal = p.val;

if (!onlyIfAbsent)

p.val = value;

}

}

}

}

if (binCount != 0) {

// 如果节点数>=8,那么转换链表结构为红黑树结构。

if (binCount >= TREEIFY_THRESHOLD)

treeifyBin(tab, i);

if (oldVal != null)

return oldVal;

break;

}

}

}

// 计数增加1,有可能触发transfer操作(扩容)。

addCount(1L, binCount);

return null;

}

public class ConcurrentHashMapDemo {

public static void main(String[] args) throws InterruptedException {

// HashMap 在并发迭代访问时会抛出 ConcurrentModificationException 异常

// Map<Integer, Character> map = new HashMap<>();

Map<Integer, Character> map = new ConcurrentHashMap<>();

Thread wthread = new Thread(() -> {

System.out.println("写操作线程开始执行");

for (int i = 0; i < 26; i++) {

map.put(i, (char) ('a' + i));

}

});

Thread rthread = new Thread(() -> {

System.out.println("读操作线程开始执行");

for (Integer key : map.keySet()) {

System.out.println(key + " - " + map.get(key));

}

});

wthread.start();

rthread.start();

Thread.sleep(1000);

}

}

CopyOnWriteArrayList

要点

作用:CopyOnWrite 字面意思为写入时复制。CopyOnWriteArrayList 是线程安全的 ArrayList。

原理:

- 在 CopyOnWriteAarrayList 中,读操作不同步,因为它们在内部数组的快照上工作,所以多个迭代器可以同时遍历而不会相互阻塞(1,2,4)。

- 所有的写操作都是同步的。他们在备份数组(3)的副本上工作。写操作完成后,后备阵列将被替换为复制的阵列,并释放锁定。支持数组变得易变,所以替换数组的调用是原子(5)。

- 写操作后创建的迭代器将能够看到修改的结构(6,7)。

- 写时复制集合返回的迭代器不会抛出 ConcurrentModificationException,因为它们在数组的快照上工作,并且无论后续的修改(2,4)如何,都会像迭代器创建时那样完全返回元素。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-9hIZAJY2-1618135569570)(C:\Users\itzz008\AppData\Roaming\Typora\typora-user-images\image-20210405211233793.png)]

源码

重要属性

lock - 执行写时复制操作,需要使用可重入锁加锁

array - 对象数组,用于存放元素

/** The lock protecting all mutators */

final transient ReentrantLock lock = new ReentrantLock();

/** The array, accessed only via getArray/setArray. */

private transient volatile Object[] array;

重要方法

添加操作

添加的逻辑很简单,先将原容器 copy 一份,然后在新副本上执行写操作,之后再切换引用。当然此过程是要加锁的。

public boolean add(E e) {

//ReentrantLock加锁,保证线程安全

final ReentrantLock lock = this.lock;

lock.lock();

try {

Object[] elements = getArray();

int len = elements.length;

//拷贝原容器,长度为原容器长度加一

Object[] newElements = Arrays.copyOf(elements, len + 1);

//在新副本上执行添加操作

newElements[len] = e;

//将原容器引用指向新副本

setArray(newElements);

return true;

} finally {

//解锁

lock.unlock();

}

}

删除操作

- 删除操作同理,将除要删除元素之外的其他元素拷贝到新副本中,然后切换引用,将原容器引用指向新副本。同属写操作,需要加锁。

public E remove(int index) {

//加锁

final ReentrantLock lock = this.lock;

lock.lock();

try {

Object[] elements = getArray();

int len = elements.length;

E oldValue = get(elements, index);

int numMoved = len - index - 1;

if (numMoved == 0)

//如果要删除的是列表末端数据,拷贝前len-1个数据到新副本上,再切换引用

setArray(Arrays.copyOf(elements, len - 1));

else {

//否则,将除要删除元素之外的其他元素拷贝到新副本中,并切换引用

Object[] newElements = new Object[len - 1];

System.arraycopy(elements, 0, newElements, 0, index);

System.arraycopy(elements, index + 1, newElements, index,

numMoved);

setArray(newElements);

}

return oldValue;

} finally {

//解锁

lock.unlock();

}

}

读操作

- CopyOnWriteArrayList 的读操作是不用加锁的,性能很高。

public E get(int index) {

return get(getArray(), index);

}

private E get(Object[] a, int index) {

return (E) a[index];

}

public class CopyOnWriteArrayListDemo {

static class ReadTask implements Runnable {

List<String> list;

ReadTask(List<String> list) {

this.list = list;

}

public void run() {

for (String str : list) {

System.out.println(str);

}

}

}

static class WriteTask implements Runnable {

List<String> list;

int index;

WriteTask(List<String> list, int index) {

this.list = list;

this.index = index;

}

public void run() {

list.remove(index);

list.add(index, "write_" + index);

}

}

public void run() {

final int NUM = 10;

// ArrayList 在并发迭代访问时会抛出 ConcurrentModificationException 异常

// List<String> list = new ArrayList<>();

CopyOnWriteArrayList<String> list = new CopyOnWriteArrayList<>();

for (int i = 0; i < NUM; i++) {

list.add("main_" + i);

}

ExecutorService executorService = Executors.newFixedThreadPool(NUM);

for (int i = 0; i < NUM; i++) {

executorService.execute(new ReadTask(list));

executorService.execute(new WriteTask(list, i));

}

executorService.shutdown();

}

public static void main(String[] args) {

new CopyOnWriteArrayListDemo().run();

}

}

17 、多线程同步和互斥有几种实现方法,都是什么?

什么是同步?

是指在不同进程之间的若干程序片断,它们的运行必须严格按照规定的某种先后次序来运行,这种先后次序依赖于要完成的特定的任务。如果用对资源的访问来定义的话,同步是指在互斥的基础上(大多数情况),通过其它机制实现访问者对资源的有序访问。在大多数情况下,同步已经实现了互斥,特别是所有写入资源的情况必定是互斥的。少数情况是指可以允许多个访问者同时访问资源。

什么是互斥?

是指散布在不同进程之间的若干程序片断,当某个进程运行其中一个程序片段时,其它进程就不能运行它们之中的任一程序片段,只能等到该进程运行完这个程序片段后才可以运行。如果用对资源的访问来定义的话,互斥某一资源同时只允许一个访问者对其进行访问,具有唯一性和排它性。但互斥无法限制访问者对资源的访问顺序,即访问是无序的。

当我们有多个线程要同时访问一个变量或对象时,如果这些线程中既有读又有写操作时,就会导致变量值或对象的状态出现混乱,从而导致程序异常。因此多线程同步就是要解决这个问题。线程同步是指线程之间所具有的一种制约关系,一个线程的执行依赖另一个线程的消息,当它没有得到另一个线程的消息时应等待,直到消息到达时才被唤醒。

线程互斥是指对于共享的进程系统资源,在各单个线程访问时的排它性。当有若干个线程都要使用某一共享资源时,任何时刻最多只允许一个线程去使用,其它要使用该资源的线程必须等待,直到占用资源者释放该资源。线程互斥可以看成是一种特殊的线程同步。

线程间的同步方法大体可分为两类:用户模式和内核模式。顾名思义,内核模式就是指利用系统内核对象的单一性来进行同步,使用时需要切换内核态与用户态,而用户模式就是不需要切换到内核态,只在用户态完成操作。

用户模式下的方法有:原子操作(例如一个单一的全局变量),临界区。内核模式下的方法有:事件,信号量,互斥量。

18 、什么是竞争条件?你怎样发现和解决竞争?

什么是竞争条件?

在Java多线程中,当两个或以上的线程对同一个数据进行操作的时候,可能会产生“竞争条件”的现象。这种现象产生的根本原因是因为多个线程在对同一个数据进行操作,此时对该数据的操作是非“原子化”的,可能前一个线程对数据的操作还没有结束,后一个线程又开始对同样的数据开始进行操作,这就可能会造成数据结果的变化未知。

public class TestThread {

public static void main(String[] args) {

// new 出一个新的对象 t

MyThread t = new MyThread();

/**

* 两个线程是在对同一个对象进行操作

*/

Thread ta = new Thread(t, "Thread-A");

Thread tb = new Thread(t, "Thread-B");

ta.start();

tb.start();

}

}

class MyThread implements Runnable {

// 变量 a 被两个线程共同操作,可能会造成线程竞争

int a = 10;

@Override

public void run() {

for (int i = 0; i < 5; i++) {

a -= 1;

try {

Thread.sleep(1);

} catch (InterruptedException e) {}

System.out.println(Thread.currentThread().getName() + " → a = " + a);

}

}

}

最终运行结果如下:

Thread-A → a = 8

Thread-B → a = 7

Thread-A → a = 6

Thread-B → a = 5

Thread-A → a = 4

Thread-B → a = 3

Thread-A → a = 2