1、题目要求

写一个程序,分析一个文本文件中各个词出现的频率,并且把频率最高的10个词打印出来。文本文件大约是

30KB~300KB大小。

2、思路

数据结构:map,vector,pair主要涉及方法:统计和排序

排序方法:Topk,

先统计各个单词的个数,建立一个以单词--次数的map。

建立一个vector,每次从map表里取一个单词,依次和vector里的元素作对比,小于最小的就淘汰,大于某个元素就将其放入这个元素之前,淘汰vector最后的元素。维持10个元素的大小

最后输出这10个vector中的单词。就是最大频率的十个。

第一次的代码如下:#include <iostream>

#include <vector>

#include <string>

#include <map>

#include <utility>

#include <fstream>

#include <algorithm>

#include <cctype>

using namespace std;

//去除多余符号

char m[100] = {' ','"','.','!',',','-','?',':'};

void trimString(std::string & str,char a[],int n)

{

int i = 0;

while(i < n){

int s = str.find_first_not_of(a[i]);

int e = str.find_last_not_of(a[i]);

str = str.substr(s,e-s+1);

i++;

}

return;

}

int cmp(const pair<string,int>& a,const pair<string,int>& b)

{

return a.second > b.second;

}

map<string, int> word;

int main()

{

fstream f1;

f1.open("1.txt",ios::in);

string i;

while(f1.eof() == 0){

// cout<<f1.eof();

if(f1.eof() == 0){

f1>>i;

}

trimString(i,m,8);//删除多余字符

transform(i.begin(), i.end(), i.begin(), (int (*)(int))tolower);//小写转换

map<string, int>::iterator it = word.find(i);

if(it == word.end()) {

word.insert(map <string, int>::value_type(i,1));

}else{

word[i] ++;

}

}

f1.close();

vector<pair<string,int> > vct;

for(map<string, int>::iterator item = word.begin() ; item != word.end() ; ++item){

vct.push_back(make_pair(item->first, item->second));

}

sort(vct.begin(),vct.end(),cmp);

for(int n = 0; n < 10; n++){

cout<<vct[n].first<<":"<<vct[n].second<<endl;

}

return 0;

}

代码问题:没有进行过滤,而且对“—”这个字符没有办法过滤,会出现溢出错误。

修改代码如下:

#include <iostream>

#include <vector>

#include <string>

#include <map>

#include <utility>

#include <fstream>

#include <algorithm>

#include <cctype>

using namespace std;

//去除多余符号

vector<string> delect = {"the","a","and","to","of","he","i","you","his","him","in","on","as","it","was","not"};

char m[100] = { ' ', '"', '.', '!', ',', '-', '?', ':', '\f', '\v' };

void trimString(std::string& str, char a[], int n)

{

int i = 0;

while (i < n){

int s = str.find_first_not_of(a[i]);

int e = str.find_last_not_of(a[i]);

str = str.substr(s, e - s + 1);

i++;

}

return;

}

bool find(std::vector<string> a, const std::string b){

std::vector<string>::iterator item = a.begin();

for (; item != a.end(); ++item){

if (*(item) == b){

return true;

}

}

return false;

}

int cmp(const pair<string, int>& a, const pair<string, int>& b)

{

return a.second > b.second;

}

map<string, int> word;

int main()

{

fstream f1;

f1.open("f:/1.txt", ios::in);

string i;

while (f1.eof() == 0){

// cout<<f1.eof();

if (f1.eof() == 0){

f1 >> i;

}

trimString(i, m, 10);//删除多余字符

transform(i.begin(), i.end(), i.begin(), (int(*)(int))tolower);//小写转换

map<string, int>::iterator it = word.find(i);

if (it == word.end()) {

word.insert(map <string, int>::value_type(i, 1));

}

else{

word[i] ++;

}

}

f1.close();

vector<pair<string, int> > vct;

for (map<string, int>::iterator item = word.begin(); item != word.end(); ++item){

if (!find(delect, item->first)){

vct.push_back(make_pair(item->first, item->second));

}

}

sort(vct.begin(), vct.end(), cmp);

for (int n = 0; n < 10; n++){

cout << vct[n].first << ":" << vct[n].second << endl;

}

return 0;

}

#include <iostream>

#include <vector>

#include <string>

#include <map>

#include <utility>

#include <fstream>

#include <algorithm>

#include <cctype>

using namespace std;

//去除多余符号

vector<string> delect = {"the","a","and","to","of","he","i","you","his","him","in","on","as","it","was","not"};

char m[100] = { ' ', '"', '.', '!', ',', '-', '?', ':', '\f', '\v' };

void trimString(std::string& str, char a[], int n)

{

int i = 0;

while (i < n){

int s = str.find_first_not_of(a[i]);

int e = str.find_last_not_of(a[i]);

str = str.substr(s, e - s + 1);

i++;

}

return;

}

bool find(std::vector<string> a, const std::string b){

std::vector<string>::iterator item = a.begin();

for (; item != a.end(); ++item){

if (*(item) == b){

return true;

}

}

return false;

}

int cmp(const pair<string, int>& a, const pair<string, int>& b)

{

return a.second > b.second;

}

map<string, int> word;

int main()

{

fstream f1;

f1.open("f:/1.txt", ios::in);

string i;

while (f1.eof() == 0){

// cout<<f1.eof();

if (f1.eof() == 0){

f1 >> i;

}

trimString(i, m, 10);//删除多余字符

transform(i.begin(), i.end(), i.begin(), (int(*)(int))tolower);//小写转换

map<string, int>::iterator it = word.find(i);

if (it == word.end()) {

word.insert(map <string, int>::value_type(i, 1));

}

else{

word[i] ++;

}

}

f1.close();

vector<pair<string, int> > vct;

for (map<string, int>::iterator item = word.begin(); item != word.end(); ++item){

if (!find(delect, item->first)){

vct.push_back(make_pair(item->first, item->second));

}

}

sort(vct.begin(), vct.end(), cmp);

for (int n = 0; n < 10; n++){

cout << vct[n].first << ":" << vct[n].second << endl;

}

return 0;

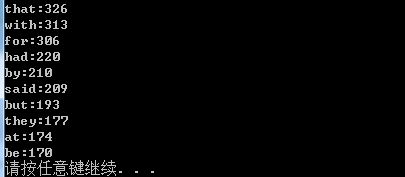

}运行截图:

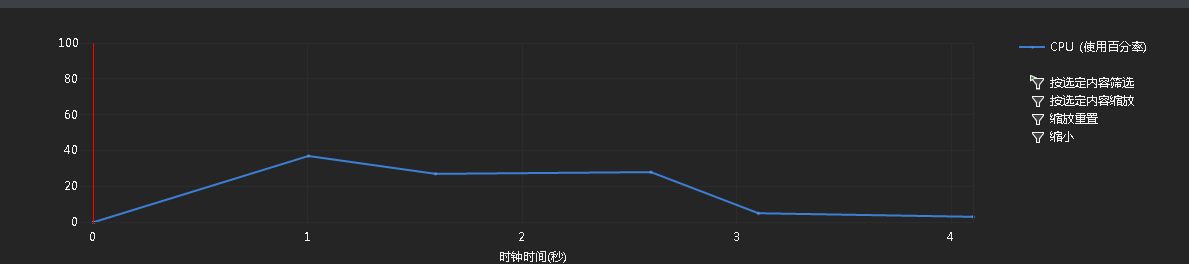

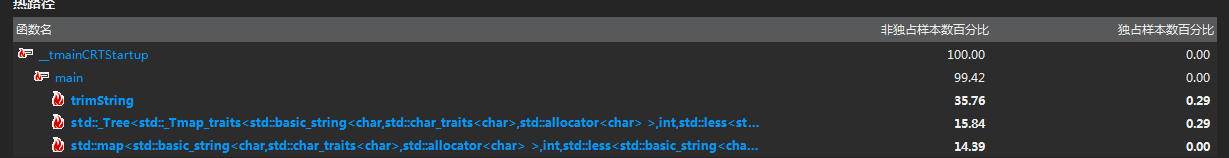

热函数分析:

很明显,字符过滤函数的时间占用过于长了,如果文本是纯英文格式的话,时间复杂度可以下降百分之五十,但是如果字符编码的问题和多余符号依然存在的话,这个函数就是必不可少的。

心得:

估计了一下,因为这里使用的hash表,我使用了STL的Map,没用hash_map。查找的时间复杂度大约是对数级的,没有达到理想的常数级(这里存疑,不一定hash_map比map好,毕竟处理地址冲突的内存损耗大)。而且因为使用了vector排序,创建vector的代价也不少。但是,从分析来看,问题并不在这里,重要的问题是字符过滤那里。我的想法是不使用过滤,而是使用按字符删除的方式,但是论坛的人说时间复杂度实际差不多,所以没改。

2448

2448

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?