前言

对比RabbitMQ,kafka吞吐量更高,但消息可靠性不如rabbit,kafka每秒几十万吞吐,集群百万吞吐,rabbit每秒几万,并发不大,求稳用rabbit,并发大,用kafka。

kafka下载安装,启动测试请参照 官方文档,本文也是基于官方文档做的最新讲解,因为版本问题,操作命令也有些区别。

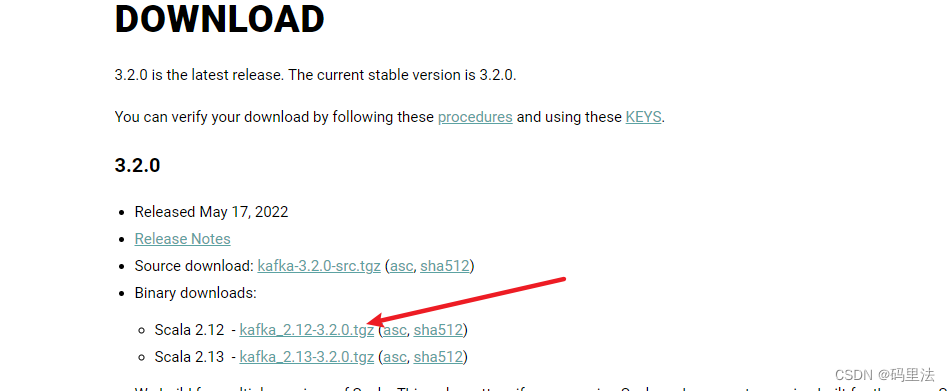

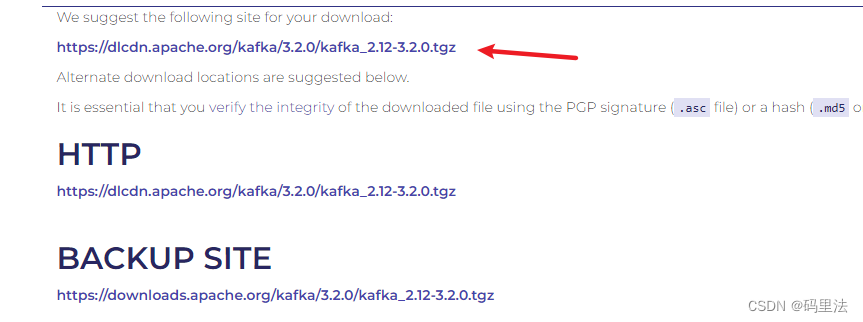

下载

由于kafka内置有zookeeper,所以不用单独去下载了,除非你有特殊的需求。

官方下载

上传至服务器解压,本次讲解安装路径为:/usr/local/kafka/

安装配置

-

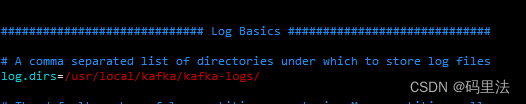

修改kafka的配置文件

conf/server.properties,单机测试其实并不需要修改什么,默认就可以,这里我这是将日志输出路径改了一下。

参数详解,集群会用到#当前机器在集群中的唯一标识,和zookeeper的myid性质一样(broker.id和host.name每个节点都不相同) broker.id=0 #配置kafka的监听端口,当前kafka对外提供服务的端口默认是9092 #listeners=PLAINTEXT://:9092 #把kafka的地址端口注册给zookeeper,如果是远程访问要改成外网IP #advertised.listeners=PLAINTEXT://:9092 //这个是borker进行网络处理的线程数 num.network.threads=3 //这个是borker进行I/O处理的线程数 num.io.threads=8 //发送缓冲区buffer大小,数据不是一下子就发送的,先回存储到缓冲区了到达一定的大小后在发送,能提高性能 socket.send.buffer.bytes=102400 //kafka接收缓冲区大小,当数据到达一定大小后在序列化到磁盘 socket.receive.buffer.bytes=102400 //这个参数是向kafka请求消息或者向kafka发送消息的请请求的最大数,这个值不能超过java的堆栈大小 socket.request.max.bytes=104857600 //消息存放的目录,这个目录可以配置为“,”逗号分割的表达式,上面的num.io.threads要大于这个目录的个数这个目录, //如果配置多个目录,新创建的topic他把消息持久化的地方是,当前以逗号分割的目录中,那个分区数最少就放那一个 log.dirs=/home/hadoop/log/kafka-logs //默认的分区数,一个topic默认1个分区数 num.partitions=1 //每个数据目录用来日志恢复的线程数目 num.recovery.threads.per.data.dir=1 //默认消息的最大持久化时间,168小时,7天 log.retention.hours=168 //轮转时间,当需要删除指定小时之前的数据时,该设置项很重要 log.roll.hours=12 //这个参数是:因为kafka的消息是以追加的形式落地到文件,当超过这个值的时候,kafka会新起一个文件 log.segment.bytes=1073741824 //每隔300000毫秒去检查上面配置的log失效时间 log.retention.check.interval.ms=300000 //是否启用log压缩,一般不用启用,启用的话可以提高性能 log.cleaner.enable=false //设置zookeeper的连接端口 zookeeper.connect=192.168.123.102:2181,192.168.123.103:2181,192.168.123.104:2181 //设置zookeeper的连接超时时间 zookeeper.connection.timeout.ms=6000 -

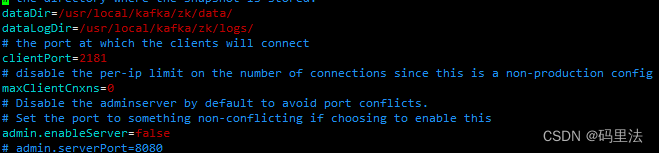

修改zookeeper配置文件

conf/zookeeper.properties,单机讲解,也只是改了日志输出路径。

dataDir=/usr/local/kafka/zk/data/ dataLogDir=/usr/local/kafka/zk/logs/ -

启动

先启动zookeeperbin/zookeeper-server-start.sh -daemon config/zookeeper.properties再启动kafka

bin/kafka-server-start.sh -daemon config/server.properties

测试

注意:低版本和高版本的kafka命令不太一样,具体参考官网

-

创建主题topic

bin/kafka-topics.sh --create --topic quickstart-events --bootstrap-server localhost:9092创建完成查看一下是否创建成功

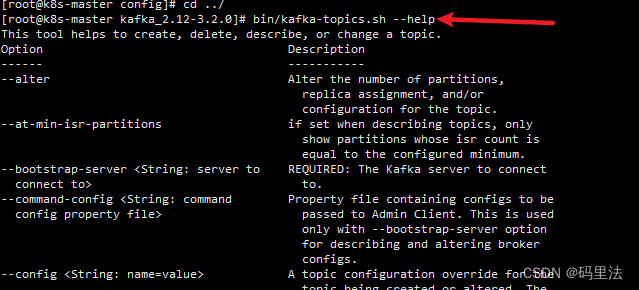

bin/kafka-topics.sh --list --bootstrap-server localhost:9092不熟悉命令请常用

--help命令,比如这样,你会找到适合本版本的命令。

-

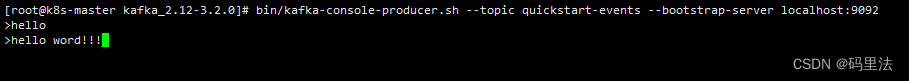

使用生产者发送一个事件消息

bin/kafka-console-producer.sh --topic quickstart-events --bootstrap-server localhost:9092

可以随时停止生产者客户端Ctrl-C。 -

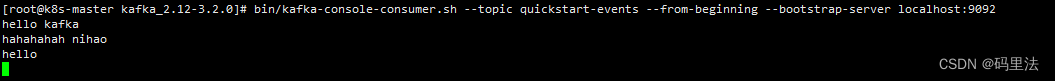

使用消费者来接收消费这个消息

bin/kafka-console-consumer.sh --topic quickstart-events --from-beginning --bootstrap-server localhost:9092

3843

3843

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?