一、Kafka是什么?

Kafka是一种高吞吐量的分布式发布订阅消息系统,它可以处理消费者规模的网站中的所有动作流数据。 这种动作(网页浏览,搜索和其他用户的行动)是在现代网络上的许多社会功能的一个关键因素。 这些数据通常是由于吞吐量的要求而通过处理日志和日志聚合来解决。 对于像Hadoop的一样的日志数据和离线分析系统,但又要求实时处理的限制,这是一个可行的解决方案。Kafka的目的是通过Hadoop的并行加载机制来统一线上和离线的消息处理,也是为了通过集群来提供实时的消费。

二、Kafka的特点

Kafka是一种高吞吐量的分布式发布订阅消息系统有如下特性:

1、通过O(1)的磁盘数据结构提供消息的持久化,这种结构对于即使数以TB的消息存储也能够保持长时间的稳定性能。

2、高吞吐量:即使是非常普通的硬件Kafka也可以支持每秒数百万的消息。

3、支持通过Kafka服务器和消费机集群来分区消息。

4、支持Hadoop并行数据加载。

三、Kafka关键词

| 关键词 | 描述 |

| Broker | Kafka集群包含一个或多个服务器,这种服务器被称为broker。 |

| Topic | 每条发布到Kafka集群的消息都有一个类别,这个类别被称为Topic。(物理上不同Topic的消息分开存储,逻辑上一个Topic的消息虽然保存于一个或多个broker上但用户只需指定消息的Topic即可生产或消费数据而不必关心数据存于何处)。 |

| Partition | Partition是物理上的概念,每个Topic包含一个或多个Partition。 |

| Producer | 负责发布消息到Kafka broker |

| Consumer | 消息消费者,向Kafka broker读取消息的客户端。 |

| Consumer Group | 每个Consumer属于一个特定的Consumer Group(可为每个Consumer指定group name,若不指定group name则属于默认的group)。可以通过Group来实现队列和发布订阅模式。 |

四、Kafka集群配置

1、配置zookeeper集群

参考文章:http://blog.csdn.net/zwx521515/article/details/78218154

zookeeeper集群配置

server.1=192.168.11.216:2888:3888

server.2=192.168.11.224:2888:3888

server.3=192.168.11.225:2888:3888

2、下载Kafka

下载地址:http://mirrors.tuna.tsinghua.edu.cn/apache/kafka/0.10.1.0/kafka_2.11-0.10.1.0.tgz

可通过wget命令进行下载

命令:wget http://mirrors.tuna.tsinghua.edu.cn/apache/kafka/0.10.1.0/kafka_2.11-0.10.1.0.tgz

下载后分别复制到以上3台机器的/usr/local/tools/目录下

3、Kafka配置

3.1、以192.168.11.216机器上的配置为例:

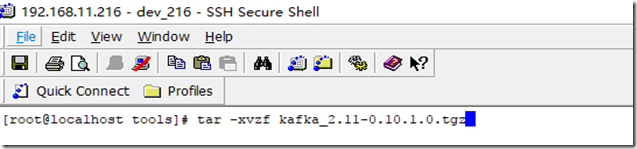

解压安装包文件:tar -xvzf kafka_2.11-0.10.1.0.tgz

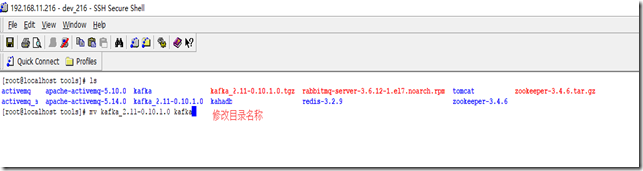

3.2、解压完成后修改文件名为kafka

3.3修改配置文件

进入kafka/config/目录修改server.properties文件

3.3.1参数解释:

broker.id=0 #当前机器在集群中的唯一标识,和zookeeper的myid性质一样

listeners = PLAINTEXT://192.168.11.216:9092#监听的服务器服务ip和端口

num.network.threads=3 #这个是borker进行网络处理的线程数

num.io.threads=8 #这个是borker进行I/O处理的线程数

log.dirs=/usr/local/tools/kafka/kafka-data/ #消息存放的目录,这个目录可以配置为“,”逗号分割的表达式,上面的num.io.threads要大于这个目录的个数这个目录,如果配置多个目录,新创建的topic他把消息持久化的地方是,当前以逗号分割的目录中,那个分区数最少就放那一个

socket.send.buffer.bytes=102400 #发送缓冲区buffer大小,数据不是一下子就发送的,先回存储到缓冲区了到达一定的大小后在发送,能提高性能

socket.receive.buffer.bytes=102400 #kafka接收缓冲区大小,当数据到达一定大小后在序列化到磁盘

socket.request.max.bytes=104857600 #这个参数是向kafka请求消息或者向kafka发送消息的请请求的最大数,这个值不能超过java的堆栈大小

num.partitions=1 #默认的分区数,一个topic默认1个分区数

log.retention.hours=168 #默认消息的最大持久化时间,168小时,7天

message.max.byte=5242880 #消息保存的最大值5M

default.replication.factor=2 #kafka保存消息的副本数,如果一个副本失效了,另一个还可以继续提供服务

replica.fetch.max.bytes=5242880 #取消息的最大直接数

log.segment.bytes=1073741824 #这个参数是:因为kafka的消息是以追加的形式落地到文件,当超过这个值的时候,kafka会新起一个文件

log.retention.check.interval.ms=300000 #每隔300000毫秒去检查上面配置的log失效时间(log.retention.hours=168 ),到目录查看是否有过期的消息如果有,删除

log.cleaner.enable=false #是否启用log压缩,一般不用启用,启用的话可以提高性能

zookeeper.connect=192.168.11.216:2181,192.168.11.224:2181,192.168.11.225:2181

3.3.2 实际配置

#broker.id=0 每台服务器的broker.id都不能相同

broker.id=1#listeners = PLAINTEXT://your.host.name:9092

listeners = PLAINTEXT://192.168.11.216:9092#监听的服务器服务ip和端口

# A comma seperated list of directories under which to store log files日志存储目录配置

#修改主题默认分区数为2

log.dirs=/usr/local/tools/kafka/kafka-data

num.partitions=2

#关闭主题不存在时自动创建功能,默认为开启(当生产者或消费者进行读写数据时,主题不存在会报错)

auto.create.topics.enable=false

#设置zookeeper的连接端口

zookeeper.connect=192.168.11.216:2181,192.168.11.224:2181,192.168.11.225:2181

修改完毕后退出并保存

3.4修改iptables配置

防火墙开放9092端口否则集群服务器之间无法通信。也可以关闭防火墙。防火墙相关可参考:http://www.linuxidc.com/Linux/2015-05/117473.htm

略

其他两台机器配置相似除了监听部分的ip需要和服务器一致即可。

3.5启动kafka服务

前提先系统zookeeper集群服务

进入kafka/bin目录执行启动命令(以守护线程方式启动),没有报错说明启动成功。

./kafka-server-start.sh –daemon ../config/server.properties

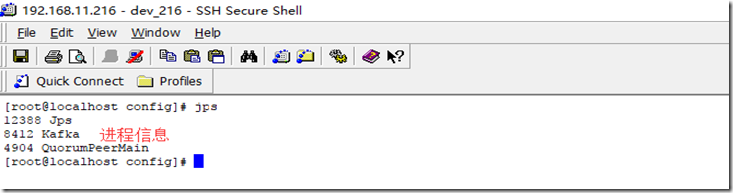

通过jps命令查看进程信息

五、集群验证

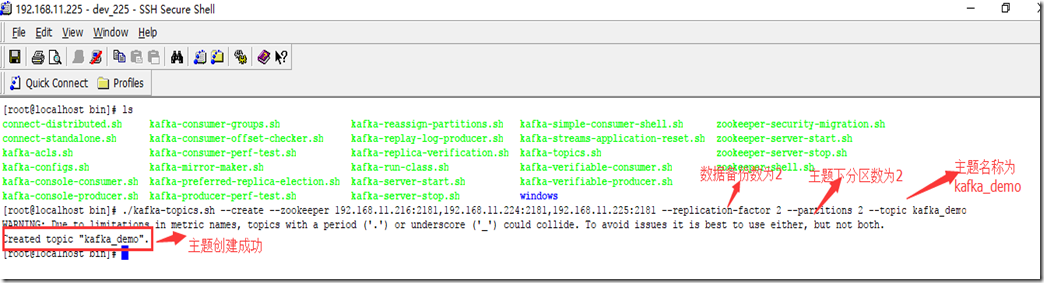

5.1、创建TOPIC kafka_demo

在225上执行命令进行创建。

./kafka-topics.sh --create --zookeeper 192.168.11.216:2181,192.168.11.224:2181,192.168.11.225:2181 --replication-factor 2 --partitions 2 --topic kafka_demo

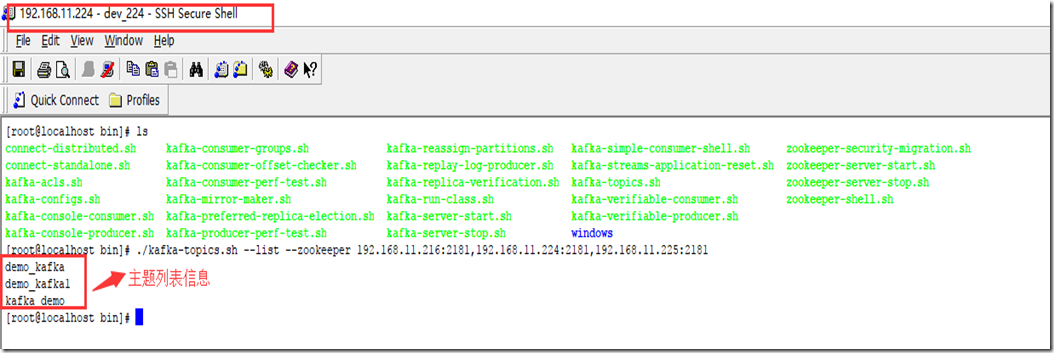

5.2、查看主题列表信息

登录224查看主题列表信息

./kafka-topics.sh --list --zookeeper 192.168.11.216:2181,192.168.11.224:2181,192.168.11.225:2181

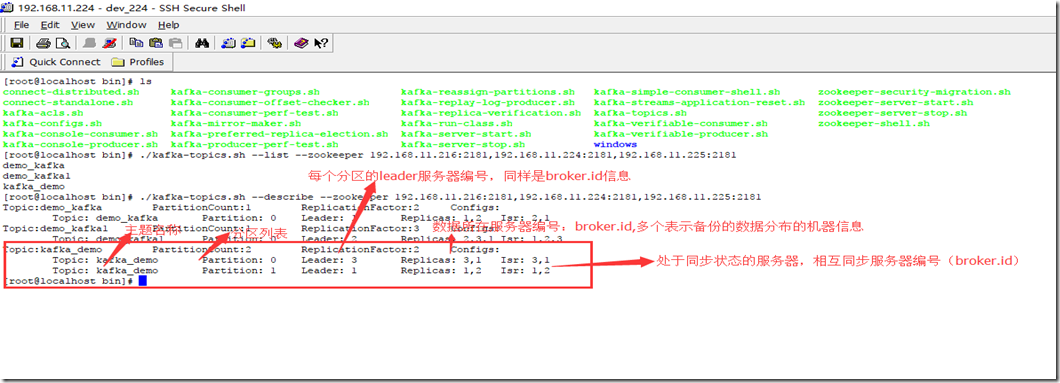

5.3、查看主题详情信息

登录224服务器执行命令进行查看

./kafka-topics.sh --describe --zookeeper 192.168.11.216:2181,192.168.11.224:2181,192.168.11.225:2181

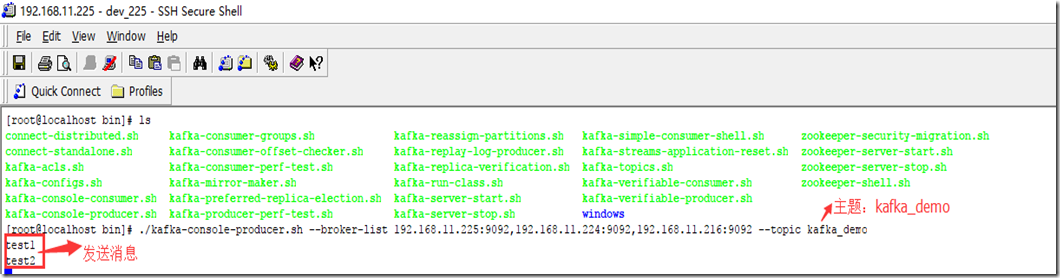

5.4、创建生产者并生产消息

./kafka-console-producer.sh --broker-list 192.168.11.225:9092,192.168.11.224:9092,192.168.11.216:9092 --topic kafka_demo

执行命令后进入阻塞状态,输入消息即可。如:test1,test2

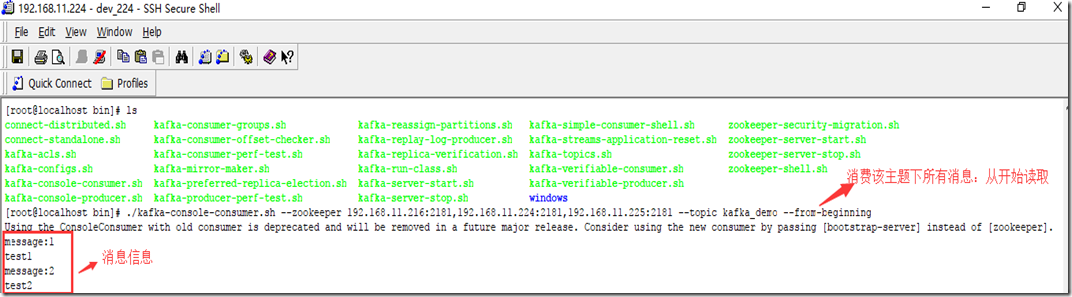

5.5、消费者从主题消费消息

./kafka-console-consumer.sh --zookeeper 192.168.11.216:2181,192.168.11.224:2181,192.168.11.225:2181 --topic kafka_demo --from-beginning

以上就是kafka集群及验证的相关操作,菜鸟初学,如有不当之处,欢迎看友们支出。接下来会写kafka与spring的整合文章。

352

352

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?