Hive只在一个节点上安装即可

部署计划:

在cent03上部署hive节点

在cent05上安装mysql

1.上传tar包

2.解压

tar -zxvf hive-0.14.0.tar.gz -C /usr/cloud/

3.配置mysql metastore(切换到root用户)

配置HIVE_HOME环境变量

//查看 Linux自带的mysql

rpm -qa | grep -i mysql

//删除安装包

rpm -e mysql-libs-5.1.66-2.el6_3.i686 --nodeps 或

yum -y remove mysql-libs-5.1.66-2.el6_3.i686

rpm -ivh MySQL-server-5.6.25-1.linux_glibc2.5.x86_64.rpm

rpm -ivh MySQL-client-5.6.25-1.linux_glibc2.5.x86_64.rpm

//通过:service mysql status 查看mysql启动没,

//如果没启动就用service mysql start 启动

//修改mysql的密码,执行一下脚本

/usr/bin/mysql_secure_installation

//默认密码在/root/.mysql_secret文件中,但它提示初始密码直接按空格,

//但笔者试了不行,后来就用了那个文件里的密码;然后根据提示进行选择

//(注意:删除匿名用户,允许用户远程连接)

//登陆mysql

mysql -u root -p将hive的metastore设置为mysql

4.配置hive

cp hive-default.xml.template hive-site.xml

修改hive-site.xml(删除所有内容,只留一个)

添加如下内容:

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://cent05:3306/hive?createDatabaseIfNotExist=true</value>

<description>JDBC connect string for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

<description>Driver class name for a JDBC metastore</description>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

<description>username to use against metastore database</description>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123</value>

<description>password to use against metastore database</description>

</property>5.安装hive和mysq完成后,将mysql的连接jar包拷贝到$HIVE_HOME/lib目录下

如果出现没有权限的问题,在mysql授权(在安装mysql的机器上执行)

mysql -uroot -p

#(执行下面的语句 .:所有库下的所有表 %:任何IP地址或主机都可以连接)

GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY '123' WITH GRANT OPTION;

FLUSH PRIVILEGES;

再在cent03上执行hive命令,可以在cen05上查看到mysql中有hive数据库

6.建表(默认是内部表)

create table trade_detail(id bigint, account string, income double, expenses double, time string) row format delimited fields terminated by '\t';建分区表

create table td_part(id bigint, account string, income double, expenses double, time string) partitioned by (logdate string) row format delimited fields terminated by '\t';建外部表

create external table td_ext(id bigint, account string, income double, expenses double, time string) row format delimited fields terminated by '\t' location '/td_ext';7.创建分区表

普通表和分区表区别:有大量数据增加的需要建分区表

create table book (id bigint, name string) partitioned by (pubdate string) row format delimited fields terminated by '\t'; 分区表加载数据

// 覆盖指定分区表数据

load data local inpath './book.txt' overwrite into table book partition (pubdate='2010-08-22');

load data local inpath '/root/data.am' into table beauty partition (nation="USA");

select nation, avg(size) from beauties group by nation order by avg(size);

//查询

select * from beauty where nation='USA';测试

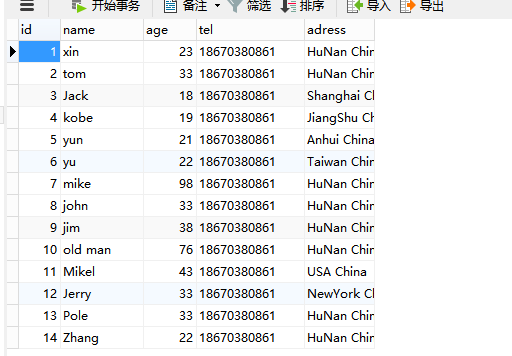

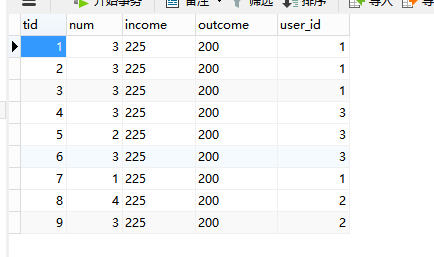

在108主机数据库中建立两个表:t_users和t_trail,添加数据;

t_users表:

t_trail表:

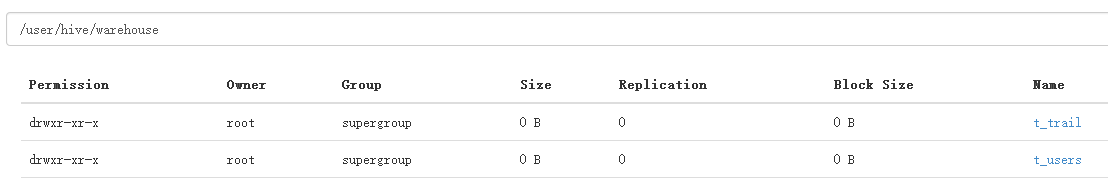

然后执行下面命令把表导入到hdfs中:

//将mysq当中的数据直接导入到hive当中

sqoop import --connect jdbc:mysql://192.168.8.108:3306/test --username root --password root --table t_users

--hive-import --hive-overwrite --hive-table t_users --fields-terminated-by '\t';

sqoop import --connect jdbc:mysql://192.168.8.108:3306/test --username root --password root --table t_trail

--hive-import --hive-overwrite --hive-table t_trail --fields-terminated-by '\t';

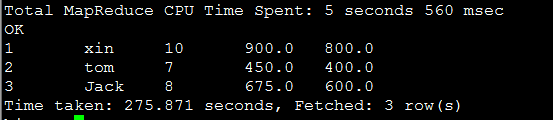

在hive命令模式下执行下面命令:

SELECT u.id, u.name, t.nums, t.incomes, t.outcomes FROM t_users u JOIN (SELECT user_id uid,sum(num) nums,sum(income) incomes,sum(outcome) outcomes FROM t_trail GROUP BY user_id) t ON u.id=t.uid;

802

802

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?