近期,上海海事大学信息工程学院曹磊副教授团队首次提出了一种多模态双向循环一致性(MB2C)方法用于缩小EEG大脑活动中视觉神经表征模态之间的差距,并使具有相似语义不同模态的表征能够分布在潜在空间的同一区域中。通过MB2C与对比学习的结合训练,实现了EEG和图像之间的跨模态对齐,并在ThingsEEG、EEGCVPR40等公开数据集上验证了方法的有效性,取得了与其他基线方法相比更先进的性能。

1 研究背景

从大脑活动数据中解码人类视觉表征是一项具有挑战但至关重要的任务,它有助于理解现实世界和人类视觉系统。然而,从大脑活动记录中解码视觉表征是非常困难的,尤其是脑电图(EEG),尽管它具有良好的时间分辨率但空间精度却较低。现有方法主要通过对比学习将大脑活动数据与相应的刺激响应进行匹配,然而这些方法依赖大量高质量的配对数据并忽略了分布在不同区域潜在空间中的模态数据具有语义上的一致性。为了从基于EEG的大脑活动中学习稳健的视觉神经表征,研究人员提出了多模态双向循环一致性(MB2C)用于缩小模态之间的差距,并使具有相似语义不同模态的表征能够分布在潜在空间的同一区域中。通过MB2C与对比学习的结合,共同约束模型的训练,有效地实现了EEG和图像之间的跨模态对齐。研究人员在ThingsEEG数据集上做了零样本分类和图像重建,还在EEGCVPR40数据集上进行了EEG分类和图像重建,与其他基线方法相比,取得了最先进的性能。

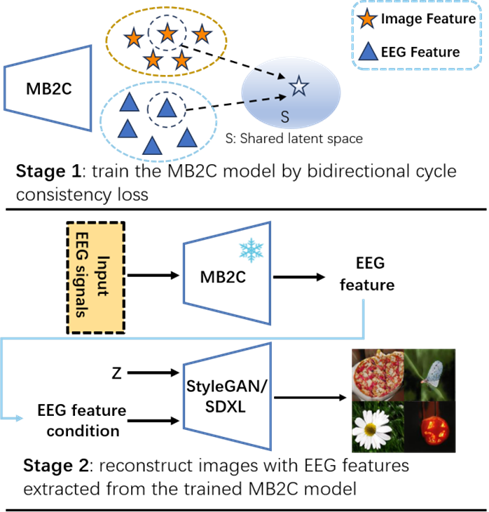

图 1:MB2C 框架的概述。MB2C主要包含两部分:大脑视觉特征的多模态学习和双向循环一致性损失。给定的配对EEG和图像输入使用基于混合的增强进行处理,然后输入大脑和图像编码器以分别获取EEG和视觉嵌入。两个嵌入都输入到双向分类 WGAN 以生成反转特征。该过程利用循环一致性损失来映射回原始嵌入,并辅以InfoNCE 损失。

2 研究方法

研究团队提出了多模态双向循环一致性 (MB2C) 框架,它主要包含两部分:大脑视觉特征的多模态学习和双向循环一致性损失。

具体而言,由于视觉刺激与大脑响应信号的配对训练数据稀缺,首先使用基于混合的增强来处理给定的配对EEG和图像输入。然后将原始数据和增强后的数据输入到大脑和图像编码器中以分别获取EEG和视觉特征,实现大脑视觉特征的多模态学习。

为了缩小模态在表征空间中分布的差距,EEG和视觉特征分别输入到Bidirectional Classified Wasserstein GAN (BCWGAN) 中,BCWGAN 由两个 GAN 模块组成:视觉特征生成网络V = {Gv, Dv} 和EEG 特征生成网络 E = {Ge, De}。两个生成网络由参与对抗性最小-最大游戏的生成器G和鉴别器D组成,从预定义的分布生成合成特征。具体而言,生成器Gv (Ge)将EEG(图像)和随机高斯噪声作为输入,生成对应的图像 (EEG)特征。判别器Dv (De)采用全连接层进行二元分类并引入分类损失引导图像 (EEG) 特征生成朝指定方向发展。随后采用重建特征和真实特征之间的均方误差来计算双向循环一致性损失,鼓励从脑电图特征生成的视觉特征转换回相应的脑电图嵌入。类似地,从图像特征生成的脑电图特征也应该能够转换回其相应的图像嵌入。此外,添加InfoNCE 损失,两个损失相辅相成,实现缩小模态间的差距,实现跨模态对齐。

3 研究结果分析

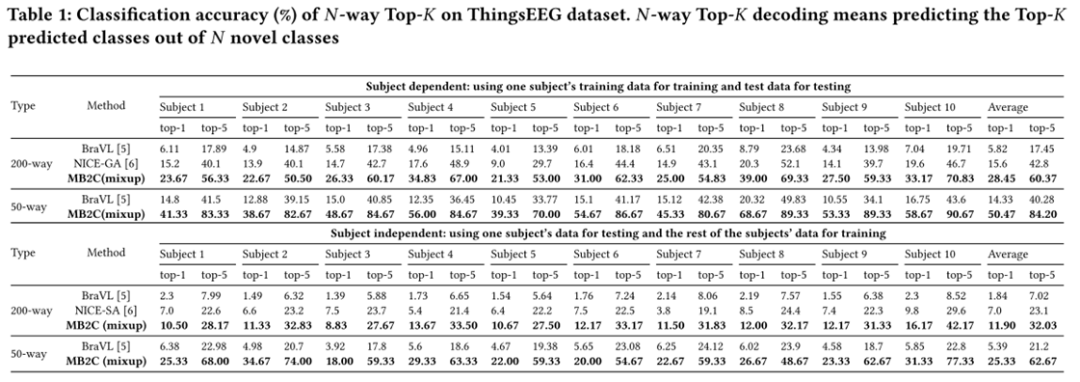

在ThingsEEG 数据集上N-way Top-K零样本分类任务实验结果

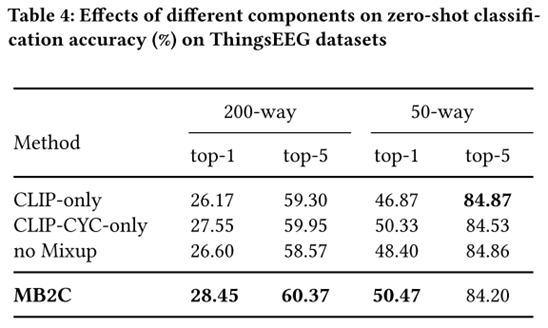

为了验证上述想法,研究人员按照MB2C框架流程在ThingsEEG 数据集上进行受试者内和受试者间的零样本分类任务。如表1所示,结果表明MB2C具有出色的神经解码能力。具体来说,在受试者内实验中,MB2C 在 50 way分类任务中实现了 50.47% 的 top-1 准确率和 84.20% 的平均 top-5 准确率。即使使用 200 个未见过的类进行测试,该模型仍保持 28.45% 的 top-1 准确率和 60.37% 的 top-5 准确率。在受试者间实验中,由于受试者之间的个体差异,神经解码性能低于受试者内预测,但仍显着优于机会水平。MB2C 相比于现有的SOTA方法展现了明显的优越性。

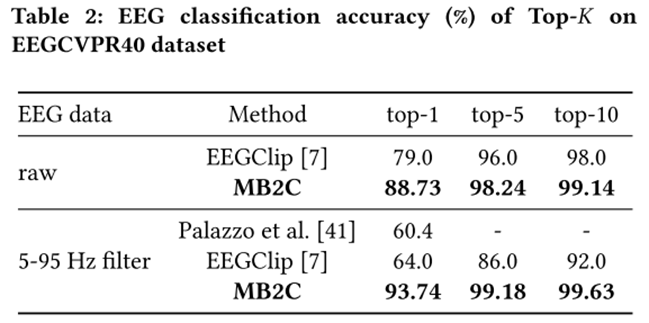

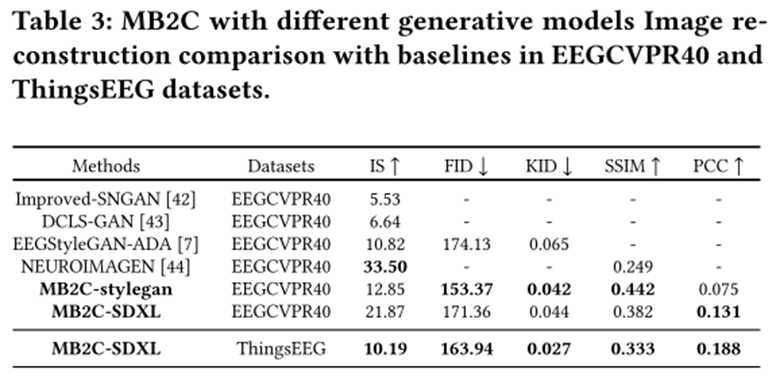

EEGCVPR40 数据集上的联合表示学习

为了验证 MB2C 的鲁棒性,研究人员在 EEGCVPR40 原始数据集和 EEGCVPR40 滤波器数据集(5-95Hz)上进行了EEG分类。在 EEGCVPR40 数据集中,每个 EEG-图像对具有真实的类别标签。在模型训练过程中,我们训练脑电图编码器和两个投影层,然后使用EEG数据微调网络,实现出色的EEG分类结果。如表 2 所示,我们的方法在 EEGCVPR40 原始数据集和 EEGCVPR40 滤波器数据集 (5-95Hz) 上的分类准确度优于当前最先进的模型。

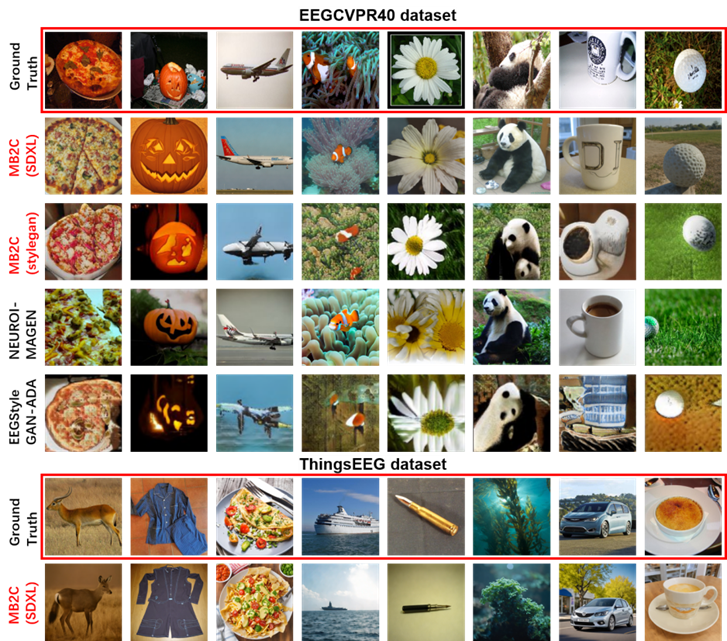

图像重建

图 2:使用 EEG 信号进行图像重建的解耦训练流程。在第 1 阶段,利用MB2C 在共享潜在空间中对齐 EEG-图像对。在第 2 阶段,我们利用 EEG 信息作为条件输入来训练 StyleGAN 或微调 SDXL 用于图像重建。

图 3:以 EEG 为条件在 EEGCVPR40 过滤(5-95 Hz)和 ThingsEEG 数据集上进行图像重建。标记为“地面实况”的行(用红色框突出显示)代表地面实况图像刺激。带有红色文本的图像对应使用 MB2C 模型提取的 EEG 特征进行的重建而其他图像对应相关论文中提出的结果。

研究人员还评估了 MB2C 在图像重建任务中的有效性。按照图2中概述的训练流程进行定量和定性实验。在第 1 阶段,利用MB2C 在共享潜在空间中对齐 EEG-图像对。在第 2 阶段,由于 EEGCVPR40 数据集较小,训练StyleGAN从头开始实现稳定性和高保真度。此外,我们采用更强大的生成模型 SDXL,使用 EEG 信息作为条件输入,在 EEGCVPR40 过滤(5-95 Hz)和 ThingsEEG 数据集上进行图像重建。据我们所知,这是 ThingsEEG 数据集上的第一次图像重建。表 3 列出了图像重建的定量比较结果。我们利用五个评估指标来表名合成图像的质量和多样性。同时,EEG条件图像重建结果如图3所示。

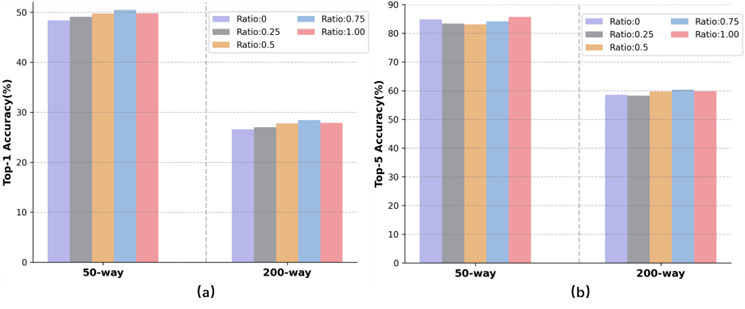

消融实验分析

图 4:混合系数对模型性能的影响。

研究人员在零样本分类任务上探讨了MB2C各个组件的作用和Mixup混合系数对模型性能的影响。

可视化分析

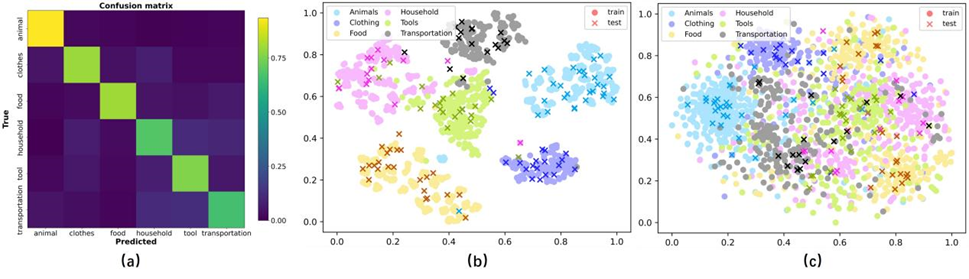

图 5:ThingsEEG 数据集上的余弦相似度和 t-SNE 可视化。(a) 测试集中所有受试者的特征对的混淆矩阵。所有概念被重新分类为五类:动物、衣服、食物、家庭、工具和交通。(b) 六个类别的学习视觉特征的 t-SNE 可视化。(c) 六个类别的学习脑电图特征的 t-SNE 可视化。

为了直观地展示 MB2C 的有效性,研究人员对进行了相似性测量和可视化分析。图5(a)的结果表明,超类内的相似度很高,EEG特征能够有效地反映相应图像的语义类别。图 5 (b) 和图 5 (c) 中描绘了从训练和测试集中学习到的视觉特征和 EEG 特征的 t-SNE 图,测试图像的特征表现出与训练图像相似的分布。

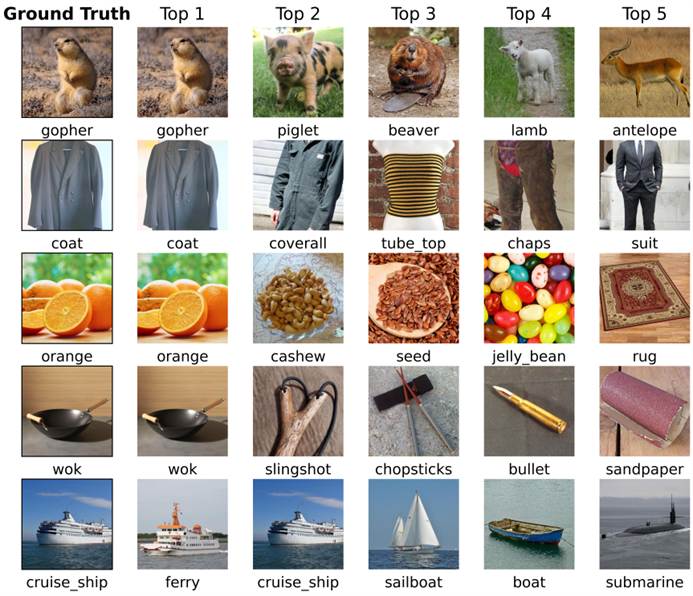

图 6:ThingsEEG 测试集中给定 EEG 信号的地面真实图像和前 5 个预测结果。

图 6呈现了样本前 5 个预测结果,可以观察到它们在语义上与真实情况相似;例如,“地鼠”、“小猪”、“海狸”、“羔羊”和“羚羊”都属于动物类别。

4 结论

这项研究的主要目标是从基于EEG的大脑活动中学习强大的视觉神经表征。研究人员提出了一种新颖的多模态框架,将 MB2C 与对比学习相结合,以实现跨模态对齐。值得注意的是,MB2C 利用双 GAN 生成模态相关特征,并将其逆变换回相应的语义潜在空间,从而缩小模态差距并确保具有相似语义的不同模态的表征能换在表示空间的同一区域。结果表明,从EEG信号中解码可见甚至不可见的视觉类别是有潜力的,并且使用EEG重建图像也是可行的。最后,虽然本文重点关注EEG和图像,但我们表明 MB2C 可以推广到其他配对模态。我们相信我们的研究对于实际脑机接口和多模态学习研究具有重要价值。

5 作者署名

该论文由上海海事大学信息工程学院曹磊副教授担任通讯作者,上海海事大学信息工程学院研究生魏雅芸和李豪为共同第一作者,上海海事大学为第一作者单位和通讯单位。成果发表CCF A国际顶级会议the 32nd ACM International Conference on Multimedia (ACM MM 24)。

代码链接

https://github.com/leeh2213/MB2C

仅用于学术分享,若侵权请留言,即时删侵!

加入社群

欢迎加入脑机接口社区交流群,

探讨脑机接口领域话题,实时跟踪脑机接口前沿。

加微信群:

添加微信:RoseBCI【备注:姓名+行业/专业】。

加QQ群:913607986

欢迎来稿

1.欢迎来稿。投稿咨询,请联系微信:RoseBCI

点击投稿:脑机接口社区学术新闻投稿指南

2.加入社区成为兼职创作者,请联系微信:RoseBCI

一键三连「分享」、「点赞」和「在看」

不错过每一条脑机前沿进展

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?