文章基本采用官方指导:

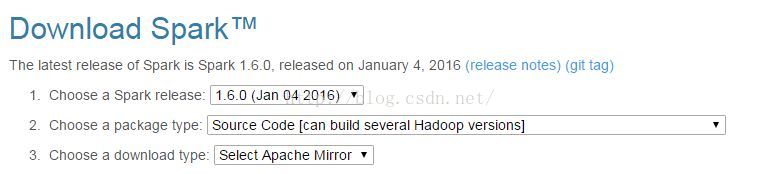

1、在spark官网下载源码,要选择source code

2、在环境变量里设置maven内存大小

export MAVEN_OPTS="-Xmx2g -XX:MaxPermSize=512M -XX:ReservedCodeCacheSize=512m"3、 编译及打包

## 简单的编译Spark和example程序

mvn -DskipTests clean package

## 指定hadoop版本compile

mvn -Pyarn -Phadoop-2.6 -Dhadoop.version=2.7.1 -DskipTests clean package

## 打包

bash make-distribution.sh --tgz --mvn /opt/maven/bin/mvn -Phive -Pyarn -Phadoop-2.6 -Phadoop-provided -Pnetlib-lgpl -Phive -Pscala-2.10 -Dhadoop.version=2.7.1 [--name 如果需要指定自己的tar名称]

## 打包 -- spark 1.4以后,取消了compute-classpath.sh脚本,导致所有通过本地起的程序无法找到hadoop相关的jar包,因此本地的程序需要使用如下的方式打包

make-distribution.sh --tgz --mvn /opt/maven/bin/mvn -Phive -Pyarn -Phadoop-2.6 -Pnetlib-lgpl -Phive -Pscala-2.10 -Dhadoop.version=2.7.1

## 指定hive

sh make-distribution.sh --tgz --mvn /opt/maven/bin/mvn -Phive -Phive-thriftserver -Pyarn -Phadoop-2.6 -Pnetlib-lgpl -Phive -Pscala-2.10 -Dhadoop.version=2.7.1 -Dhive.version.short=1.2.14、注意事项:

本例子使用maven打包,如果你有私服,尽量配上,下载会快些。

1850

1850

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?