整体上课状态:

89%时间在线

原因:抠手指,走神

终于重拾微科研了,过去6个月

今天的课程比我想象中的简单,在classin课后看回放真的对我这种小白,并且上课时不敢提问的(以前)人来说太友好。

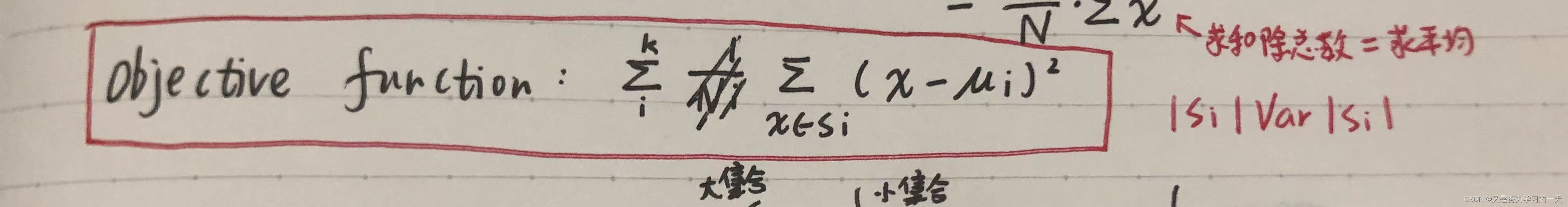

虽然说应该没学过方差,或者是学过但是完全没见过这个公式,但是并不影响理解,特别是在老师详细解释之后理解的更透彻了,虽然后面那个红色的公式我还是不太懂

目前对ML的理解好像还是分类,或者说transformation,从一堆照片中,分类为不同的种类(猫狗鸡鸭牛),写出能够做这件事的Model。

Model, Data, parameter一环扣一环,每个都很重要,越复杂的model能够应对的环境越多,data同时也决定model的样子,相反也需要用合适的model来describe合适的data;更直接的,data直接决定parameter,最简单的——y=ax+b,data图像开口向上a就是正。

Model和training都有两种。Generative model和Discriminative model:前者是要找到生产数据的源头,也就是数据产生的distribution,比如两种可乐,就算味道再像,一个就是百事一个就是可口;后者需要找到数据的不同,但只是找到boundary即可,如“不同”超过判断标准,即比较的东西是不同的,反之“不同”并不够大不够明显,就是一样的

Supervised learning和Unsupervised learning,前者是手把手教学,将每一个data (input)都label上类别,再让函数来分类(找trend),也就是每一个数据对应的值都会提供;后者更加常用,尽管没有那么精确,但更加方便,因为label是不好准备的,而data (input)更容易收集,所以这种training是不知道lable的,其让算法自行exploit数据间的关系。

以上是ML的basic info

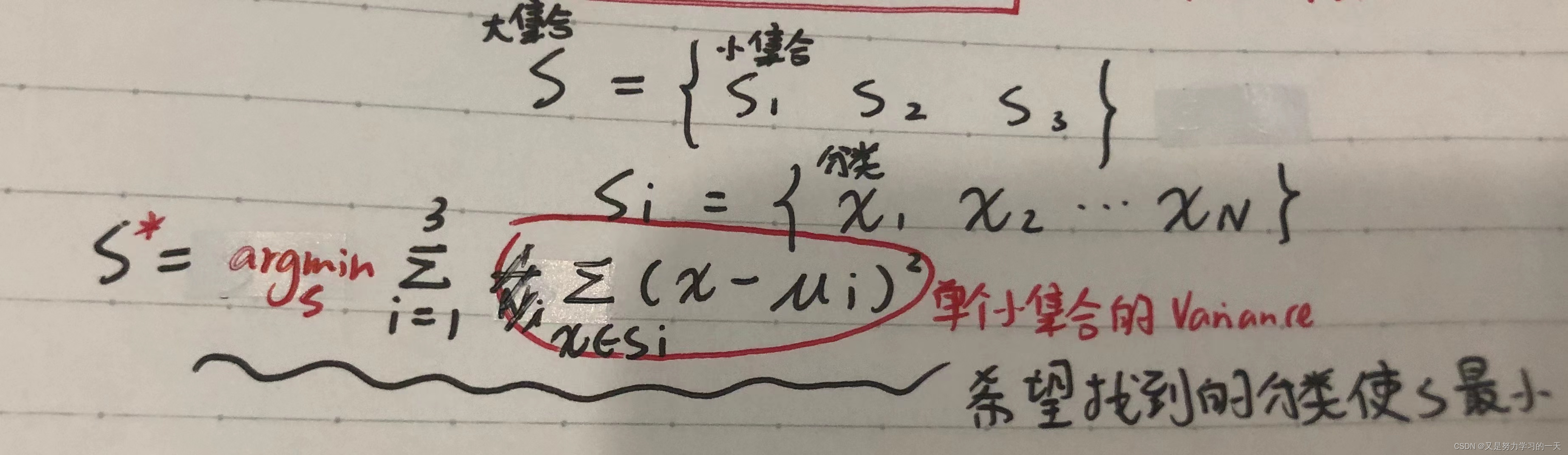

来到需要学习的第一个算法----K-means clustering

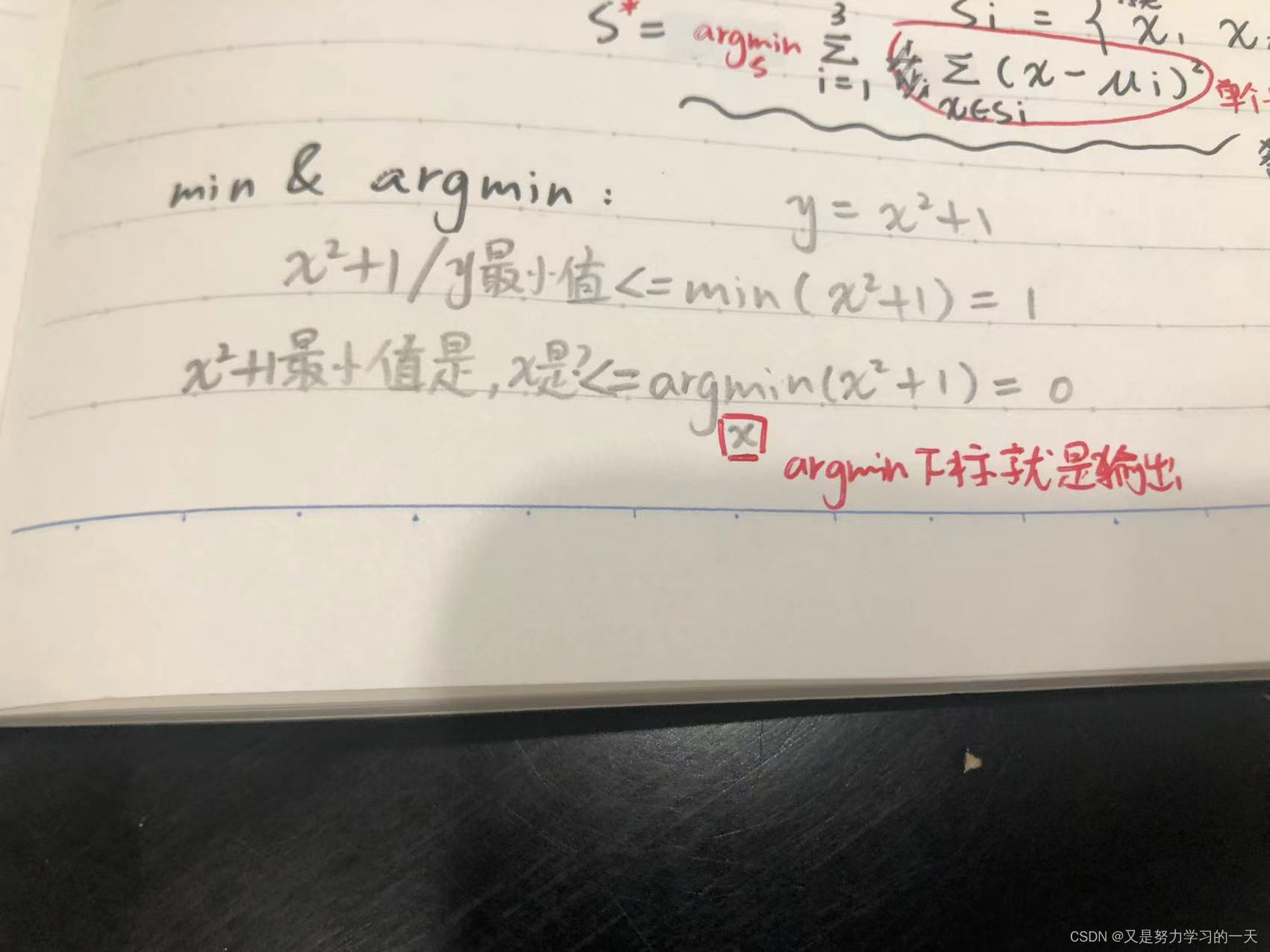

这个算法的目标不仅是要generate k clusters,因为只有这个目标的话,则没有评判标准,意味着可以随意规划cluster。另一个很重要的目标就是希望每一类数据都是紧凑的,这就需要方差来帮忙,在上面已经截图了该式子,下面这个图更容易理解。还学习了min和argmin的区别

接下来就是之前令我闻风丧胆的课后作业了,安装conda,了解numpy。到吃饭时间了,先缓一缓...

吓死我了差点以为草稿没了

已经安装了anaconda,但是不知道怎么“激活conda”?也不太清楚numpy怎么操作。。。先再去找点资料,研究一下numpy,然后接着上课听听老师怎么讲的吧

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?