Contrastively-reinforced Attention Convolutional Neural Network for Fine-grained Image Recognition

个人感觉,这篇论文没有太多创新点,效果也一般般

文章目录

摘要

灵感来源:通过将图像与相同/不同标签的图像进行对比,注意到关键线索位于某些对象中,其他对象可忽略。

提出了对比增强的注意力卷积神经网络(CRA-CNN),主要包含两部分:分类分支和注意力正则化分支。 前者进行分类,同时建议将输入的视觉信息分为注意力信息和冗余信息,后者评估注意力和冗余信息并对其进行对比。

1 引言

注意力定位可以帮助保留有用信息忽视无用信息,但注意力定位复杂,代价昂贵或者准确率低。

本文专注于增强CNN激活对视觉注意力的感知。调节网络以更多地响应核心注意力,该部分在不同条件下(背景,姿势,光照等)是不变的。 这样,网络可以在任何条件下响应正确的线索,并减少视觉冗余的影响。

对比增强的注意力卷积神经网络(CRA-CNN),该网络由两个分支组成:

-

分类分支 N c l s N_{cls} Ncls

- 预测图像类别

- 从给定图像学到的信息中,生成一组注意参数,输入到ART模块中。ART模块将将输入信息分成注意力和冗余。

-

注意力正则化分支 N a r N_{ar} Nar

N a r N_{ar} Nar评估 N c l s N_{cls} Ncls的注意力/冗余提议,并调节 N c l s N_{cls} Ncls的激活

训练过程二者都有,测试过程只有 N c l s N_{cls} Ncls,除了softmax损失外,还训练具有三重态损失的 N a r N_{ar} Nar来分离同一图像的注意力冗余对,并拉近不同图像的冗余度。

2 相关研究

基于区域的注意力学习

主流研究通过定位注意力区域进行分类,从而克服了类别间的相似性和类别内的差异。

注释方法不实际。无监督或弱监督方法的缺点:研究人员必须手动固定注意力区域的大小,形状等;裁剪局部区域不可避免地会丢失一些视觉信息。

注意感知的深层功能

一些研究通过对深层特征采用选择性或加权方案来专注于学习注意力。

本文方法不集中在设计额外复杂的方案以将某些权重应用于CNN特征,而是通过具有设计损失的子网的注意力调节来增强注意力感知

3 方法

- 分类分支是我们想要提升注意力的目标分支

- 注意力正则分支由于增强分类分支

- 两个分支通过ART模块连接。ART模块包含注意力转换模块(AT模块)和冗余转换模块(RT模块)

- 约束损失 L r e s L_{res} Lres使变换在合理范围内。 N a r N_{ar} Nar识别出注意力的类别,该类别应与输入的类别相同,然后拉近/推远变换后的图像。

-

N

c

l

s

N_{cls}

Ncls必须同时进行

- 预测给定图像的类别

- 预测以 N c l s N_{cls} Ncls内部的关注信息为条件的转换

- 确保转换后的图像中包含/排除的视觉信息具有区别性/冗余性

3.1 ART模块

ART模块必须满足三个要求:

- ART模块应该是可区分的,可以嵌入神经网络中

- ART模块应该是简单且易于优化

- 自动调整注意力的位置,大小和角度,以有效反映 N c l s N_{cls} Ncls的注意力

ART模块通过克服ST模块的缺点而从ST模块修正而成

预备知识:ST模块,也就是空间变换模块。文章里面这一部分符号较乱,统一了一下:

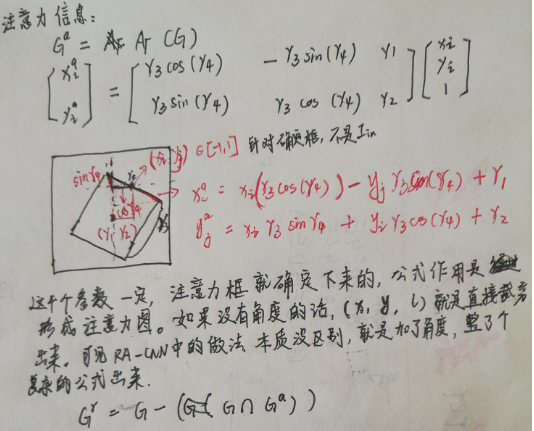

ART模块

分类网络产生四个参数 ,用于注意力

,用于注意力

约束

我们对ART模块施加了限制,以避免无意义的转换:

注意力损失( E = [ e 1 , e 2 , e 3 , e 4 ] E=[e1,e2,e3,e4] E=[e1,e2,e3,e4]是 Γ Γ Γ的期望值):

3.2 对比加强

图像成对输入(按照我的理解,应该是同label的)

其中 d d d表示欧几里得距离,而 f a r f_{ar} far表示 N a r N_{ar} Nar的深层特征。

在训练过程中,最小化了多任务目标函数:

在测试过程中,仅使用分类器。

4 实验

基线是resnet50和resnet101,可见这篇论文的水平,backbone是resnet50和resnet101,那肯定会有提升呀。

5 结论

- 提出了对比增强的注意力卷积神经网络(CRA-CNN),提高深度激活的注意力感知能力。CRA-CNN由两个分支组成,通过ART模块连接。 注意力正则化分支通过评估注意/冗余信息来迫使分类分支探索核心注意区域。

- 易于实现,成本低廉,简单,准确性有竞争力。

本文提出了一种对比增强注意力卷积神经网络(CRA-CNN),用于改善细粒度图像识别。CRA-CNN包含分类分支和注意力正则化分支,通过ART模块进行交互。分类分支进行图像分类,注意力正则化分支评估并调节注意力信息。在训练过程中,使用三重态损失分离注意力和冗余信息,提高网络对核心关注区域的响应,降低背景等因素的影响。实验表明,虽然方法相对简单,但能有效提升模型性能。

本文提出了一种对比增强注意力卷积神经网络(CRA-CNN),用于改善细粒度图像识别。CRA-CNN包含分类分支和注意力正则化分支,通过ART模块进行交互。分类分支进行图像分类,注意力正则化分支评估并调节注意力信息。在训练过程中,使用三重态损失分离注意力和冗余信息,提高网络对核心关注区域的响应,降低背景等因素的影响。实验表明,虽然方法相对简单,但能有效提升模型性能。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?