我在运行Spark程序的时候报错

java.lang.OutOfMemoryError:GC overhead limit exceeded伴随着通常有:

java.lang.OutOfMemoryError:Java heap space

org.apache.spark.shuffle.FetchFailedException:Failed to connect to ...这是因为executor的内存不足,导致GC杀死一些任务

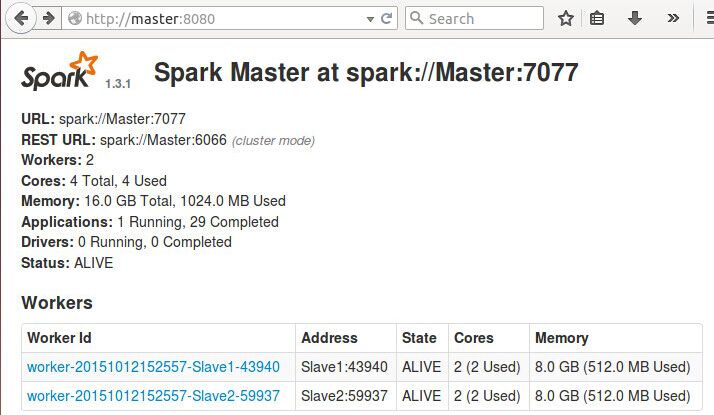

登录 http://Master:8080会看到

可以看到在这个应用了,每个节点只用到了512MB,这是spark程序默认的,解决这个问题只要设置VM Options中的spark.executor.memory属性即可。

比如用的IDEA,在Run configuration里设置VM Options:

-Dspark.executor.memory

当运行Spark程序时遇到'GC overhead limit exceeded'错误,通常是executor内存不足导致。解决方法包括在VM Options中设置spark.executor.memory属性,确保其小于节点内存。在IDEA的Run configuration中设置此参数,或在${SPARK_HOME}/conf/spark-env.sh文件中修改worker内存。优化代码,如及时unpersist不再使用的RDD,也是更根本的解决策略。

当运行Spark程序时遇到'GC overhead limit exceeded'错误,通常是executor内存不足导致。解决方法包括在VM Options中设置spark.executor.memory属性,确保其小于节点内存。在IDEA的Run configuration中设置此参数,或在${SPARK_HOME}/conf/spark-env.sh文件中修改worker内存。优化代码,如及时unpersist不再使用的RDD,也是更根本的解决策略。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

958

958

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?