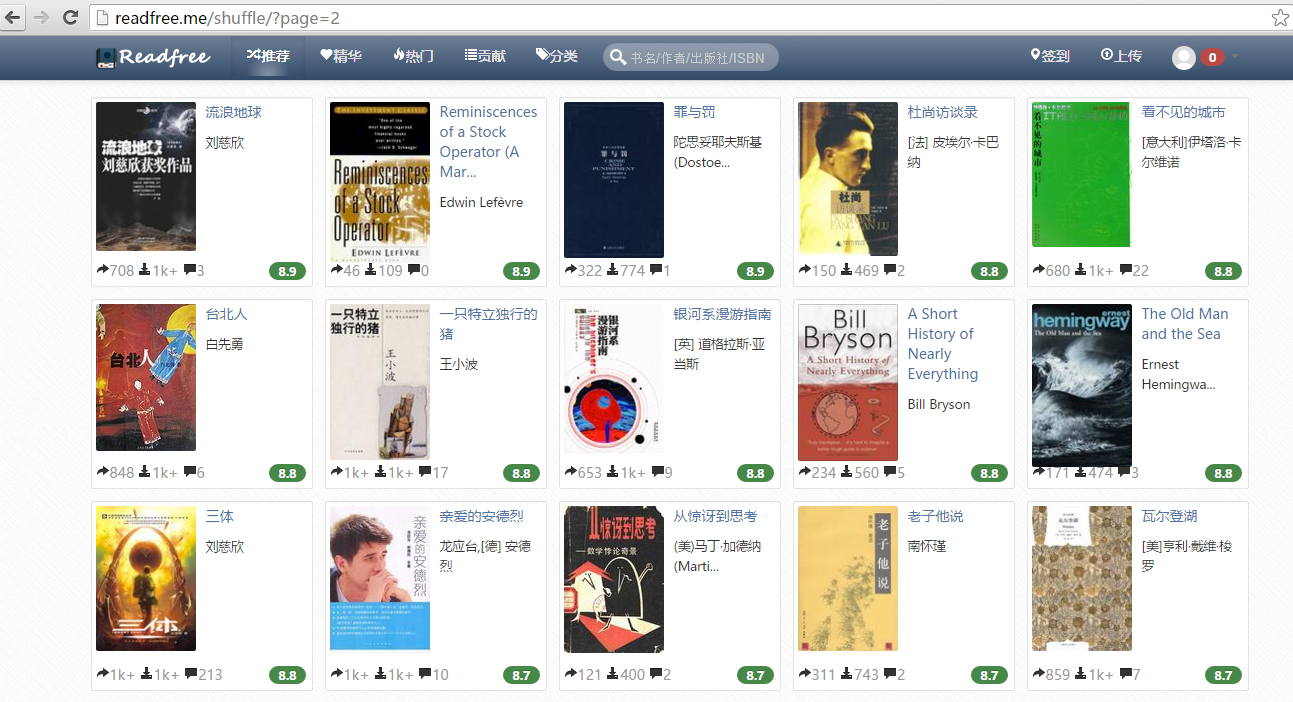

在以上两篇文章中已经介绍到了 Python 爬虫和 MongoDB , 那么下面我就将爬虫爬下来的数据存到 MongoDB 中去,首先来介绍一下我们将要爬取的网站, readfree 网站,这个网站非常的好,我们只需要每天签到就可以免费下载三本书,良心网站,下面我就将该网站上的每日推荐书籍爬下来。

利用上面几篇文章介绍的方法,我们很容易的就可以在网页的源代码中寻找到书籍的姓名和书籍作者的信息。

找到之后我们复制 XPath ,然后进行提取即可。源代码如下所示

# coding=utf-8

import re

import requests

from lxml import etree

import pymongo

import sys

reload(sys)

sys.setdefaultencoding('utf-8')

def getpages(url, total):

nowpage = int(re.search('(\d+)', url, re.S).group(1))

urls = []

for i in range(nowpage, total + 1):

link = re.sub('(\d+)', '%s' % i, url, re.S)

urls.append(link)

return urls

def spider(url):

html = requests.get(url)

selector = etree.HTML(html.text)

book_name = selector.x

本文讲述了如何使用Python爬虫从网页源代码中提取书籍的姓名和作者信息,并详细介绍了如何避免一次性写入数据库导致数据丢失的问题。通过逐条写入和处理源代码中的编码问题,确保数据正确存储。同时,提到了在提取信息时去除换行符的步骤,以提高数据的整洁性。最后,提醒读者在运行程序时确保MongoDB已启动,并欢迎指出代码的改进意见。

本文讲述了如何使用Python爬虫从网页源代码中提取书籍的姓名和作者信息,并详细介绍了如何避免一次性写入数据库导致数据丢失的问题。通过逐条写入和处理源代码中的编码问题,确保数据正确存储。同时,提到了在提取信息时去除换行符的步骤,以提高数据的整洁性。最后,提醒读者在运行程序时确保MongoDB已启动,并欢迎指出代码的改进意见。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1038

1038

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?