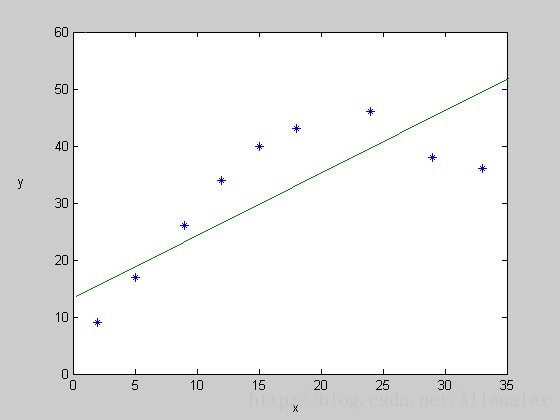

在线性回归中,对于给定的训练集,用一个线性表达式来拟合所有数据,当训练集中输入变量和目标变量之间的确存在线性关系时,通常拟合的很好。但是如果没有明显的线性关系的话,可能就拟合不到好的效果了。比如下面坐标表示的情形,用一条直线来拟合图上的点显然不是很合适。

这种情况叫做欠拟合(underfitting)。

通常来说,对待这种情况,特征的选择可能会非常的重要,比如,对于上面的图,如果加特征:x的平方,或者其他比如sin(x)可能能够实现很好的拟合这些点。我们这里要介绍的局部加权(线性)回归(locally weighted linear regression),在保证有足够训练数据的前提下,能够使得特征的选择没有那么关键。

线性回归算法中,给定一个查询点x,要预测其对应的y(也就是h(i)),处理方法如下:

1.选择合适的参数向量

,

2.输出

局部加权回归的处理方式如下:

1.选择合适的参数向量

,

2.输出

与线性回归的区别显然是在第一步中多了一个权值w(i)。这个权值也就是改方法为什么叫做“加权“,同时从后面的解释,你会发现它也是能够说明为了该方法又包含”局部“的原因。

这个权值怎么定义?又有什么用呢?

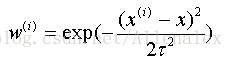

显然,在线性回归中,给定某个值,预测其对应的输出时,是通盘考虑所有的训练数据集。从上面的图我们看到,与其使用所有的点,可能还不如使用要预测的值的局部的几个训练数据点好。这是局部加权回归的思想,那要如何实现只考虑,或者更准确的说主要考虑局部的训练数据呢?这就是w(i)的任务了。下面给出w(i)的一种数学定义方式,读者可以提供其他的形式,只要能够实现相应的功能就行:

其中x是要预测的值,x(i)是第i个训练数据。分母中的符号’t‘控制训练点随着距离查询点x衰减的速率。越大,衰减的越慢,反之则越快。

从上式可以很明显的看到随着x(i)里x越远,权值w(i)越小。

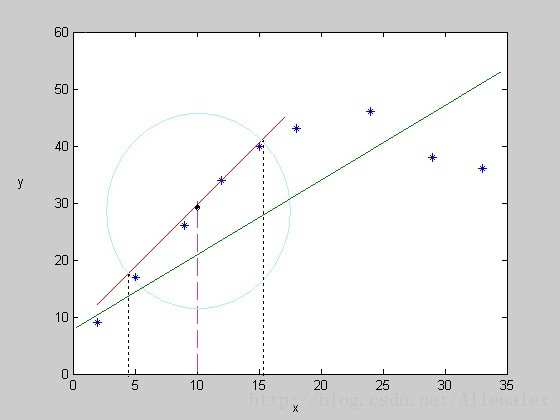

我们的标题中局部加权(线性)回归。从上面我们已经知道”局部“,”加权“的来源,那这个线性体现在哪呢?我们想一想,从上面的局部加权回归的两步的第1部我们能够看出,在预测x对应的输出时,我们采用的是什么呢?从假设可以看出,采用的仍然是线性回归的方式,只是不像初始的线性回归,局部加权线性回归是在”局部“采用线性回归。从下图可能看到更仔细。

对上图的说明:假如给定x=10,要预测对应的y值,如果又线性拟合的方法的会,拟合得到的是图中的绿线,那么对应的点将在该直线上,但如果是局部加权,也就是只考虑(主要)两条虚线之间,也就是圆圈之内的四个点来线性拟合,那么得到的是那条红线,对应的点在这条红线上相对的y值就是预测值,从直观上来看就可以认为这种预测会更准确。

对于局部加权回归的文字介绍到这里,后续有时间再附上相应的代码吧 。

。

2936

2936

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?