一、介绍

这个文档讨论的是CNNs的推导和实现。CNN架构的连接比权值要多很多,这实际上就隐含着实现了某种形式的规则化。这种特别的网络假定了我们希望通过数据驱动的方式学习到一些滤波器,作为提取输入的特征的一种方法。

本文中,我们先对训练全连接网络的经典BP算法做一个描述,然后推导2D CNN网络的卷积层和子采样层的BP权值更新方法。在推导过程中,我们更强调实现的效率,所以会给出一些Matlab代码。最后,我们转向讨论如何自动地学习组合前一层的特征maps,特别地,我们还学习特征maps的稀疏组合。

二、全连接的反向传播算法

典型的CNN中,开始几层都是卷积和下采样的交替,然后在最后一些层(靠近输出层的),都是全连接的一维网络。这时候我们已经将所有两维2D的特征maps转化为全连接的一维网络的输入。这样,当你准备好将最终的2D特征maps输入到1D网络中时,一个非常方便的方法就是把所有输出的特征maps连接成一个长的输入向量。然后我们回到BP算法的讨论。(更详细的基础推导可以参考UFLDL中“反向传导算法”)。

2.1、Feedforward Pass前向传播

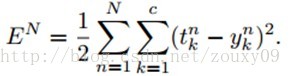

在下面的推导中,我们采用平方误差代价函数。我们讨论的是多类问题,共c类,共N个训练样本。

这里

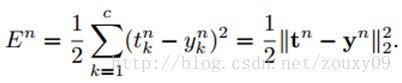

因为在全部训练集上的误差只是每个训练样本的误差的总和,所以这里我们先考虑对于一个样本的BP。对于第n个样本的误差,表示为:

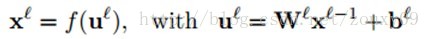

传统的全连接神经网络中,我们需要根据BP规则计算代价函数E关于网络每一个权值的偏导数。我们用l来表示当前层,那么当前层的输出可以表示为:

输出激活函数f(.)可以有很多种,一般是sigmoid函数或者双曲线正切函数。sigmoid将输出压缩到[0, 1],所以最后的输出平均值一般趋于0 。所以如果将我们的训练数据归一化为零均值和方差为1,可以在梯度下降的过程中增加收敛性。对于归一化的数据集来说,双曲线正切函数也是不错的选择。

2.2、Backpropagation Pass反向传播

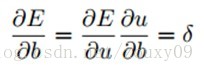

反向传播回来的误差可以看做是每个神经元的基的灵敏度sensitivities(灵敏度的意思就是我们的基b变化多少,误差会变化多少,也就是误差对基的变化率,也就是导数了),定义如下:(第二个等号是根据求导的链式法则得到的)

因为∂u/∂b=1,所以∂E/∂b=∂E/∂u=δ,也就是说bias基的灵敏度∂E/∂b=δ

本文详细介绍了CNN的反向传播算法,包括全连接网络的反向传播、卷积层和子采样层的权值更新,并探讨了如何自动学习特征地图的组合,以及在MATLAB中实现CNN训练的优化技巧。内容涵盖误差反向传播、权重更新、卷积层和子采样层的梯度计算,以及稀疏组合学习。

本文详细介绍了CNN的反向传播算法,包括全连接网络的反向传播、卷积层和子采样层的权值更新,并探讨了如何自动学习特征地图的组合,以及在MATLAB中实现CNN训练的优化技巧。内容涵盖误差反向传播、权重更新、卷积层和子采样层的梯度计算,以及稀疏组合学习。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

49万+

49万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?