一、逻辑回归

在 机器学习之线性回归 中,我们可使用梯度下降的方法得到一个映射函数 hθ(X) 来去贴近样本点,这个函数是对连续值的一个预测。

而逻辑回归是解决分类问题的一个算法,我们可以通过这个算法得到一个映射函数 f:X→y ,其中 X 为特征向量,

二、判定边界

当将训练集的样本以其各个特征为坐标轴在图中进行绘制时,通常可以找到某一个 判定边界 去将样本点进行分类。例如:

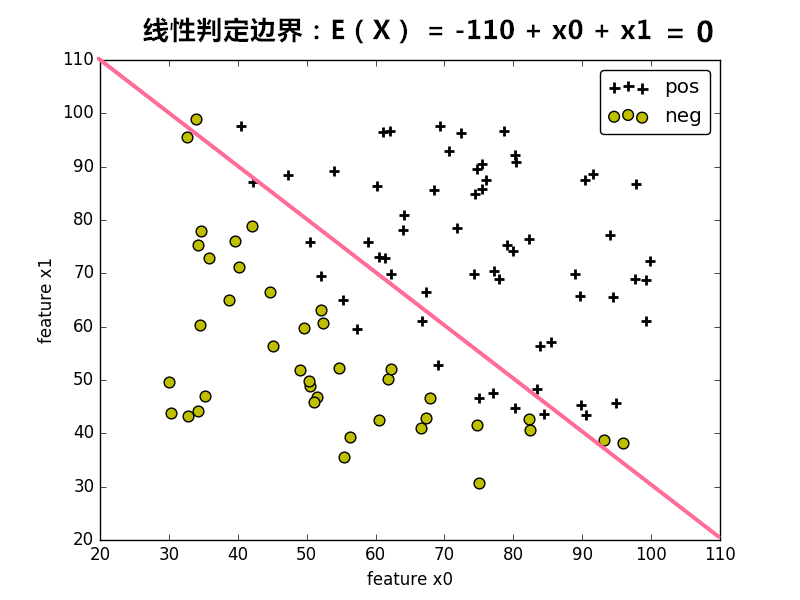

线性判定边界:

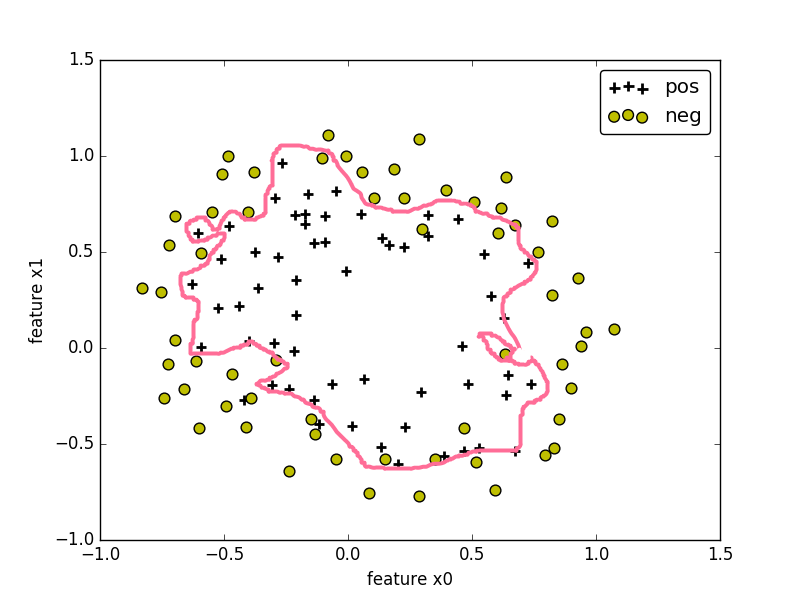

非线性判定边界:

在图中,样本的标记类型有两种类型,一种为正样本,另一种为负样本,样本的特征 x0 和 x1 为坐标轴。根据样本的特征值,可将样本绘制在图上。

在图中,可找到某个 判定边界 来对不同标签的样本进行划分。根据这个判定边界,我们可以知道哪些样本是正样本,哪些样本为负样本。

因此我们可以通过学习得到一个方程 Eθ(X)=0 来表示 判定边界,即 判定边界 为 Eθ(X)=0 的点集。(可以看作是等高超平面)

其中 θ={ θ0,θ1,θ2,...,θn} ,为保留 Eθ(X)=0 中的常数项,令特征向量 X={ 1,x1,x2,…,xn} 。

为使得我们的边界可以非线性化,对于特征 xi 可以为特征的高次幂或相互的乘积。

对于位于判定边界上的样本,其特征向量 X 可使得

本文深入探讨了逻辑回归的原理,包括判定边界、二分类和sigmoid函数,以及损失函数的定义、极大似然估计和正则化。接着,文章介绍了如何从二分类扩展到多分类,重点讲解了softmax函数在多分类问题中的应用,并给出了tensorflow的代码示例。

本文深入探讨了逻辑回归的原理,包括判定边界、二分类和sigmoid函数,以及损失函数的定义、极大似然估计和正则化。接着,文章介绍了如何从二分类扩展到多分类,重点讲解了softmax函数在多分类问题中的应用,并给出了tensorflow的代码示例。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

185

185

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?