最近在学习python爬虫,前几天接触到模拟登陆这一块,其实之前就有接触过,但时间有点久远就遗忘了。在看了汪海的[Python]网络爬虫(十):一个爬虫的诞生全过程(以山东大学绩点运算为例)这篇文章后,尝试模拟登录自己学校的网站获取信息,但在登录这一块就卡壳了。

说明一下学校登录界面的情况。当需要进入个人信息的时候,比如图书馆、选课等,都会进入到一个专门的统一身份认证的界面,如图1所示。

可以从图中看出,这儿的登录需要验证码,这就需要确保在模拟登陆时候获取的验证码一定和获取当前页面的验证码一致。 另外,这个验证码是动态生成的,所以没有办法在请求页面之后将获取到的页面内容进行解析获取验证码的网址。

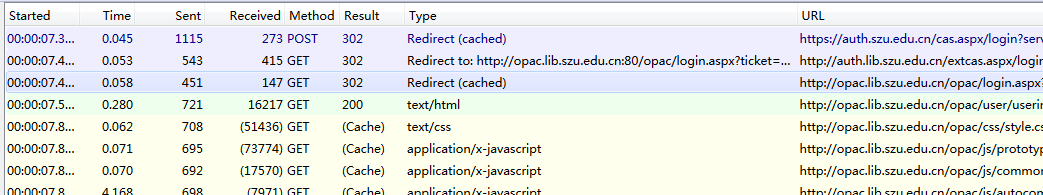

图2给出的登录时所捕获到的数据。(Firefox + httpfox插件,目前感觉比chrome自带的审查元素要好用点)

可以从图2看出,在登录提交表单(提交用户名、密码等信息&

本文介绍了在学习Python爬虫过程中遇到的模拟登录问题,特别是针对存在统一身份认证界面的网站。通过分析登录时的数据交换,找到真实的提交表单网址,并利用urllib2库的cookie功能解决验证码获取,同时处理登录过程中的重定向问题。

本文介绍了在学习Python爬虫过程中遇到的模拟登录问题,特别是针对存在统一身份认证界面的网站。通过分析登录时的数据交换,找到真实的提交表单网址,并利用urllib2库的cookie功能解决验证码获取,同时处理登录过程中的重定向问题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6210

6210

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?