在上一篇博文有介绍hadoop的完全分布式模式的配置,但是没有对负载进行均衡设置,本篇博文就来说明将NameNode,SecondaryNameNode,JobTracker分别指定到三台主机上。

1. 指定SecondaryNameNode为host2

1.1 配置masters

使用如下命令:

vim conf/masters将之前的host1修改为host2,然后使用如下的命令复制到host2和host3:

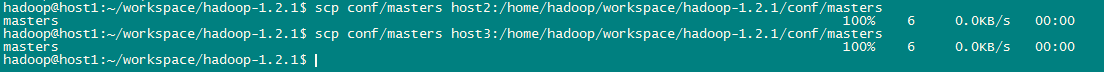

scp conf/masters host2:/home/hadoop/workspace/hadoop-1.2.1/conf/masters

scp conf/masters host3:/home/hadoop/workspace/hadoop-1.2.1/conf/masters如下:

1.2 配置hdfs-site.xml

在conf/hdfs-site.xml里面添加如下内容:

<property>

<name>dfs.http.address</name>

<value>host1:50070</value>

</property>

<property>

<name>dfs.secondary.http.address</

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1043

1043

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?