Spark学习笔记-开始第一个spark程序

在安装完Spark,其实最疑惑还是Spark怎么用的问题,由于也是刚学习linux,也不是很习惯linux下的命令行操作。按照Spark的官方文档,我们开始编写Spark的的第一个程序。

一、标准进入spark方式

很多人在安装完spark后就懵了,本人也是一样。毕竟spark在linux下没有什么桌面图标这种明显的东西。要启动Spark,我们先要进入Spark的目录下。我们在Unbutu桌面输入Ctrl+Alt+T 打开控制台,然后输入:

cd /usr/lib/spark/spark-1.4.0 这个路径是我的安装路径,也就是spark的目录。Spark一共提供了3中API 分别为 scala、java以及python,同时提供了scala和python的命令行操作。

进入scala环境,输入:

./bin/spark-shell进入python环境,输入:

./bin/pyspark二、快捷进入spark方式

这个是官方提供的进入spark命令行的方式,实际上我发现直接呼出控制台然后直接输入spark-shell以及pyspark也能够直接进入相应的环境。如果能够直接进入spark的环境,那么就可以偷个懒直接输入spark-shell和pyspark。

三、编写spark的第一个程序

由于本人不太熟悉python,同时spark的官方例程也是scala编写的,所以这里的DEMO默认都是spark环境下的程序。

Spark最主要的抽象是RDD,前面一篇文章《Spark学习笔记-Spark-弹性分布式数据集RDDs》已经初步的总结了一下。RDD有很多的创建方式,我们甚至可以通硬盘中的一个txt文件创建一个RDD。

输入:

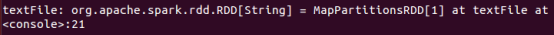

val textFile = sc.textFile("README.md") 得到:

经过前面的语句我们可以得到RDD到textFile的映射,也就是textFile这个变量,同时textFile就是一个RDD。我们可以对它进行很多RDD的操作。

例如输入:

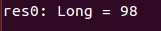

textFile.count() 得到:

说明:实际上spark运行过程中控制台还会输出其他信息,这里只输出最后的结果。还有一点就是本人在直接进入spark-shell时,这个例程运行出现错误,猜测这个地方和Matlab类似,有个目录的问题,这个README.md在spark的目录下面,如果直接进入可能导致spark找不到这个文件。

539

539

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?