高德api接口地址:https://lbs.amap.com/api/webservice/guide/api/search

如果不是高德开发者可以申请为开发者

第一步,申请”Web服务API”密钥(Key);

第二步,拼接HTTP请求URL,第一步申请的Key需作为必填参数一同发送;

第三步,接收HTTP请求返回的数据(JSON或XML格式),解析数据。

如无特殊声明,接口的输入参数和输出数据编码全部统一为UTF-8。

1. 通过高德搜索接口得到附近小区搜索列表

解析后获取到正确小区的id

其中city是城市代码,可以通过浏览器手工获取到。words是搜索的具体风景区名称。

url链接

https://restapi.amap.com/v3/place/text?key=4b86820a7590de60e4f81f53e59ae17f&citylimit=true&output=json&key为申请的密钥,申请详细步骤文档有说明

keywords 查询的关键词,如景区/小区名称

city 查询的目标城市

示例

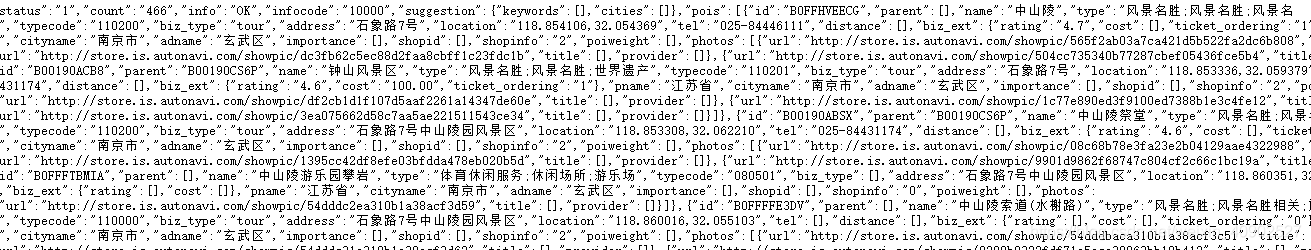

https://restapi.amap.com/v3/place/text?key=4b86820a7590de60e4f81f53e59ae17f&citylimit=true&output=json&keywords=中山陵景区&city=南京返回结果为json字符串

提取景区/小区的id:B0FFHVEECG

方案1

1.然后通过poiid调用另外一个接口查询该景区/小区

接口地址:

https://ditu.amap.com/detail/get/detail?id=B0FFHVEECG参数id填写上面获取到的poiid=B0FFHVEECG

1. 将返回的结果转成json然后逐层提取出来

2.存入数据库或者csv文档

def info(self, response):

meta = response.meta

data = json.loads(response.text)

print(data)

try:

if data["status"] == "1":

spec = data["data"]["spec"]

border = spec["mining_shape"]["shape"]

print("border ",border)

AllCityDataSQL().UpdateXcJingDianiData((meta["id"]),border)

except:

print("查询错误~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~" + meta["url"])方案2

2. 通过poiid查找边界信息,红色部分可以替换成其他城市代码(身份证前6位)和景区id

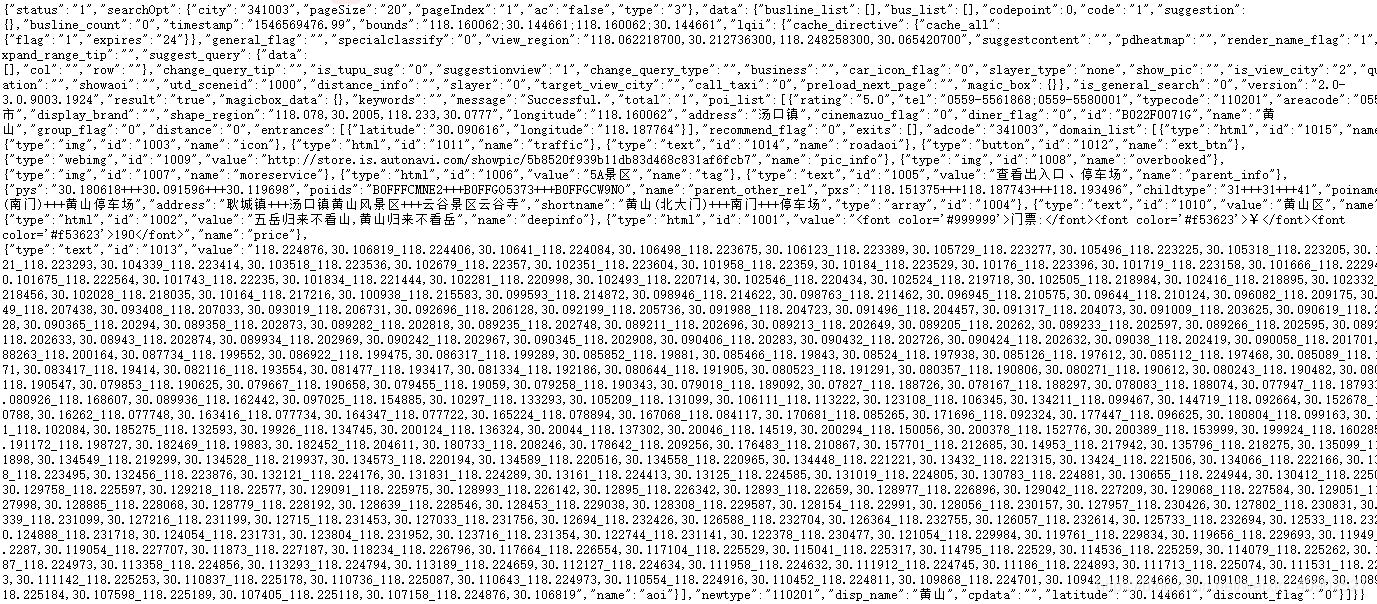

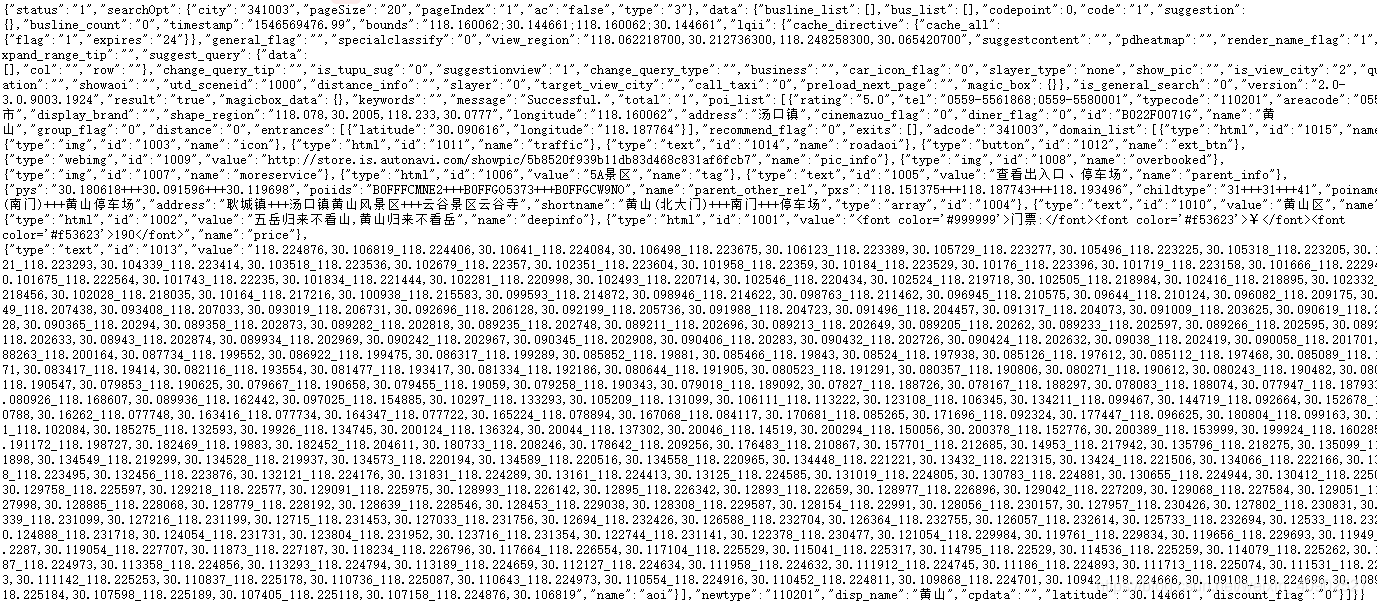

接口地址 https://gaode.com/service/poiInfo?query_type=IDQ&pagesize=20&pagenum=1&qii=true&cluster_state=5&need_utd=true&utd_sceneid=1000&div=PC1000&addr_poi_merge=true&is_classify=true&zoom=11&id=B022F0071G&city=341003

返回json字符串

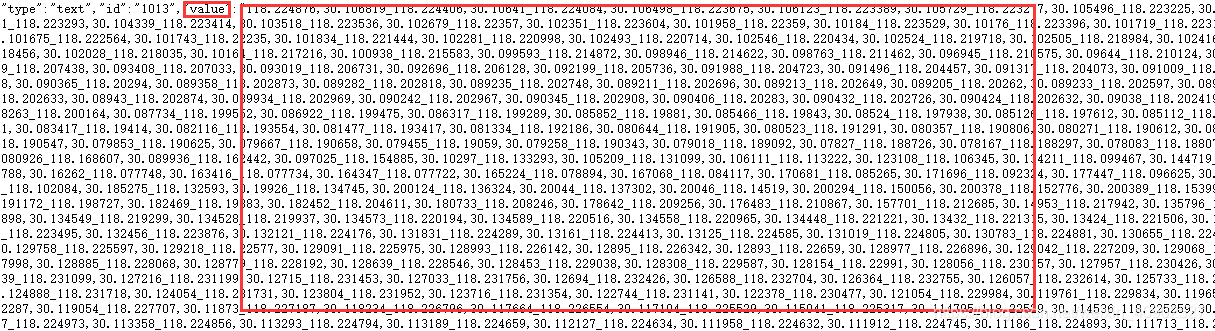

value字段 由一堆坐标组成的数值

1.将返回的结果转成json ,然后逐层提取出来

2.返回的value字段值还需修改一下,将_换成,才能使用

3.存入数据库或者csv文档

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?