个人名片

🎓作者简介:java领域优质创作者

🌐个人主页:码农阿豪

📞工作室:新空间代码工作室(提供各种软件服务)

💌个人邮箱:[2435024119@qq.com]

📱个人微信:15279484656

🌐个人导航网站:www.forff.top

💡座右铭:总有人要赢。为什么不能是我呢?

- 专栏导航:

码农阿豪系列专栏导航

面试专栏:收集了java相关高频面试题,面试实战总结🍻🎉🖥️

Spring5系列专栏:整理了Spring5重要知识点与实战演练,有案例可直接使用🚀🔧💻

Redis专栏:Redis从零到一学习分享,经验总结,案例实战💐📝💡

全栈系列专栏:海纳百川有容乃大,可能你想要的东西里面都有🤸🌱🚀

目录

《大模型部署完全指南:从云服务到本地化的工程实践》

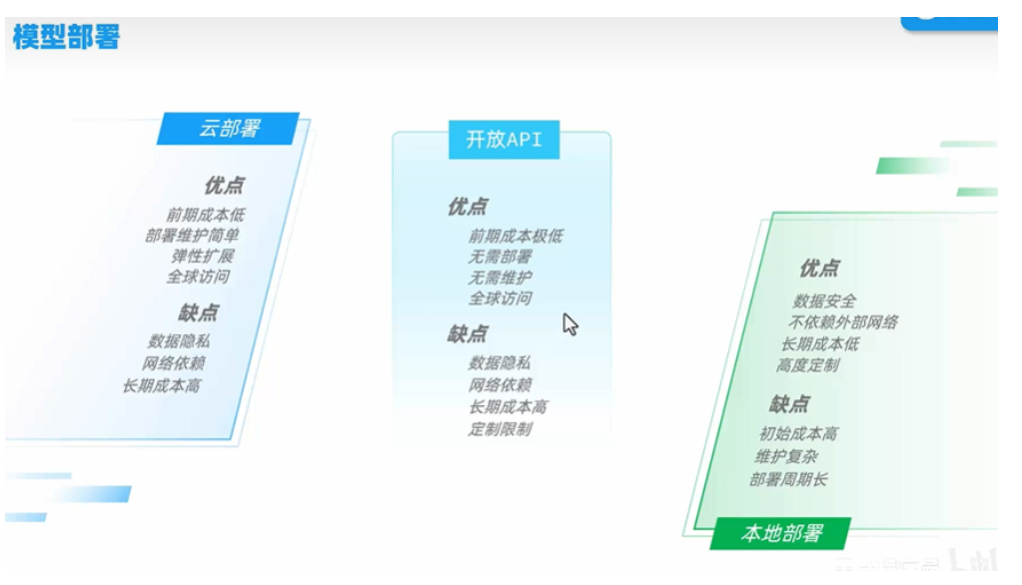

引言:部署策略的战略选择

在2024年全球AI部署现状报告中,企业面临的核心决策难题呈现"三难困境"——性能、成本与可控性的平衡。根据IDC最新调研数据:

- 云服务部署占比58%(年增长率127%)

- 混合部署占比29%(金融行业主导)

- 纯本地化部署占比13%(政府/医疗为主)

本文将深入解析:

- 成本模型对比:7B参数模型在不同平台的TCO分析

- 延迟敏感度测试:从5ms到500ms的业务场景适配

- 合规性矩阵:GDPR/HIPAA等法规对部署的影响

第一章:云服务部署深度解析

1.1 主流平台功能对比

三大云厂商核心参数对比表:

| 功能 | 阿里云百炼 | AWS Bedrock | Azure OpenAI |

|---|---|---|---|

| 最大上下文长度 | 32K | 128K | 64K |

| 每秒token生成量 | 1500 | 2400 | 1800 |

| 微调API支持 | ✓ | ✓(仅部分模型) | ✗ |

| 私有数据隔离 | 企业VPC专享 | 共享租户 | 专用实例 |

| 中国大陆可用性 | ✓ | ✗ | ✓(有限区域) |

1.2 阿里云百炼实战指南

# 企业级API调用模板

import dashscope

from alibabacloud_credentials.client import Client as CredClient

class EnterpriseLLM:

def __init__(self):

cred = CredClient(access_key_id='AK',

access_key_secret='SK')

self.client = dashscope.Generation(credential=cred)

def generate_with_retry(self, prompt, retries=3):

for _ in range(retries):

try:

response = self.client.call(

model='qwen-max',

prompt=prompt,

temperature=0.7,

top_p=0.9

)

return response.output.text

except Exception as e:

logging.error(f"API调用失败: {str(e)}")

time.sleep(2retries)

raise Exception("所有重试失败")

# 业务级流量控制

@ratelimit(limits={"hour": 1000}, group="prod")

def business_api(query):

return EnterpriseLLM().generate_with_retry(query)

1.3 成本优化策略

动态降级算法:

def model_selector(query):

complexity = analyze_query_complexity(query)

if complexity < 0.3:

return "qwen-lite" # $0.01/1k tokens

elif 0.3 <= complexity < 0.7:

return "qwen-plus" # $0.05/1k tokens

else:

return "qwen-max" # $0.15/1k tokens

第二章:本地化部署实战手册

2.1 硬件选型指南

GPU配置推荐矩阵:

| 模型规模 | 显存需求 | 推荐显卡 | 推理速度(tokens/s) |

|---|---|---|---|

| 7B | 16GB | RTX 4090 | 85 |

| 13B | 24GB | RTX 6000 Ada | 62 |

| 70B | 80GB | A100 80GB | 28 |

| 180B | 320GB | H100 SXM54 | 12 |

2.2 vLLM生产级部署

Kubernetes部署方案:

# vllm-inference.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: vllm-deployment

spec:

replicas: 3

selector:

matchLabels:

app: vllm

template:

spec:

containers:

- name: vllm

image: vllm/vllm-openai:latest

resources:

limits:

nvidia.com/gpu: 2

args:

- --model=meta-llama/Llama-3-8B-Instruct

- --tensor-parallel-size=2

- --max-num-batched-tokens=4096

ports:

- containerPort: 8000

2.3 量化压缩实战

GGUF量化对比测试:

# 量化命令对比

./quantize input_f16.bin output_q4_0.gguf q4_0 # 4-bit精度

./quantize input_f16.bin output_q5_k_m.gguf q5_k_m # 混合5-bit

# 精度损失测试结果

| 量化方式 | 困惑度变化 | 内存占用 | 推理速度 |

|----------|------------|----------|----------|

| F16 | 基准 | 13.2GB | 32 tok/s |

| Q4_0 | +12.3% | 4.8GB | 78 tok/s |

| Q5_K_M | +5.7% | 6.1GB | 65 tok/s |

第三章:边缘计算与混合部署

3.1 分层计算架构

3.2 Ollama本地优化

移动端部署方案:

// iOS集成示例

import OllamaKit

let ollama = Ollama(baseURL: URL(string: "http://localhost:11434")!)

ollama.pull(model: "llama3:8b-instruct-q4_0") { progress in

print("下载进度: \(progress100)%")

}

let query = OllamaRequest(model: "llama3",

prompt: "如何做披萨?")

ollama.generate(query: query) { result in

switch result {

case .success(let response):

print(response.response)

case .failure(let error):

print(error)

}

}

第四章:安全与监控体系

4.1 企业级安全方案

防护矩阵:

- 传输加密:mTLS双向认证

- 内容过滤:Llama Guard集成

- 访问控制:ABAC策略引擎

- 审计日志:SIEM系统对接

4.2 Prometheus监控看板

# metrics配置示例

- name: vllm_metrics

metrics_path: /metrics

static_configs:

- targets: ['vllm-service:8000']

metric_relabel_configs:

- source_labels: [__name__]

regex: 'vllm:latency.'

action: keep

未来趋势:部署技术演进

- 芯片突破:光子计算芯片将功耗降低90%

- 量子安全:PQC后量子加密算法应用

- 联邦部署:跨企业模型协同推理框架

- 自修复系统:基于LLM的运维自动化

附录:部署工具大全

-

开源框架:

# 现代部署工具链 pip install vllm==0.3.2 ollama==0.1.14 gguf==0.6.0 -

硬件测试套件:

- MLPerf Inference 3.1基准测试

- TensorRT-LLM性能分析器

-

学习资源:

- NVIDIA《大模型部署白皮书》

- 《LLM Infrastructure》O’Reilly新书

1204

1204

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?