一,定义

机器翻译是指将一段文本从一种语言自动翻译到另一种语言。机器翻译在很多应用场景中都有广泛应用,如国际化软件的本地化、跨语言信息检索、多语言聊天机器人等。然而,机器翻译仍然面临一些挑战,如处理复杂的语言结构、理解上下文和消除歧义等。随着技术的不断进步,机器翻译的准确性和流畅性也在不断提高。因为一段文本序列在不同语言中的长度不一定相同,所以我们使用机器翻译为例来介绍编码器—解码器和注意力机制的应用。

二,基本流程与翻译方法

1,流程

- 预处理:对源语言进行分析,包括词性标注、句法分析等。

- 转换:将源语言转换成目标语言,这涉及到词汇、句法和语义的转换。

- 后处理:对目标语言进行校对和润色,以使其更符合目标语言的习惯。

2,方法

- 基于规则的机器翻译(Rule-Based Machine Translation, RBMT):依赖于人工编写的语法和词典,适用于特定的语言对和领域。

- 基于实例的机器翻译(Example-Based Machine Translation, EBMT):通过查找相似的翻译实例来生成翻译结果。

- 基于统计的机器翻译(Statistical Machine Translation, SMT):利用大量的双语语料库来训练模型,通过概率模型进行翻译。

- 基于神经网络的机器翻译(Neural Machine Translation, NMT):利用深度学习技术,特别是循环神经网络(RNN)和长短时记忆网络(LSTM),来进行翻译。

三,实验步骤与代码

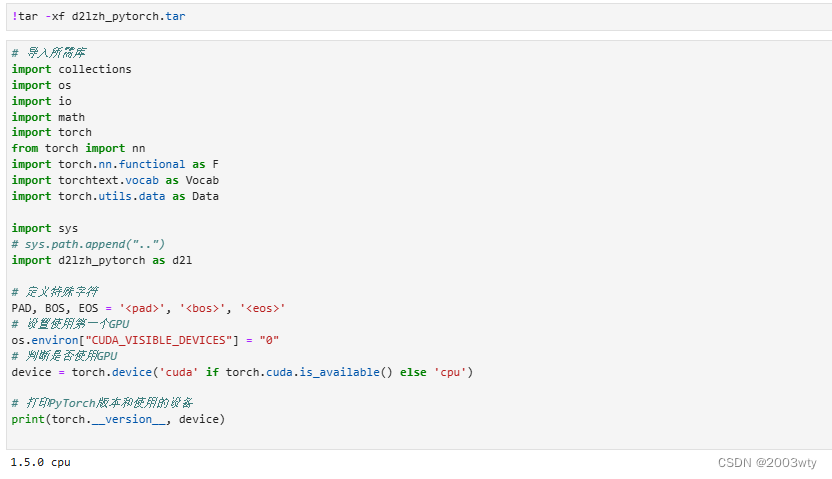

1,读取和预处理数据

定义一些特殊符号。其中“<pad>”(padding)符号用来添加在较短序列后,直到每个序列等长,而“<bos>”和“<eos>”符号分别表示序列的开始和结束。

定义两个辅助函数对后面读取的数据进行预处理。

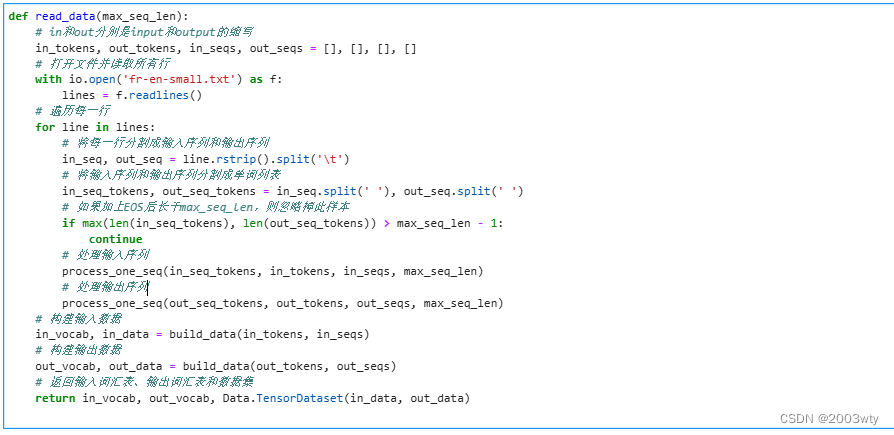

为了演示方便,我们在这里使用一个很小的法语—英语数据集。在这个数据集里,每一行是一对法语句子和它对应的英语句子,中间使用'\t'隔开。在读取数据时,我们在句末附上“<eos>”符号,并可能通过添加“<pad>”符号使每个序列的长度均为max_seq_len。我们为法语词和英语词分别创建词典。法语词的索引和英语词的索引相互独立。

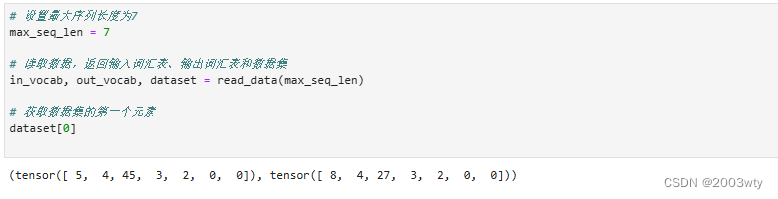

将序列的最大长度设成7,然后查看读取到的第一个样本。该样本分别包含法语词索引序列和英语词索引序列。

2,含注意力机制的编码器—解码器

我们将使用含注意力机制的编码器—解码器来将一段简短的法语翻译成英语。下面我们来介绍模型的实现。

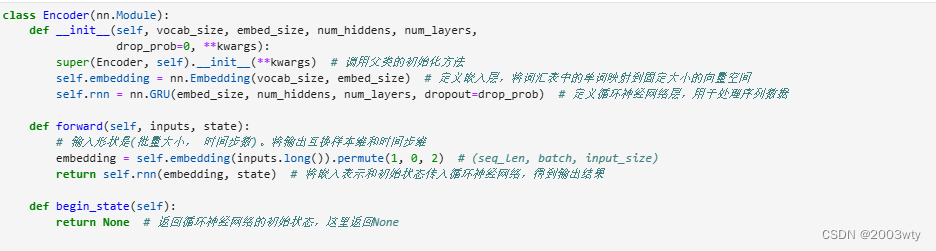

2.1 编码器

在编码器中,我们将输入语言的词索引通过词嵌入层得到词的表征,然后输入到一个多层门控循环单元中。正如我们在6.5节(循环神经网络的简洁实现)中提到的,PyTorch的nn.GRU实例在前向计算后也会分别返回输出和最终时间步的多层隐藏状态。其中的输出指的是最后一层的隐藏层在各个时间步的隐藏状态,并不涉及输出层计算。注意力机制将这些输出作为键项和值项。

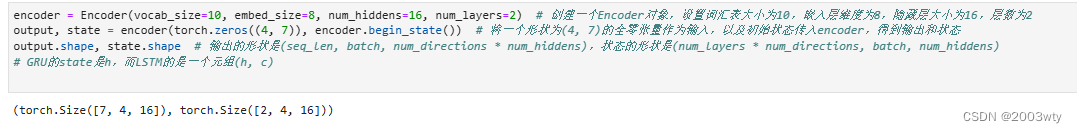

下面我们来创建一个批量大小为4、时间步数为7的小批量序列输入。设门控循环单元的隐藏层个数为2,隐藏单元个数为16。编码器对该输入执行前向计算后返回的输出形状为(时间步数, 批量大小, 隐藏单元个数)。门控循环单元在最终时间步的多层隐藏状态的形状为(隐藏层个数, 批量大小, 隐藏单元个数)。对于门控循环单元来说,state就是一个元素,即隐藏状态;如果使用长短期记忆,state是一个元组,包含两个元素即隐藏状态和记忆细胞。

2.2 注意力机制

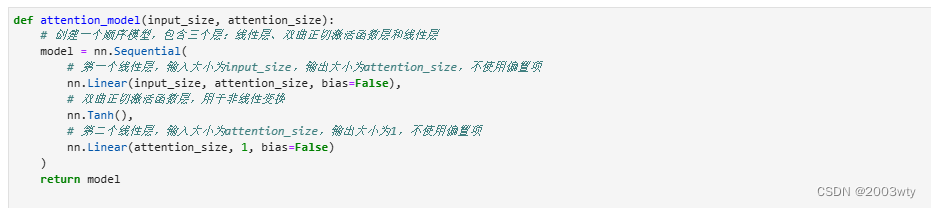

我们将实现10.11节(注意力机制)中定义的函数𝑎𝑎:将输入连结后通过含单隐藏层的多层感知机变换。其中隐藏层的输入是解码器的隐藏状态与编码器在所有时间步上隐藏状态的一一连结,且使用tanh函数作为激活函数。输出层的输出个数为1。两个Linear实例均不使用偏差。其中函数𝑎𝑎定义里向量𝑣𝑣的长度是一个超参数,即attention_size。

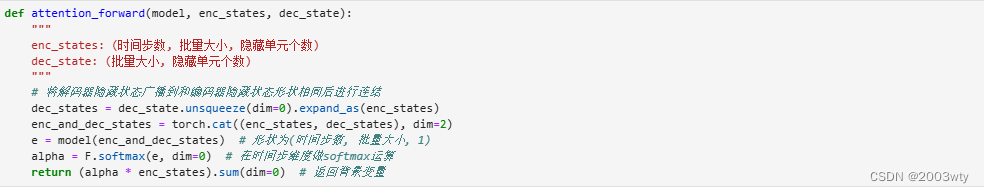

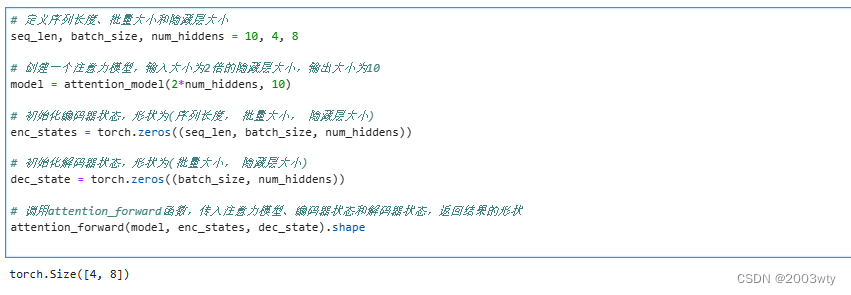

注意力机制的输入包括查询项、键项和值项。设编码器和解码器的隐藏单元个数相同。这里的查询项为解码器在上一时间步的隐藏状态,形状为(批量大小, 隐藏单元个数);键项和值项均为编码器在所有时间步的隐藏状态,形状为(时间步数, 批量大小, 隐藏单元个数)。注意力机制返回当前时间步的背景变量,形状为(批量大小, 隐藏单元个数)。

在下面的例子中,编码器的时间步数为10,批量大小为4,编码器和解码器的隐藏单元个数均为8。注意力机制返回一个小批量的背景向量,每个背景向量的长度等于编码器的隐藏单元个数。因此输出的形状为(4, 8)。

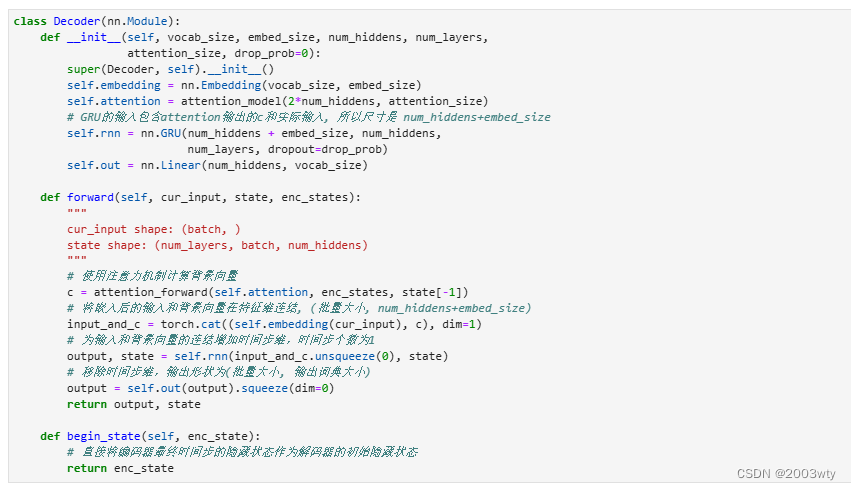

2.3 含注意力机制的解码器

我们直接将编码器在最终时间步的隐藏状态作为解码器的初始隐藏状态。这要求编码器和解码器的循环神经网络使用相同的隐藏层个数和隐藏单元个数。

在解码器的前向计算中,我们先通过刚刚介绍的注意力机制计算得到当前时间步的背景向量。由于解码器的输入来自输出语言的词索引,我们将输入通过词嵌入层得到表征,然后和背景向量在特征维连结。我们将连结后的结果与上一时间步的隐藏状态通过门控循环单元计算出当前时间步的输出与隐藏状态。最后,我们将输出通过全连接层变换为有关各个输出词的预测,形状为(批量大小, 输出词典大小)。

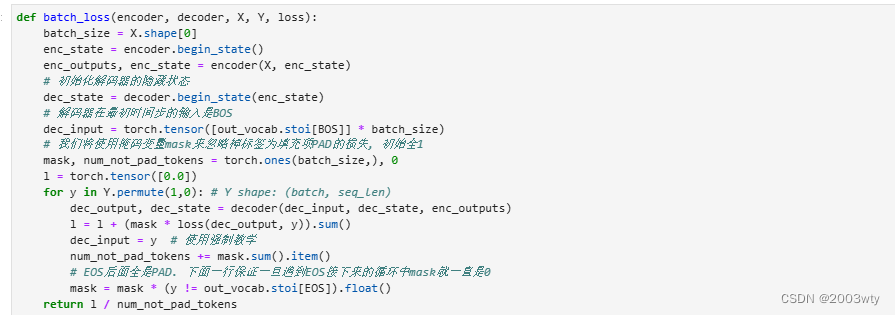

3,训练模型

我们先实现batch_loss函数计算一个小批量的损失。解码器在最初时间步的输入是特殊字符BOS。之后,解码器在某时间步的输入为样本输出序列在上一时间步的词,即强制教学。此外,同10.3节(word2vec的实现)中的实现一样,我们在这里也使用掩码变量避免填充项对损失函数计算的影响。

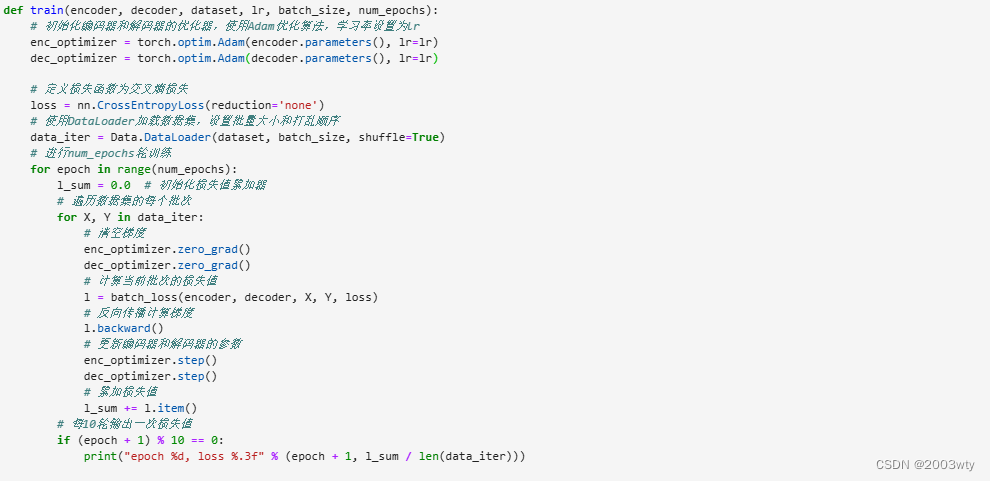

在训练函数中,我们需要同时迭代编码器和解码器的模型参数。

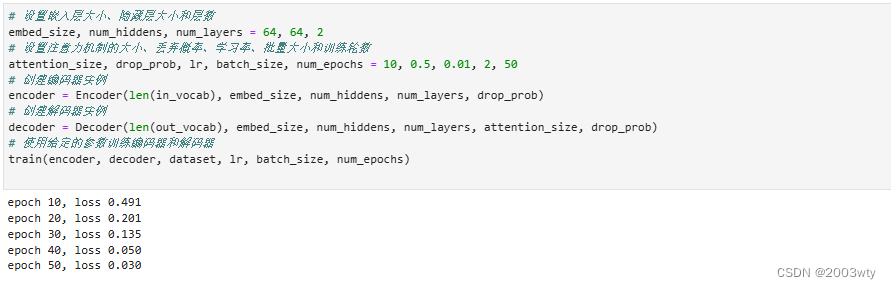

接下来,创建模型实例并设置超参数。然后,我们就可以训练模型了。

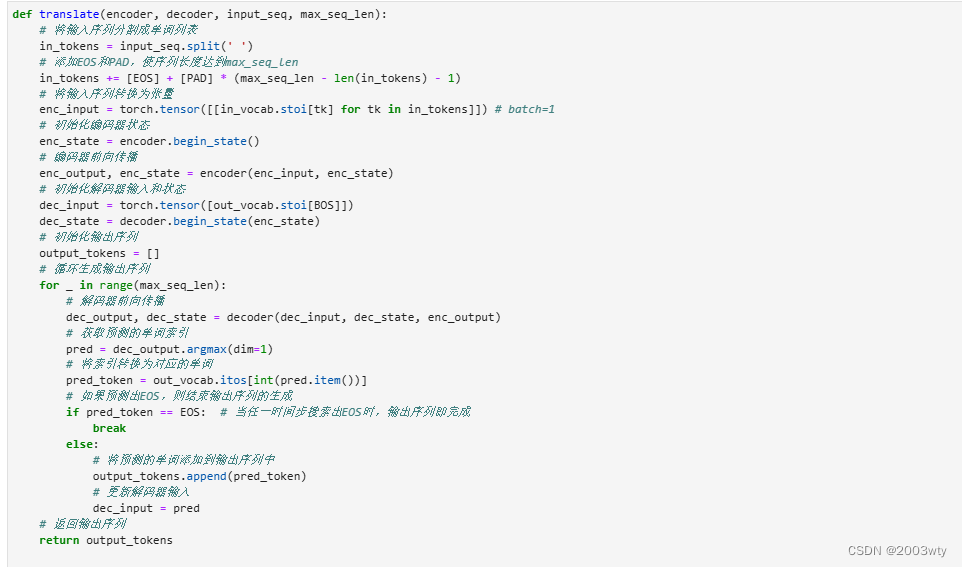

4,预测不定长的序列

在10.10节(束搜索)中我们介绍了3种方法来生成解码器在每个时间步的输出。这里我们实现最简单的贪婪搜索。

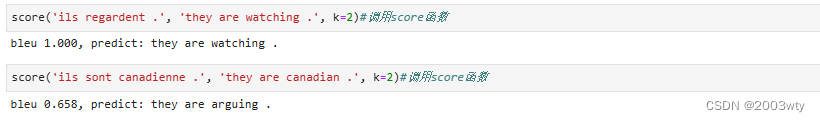

简单测试一下模型。输入法语句子“ils regardent.”,翻译后的英语句子应该是“they are watching.”。

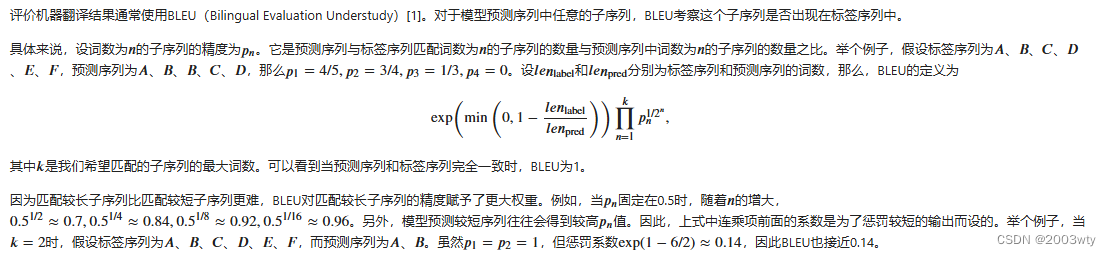

5,评价翻译结果

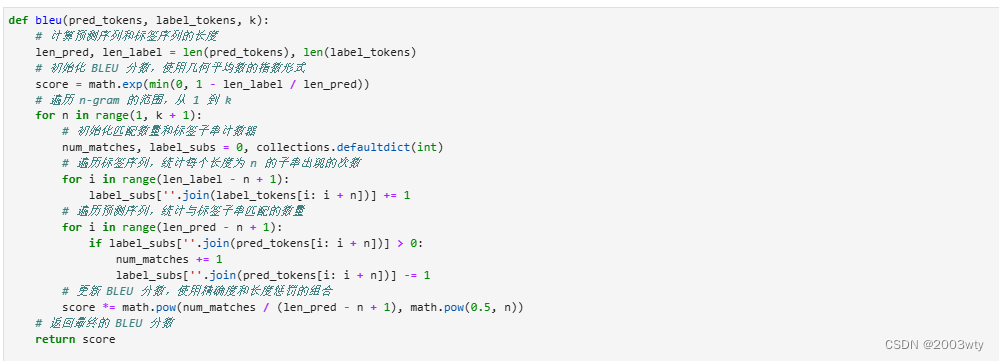

下面来实现BLEU的计算。

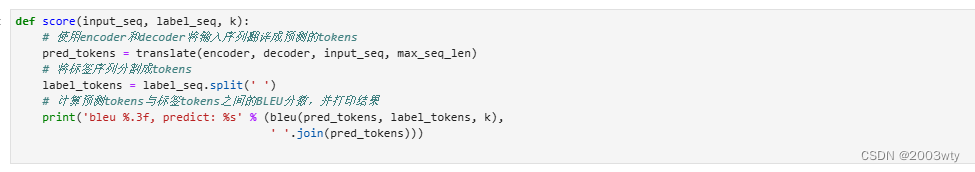

接下来,定义一个辅助打印函数

预测正确则分数为1。

四,实验总结

本次实验展示了基于神经网络的机器翻译方法的有效性,并为我们进一步优化和应用该方法提供了有益的经验和启示。机器翻译技术已取得显著进展,特别是神经网络机器翻译在质量上有着明显优势。然而,每种技术都有其适用范围和限制,如资源需求、模型训练时间和翻译效率等。未来的研究可关注于模型的优化、多语言翻译以及低资源语言的翻译技术。

1581

1581

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?