搭建伪分布式

一.安装 JAVA 环境

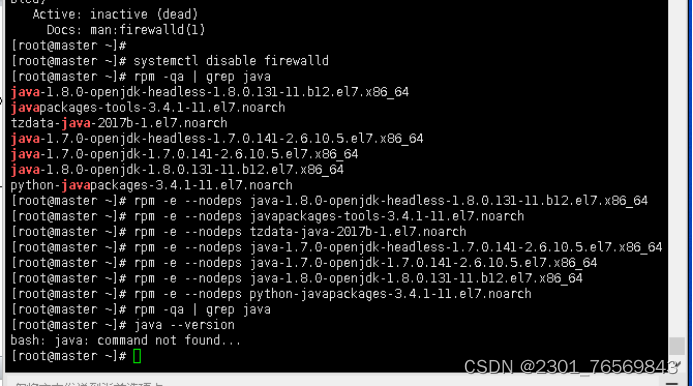

1.卸载自带 OpenJDK

[root@master ~]# rpm -qa | grep java

[root@master ~]# rpm -e --nodeps java-1.8.0-openjdk-headless-1.8.0.131-11.b12.el7.x86_64

[root@master ~]# rpm -e --nodeps javapackages-tools-3.4.1-11.el7.noarch

[root@master ~]# rpm -e --nodeps tzdata-java-2017b-1.el7.noarch

[root@master ~]# rpm -e --nodeps java-1.7.0-openjdk-headless-1.7.0.141-2.6.10.5.el7.x86_64[root@master ~]# rpm -e --nodeps java-1.7.0-openjdk-1.7.0.141-2.6.10.5.el7.x86_64

[root@master ~]# rpm -e --nodeps java-1.8.0-openjdk-1.8.0.131-11.b12.el7.x86_64

[root@master ~]# rpm -e --nodeps python-javapackages-3.4.1-11.el7.noarch

[root@master ~]# rpm -qa | grep java

[root@master ~]# java --version

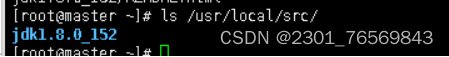

2.下载JDK安装包,将安装包解压到/usr/local/src目录下

[root@master ~]# tar -zxvf /opt/software/jdk-8u152-linux-x64.tar.gz -C/usr/local/src/

[root@master ~]# ls /usr/local/src/

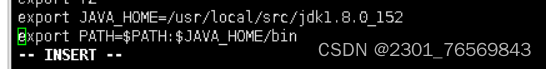

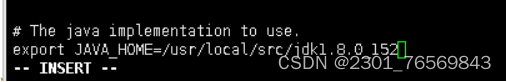

3. 设置 JAVA 环境变量

[root@master ~]# vi /etc/profile

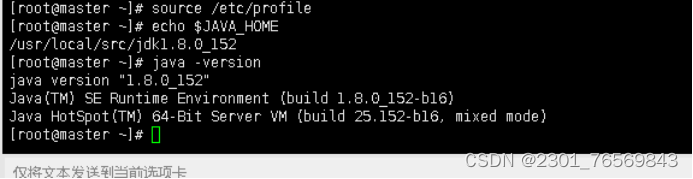

4. 执行 source 使设置生效并检查JAVA是否可用

[root@master ~]# source /etc/profile

[root@master ~]# echo $JAVA_HOME

[root@master ~]# java -version

二.实现免密登录

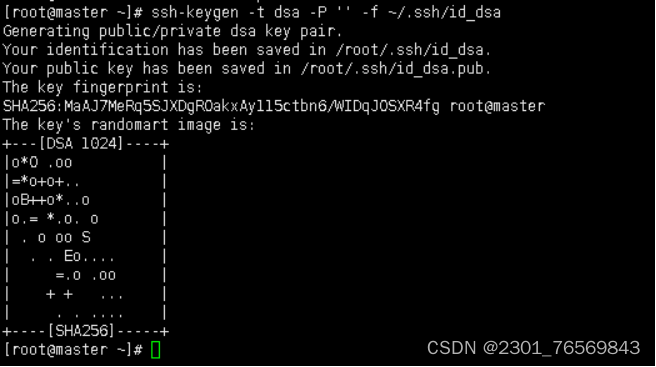

1.创建ssh秘钥,输入如下命令,生成公私密钥

[root@master ~]# ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

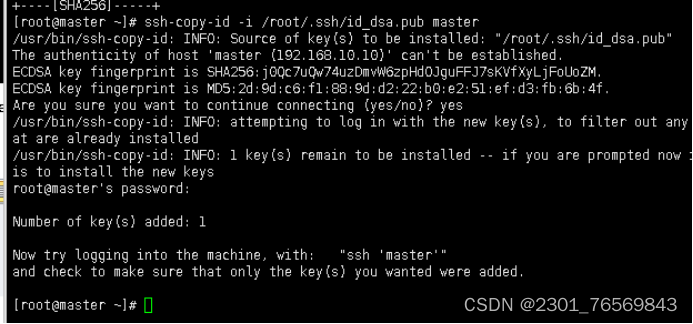

2. 将master公钥id_dsa复制到master进行公钥认证,实现本机免密登陆,测试完exit退出

[root@master ~]# ssh-copy-id -i /root/.ssh/id_dsa.pub master

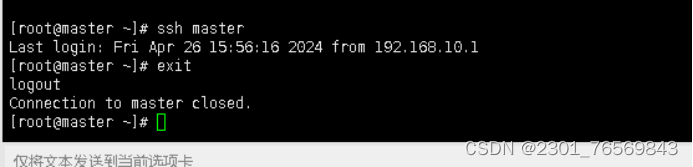

[root@master ~]# ssh master

[root@master ~]# exit

三.Hadoop环境的安装与配置

1. 修改环境变量

[root@master ~]# vim /etc/profile

[root@master ~]# source /etc/profile

2. 配置 Hadoop 配置文件,修改配置文件为jdk的安装路径

[root@master ~]# cd /usr/local/src/hadoop-2.7.1/

[root@master hadoop-2.7.1]# vi etc/hadoop/hadoop-env.sh

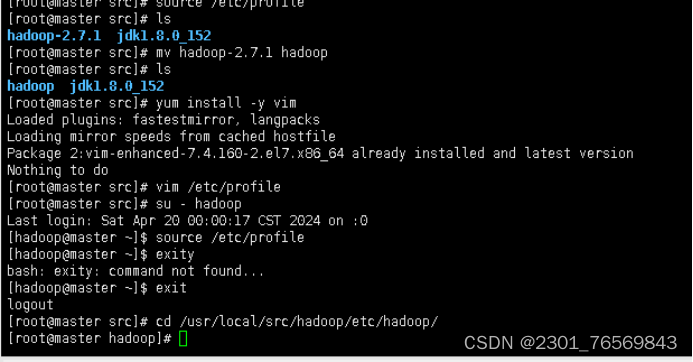

3.将 hadoop-2.7.1 文件夹重命名为 Hadoop

[root@master ~]# cd /use/local/src/

[root@master src]# mv hadoop-2.7.1 hadoop

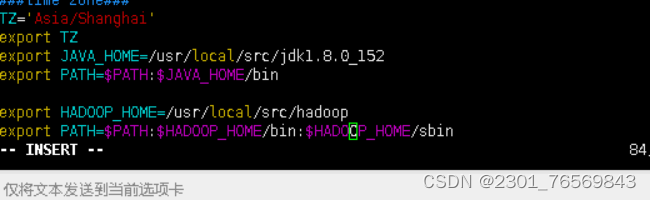

4.配置 Hadoop 环境变量

[root@master src]# yum install -y vim

[root@master src]# vim /etc/profile

5.使配置的Hadoop环境变量生效

[root@master src]# su - hadoop

[hadoop@master ~]$ source /etc/profile

[hadoop@master ~]$ exit

[root@master src]# cd /usr/local/src/hadoop/etc/hadoop/

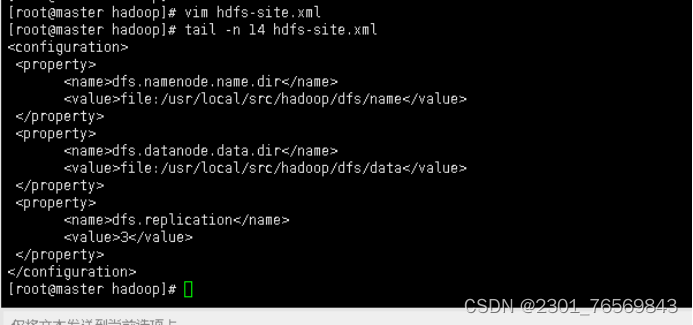

6.配置hdfs-site.xml文件参数

[root@master hadoop]# vim hdfs-site.xml

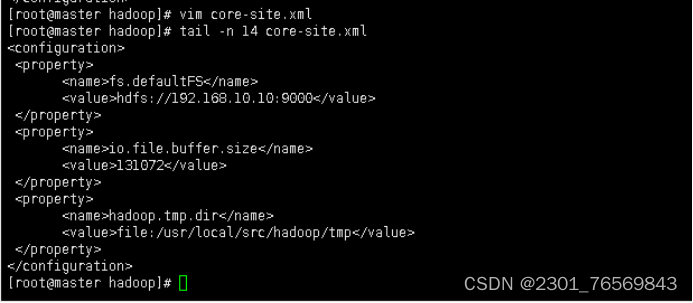

7.配置core-site.xml参数

[root@master hadoop]# vim core-site.xml

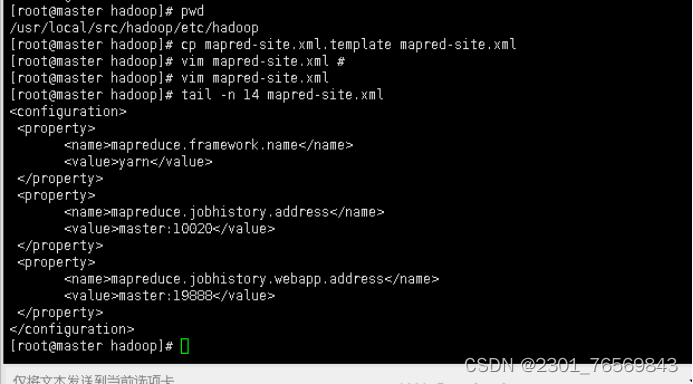

8.配置mapred-site.xml参数

[root@master hadoop]# pwd

[root@master hadoop]# cp mapred-site.xml.template mapred-site.xml

[root@master hadoop]# vim mapred-site.xml

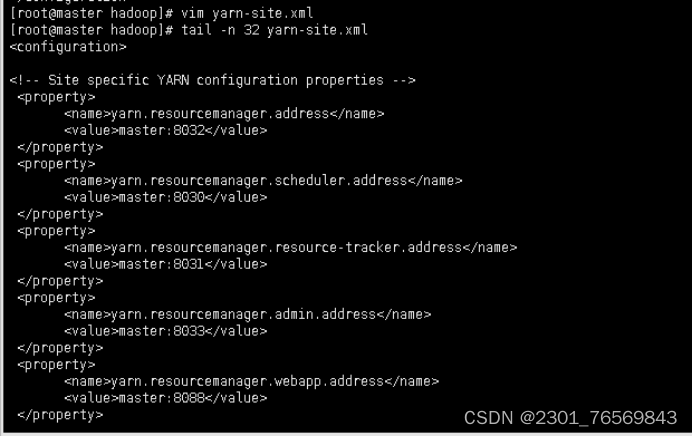

9.配置yarn-site.xml参数

[root@master hadoop]# vim yarn-site.xml

四.Hadoop其他相关配置

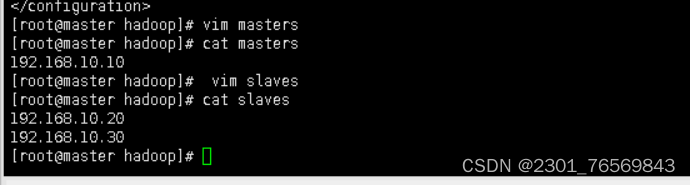

1.配置masters和slaves文件

[root@master hadoop]# vim masters

[root@master hadoop]# vim slaves

2.新建目录

[root@master hadoop]# mkdir /usr/local/src/hadoop/tmp

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/name -p

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/data -p

3.修改目录权限

[root@master hadoop]# chown -R hadoop:hadoop /usr/local/src/hadoop/

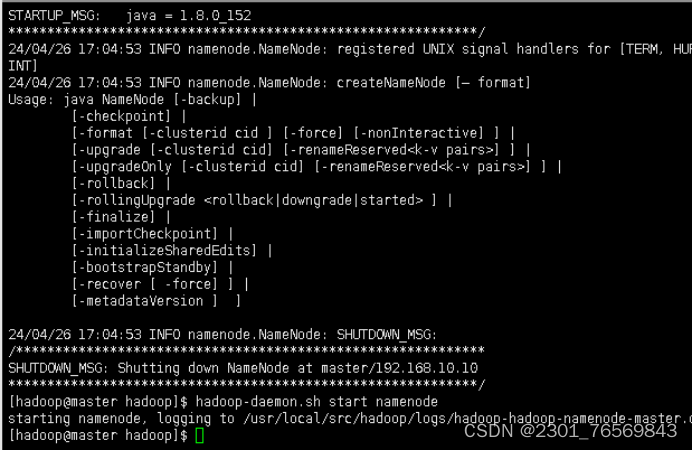

4.配置Hadoop格式化

[root@master ~]# su – hadoop

[hadoop@master ~]# cd /usr/local/src/hadoop/

[hadoop@master hadoop]$ bin/hdfs namenode –format

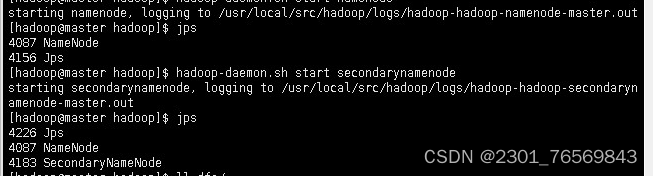

[hadoop@master hadoop]$ hadoop-daemon.sh start namenode

5.查看Java进程

[hadoop@master hadoop]$ jps

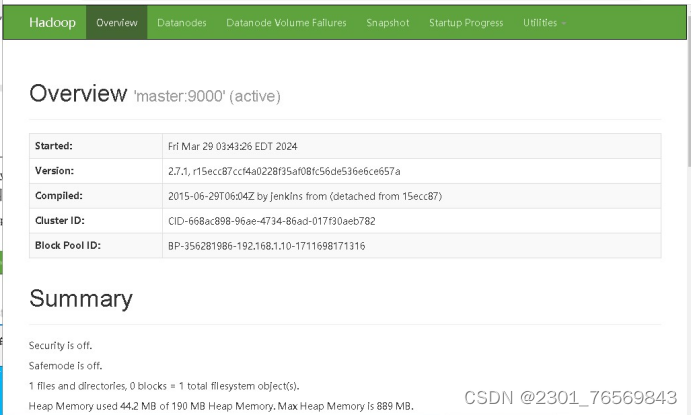

6.浏览器输入http://192.168.10.10:50070,查看NameNode和DataNode信息

五.Scala部署安装步骤

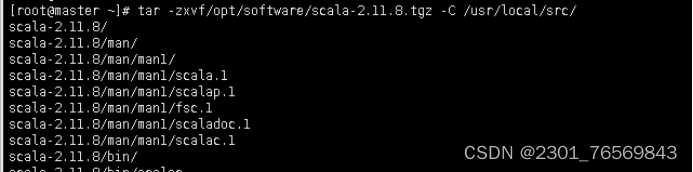

1.上传并解压安装scala安装包

[root@master ~]# tar -zxvf/opt/software/scala-2.11.8.tgz -C /usr/local/src/

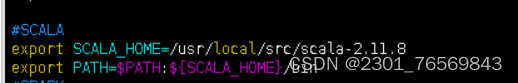

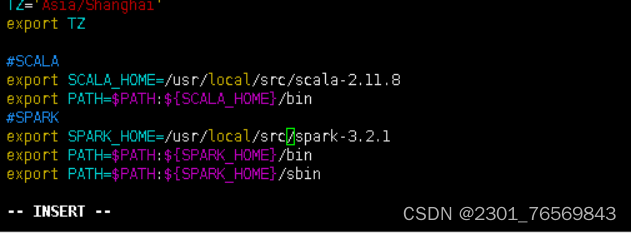

2.设置环境变量

[root@master ~]# vim /etc/profile

#SCALA

export SCALA_HOME=/usr/local/src/scala-2.11.8

export PATH=$PATH:${SCALA_HOME}/bin

3. 使环境变量生效

[root@master ~]# source /etc/profile

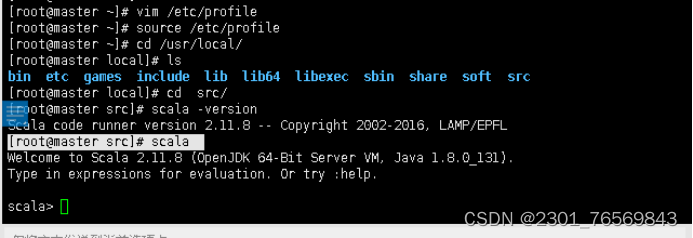

4. 验证scala 启动成功

[root@master ~]# cd /usr/local/src/

[root@master src]# scala -version

[root@master src]# scala scala启动成功

六.spark部署与安装

1.上传并解压安装spark安装包

[root@master ~]# tar -zxvf/opt/software/spark-3.2.1-bin-hadoop2.7.tgz -C /usr/local/src/

2.设置环境变量

[root@master ~]# vim /etc/profile

3.使环境变量生效

[root@master ~]# source /etc/profile

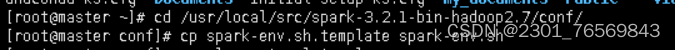

4.修改配置文件

[root@master ~]# cd /usr/local/src/spark-3.2.1-bin-hadoop2.7/conf/

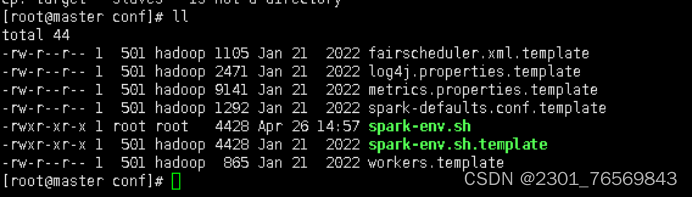

5.先备份文件cp spark env.sh.template spark env.sh

[root@master conf]# ll

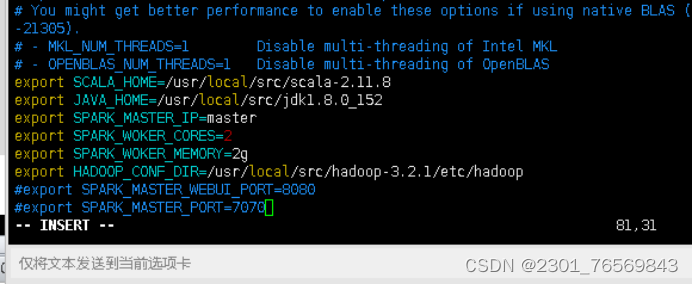

6. 修改spark- env.sh文件

[root@master conf]# vim spark-env.sh

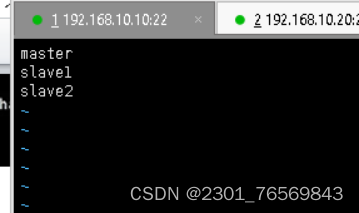

7.修改从节点IP

[root@master conf]# vi slaves

8.分发文件

scp -r /usr/local/src/spark-3.2.1/ slave1:/usr/local/src/

scp -r /usr/local/src/spark-3.2.1/ slave2:/usr/local/src/

9.使环境变量生效

[root@master ~]# source /etc/profile

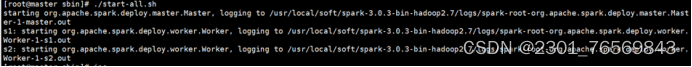

10.启动集群:spark目录下

[root@master sbin]# ./start-all.sh

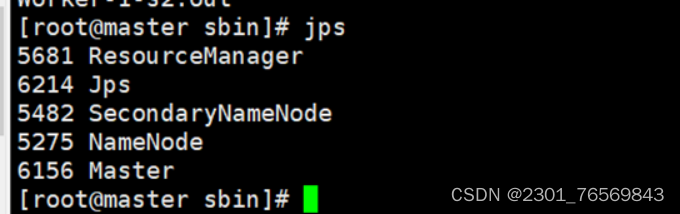

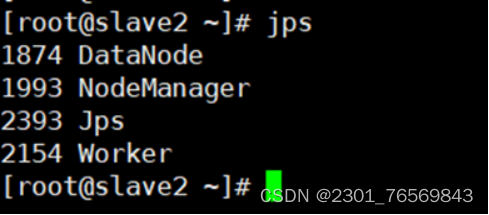

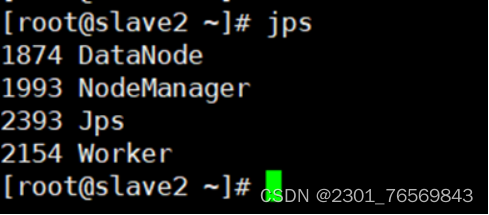

11.查看三个节点

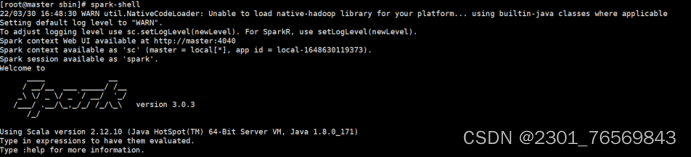

12.Spark-shell

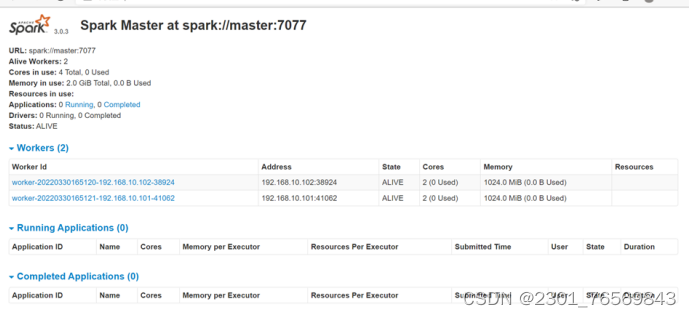

13.浏览器查看http://192.168.10.10:8080

237

237

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?