连接:写文章-CSDN创作中心

引言:在当今信息爆炸的时代,如何从海量的网络数据中获取有价值的信息成为了一个值得探讨的话题。爬虫技术作为网络数据获取的重要手段之一,越来越受到人们的关注。本文将从爬虫技术的基础概念出发,逐步深入探索爬虫的工作原理、关键技术、应用场景以及实战案例,帮助读者全面了解并掌握爬虫技术。

目录

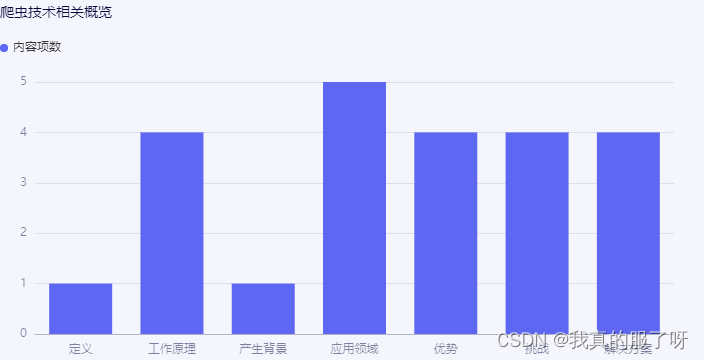

一、爬虫技术概述

- 爬虫定义:网络爬虫(Web Crawler)是一种自动获取网页内容并按照一定规则提取数据的程序。

- 爬虫分类:根据使用场景和目的,爬虫可分为通用爬虫、聚焦爬虫和增量式爬虫等。

- 爬虫工作原理:爬虫通过模拟浏览器行为,向目标网站发送请求,获取网页内容后进行解析,提取所需数据。

二、爬虫关键技术及案例

- 请求库:如Python中的requests库,用于发送HTTP请求。

import requests # 发送 GET 请求 response = requests.get('http://example.com') # 检查请求是否成功 if response.status_code == 200: # 处理响应内容 print(response.text) else: # 处理请求失败的情况 print(f'请求失败,状态码: {response.status_code}')上述示例中使用

requests.get()方法发送一个 GET 请求到指定的 URL。然后通过检查响应的状态码来确定请求是否成功。如果状态码为 200,表示请求成功,可以使用response.text获取响应的文本内容。- 解析库:如BeautifulSoup、lxml等,用于解析HTML或XML文档,提取数据。

from bs4 import BeautifulSoup import requests # 发送 GET 请求获取 HTML 内容 response = requests.get('http://example.com') # 解析 HTML 内容 soup = BeautifulSoup(response.text, 'html.parser') # 提取标题 title = soup.title.string # 提取所有链接 links = [link.get('href') for link in soup.find_all('a')] # 打印结果 print(f'标题: {title}') print(f'链接: {links}')from lxml import html import requests # 发送 GET 请求获取 HTML 内容 response = requests.get('http://example.com') # 解析 HTML 内容 tree = html.fromstring(response.text) # 提取标题 title = tree.xpath('//title/text()')[0] # 提取所有链接 links = tree.xpath('//a/@href') # 打印结果 print(f'标题: {title}') print(f'链接: {links}')上述实例中使用 requests 库发送 GET 请求获取指定 URL 的 HTML 内容。然后使用 BeautifulSoup 或 lxml 库解析 HTML 内容。

使用 BeautifulSoup,我们可以通过访问 HTML 标签的属性来提取数据,例如通过

soup.title.string提取标题,通过soup.find_all('a')找到所有的链接,并使用列表推导式提取链接的href属性。使用 lxml,我们可以使用 XPath 表达式来定位和提取数据,例如通过

//title/text()提取标题,通过//a/@href提取所有链接的href属性。- 代理与反反爬:使用代理IP绕过目标网站的反爬策略,同时采用反反爬技术提高爬虫稳定性。

- 异步与并发:使用异步IO、多线程、多进程等技术提高爬虫性能。

import asyncio import aiohttp # 异步函数,发送 HTTP 请求并获取响应 async def fetch(url): async with aiohttp.ClientSession() as session: async with session.get(url) as response: return await response.text() # 创建任务列表 urls = ['http://example.com', 'http://example.net', 'http://example.org'] tasks = [fetch(url) for url in urls] # 运行异步任务 loop = asyncio.get_event_loop() results = loop.run_until_complete(asyncio.gather(*tasks)) # 打印结果 for result in results: print(result)import threading import requests # 线程函数,发送 HTTP 请求并获取响应 def thread_function(url): response = requests.get(url) print(response.text) # 创建线程列表 urls = ['http://example.com', 'http://example.net', 'http://example.org'] threads = [threading.Thread(target=thread_function, args=(url,)) for url in urls] # 启动线程 for thread in threads: thread.start() # 等待所有线程完成 for thread in threads: thread.join()import multiprocessing import requests # 进程函数,发送 HTTP 请求并获取响应 def process_function(url): response = requests.get(url) print(response.text) # 创建进程列表 urls = ['http://example.com', 'http://example.net', 'http://example.org'] processes = [multiprocessing.Process(target=process_function, args=(url,)) for url in urls] # 启动进程 for process in processes: process.start() # 等待所有进程完成 for process in processes: process.join()上面的示例代码展示了如何使用异步 IO、多线程和多进程来并发地发送 HTTP 请求并获取响应,从而提高爬虫的性能。在实际应用中,需要根据具体情况选择合适的技术,并处理好并发带来的资源竞争和数据一致性等问题。

- 数据存储:将爬取的数据存储到数据库、文件或云存储中,方便后续处理和分析

#将爬取的数据存储到数据库中:

import pymysql

# 连接数据库

conn = pymysql.connect(host='localhost', user='root', password='your_password', database='your_database', charset='utf8')

cursor = conn.cursor()

# 插入数据

sql = "INSERT INTO your_table (column1, column2) VALUES (%s, %s)"

data = ('value1', 'value2')

cursor.execute(sql, data)

conn.commit()

# 关闭连接

cursor.close()

conn.close()

#将爬取的数据存储到文件中:

with open('output.txt', 'a', encoding='utf-8') as f:

f.write('需要保存的数据内容' + '

')

#将爬取的数据存储到云存储(如阿里云OSS)中:

from oss2 import Auth, Bucket

# 认证信息

auth = Auth('your_access_key_id', 'your_access_key_secret')

bucket = Bucket(auth, 'your_endpoint', 'your_bucket_name')

# 上传文件

with open('local_file_path', 'rb') as fileobj:

bucket.put_object('remote_file_path', fileobj)

三·、爬虫应用场景

- 数据挖掘与分析:爬取互联网上的各类数据,如电商价格、用户评论等,进行数据挖掘和分·析。

- 搜索引擎优化(SEO):通过爬虫分析竞争对手的网站结构、关键词布局等信息,优化自身网站的SEO效果。

- 舆情监控:爬取社交媒体、新闻网站等平台上的信息,进行舆情监控和分析。

- 自动化测试:使用爬虫模拟用户行为,对网站进行自动化测试,提高测试效率。

四、实战案例

- 爬取某电商网站商品信息:通过requests库发送请求,使用BeautifulSoup解析HTML文档,提取商品名称、价格、评价等信息,并存储到数据库中。

import requests from bs4 import BeautifulSoup import sqlite3 # 创建数据库连接 conn = sqlite3.connect('products.db') cursor = conn.cursor() # 创建数据表 cursor.execute(''' CREATE TABLE IF NOT EXISTS products ( id INTEGER PRIMARY KEY AUTOINCREMENT, name TEXT, price REAL, rating REAL ) ''') # 发送请求 url = 'https://www.example.com/products' # 将此URL替换为实际的电商网站URL response = requests.get(url) html_content = response.text # 解析HTML文档 soup = BeautifulSoup(html_content, 'html.parser') # 提取商品信息 products = soup.find_all('div', class_='product') # 根据实际的HTML结构修改此行 for product in products: name = product.find('h2', class_='name').text # 根据实际的HTML结构修改此行 price = float(product.find('span', class_='price').text) # 根据实际的HTML结构修改此行 rating = float(product.find('span', class_='rating').text) # 根据实际的HTML结构修改此行 # 存储到数据库中 cursor.execute("INSERT INTO products (name, price, rating) VALUES (?, ?, ?)", (name, price, rating)) # 提交事务并关闭连接 conn.commit() cursor.close() conn.close()- 爬取某社交媒体用户信息:通过模拟登录,获取用户Token,然后爬取用户发布的帖子、评论等信息,进行舆情分析。

import requests

from bs4 import BeautifulSoup

# 模拟登录并获取Token

def get_token(username, password):

login_url = 'https://www.example.com/login' # 将此URL替换为实际的社交媒体登录URL

data = {

'username': username,

'password': password

}

response = requests.post(login_url, data=data)

token = response.json().get('token')

return token

# 爬取用户发布的帖子和评论

def crawl_user_info(token, user_id):

posts_url = f'https://www.example.com/users/{user_id}/posts' # 将此URL替换为实际的社交媒体用户帖子URL

headers = {'Authorization': f'Bearer {token}'}

response = requests.get(posts_url, headers=headers)

posts = response.json()

comments_url = f'https://www.example.com/users/{user_id}/comments' # 将此URL替换为实际的社交媒体用户评论URL

response = requests.get(comments_url, headers=headers)

comments = response.json()

return posts, comments

# 舆情分析

def analyze_public_opinion(posts, comments):

# 在这里编写舆情分析的代码

pass

if __name__ == '__main__':

username = 'your_username'

password = 'your_password'

user_id = 'target_user_id'

token = get_token(username, password)

posts, comments = crawl_user_info(token, user_id)

analyze_public_opinion(posts, comments)

五、总结与展望

爬虫技术作为网络数据获取的重要手段之一,具有广泛的应用前景。本文从爬虫技术的基础概念出发,深入探讨了爬虫的工作原理、关键技术、应用场景以及实战案例。通过学习和实践爬虫技术,我们可以轻松地从海量的网络数据中获取有价值的信息,为数据挖掘、舆情监控等领域提供有力支持。未来,随着人工智能、大数据等技术的不断发展,爬虫技术将迎来更加广阔的应用空间。

516

516

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?