Spark中,文本文件的读取和存储

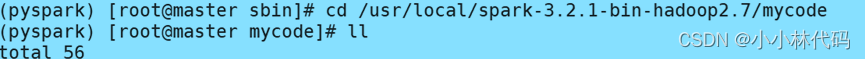

第一步:进入到你要读取文件的路径目录下,查看是否有你要读取保存的文件

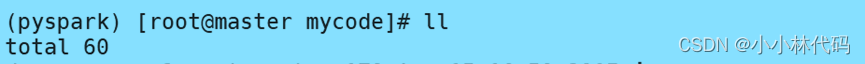

第二步:查询后发现没有你要读取的文件,就上传将要读取的文件,上传后再次查看是否有文件

上传文件,命令,rz

查看文件,命令,ll或ls

![]()

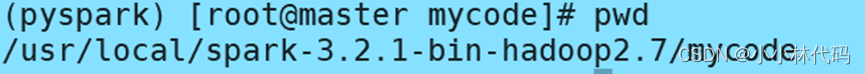

第三步:打印当前所在路径的地址,命令,pwd

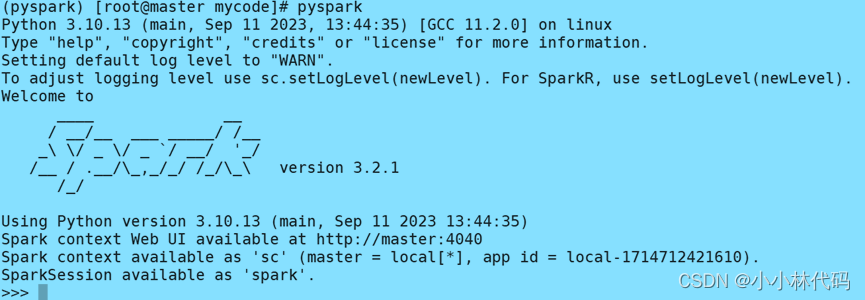

第四步:进入pyspark交互式环境,命令,pyspark

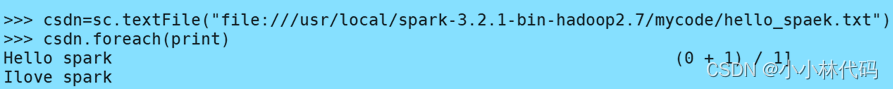

第五步:读取本地文件hello_spaek.txt创建名为csdn的RDD

第六步:输出RDD元素

命令,结果如下图所示

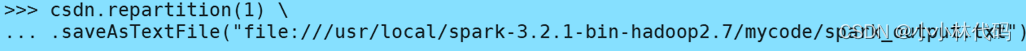

第七步:设置分区为1,并将读取的RDD保存为文本文件,保存文本文件地址可以自己选定

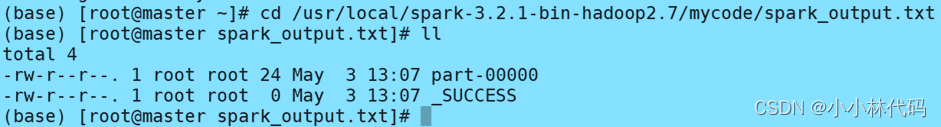

第八步:重新打开个终端查看是否保存成功,如果出现_SUCCESS文件则说明保存成功

进入保存文本文件的文件下,使用ll命令查看

命令,结果如下图所示

本文详细介绍了如何在Spark环境中读取本地文件hello_spaek.txt,创建RDD,设置分区并将其保存为文本文件,最后验证保存成功的步骤。

本文详细介绍了如何在Spark环境中读取本地文件hello_spaek.txt,创建RDD,设置分区并将其保存为文本文件,最后验证保存成功的步骤。

4696

4696

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?