每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

为什么我们不需要GPT-5:AI的真正问题是速度

前段时间我写了一篇关于为什么我们不需要GPT-5的文章。原因?智能并不是AI的主要问题,主要问题是速度。

事实上,响应时间长的问题并不是新问题。这已经困扰了我所有的AI功能。我敢说,速度是AI面临的头号问题。不是基准测试,不是什么“HellaSwag”,而是速度。

最近我更加思考这个问题。AI如此显著进步的主要方式之一是所谓的“从人类反馈中进行强化学习”。基本上,你让人类评审员对AI的响应进行评分。通过这种方法,你可以调整AI,让它听起来多么聪明都行。至于幻觉、推理和数学,模型之间可能有所不同,但对大多数模型来说,这并不是一个大问题。

在那篇文章中,我建议与其专注于GPT-5,不如专注于GPT-4.5,就像GPT-3.5之于GPT-3:显著更小且更快。看起来他们可能正在这样做,有了GPT-4o。

OpenAI员工是不是为欢呼声的大小拿奖金?

Google又被超越了

GPT-4o于5月13日星期一宣布。而Google I/O则在5月14日星期二举行。我们已经知道那天将要发布的一件事:Gemini Pro的按需定价。

自从推出以来,Gemini Pro一直是免费的,但有限制。最显著的是每分钟只能发出几个请求。但看起来Google最终打算在5月2日开始对那些想做更多事情的人收费。然而,不知道什么原因,他们把这个日期推到了5月14日,与Google I/O同步。

他们不应该这样做,因为现在GPT-4o已经宣布。之所以重要,是因为Gemini 1.5 Pro似乎是瞄准了GPT-4 Turbo。它的成本是每百万输入令牌7美元,每百万输出令牌21美元。比GPT-4 Turbo的每百万输入令牌10美元和每百万输出令牌20美元略便宜。因此,尽管在某些基准测试中表现较差,Gemini 1.5 Pro可能仍是一个不错的替代品,主要是因为它有100万令牌的上下文窗口。

但现在GPT-4o甚至比GPT-4 Turbo更便宜,也比Gemini 1.5 Pro便宜。它的价格仅为每百万输入令牌5美元和每百万输出令牌10美元,比GPT-4 Turbo便宜一半。

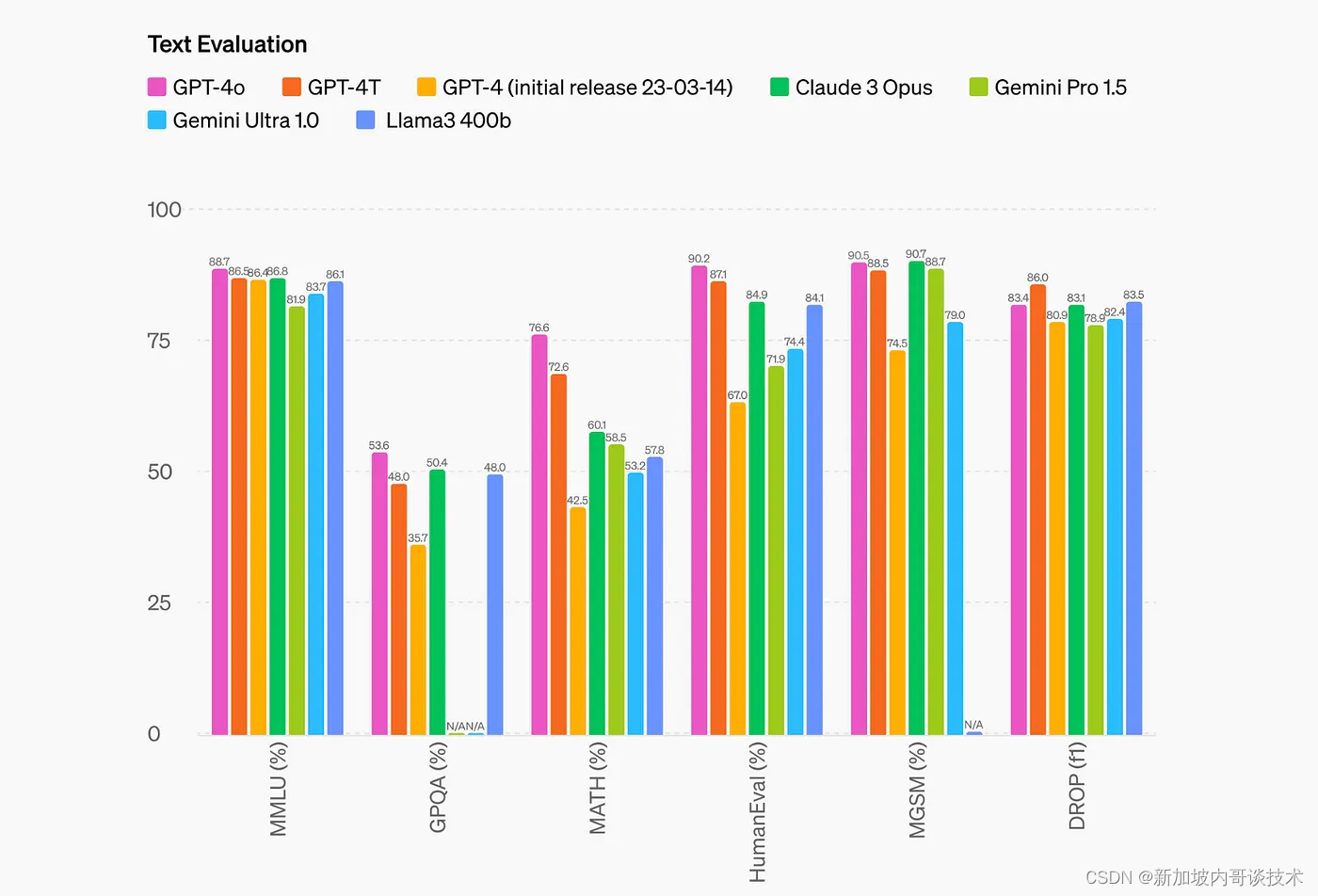

更重要的是,它在实现稍好性能的同时,还能做到这一点:

现在谁还会想用Gemini 1.5 Pro?想象一下,如果明天在Google I/O上突然宣布将Gemini 1.5 Pro的价格再减半,那将会怎样。然后所有的Google员工都会争相更新文档。

这也不是Gemini第一次被超越。Gemini 1.0 Pro最初定价应该和GPT-3.5 Turbo一样。然后GPT-3.5 Turbo降价,Google跟着调整价格。

最令人印象深刻的可能是Llama 3。虽然在所有方面都不是最好的,但对于一个4000亿参数的模型来说,它表现得相当不错。我之前不知道有4000亿参数的Llama 3。

这个图表清楚地显示,唯一接近的是Claude 3 Opus。我听说Claude 3 Opus非常不错。哦,它的上下文窗口是20万令牌,这使它与GPT-4o非常具有竞争力。

我们不知道GPT-4o的上下文窗口是多少。我找到了一篇XDA的文章,说:

在上下文窗口方面,GPT-4o的上下文窗口比GPT-4和GPT-3.5大得多。作为参考,GPT-4 Turbo的上下文窗口是128K令牌,最大响应令牌长度为4096。据早期报告,GPT-4o的输出令牌限制减半至2048,但OpenAI表示它的上下文窗口为128K令牌,截止日期为2023年10月。

但这听起来像是在假设GPT-4o将拥有与GPT-4 Turbo相似的上下文窗口。它可能是一样大或更大,但到底有多大?

考虑到这一点,也许128K的假设令牌已经足够。我用Gemini 1.5 Pro来总结YouTube视频,一小时长的视频可以轻松达到50,000个字符。所以你只需要50,000个输入令牌。

哦,一个输入令牌平均大约4个字符。但是这会根据文本的不同而改变。一个50,000字符长的YouTube转录可能不适合15,000个令牌。而历史上大多数令牌化算法对非英语文本的处理都相当糟糕。但看起来OpenAI正在努力改进这一点。

GPT-4o还改进了他们使用的令牌化算法。大多数基于拉丁文的语言(英语、法语、西班牙语等)将只看到1.1-1.2倍的改进。然而,一些语言将看到显著更好的改进,如中文(1.4倍)、韩文(1.7倍)和阿拉伯语(2.0倍)。这意味着API将变得更便宜,尤其是如果你使用非拉丁文的脚本语言。

事实上,现在它已经便宜到OpenAI似乎要向免费用户提供GPT-4o。

GPT-4o的文本和图像功能今天开始在ChatGPT中推出。我们将GPT-4o提供给免费用户,并为Plus用户提供多达5倍的消息限制。我们将在未来几周内在ChatGPT Plus中推出带有GPT-4o的Alpha版新语音模式。

最后,我想谈一下多模态,这就是“o”的意义所在。它代表“omni”。

当Google Gemini推出时,它是一个多模态模型,这是一个大新闻。这也是我喜欢Gemini网页应用的原因。你可以发送一张图片,它就能告诉你那是什么。

它还集成了一些Google服务,如YouTube和地图。我不确定OpenAI是否能做到这一点。另外,顺便说一下,Gemini的YouTube摘要比Stratum(iOS,Android)的YouTube摘要要差得多。仅供参考。

GPT-4o作为多模态是个大新闻。你也可以向GPT-4 Turbo发送图像,但我怀疑它的集成效果并不好。随着GPT-4o的推出,OpenAI开发了一个可以做所有事情的模型,并在这个方面做得很疯狂。

旗舰功能当然是语音交互。

OpenAI之前做过类似的事情。在ChatGPT应用程序中,有一个麦克风按钮,可以让你与AI对话。然而,它并不比手机自带的语音转文本功能好多少。看起来GPT-4o大大增强了这一点。它看起来不需要任何关键词或点击就能激活,你甚至可以在AI与你对话时打断它。

这让我想起了Google Gemini的最初演示。

你知道,那是伪造的。

此外,这出现在GPT-4o的页面上。

所有视频都以1倍的实时播放

这可能意味着什么?

总之,看起来OpenAI终于可以真实地做到这一点,这非常疯狂。这就是我所说的“AI已经达到顶峰”。这是原来的标题。现在是“AI军备竞赛结束了”。我只是认为没有太多动机去开发更大的AI了。

我一直在写很多关于当今的大型语言模型太大且不具经济可行性的内容。

如果你再看一遍那个性能图表,GPT-4o并不比GPT-4 Turbo好多少。实际上,它在一个测试中输给了GPT-4 Turbo。

这绝对不像从GPT-4到GPT-4 Turbo的提升那么显著。你可以说这是因为所有的多模态功能。也许吧。但我怀疑OpenAI已经承认,开发更大更强的模型意义不大。

当ChatGPT问世时,我们的下巴都掉了,因为它可以在几秒钟内写出整篇文章。但现在我们已经习惯了。那种魔力消失了。

GPT-4 Turbo已经足够好。AI的未来不在于智能,未来在于多模态。在智能基础上做更多事情。因此,GPT-4o更多的是对GPT-4 Turbo的改进。它试图重新捕捉我们第一次看到ChatGPT时的那种魔力。这可能会引领新一代的大型语言模型。一个更加关注用户体验而不是纯粹速度和性能的模型。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?