在Python中,可以使用各种库和工具对神经网络的分类和预测结果进行可视化展示。下面是一些常用的方法和工具:

- Matplotlib: Matplotlib是一个广泛使用的绘图库,可以用于绘制各种类型的图形,包括线图、散点图等。可以使用Matplotlib绘制分类结果的混淆矩阵、ROC曲线等。

示例代码:

import matplotlib.pyplot as plt

import numpy as np

# 绘制分类结果的混淆矩阵

def plot_confusion_matrix(cm, classes):

plt.imshow(cm, interpolation='nearest', cmap=plt.cm.Blues)

plt.title('Confusion matrix')

plt.colorbar()

tick_marks = np.arange(len(classes))

plt.xticks(tick_marks, classes, rotation=45)

plt.yticks(tick_marks, classes)

plt.tight_layout()

plt.ylabel('True label')

plt.xlabel('Predicted label')

# 绘制ROC曲线

def plot_roc_curve(fpr, tpr, roc_auc):

plt.figure()

plt.plot(fpr, tpr, color='darkorange', lw=2, label='ROC curve (area = %0.2f)' % roc_auc)

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

2. Seaborn: Seaborn是一个基于matplotlib的数据可视化库,提供了一些简单易用的统计图表,可以用于绘制分类结果的柱状图、箱线图等。

示例代码:

import seaborn as sns

# 绘制分类结果的柱状图

def plot_bar_chart(labels, values):

sns.barplot(x=labels, y=values)

plt.title('Bar Chart')

plt.xlabel('Labels')

plt.ylabel('Values')

plt.show()

# 绘制分类结果的箱线图

def plot_boxplot(data):

sns.boxplot(data=data)

plt.title('Box Plot')

plt.xlabel('Labels')

plt.ylabel('Values')

plt.show()

3. TensorBoard: TensorBoard是TensorFlow的可视化工具,可以用于展示训练过程中的各种指标、损失函数曲线、计算图等。可以使用TensorBoard展示神经网络的分类和预测结果。

示例代码:

from tensorflow.keras.callbacks import TensorBoard

# 创建TensorBoard回调函数

tensorboard_callback = TensorBoard(log_dir=log_dir, histogram_freq=1, write_graph=True, write_images=True)

# 使用TensorBoard回调函数训练模型

model.fit(X_train, y_train, callbacks=[tensorboard_callback])

这些是常见的在Python中对神经网络分类和预测结果进行可视化展示的方法和工具。根据具体需求,可以选择适合的方法进行展示。

为了对神经网络分类和预测的结果进行可视化展示,我们可以使用`Matplotlib`和`Seaborn`等库。以下是一个完整的示例,展示如何训练一个简单的神经网络分类模型,并对其结果进行可视化,包括训练过程的损失和准确率曲线、混淆矩阵以及ROC曲线等。

###示例代码

```python

importnumpyasnp

importpandasaspd

importmatplotlib.pyplotasplt

importseabornassns

fromsklearn.datasetsimportmake_classification

fromsklearn.model_selectionimporttrain_test_split

fromsklearn.preprocessingimportLabelBinarizer,StandardScaler

fromsklearn.metricsimportconfusion_matrix,roc_curve,auc,roc_auc_score

fromkeras.modelsimportSequential

fromkeras.layersimportDense

fromkeras.optimizersimportAdam

#生成模拟数据集

X,y=make_classification(n_samples=1000,n_features=20,n_informative=2,n_redundant=2,random_state=42)

#数据标准化

scaler=StandardScaler()

X=scaler.fit_transform(X)

#标签二值化

lb=LabelBinarizer()

y=lb.fit_transform(y)

#分割数据集

X_train,X_test,y_train,y_test=train_test_split(X,y,test_size=0.2,random_state=42)

#构建神经网络模型

model=Sequential()

model.add(Dense(64,input_dim=X_train.shape[1],activation='relu'))

model.add(Dense(32,activation='relu'))

model.add(Dense(1,activation='sigmoid'))

#编译模型

model.compile(loss='binary_crossentropy',optimizer=Adam(learning_rate=0.001),metrics=['accuracy'])

#训练模型

history=model.fit(X_train,y_train,epochs=100,batch_size=32,validation_split=0.1,verbose=2)

#评估模型

loss,accuracy=model.evaluate(X_test,y_test)

print(f'TestLoss:{loss}')

print(f'TestAccuracy:{accuracy}')

#预测概率

y_pred_prob=model.predict(X_test).ravel()

#预测类别

y_pred=(y_pred_prob>0.5).astype(int)

#可视化训练过程的损失和准确率

defplot_training_history(history):

plt.figure(figsize=(12,5))

#损失

plt.subplot(1,2,1)

plt.plot(history.history['loss'],label='TrainLoss')

plt.plot(history.history['val_loss'],label='ValidationLoss')

plt.title('TrainingandValidationLoss')

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend()

#准确率

plt.subplot(1,2,2)

plt.plot(history.history['accuracy'],label='TrainAccuracy')

plt.plot(history.history['val_accuracy'],label='ValidationAccuracy')

plt.title('TrainingandValidationAccuracy')

plt.xlabel('Epochs')

plt.ylabel('Accuracy')

plt.legend()

plt.tight_layout()

plt.show()

plot_training_history(history)

#混淆矩阵

defplot_confusion_matrix(y_test,y_pred):

cm=confusion_matrix(y_test,y_pred)

plt.figure(figsize=(8,6))

sns.heatmap(cm,annot=True,fmt='d',cmap='Blues',xticklabels=['Class0','Class1'],yticklabels=['Class0','Class1'])

plt.title('ConfusionMatrix')

plt.xlabel('Predicted')

plt.ylabel('True')

plt.show()

plot_confusion_matrix(y_test,y_pred)

#ROC曲线

defplot_roc_curve(y_test,y_pred_prob):

fpr,tpr,thresholds=roc_curve(y_test,y_pred_prob)

roc_auc=auc(fpr,tpr)

plt.figure(figsize=(8,6))

plt.plot(fpr,tpr,color='darkorange',lw=2,label='ROCcurve(area=%0.2f)'%roc_auc)

plt.plot([0,1],[0,1],color='navy',lw=2,linestyle='--')

plt.xlim([0.0,1.0])

plt.ylim([0.0,1.05])

plt.xlabel('FalsePositiveRate')

plt.ylabel('TruePositiveRate')

plt.title('ReceiverOperatingCharacteristic(ROC)Curve')

plt.legend(loc="lowerright")

plt.show()

plot_roc_curve(y_test,y_pred_prob)

#AUC分数

auc_score=roc_auc_score(y_test,y_pred_prob)

print(f'AUCScore:{auc_score}')

```

###代码说明

1.**数据生成和预处理**:

-使用`make_classification`生成模拟分类数据集。

-对特征数据进行标准化处理。

-对标签进行二值化处理。

2.**模型构建和训练**:

-构建一个简单的神经网络模型,包含输入层、隐藏层和输出层。

-编译模型,指定损失函数和优化器。

-训练模型,并记录训练历史。

3.**可视化训练过程**:

-绘制训练过程中的损失和准确率曲线。

4.**混淆矩阵**:

-计算并绘制混淆矩阵,以可视化分类结果的正确和错误情况。

5.**ROC曲线**:

-计算并绘制ROC曲线,以评估模型的分类性能。

6.**AUC分数**:

-计算并打印AUC分数,作为模型性能的另一个评估指标。

###运行结果

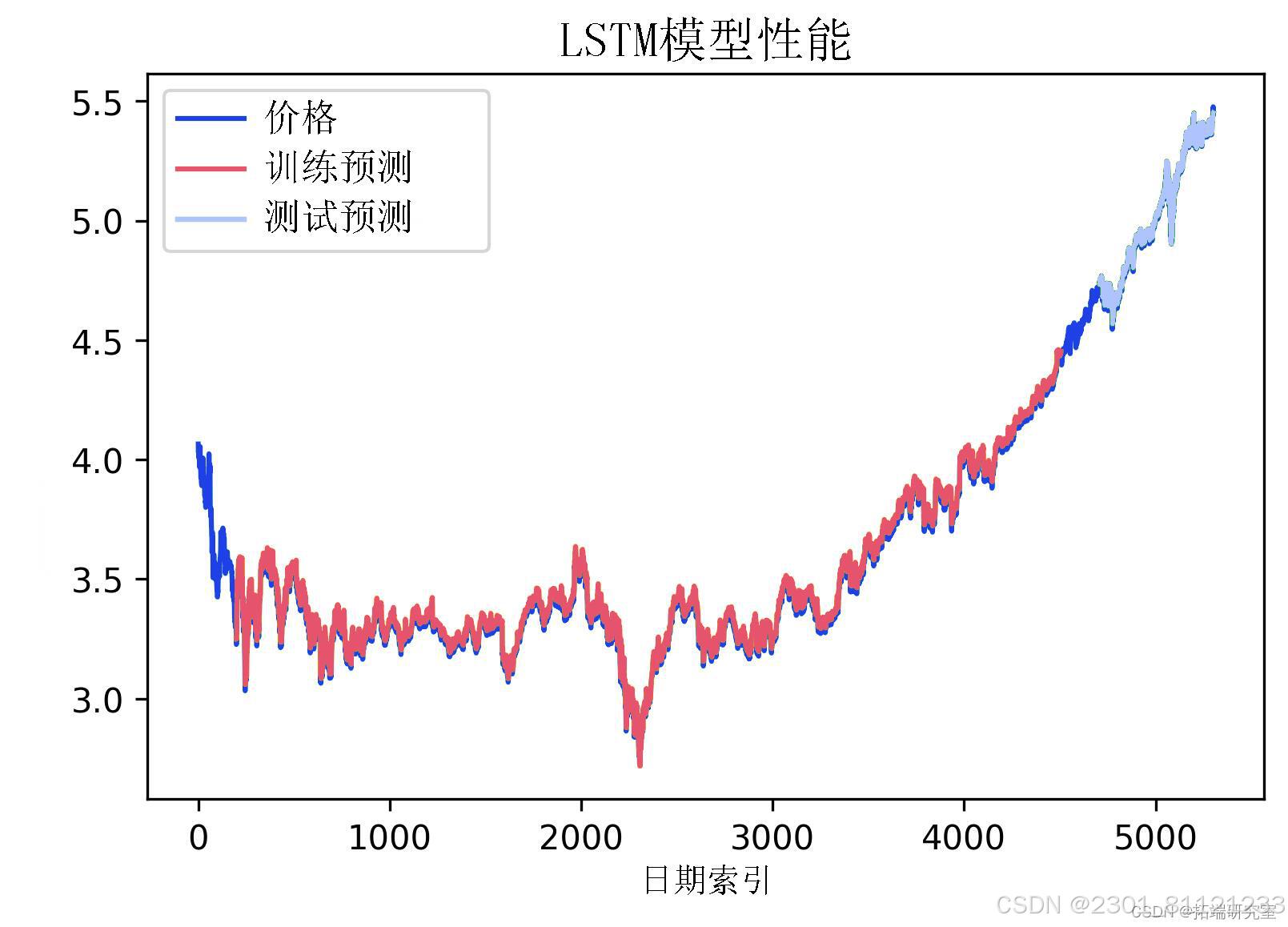

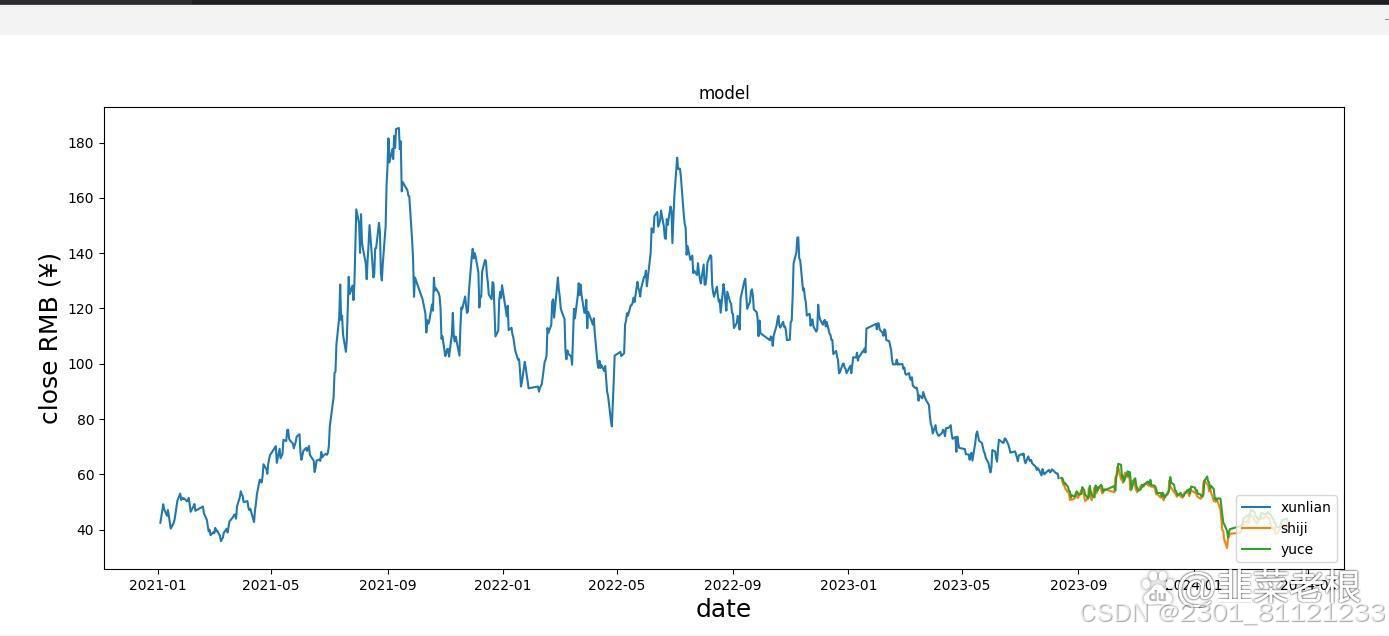

-**训练过程的损失和准确率曲线**:显示训练集和验证集的损失和准确率变化情况。

-**混淆矩阵**:显示分类结果的混淆矩阵,包括正确分类的数量和错误分类的数量。

-**ROC曲线**:显示ROC曲线和AUC分数,以评估模型的分类性能。

通过这些可视化图表,您可以更直观地了解模型的训练过程和分类性能,从而进行进一步的优化和调整。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?