做了那么多年开发,自学了很多门编程语言,我很明白学习资源对于学一门新语言的重要性,这些年也收藏了不少的Python干货,对我来说这些东西确实已经用不到了,但对于准备自学Python的人来说,或许它就是一个宝藏,可以给你省去很多的时间和精力。

别在网上瞎学了,我最近也做了一些资源的更新,只要你是我的粉丝,这期福利你都可拿走。

我先来介绍一下这些东西怎么用,文末抱走。

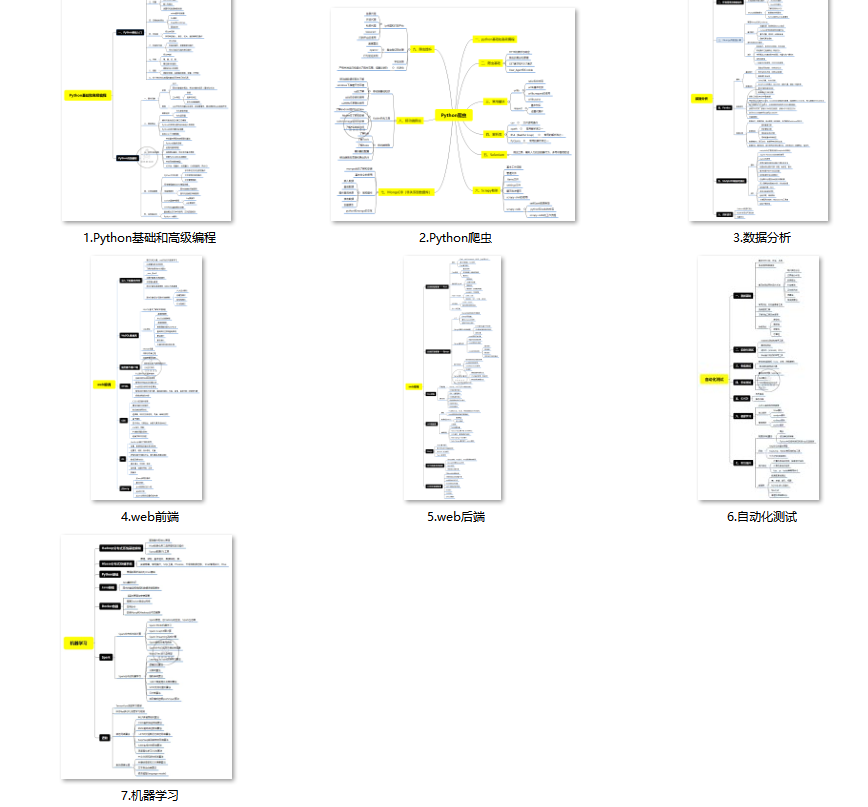

(1)Python所有方向的学习路线(新版)

这是我花了几天的时间去把Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

最近我才对这些路线做了一下新的更新,知识体系更全面了。

(2)Python学习视频

包含了Python入门、爬虫、数据分析和web开发的学习视频,总共100多个,虽然没有那么全面,但是对于入门来说是没问题的,学完这些之后,你可以按照我上面的学习路线去网上找其他的知识资源进行进阶。

(3)100多个练手项目

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了,只是里面的项目比较多,水平也是参差不齐,大家可以挑自己能做的项目去练练。

(4)200多本电子书

这些年我也收藏了很多电子书,大概200多本,有时候带实体书不方便的话,我就会去打开电子书看看,书籍可不一定比视频教程差,尤其是权威的技术书籍。

基本上主流的和经典的都有,这里我就不放图了,版权问题,个人看看是没有问题的。

(5)Python知识点汇总

知识点汇总有点像学习路线,但与学习路线不同的点就在于,知识点汇总更为细致,里面包含了对具体知识点的简单说明,而我们的学习路线则更为抽象和简单,只是为了方便大家只是某个领域你应该学习哪些技术栈。

(6)其他资料

还有其他的一些东西,比如说我自己出的Python入门图文类教程,没有电脑的时候用手机也可以学习知识,学会了理论之后再去敲代码实践验证,还有Python中文版的库资料、MySQL和HTML标签大全等等,这些都是可以送给粉丝们的东西。

这些都不是什么非常值钱的东西,但对于没有资源或者资源不是很好的学习者来说确实很不错,你要是用得到的话都可以直接抱走,关注过我的人都知道,这些都是可以拿到的。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

①从 NameNode 维护的的目录树里面删除路径,这也是为什么执行删除操作之后就无法再通过hdfs dfs -ls xxx 或其它 api 方式再查看到路径的根本原因**(拒绝需要被删除的文件的外部访问)**

②找出被删路径关联的 block 信息,每个文件包含多个 block 块,分布在各个 DataNode,此时并未真正物理删除 DataNode 上物理磁盘上的block块

③记录删除日志到editlog(这一步也很重要,甚至是后面恢复数据的关键)

代码@2把将要删除的block信息添加到org.apache.hadoop.hdfs.server.blockmanagement.BlockManager 里面维护的 InvalidateBlocks 对象中,InvalidateBlocks 专门用于保存等待删除的数据块副本

以上步骤并未涉及真正的物理删除的操作

BlockManager

BlockManager 管理了hdfs block 的生命周期并且维护在 Hadoop 集群中的块相关的信息,包括快的上报、复制、删除、监控、标记等等一系列功能。

BlockManager 中有个方法 invalidateWorkForOneNode() 专门用于定时删除 InvalidateBlocks 中存储的待删除的快,此方法会在 NameNode 启动时在 BlockManager 的内部线程类ReplicationMonitor 定时轮循把要删除的块放入 DatanodeDescriptor 中的逻辑,方法的调用路径如下:

org.apache.hadoop.hdfs.server.namenode.NameNode#initialize(Configuration conf)

org.apache.hadoop.hdfs.server.namenode.NameNode#startCommonServices(Configuration conf)

org.apache.hadoop.hdfs.server.namenode.FSNamesystem#startCommonServices(Configuration conf, HAContext haContext)

org.apache.hadoop.hdfs.server.blockmanagement.BlockManager#activate(Configuration conf)

org.apache.hadoop.hdfs.server.blockmanagement.BlockManager.ReplicationMonitor#run()

org.apache.hadoop.hdfs.server.blockmanagement.BlockManager#computeDatanodeWork()

org.apache.hadoop.hdfs.server.blockmanagement.BlockManager#computeDatanodeWorkcomputeInvalidateWork(int nodesToProcess)

org.apache.hadoop.hdfs.server.blockmanagement.BlockManager#invalidateWorkForOneNode(DatanodeInfo dn)

org.apache.hadoop.hdfs.server.blockmanagement.InvalidateBlocks#invalidateWork(final DatanodeDescriptor dn)

BlockManager 维护了 InvalidateBlocks,存放了待删除的 block,BlockManager 在 NameNode 启动时会单独启动一个线程,定时把要删除的块信息放入 InvalidateBlocks 中,每次会从InvalidateBlocks 队列中为每个 DataNode 取出 **blockInvalidateLimit(由配置项dfs.block.invalidate.limit,默认1000)**个块逻辑在 BlockManager.computeInvalidateWork() 方法里会把要删除的块信息放入 DatanodeDescriptor 中的 invalidateBlocks 数组,DatanodeManager 再通过 DataNode 与NameNode 心跳时,构建删除块的指令集,NameNode 再把指令下发给DataNode,心跳由 DatanodeProtocol 调用,方法的调用路径如下:

org.apache.hadoop.hdfs.server.protocol.DatanodeProtocol#sendHeartbeat()

org.apache.hadoop.hdfs.server.namenode.NameNodeRpcServer#sendHeartbeat()

org.apache.hadoop.hdfs.server.namenode.FSNamesystem#handleHeartbeat()

org.apache.hadoop.hdfs.server.blockmanagement.DatanodeManager#handleHeartbeat()

DatanodeManager.handleHeartbeat() 中构建删除的指令给 DataNode,待 NameNode 发送的代码如下:

/** Handle heartbeat from datanodes. */

public DatanodeCommand[] handleHeartbeat(DatanodeRegistration nodeReg,

StorageReport[] reports, final String blockPoolId,

long cacheCapacity, long cacheUsed, int xceiverCount,

int maxTransfers, int failedVolumes,

VolumeFailureSummary volumeFailureSummary,

@Nonnull SlowPeerReports slowPeers,

@Nonnull SlowDiskReports slowDisks) throws IOException {

final DatanodeDescriptor nodeinfo;

try {

nodeinfo = getDatanode(nodeReg);

} catch (UnregisteredNodeException e) {

return new DatanodeCommand[]{RegisterCommand.REGISTER};

}

// Check if this datanode should actually be shutdown instead.

if (nodeinfo != null && nodeinfo.isDisallowed()) {

setDatanodeDead(nodeinfo);

throw new DisallowedDatanodeException(nodeinfo);

}

if (nodeinfo == null || !nodeinfo.isRegistered()) {

return new DatanodeCommand[]{RegisterCommand.REGISTER};

}

heartbeatManager.updateHeartbeat(nodeinfo, reports, cacheCapacity,

cacheUsed, xceiverCount, failedVolumes, volumeFailureSummary);

// If we are in safemode, do not send back any recovery / replication

// requests. Don't even drain the existing queue of work.

if (namesystem.isInSafeMode()) {

return new DatanodeCommand[0];

}

// block recovery command

final BlockRecoveryCommand brCommand = getBlockRecoveryCommand(blockPoolId,

nodeinfo);

if (brCommand != null) {

return new DatanodeCommand[]{brCommand};

}

final List<DatanodeCommand> cmds = new ArrayList<>();

// Allocate _approximately_ maxTransfers pending tasks to DataNode.

// NN chooses pending tasks based on the ratio between the lengths of

// replication and erasure-coded block queues.

int totalReplicateBlocks = nodeinfo.getNumberOfReplicateBlocks();

int totalECBlocks = nodeinfo.getNumberOfBlocksToBeErasureCoded();

int totalBlocks = totalReplicateBlocks + totalECBlocks;

if (totalBlocks > 0) {

int numReplicationTasks = (int) Math.ceil(

(double) (totalReplicateBlocks * maxTransfers) / totalBlocks);

int numECTasks = (int) Math.ceil(

(double) (totalECBlocks * maxTransfers) / totalBlocks);

if (LOG.isDebugEnabled()) {

LOG.debug("Pending replication tasks: " + numReplicationTasks

+ " erasure-coded tasks: " + numECTasks);

}

// check pending replication tasks

List<BlockTargetPair> pendingList = nodeinfo.getReplicationCommand(

numReplicationTasks);

if (pendingList != null && !pendingList.isEmpty()) {

cmds.add(new BlockCommand(DatanodeProtocol.DNA_TRANSFER, blockPoolId,

pendingList));

}

// check pending erasure coding tasks

List<BlockECReconstructionInfo> pendingECList = nodeinfo

.getErasureCodeCommand(numECTasks);

if (pendingECList != null && !pendingECList.isEmpty()) {

cmds.add(new BlockECReconstructionCommand(

DNA_ERASURE_CODING_RECONSTRUCTION, pendingECList));

}

}

// check block invalidation

Block[] blks = nodeinfo.getInvalidateBlocks(blockInvalidateLimit);

if (blks != null) {

cmds.add(new BlockCommand(DatanodeProtocol.DNA_INVALIDATE, blockPoolId,

blks));

}

// cache commands

addCacheCommands(blockPoolId, nodeinfo, cmds);

// key update command

blockManager.addKeyUpdateCommand(cmds, nodeinfo);

// check for balancer bandwidth update

if (nodeinfo.getBalancerBandwidth() > 0) {

cmds.add(new BalancerBandwidthCommand(nodeinfo.getBalancerBandwidth()));

// set back to 0 to indicate that datanode has been sent the new value

nodeinfo.setBalancerBandwidth(0);

}

if (slowPeerTracker != null) {

final Map<String, Double> slowPeersMap = slowPeers.getSlowPeers();

if (!slowPeersMap.isEmpty()) {

if (LOG.isDebugEnabled()) {

LOG.debug("DataNode " + nodeReg + " reported slow peers: " +

slowPeersMap);

}

for (String slowNodeId : slowPeersMap.keySet()) {

slowPeerTracker.addReport(slowNodeId, nodeReg.getIpcAddr(false));

}

}

}

if (slowDiskTracker != null) {

if (!slowDisks.getSlowDisks().isEmpty()) {

if (LOG.isDebugEnabled()) {

LOG.debug("DataNode " + nodeReg + " reported slow disks: " +

slowDisks.getSlowDisks());

}

slowDiskTracker.addSlowDiskReport(nodeReg.getIpcAddr(false), slowDisks);

}

}

if (!cmds.isEmpty()) {

return cmds.toArray(new DatanodeCommand[cmds.size()]);

}

return new DatanodeCommand[0];

}

定时轮循+limit 1000个块删除的特性决定了hdfs删除数据并不会立即真正的执行物理删除,并且一次删除的数量也有限,所以出现误删操作需要立即停止HDFS,虽然有的数据在轮循中已被删除,所以事发后停止HDFS集群越早,被删的数据越少,损失越小!

EditLog

EditLog记录了hdfs操作的每一条日志记录,包括当然包括删除,我们所熟知的文件操作类型只有增、删、改,但是在 HDFS 的领域里,远远不止这些操作,我们看看 EditLog 操作类型的枚举类org.apache.hadoop.hdfs.server.namenode.FSEditLogOpCodes

/**

* Licensed to the Apache Software Foundation (ASF) under one

* or more contributor license agreements. See the NOTICE file

* distributed with this work for additional information

* regarding copyright ownership. The ASF licenses this file

* to you under the Apache License, Version 2.0 (the

* "License"); you may not use this file except in compliance

* with the License. You may obtain a copy of the License at

*

* http://www.apache.org/licenses/LICENSE-2.0

*

* Unless required by applicable law or agreed to in writing, software

* distributed under the License is distributed on an "AS IS" BASIS,

* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

* See the License for the specific language governing permissions and

* limitations under the License.

*/

package org.apache.hadoop.hdfs.server.namenode;

import org.apache.hadoop.classification.InterfaceAudience;

import org.apache.hadoop.classification.InterfaceStability;

import org.apache.hadoop.hdfs.server.namenode.FSEditLogOp.*;

/**

* Op codes for edits file

*/

@InterfaceAudience.Private

@InterfaceStability.Unstable

public enum FSEditLogOpCodes {

// last op code in file

OP_ADD ((byte) 0, AddOp.class),

// deprecated operation

OP_RENAME_OLD ((byte) 1, RenameOldOp.class),

OP_DELETE ((byte) 2, DeleteOp.class),

OP_MKDIR ((byte) 3, MkdirOp.class),

OP_SET_REPLICATION ((byte) 4, SetReplicationOp.class),

@Deprecated OP_DATANODE_ADD ((byte) 5), // obsolete

@Deprecated OP_DATANODE_REMOVE((byte) 6), // obsolete

OP_SET_PERMISSIONS ((byte) 7, SetPermissionsOp.class),

OP_SET_OWNER ((byte) 8, SetOwnerOp.class),

OP_CLOSE ((byte) 9, CloseOp.class),

OP_SET_GENSTAMP_V1 ((byte) 10, SetGenstampV1Op.class),

OP_SET_NS_QUOTA ((byte) 11, SetNSQuotaOp.class), // obsolete

OP_CLEAR_NS_QUOTA ((byte) 12, ClearNSQuotaOp.class), // obsolete

OP_TIMES ((byte) 13, TimesOp.class), // set atime, mtime

OP_SET_QUOTA ((byte) 14, SetQuotaOp.class),

// filecontext rename

OP_RENAME ((byte) 15, RenameOp.class),

// concat files

OP_CONCAT_DELETE ((byte) 16, ConcatDeleteOp.class),

OP_SYMLINK ((byte) 17, SymlinkOp.class),

OP_GET_DELEGATION_TOKEN ((byte) 18, GetDelegationTokenOp.class),

OP_RENEW_DELEGATION_TOKEN ((byte) 19, RenewDelegationTokenOp.class),

OP_CANCEL_DELEGATION_TOKEN ((byte) 20, CancelDelegationTokenOp.class),

OP_UPDATE_MASTER_KEY ((byte) 21, UpdateMasterKeyOp.class),

OP_REASSIGN_LEASE ((byte) 22, ReassignLeaseOp.class),

OP_END_LOG_SEGMENT ((byte) 23, EndLogSegmentOp.class),

OP_START_LOG_SEGMENT ((byte) 24, StartLogSegmentOp.class),

OP_UPDATE_BLOCKS ((byte) 25, UpdateBlocksOp.class),

OP_CREATE_SNAPSHOT ((byte) 26, CreateSnapshotOp.class),

OP_DELETE_SNAPSHOT ((byte) 27, DeleteSnapshotOp.class),

OP_RENAME_SNAPSHOT ((byte) 28, RenameSnapshotOp.class),

OP_ALLOW_SNAPSHOT ((byte) 29, AllowSnapshotOp.class),

OP_DISALLOW_SNAPSHOT ((byte) 30, DisallowSnapshotOp.class),

OP_SET_GENSTAMP_V2 ((byte) 31, SetGenstampV2Op.class),

OP_ALLOCATE_BLOCK_ID ((byte) 32, AllocateBlockIdOp.class),

OP_ADD_BLOCK ((byte) 33, AddBlockOp.class),

OP_ADD_CACHE_DIRECTIVE ((byte) 34, AddCacheDirectiveInfoOp.class),

OP_REMOVE_CACHE_DIRECTIVE ((byte) 35, RemoveCacheDirectiveInfoOp.class),

OP_ADD_CACHE_POOL ((byte) 36, AddCachePoolOp.class),

OP_MODIFY_CACHE_POOL ((byte) 37, ModifyCachePoolOp.class),

OP_REMOVE_CACHE_POOL ((byte) 38, RemoveCachePoolOp.class),

OP_MODIFY_CACHE_DIRECTIVE ((byte) 39, ModifyCacheDirectiveInfoOp.class),

OP_SET_ACL ((byte) 40, SetAclOp.class),

OP_ROLLING_UPGRADE_START ((byte) 41, RollingUpgradeStartOp.class),

OP_ROLLING_UPGRADE_FINALIZE ((byte) 42, RollingUpgradeFinalizeOp.class),

OP_SET_XATTR ((byte) 43, SetXAttrOp.class),

OP_REMOVE_XATTR ((byte) 44, RemoveXAttrOp.class),

OP_SET_STORAGE_POLICY ((byte) 45, SetStoragePolicyOp.class),

OP_TRUNCATE ((byte) 46, TruncateOp.class),

OP_APPEND ((byte) 47, AppendOp.class),

OP_SET_QUOTA_BY_STORAGETYPE ((byte) 48, SetQuotaByStorageTypeOp.class),

OP_ADD_ERASURE_CODING_POLICY ((byte) 49, AddErasureCodingPolicyOp.class),

OP_ENABLE_ERASURE_CODING_POLICY((byte) 50, EnableErasureCodingPolicyOp.class),

OP_DISABLE_ERASURE_CODING_POLICY((byte) 51,

DisableErasureCodingPolicyOp.class),

OP_REMOVE_ERASURE_CODING_POLICY((byte) 52, RemoveErasureCodingPolicyOp.class),

// Note that the current range of the valid OP code is 0~127

OP_INVALID ((byte) -1);

private final byte opCode;

private final Class<? extends FSEditLogOp> opClass;

/**

* Constructor

*

* @param opCode byte value of constructed enum

*/

FSEditLogOpCodes(byte opCode) {

this(opCode, null);

}

FSEditLogOpCodes(byte opCode, Class<? extends FSEditLogOp> opClass) {

this.opCode = opCode;

this.opClass = opClass;

}

/**

* return the byte value of the enum

*

* @return the byte value of the enum

*/

public byte getOpCode() {

return opCode;

}

public Class<? extends FSEditLogOp> getOpClass() {

return opClass;

}

private static final FSEditLogOpCodes[] VALUES;

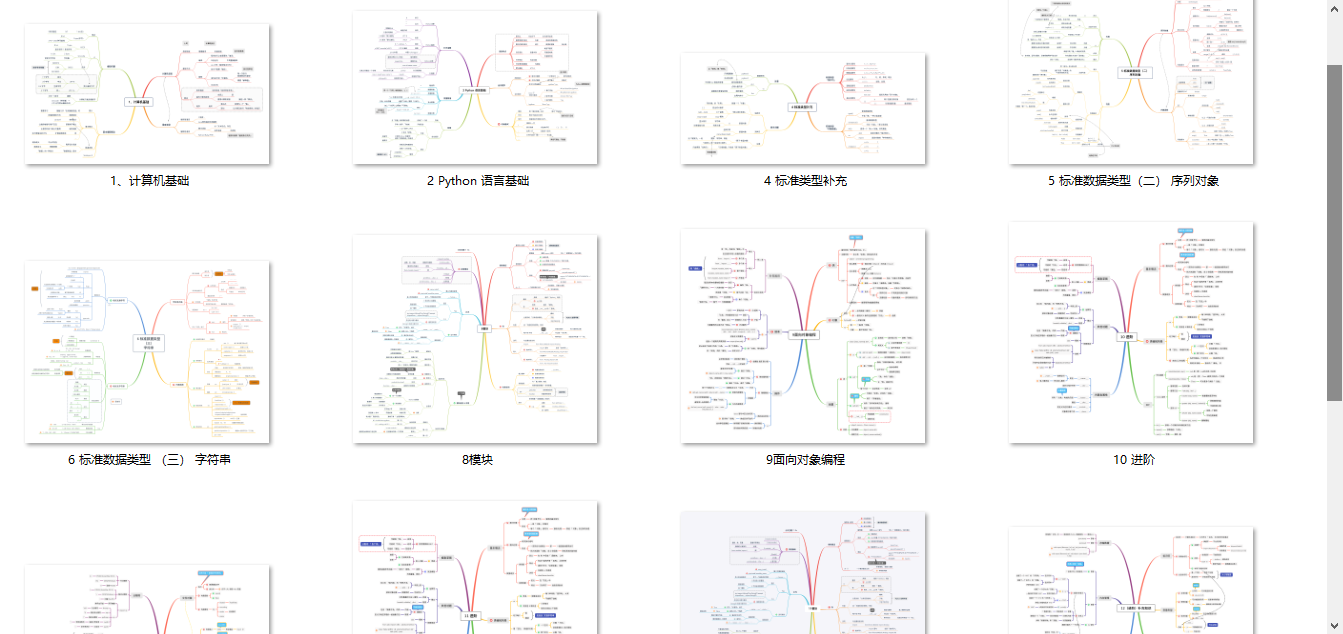

**一、Python所有方向的学习路线**

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

**二、Python必备开发工具**

工具都帮大家整理好了,安装就可直接上手!

**三、最新Python学习笔记**

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

**四、Python视频合集**

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

**五、实战案例**

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

**六、面试宝典**

###### **简历模板**

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化学习资料的朋友,可以戳这里获取](https://bbs.csdn.net/forums/4304bb5a486d4c3ab8389e65ecb71ac0)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?