一、引言

随着互联网的快速发展,网络爬虫技术被广泛应用于数据收集和处理。在爬虫过程中,如何有效地存储和管理爬取到的数据成为一个重要的问题。本文将探讨网络爬虫数据存储的需求、策略以及案例,本文为读者提供对网络爬虫数据存储的一些有益的参考。

二、网络爬虫数据存储的需求

1.数据量的需求

随着互联网的快速发展,网络爬虫需要获取的数据量越来越大。因此,数据存储需要能够满足大量的数据存储需求。

2.数据更新的需求

网络爬虫需要定期更新数据,因此数据存储需要能够支持数据的实时更新。

3.数据安全的需求

网络爬虫获取的数据可能包含敏感信息,因此数据存储需要保证数据的安全性,防止数据泄露。

4.数据查询和分析的需求

网络爬虫获取的数据需要进行查询和分析,因此数据存储需要支持高效的查询和分析操作。

三、网络爬虫数据存储的常见方式

1.文件存储

文件存储是将爬虫数据存储在本地文件系统中。这种方式简单易用,但不适合大规模数据的存储和管理。

以下是网络爬虫保存数据为TXT文本文件的步骤:

- 确定保存数据的格式:根据实际需求,确定保存数据的格式,如CSV、JSON等。

- 获取数据:使用网络爬虫获取需要保存的数据。

- 写入文本文件:将获取到的数据写入到TXT文本文件中。可以使用Python中的文件操作函数,如open()、write()等。

例如,以下是一个简单的Python代码示例,用于将数据保存为TXT文本文件:

# 获取网页内容

response = requests.get('http://example.com')

html_content = response.text

# 提取需要保存的数据

data = extract_data(html_content) # 假设extract_data是一个自定义的函数,用于提取需要保存的数据

# 将数据保存为TXT文本文件

with open('data.txt', 'w') as f:

f.write(str(data))open() 将会返回一个 file 对象,基本语法格式如下:

open(filename, mode)

- filename:包含了你要访问的文件名称的字符串值。

- mode:决定了打开文件的模式:只读,写入,追加等。所有可取值见如下的完全列表。这个参数是非强制的,默认文件访问模式为只读(r)。

不同模式打开文件的完全列表:

| r | 以只读方式打开一个文件,默认模式。 |

| rb | 以二进制方式打开一个文件,例如音频、图片、视频等。 |

| r+ | 以读写方式打开一个文件,既可以读文件又可以写文件。 |

| rb+ | 以二进制读写方式打开一个文件,即可以读也可以写,读写都是二进制数据。 |

| w | 以写入的方式打开一个文件。如果该文件已存在,则将其覆盖;否则创建文件。 |

| wb | 以二进制写入方式打开一个文件。如果该文件已存在,则将其覆盖;否则创建文件。 |

| w+ | 以读写方式打开一个文件。如果该文件已存在,则将其覆盖;否则创建文件。 |

| wb+ | 以二进制读写格式打开一个文件。如果该文件已存在,则将其覆盖;否则创建文件。 |

| a | 以追加方式打开一个文件。若文件已存在,文件指针会放在文件结尾;否则创建文件来写入。。 |

| ab | 以二进制追加方式打开一个文件。若文件已存在,文件指针会放在文件结尾;否则创建文件来写入。 |

| a+ | 以读写方式打开一个文件。若文件已存在,文件指针会放在文件结尾;否则创建文件来写。入 |

| ab+ | 以二进制追加方式打开一个文件。若文件已存在,文件指针会放在文件结尾;否则创建文件来写入。 |

2.JSON文件存储

网络爬虫可以使用JSON文件来存储数据。JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于阅读和编写,同时也易于机器解析和生成。

以下是网络爬虫使用JSON文件存储数据的步骤:

(1)确定数据结构:首先需要确定要存储的数据结构,包括数据的字段和类型。例如,如果要从一个网页中爬取用户的个人信息,可能需要存储的数据包括用户的姓名、年龄、性别等。

(2)编写JSON文件:根据确定的数据结构,可以编写一个JSON文件来存储数据。JSON文件通常以键值对的形式表示数据,每个键对应一个字段,每个值对应一个字段的值。例如,如果需要存储一个用户的个人信息,可以编写如下的JSON文件:

{

"name": "John Doe",

"age": 30,

"gender": "Male"

}(3)读取JSON文件:在需要使用这些数据时,可以读取JSON文件并将其解析为Python对象。Python提供了内置的json模块来处理JSON数据。例如,可以使用以下代码读取并解析JSON文件:

import json

with open('data.json', 'r') as f:

data = json.load(f)在上面的代码中,首先使用open()函数打开JSON文件,然后使用json.load()函数将文件内容解析为Python对象。

(4)更新JSON文件:如果需要更新存储在JSON文件中的数据,可以重新编写JSON文件并覆盖原有的文件内容。或者,也可以在原有的JSON文件中添加新的键值对来更新数据。

3.CSV文件存储

网络爬虫通常用于从网站上抓取数据,然后将这些数据存储在各种格式的文件中,包括CSV文件。以下是一个简单的Python示例,说明如何使用网络爬虫将数据存储到CSV文件中:

import csv

import requests

# 目标网页的URL

url = "http://example.com"

# 发送HTTP请求并获取网页内容

response = requests.get(url)

html_content = response.text

# 使用BeautifulSoup库解析HTML内容

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'lxml')

# 提取所需的数据,这里以网页标题为例

titles = soup.find_all('title')

# 存储数据到CSV文件中

with open('output.csv', 'w', newline='', encoding='utf-8') as f:

writer = csv.writer(f)

for title in titles:

# 这里简单地把标题作为CSV文件的一列,你可以根据需要提取更多信息

writer.writerow([title.text])这个例子中,我们使用了requests库来发送HTTP请求并获取网页内容,然后使用BeautifulSoup库来解析HTML内容。我们提取了网页中的所有标题,并将它们存储在一个CSV文件中。你可以根据需要修改代码,以提取其他信息,或者对数据进行处理。

注意,运行这个爬虫可能需要遵守网站的使用条款或机器人排除协议,以确保你的爬虫不会对网站的正常运行造成干扰。此外,你可能需要处理各种可能出现的错误和异常,例如网络请求失败、解析错误等

4.MongoDB文档存储

网络爬虫的数据可以存储到MongoDB中。MongoDB是一种非关系型数据库,适用于存储大量的数据,并且支持灵活的数据结构。

要将网络爬虫的数据存储到MongoDB中,需要进行以下步骤:

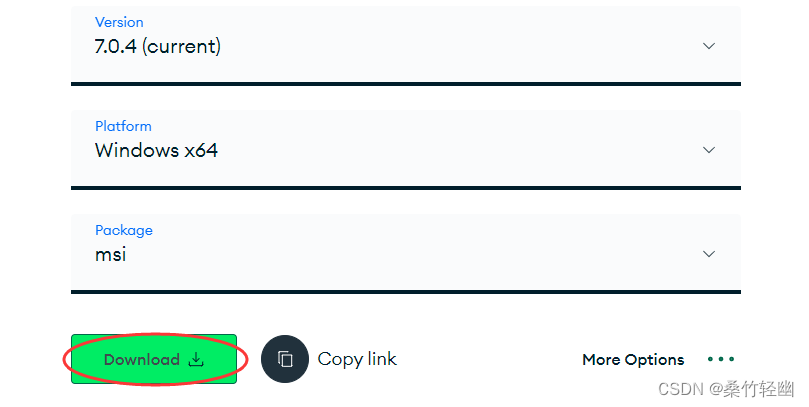

1.安装MongoDB:首先需要在本地或服务器上安装MongoDB数据库。可以从MongoDB的官方网站下载适用于你的操作系统的安装包,并按照安装指南进行安装。

2.连接MongoDB:在编写网络爬虫的代码时,需要使用MongoDB的驱动程序来连接数据库。不同的编程语言有不同的驱动程序可供选择,例如Python的PyMongo驱动程序。

下面是一个简单的示例代码,演示了如何使用PyMongo连接MongoDB数据库:

from pymongo import MongoClient

# 创建MongoDB的连接对象

client = MongoClient('localhost', 27017)

# 连接到指定的数据库

db = client['mydatabase']

# 连接到指定的集合(类似于表)

collection = db['mycollection']

# 在集合中插入数据

data = {'name': 'John', 'age': 30, 'city': 'New York'}

collection.insert_one(data)

# 查询集合中的数据

results = collection.find()

for result in results:

print(result)

# 关闭连接

client.close()在上面的代码中,首先使用MongoClient类创建一个MongoDB的连接对象,指定MongoDB服务器的主机名和端口号。然后,通过连接对象选择指定的数据库和集合。可以使用insert_one()方法在集合中插入数据,使用find()方法查询集合中的数据。最后,使用close()方法关闭连接。

请确保在运行代码之前已经安装了PyMongo库。你可以使用以下命令来安装PyMongo:

pip install pymongo四、总结

网络爬虫数据存储的最佳实践包括选择合适的存储类型、进行数据清洗和保障数据安全。根据你的需求和资源选择合适的存储类型,对数据进行清洗以确保数据的准确性和完整性,同时采取措施保障数据的安全性。这将有助于你从网络爬虫获取的数据中获得有价值的洞察和分析结果。

1124

1124

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?