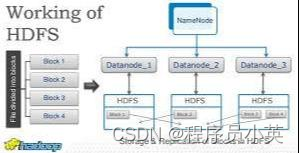

1、HDFS伪分布式搭建步骤:

(1) 配置免密登录 node01->node01

ssh-keygen -t rsa

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node01(2) 配置JDK

export JAVA_HOME=/opt/software/jdk/jdk1.8.0_151

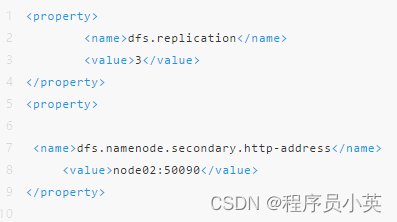

export PATH=$PATH:$JAVA_HOME/bin (3) 修改hdfs-site.xml配置文件

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node01:50090</value>

</property>(4) 修改core-site.xml配置文件

<property>

<name>fs.defaultFS</name>

<value>hdfs://node01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/var/abc/hadoop/local</value>

</property>(5) 修改slaves配置文件

修改为node01

(6) 格式化NameNode(创建目录以及文件) hdfs namenode -format

(7) 启动HDFS start-dfs.sh

(8) 操作HDFS文件系统

① 创建目录 hdfs dfs -mkdir -p /user/root

② 上传文件 hdfs dfs -D dfs.blocksize=1048576 -put

2、HDFS完全分布式搭建步骤:

(1) 时间同步

① 各个节点安装ntp命令yum install ntp

② 上网查找最新的时间服务器ntp1.aliyun.com

③ 同步时间ntpdate ntp1.aliyun.com

(2) 配置免密登录

node01->node01 node01->node02 node01->node03 node01->node04

① 所有节点执行 ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

② 在node01节点执行,将node01的公钥加入到其他节点的白名单中 ssh-copy-id -i ~/.ssh/id_rsa.pub root@node01

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node02

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node03

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node04

(3) 所有节点配置JDK

(4) 修改hdfs-site.xml配置文件

(5) 修改core-site.xml配置文件

<property> <name>fs.defaultFS</name> <value>hdfs://node01:9000</value></property><property> <name>hadoop.tmp.dir</name> <value>/var/abc/hadoop/cluster</value></property>

(6) 修改slaves配置文件

修改为node02 node03 node04

将配置好的安装包分发到其他节点上

scp -r hadoop-2.6.5 root@node02:/opt/software/hadoop/

(7) 将所有的HDFS相关的进程关闭

(8) 格式化NameNode(创建目录以及文件)在node01节点执行

① hdfs namenode -format

(9) 启动HDFS start-dfs.sh

(10) 操作HDFS文件系统

① 创建目录 hdfs dfs -mkdir -p /user/root

② 上传文件 hdfs dfs -D dfs.blocksize=1048576 -put

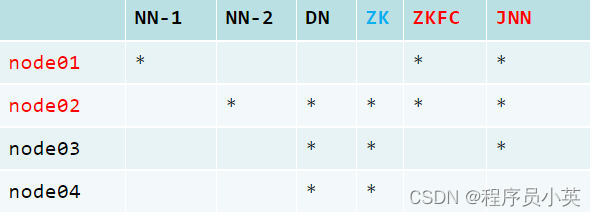

3、HDFS HA完全分布式搭建步骤:

集群规划:

(1) 配置免密登录

node01->node01 node01->node02 node01->node03 node01->node04

node02->node01

① 在node02节点执行,将node01的公钥加入到其他节点的白名单中 ssh-copy-id -i ~/.ssh/id_rsa.pub root@node01

(2) 所有节点配置JDK

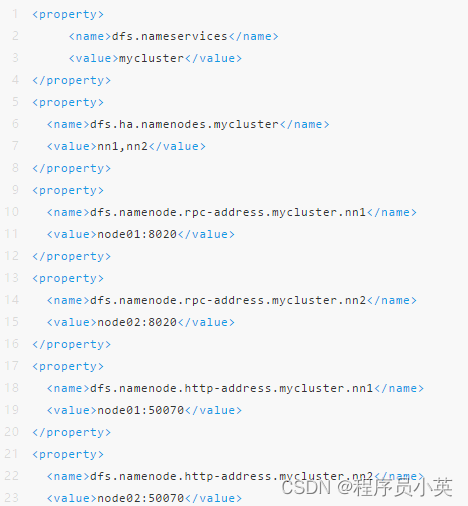

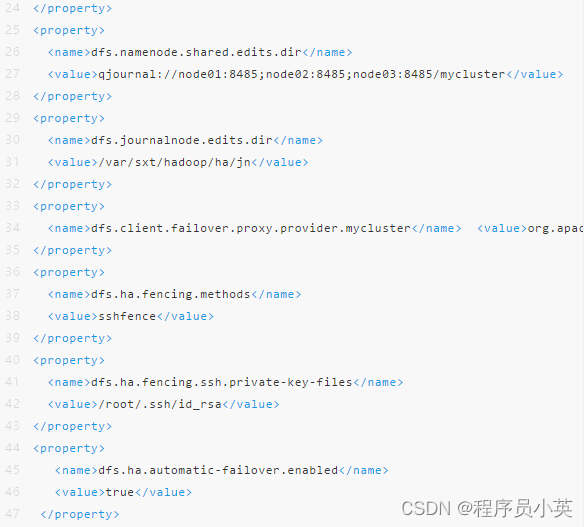

(3) 修改hdfs-site.xml配置文件

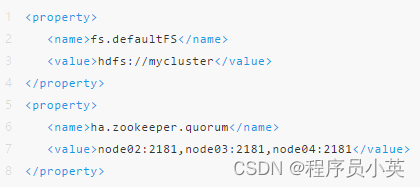

(4) 修改core-site.xml配置文件

(5) 修改slaves配置文件

① 修改为node02 node03 node04

(6) 将配置好的HDFS安装包拷贝到node02 node03 node04

4、搭建zookeeper集群:

(1) node02上解压

(2) 修改conf目录下的zoo_sample.cfg的名称,改为zoo.cfg

① mv zoo_sample.cfg zoo.cfg

(3) 修改zoo.cfg

① dataDir=/var/zfg/zookeeper

② server.1=node02:2888:3888

③ server.2=node03:2888:3888

④ server.3=node04:2888:3888

(4) 在dataDir目录下创建一个myid文件,在这个文件中写上当前节点ID号

(5) 将配置好的zookeeper安装包拷贝到node03 node04

(6) 拷贝完毕后,在各自节点上创建myid号,ID号要依次递增

(7) zk节点bin下执行./zkServer.sh start

(8) 格式化NameNode(创建目录以及文件)

① 在node01、node02、node03分别执行如下命令

1) hadoop-daemon.sh start journalnode

② 随机选择一台NameNode执行:

1) hdfs namenode -format

2) hadoop-daemon.sh start namenode

③ 另外一台NameNode节点执行:

1) hdfs namenode -bootstrapStandby

(9) hdfs zkfc -formatZK

(10) 关闭所有节点上的进程 stop-dfs.sh

(11) 启动HDFS start-dfs.sh

(12) 操作HDFS文件系统

① 创建目录 hdfs dfs -mkdir -p /user/root

② 上传文件 hdfs dfs -D dfs.blocksize=1048576 -put

943

943

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?