再点击NAT设置,修改网关IP为192.168.10.2(之后也要修改windows上的VMnet8的网关)

再点击DHCP设置,修改起始IP为192.168.10.128,结束IP为192.168.10.256

之后保存并退出。

修改ens33网卡配置

vim /etc/sysconfig/network-scripts/ifcfg-ens33

将BOOTPROTO改为static,ONBOOT改为yes,之后添加以下配置

IPADDR=192.168.10.128

GATEWAY=192.168.10.2

NETMASK=255.255.255.0

DNS1=192.168.10.2

之后将其余两台主机分别处理,写入各自的IP

0.2 SSH免密登录

注意:在hadoop130上生成公钥,然后复制给hadoop131,结果是可以在hadoop130上免密登录hadoop131

简单方法:

先在hadoop130上生成公钥、密钥

ssh-keygen //之后按四下回车

然后将公钥复制给hadoop131,就可以登陆hadoop131(中间可能要输入hadoop131的密码)

ssh-copy-id hadoop131

复杂方法:

在从机hadoop130上,查看本地机器的隐藏文件 .ssh

ll -a

进入.ssh目录

cd .ssh

发起公钥请求

ssh-keygen -t rsa

然后在.ssh/目录下,会新生成两个文件:id_rsa.pub和 id_rsa

上传公钥到目标主机(注意要在.ssh目录下,否则可能没有权限)

ssh-copy-id crane@192.168.10.131

ssh-copy-id crane@hadoop131

(ssh-copy-id 用户名@主机名/IP地址)

在主机的.ssh文件上检查是否接收到 authorized_keys文件

文件中查看hadoop131下的authorized_keys文件与hadoop130下的id_rsa.pub中内容是一样的

之后可以在主机hadoop130上测试免密登录从机hadoop131

ssh hadoop131 //用户名相同时

ssh 用户名@IP地址 //用户名不同时

Q1.找不到.ssh文件夹

ssh localhost

.ssh 是记录密码信息的文件夹,如果没有登录过root的话,就没有 .ssh 文件夹,因此登录 localhost ,并输入密码就会生成了。

Q2.SSHD服务无响应

yum list installed | grep openssh-server //检查sshd有没有安装

netstat -an | grep 22 //检查sshd 服务是否启动

systemctl start sshd.service //开启sshd服务

systemctl status sshd.service //查看sshd状态

systemctl restart sshd.service //重启sshd服务

0.3 主机配置

配置主机hostname为hadoop130,hadoop131,hadoop132

配置主机hosts

192.168.10.130 hadoop130

192.168.10.131 hadoop131

192.168.10.132 hadoop132

集群时间同步

ntpdate ntp5.aliyun.com //同步阿里云的时间

关闭防火墙

先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前在阿里

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

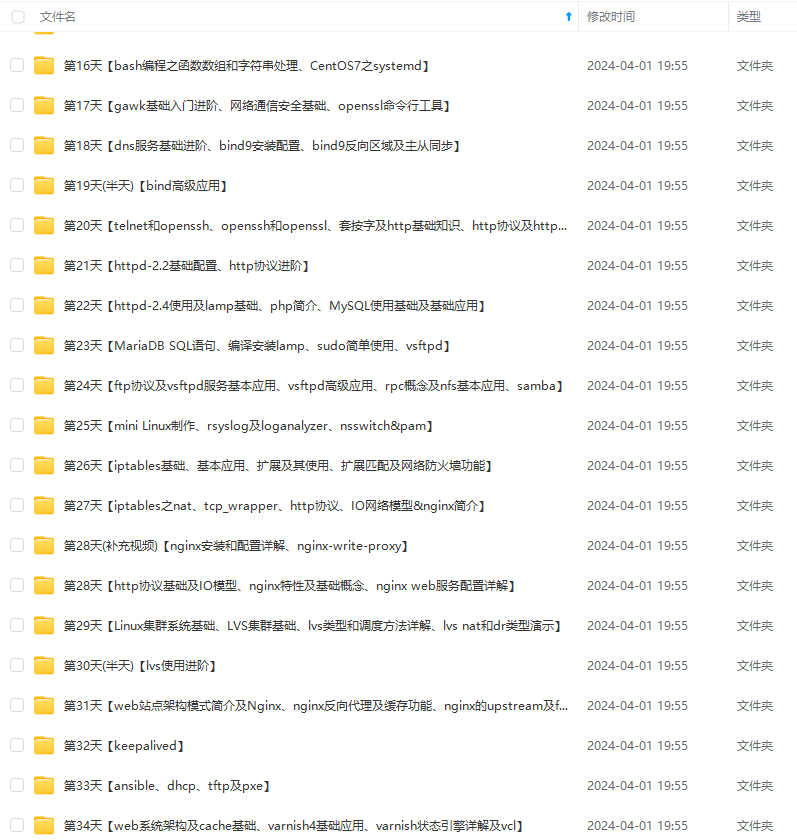

因此收集整理了一份《2024年最新Linux运维全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上运维知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

伙伴深入学习提升的进阶课程,涵盖了95%以上运维知识点,真正体系化!**

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

704

704

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?