driver = webdriver.Chrome(r’F:\driver\chromedriver.exe’)

driver.get(url)

怎么样,是不是浏览器自动打开了?现在我们尝试输出这个driver,就可以看见,网页的正确源代码已经在里面了。

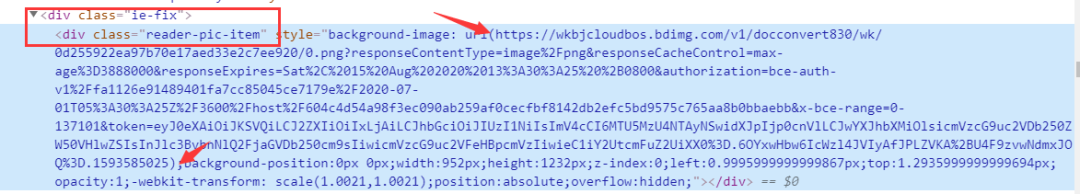

现在我们仔细研究一下源代码就可以看到,我们需要的内容在下面这个位置。

现在正确的源代码也有了,内容的位置也知道了,直接解析,爬取,完事就好了。

想得美,经过这样的爬取之后,对内容进行解析,让我们看看究竟爬到没有。

from lxml import etree

import re

html=etree.HTML(driver.page_source)

links=html.xpath(“//div[@class=‘reader-pic-item’]/@style”)

part = re.compile(r’url([)]')

qa=“”.join(links)

z=part.findall(qa)

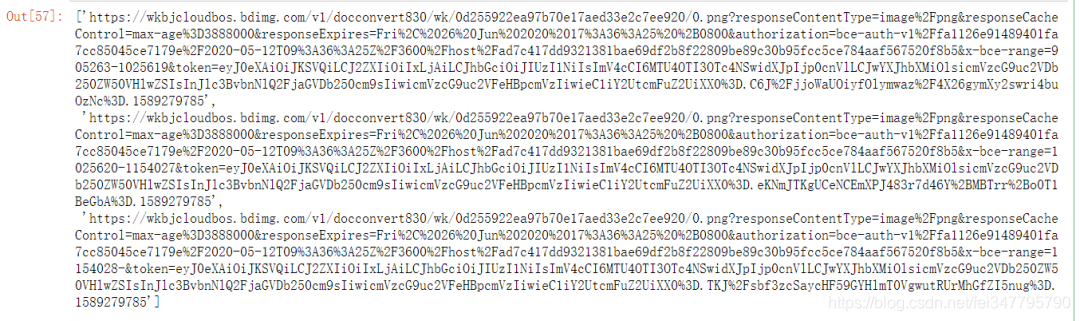

我们可以知道,其实我们只爬到3张PDF,其他的都没有爬到。这是为什么呢?

这是百度文库为了防止大家去爬,专门设置的一个小机关。

返回百度文库,我们仔细看看源代码,其实我们可以发现,随着页面的变化,源代码是不断改变的,每次都只有3张图片的url。并且这个页码数也有一定的规律,如果在第二页,那么图片就是1,2,3,如果在第三页,图片就是2,3,4。

那么我们的疑惑一下就解决了,只需要不断地进行换页的爬取,就可以了。接下来就是如何实现换页的操作了。

这个需要两个步骤,先是点击继续阅读,然后进行页面输入实现换页。先实现点击的操作,代码如下。

button = driver.find_element_by_xpath(“//*[@id=‘html-reader-go-more’]/div[2]/div[1]/span”)

button.click()

driver.execute_script(“arguments[0].click();”, button)

整个操作是通过JS来进行的,大家可以把这个记住,以后需要点击的时候直接用就可以。

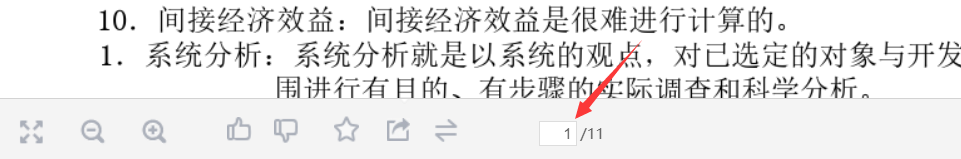

然后就是输入页面实现换页,这个其实涉及的比较多,细分的话,步骤分为获取总页数,依次输入页面并点击。

import re

寻找页面

source = re.compile(r’/(.*?)')

number = int(source.findall(driver.page_source)[0])

输入页面并点击

driver.find_element_by_class_name(“page-input”).clear()

driver.find_element_by_class_name(“page-input”).send_keys(‘2’)

driver.find_element_by_class_name(“page-input”).send_keys(Keys.ENTER)

如果小伙伴成功实现了上面的操作,其实大体的爬取工作已经差不多了,接下来就是保存我们的PPT和PDF了。

因为爬取PDF和PPT的时候,我们是爬取的图片的源地址,那么我们要获得这张图片并保存下来就必须对这个地址发起请求,然后将返回头以二进制保存下来。

for m in range(3):

pic = requests.get(z[m]).content

方法一

file = open(f’./照片/{m+1}.jpg’,‘wb’)

file.write(pic)

file.close()

方法二

with open(f’./照片/{m+1}.jpg’,‘wb’) as f:

f.write(pic)

f.close()

在这里,提醒大家一下一定要按照对图片用正确顺序进行命名,因为后面保存为PDF的时候,需要排序。

在py文件的目录下,大家就可以看见保存下来的图片了。最后一步,将图片保存为PDF。

from PIL import Image

import os

folderPath = “F:/TEST”

filename = “test”

files = os.listdir(folderPath)

jpgFiles = []

sources = []

for file in files:

if ‘jpg’ in file:

jpgFiles.append(file)

tep = []

for i in jpgFiles:

ex = i.split(‘.’)

tep.append(int(ex[0]))

tep.sort()

jpgFiles=[folderPath +‘/’+ str(i) + ‘.jpg’ for i in tep]

output = Image.open(jpgFiles[0])

jpgFiles.pop(0)

for file in jpgFiles:

img = Image.open(file)

img = img.convert(“P”)

sources.append(img)

output.save(f"./{filename}.pdf",“PDF”,save_all=True,append_images=sources)

最终的结果就是生成了咱们的PDF文件。

上述的操作看起来很多,很麻烦,其实并不是的。因为大部分的操作都是固定的,大家只需要记熟就可以了。

import requests

from selenium import webdriver

from lxml import etree

import re

from selenium.webdriver.common.keys import Keys

import time

from PIL import Image

import os

from bs4 import BeautifulSoup

import bs4

from docx import Document

import sys

def getHTMLText(url):

header = {‘User-agent’: ‘Googlebot’}

try:

r = requests.get(url, headers = header, timeout = 30)

r.raise_for_status()

r.encoding = ‘gbk’

r.encoding = r.apparent_encoding

return r.text

except:

return ‘’

def parse_type(content):

return re.findall(r"docType.?:.?‘(.*?)’,", content)[0]

def parse_txt(html):

plist = []

soup = BeautifulSoup(html, “html.parser”)

plist.append(soup.title.string)

for div in soup.find_all(‘div’, attrs={“class”: “bd doc-reader”}):

plist.extend(div.get_text().split(‘\n’))

plist = [c.replace(’ ', ‘’) for c in plist]

plist = [c.replace(‘\x0c’, ‘’) for c in plist]

return plist

def print_docx(plist, filename):

file = open(filename + ‘.txt’, ‘w’,encoding=‘utf-8’)

for str in plist:

file.write(str)

file.write(‘\n’)

file.close()

with open(filename + ‘.txt’, encoding=‘utf-8’) as f:

docu = Document()

docu.add_paragraph(f.read())

docu.save(filename + ‘.docx’)

def parse_doc(url, folderPath):

driver = webdriver.Chrome(r’./src/chromedriver.exe’)

driver.get(url)

找到‘继续阅读’按钮 定位至还剩35页未读,继续阅读

button = driver.find_element_by_xpath(“//*[@id=‘html-reader-go-more’]/div[2]/div[1]/span”)

按下按钮

driver.execute_script(“arguments[0].click();”, button)

time.sleep(1)

source = re.compile(r’/(.*?)')

number = int(source.findall(driver.page_source)[0])

获取页码数

number = total[1]

time.sleep(1)

for i in range(2,number):

driver.find_element_by_class_name(“page-input”).clear()

driver.find_element_by_class_name(“page-input”).send_keys(f’{i}')

driver.find_element_by_class_name(“page-input”).send_keys(Keys.ENTER)

time.sleep(1)

html=etree.HTML(driver.page_source)

找到picture容器

links=html.xpath(“//div[@class=‘reader-pic-item’]/@style”)

找到图片对应的url

part = re.compile(r’url([)]')

qa=“”.join(links)

z=part.findall(qa)

if i == 2:

for m in range(3):

pic = requests.get(z[m]).content

with open(f’./照片/{m+1}.jpg’,‘wb’) as f:

f.write(pic)

f.close()

else:

pic = requests.get(z[2]).content

with open(f’./照片/{i+1}.jpg’,‘wb’) as f:

f.write(pic)

f.close()

time.sleep(1)

driver.quit()

def parse_other(url, folderPath):

driver = webdriver.Chrome(r’./src/chromedriver.exe’)

driver.get(url)

找到‘继续阅读’按钮 定位至还剩35页未读,继续阅读

button = driver.find_element_by_xpath(“//*[@id=‘html-reader-go-more’]/div[2]/div[1]/span”)

按下按钮

driver.execute_script(“arguments[0].click();”, button)

time.sleep(1)

source = re.compile(r’/(.*?)')

number = int(source.findall(driver.page_source)[0])

获取页码数

number = total[1]

time.sleep(1)

获取图片

for i in range(2,number):

driver.find_element_by_class_name(“page-input”).clear()

driver.find_element_by_class_name(“page-input”).send_keys(f’{i}')

driver.find_element_by_class_name(“page-input”).send_keys(Keys.ENTER)

time.sleep(1)

html=etree.HTML(driver.page_source)

找到picture容器"//div[@class=‘reader-pic-item’]/@style"

z=html.xpath(‘//div[@class=“ppt-image-wrap”]/img/@src’)

print(z)

保存图片

if i == 2:

for m in range(3):

最后

Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习 Python 门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

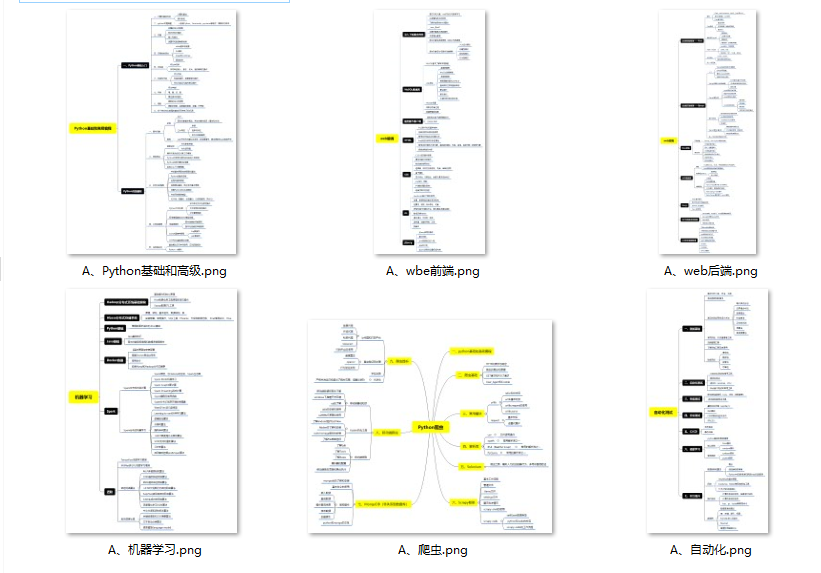

👉Python所有方向的学习路线👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉Python必备开发工具👈

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

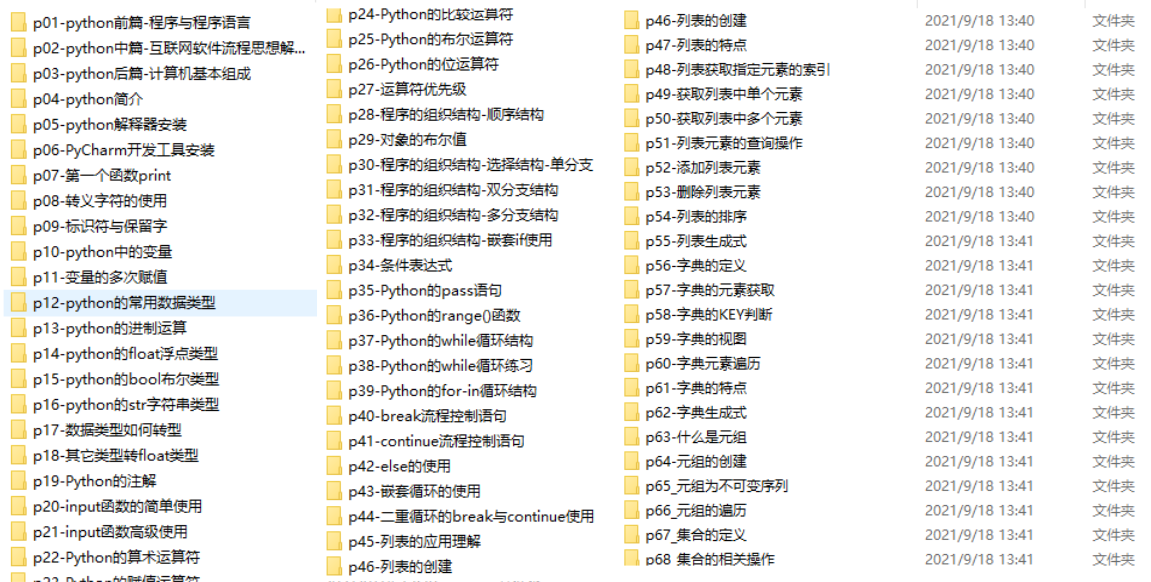

👉Python全套学习视频👈

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

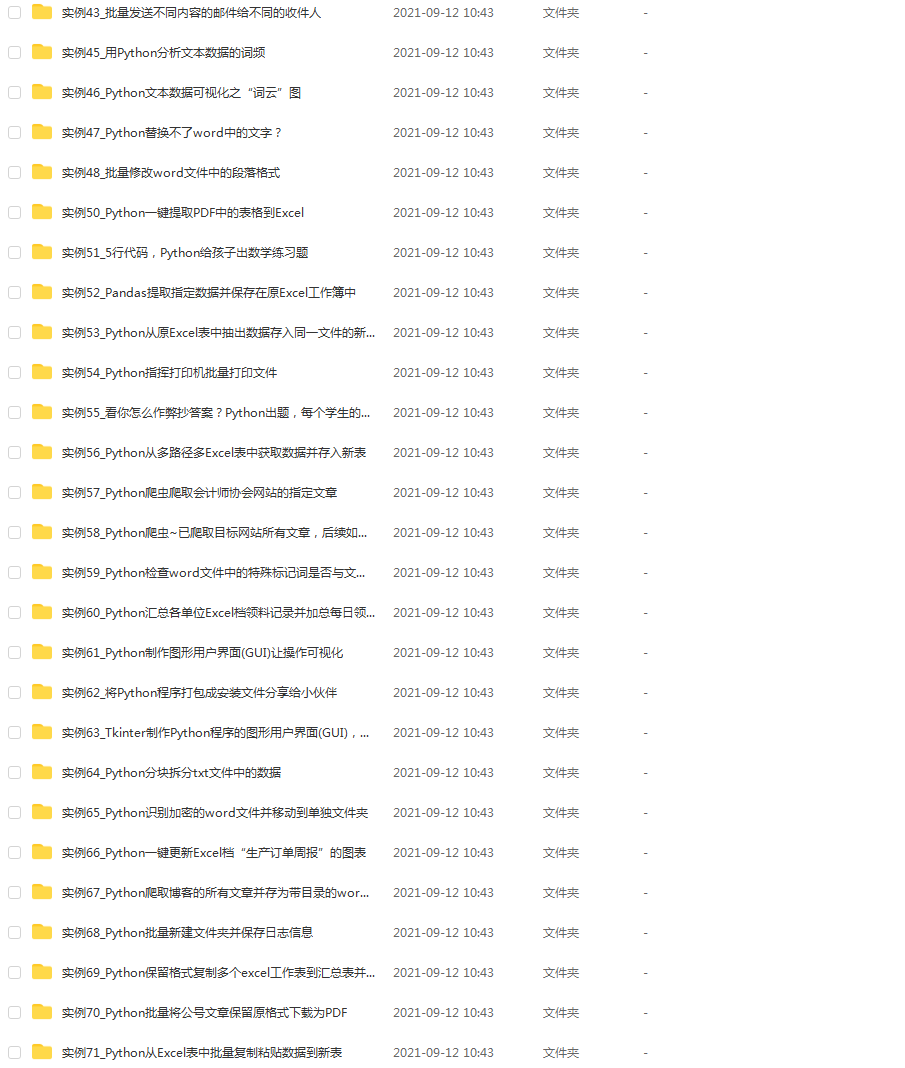

👉实战案例👈

学python就与学数学一样,是不能只看书不做题的,直接看步骤和答案会让人误以为自己全都掌握了,但是碰到生题的时候还是会一筹莫展。

因此在学习python的过程中一定要记得多动手写代码,教程只需要看一两遍即可。

👉大厂面试真题👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数初中级Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python爬虫全套学习资料》送给大家,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频

如果你觉得这些内容对你有帮助,可以添加下面V无偿领取!(备注:python)

的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数初中级Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python爬虫全套学习资料》送给大家,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频

如果你觉得这些内容对你有帮助,可以添加下面V无偿领取!(备注:python)

[外链图片转存中…(img-2PchwTD2-1711037572044)]

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?