随着网络的迅速发展,互联网成为大量信息的载体,如何有效的利用这些信息成为巨大的挑战。区别于搜索引擎,定向抓取相关网页资源的网络爬虫应用而生,可以根据既定的抓取目标有效的选择网络上需要的网页资源和信息。如用户想获得知乎豆瓣等网站上的主要数据进行分析,如用户想获得某个论坛贴吧内的所有图片等,把这项工作交给网络爬虫,可以大大提高人们的效率。

Jsoup是一个 Java 的开源HTML解析器,可直接解析某个URL地址、HTML文本内容。它提供了一套非常方便的API,可通过DOM,CSS以及类似于jQuery的操作方法来取出和操作数据。

Jsoup主要有以下功能:

-

从一个字符串、文件或者一个 URL 中解析HTML

-

提供一系列方法对HTML进行数据抽取

-

对HTML元素、属性、文本进行操作

-

消除不受信任的HTML (来防止XSS攻击)

简言之,安卓跟web爬虫基本上没什么区别,都是通过请求获得响应。Android返回的是json格式的字符串,web返回的是页面,通过Jsoup我们可以方便的对网页的数据进行操作。

首先在Jsoup官网 https://jsoup.org/download 下载对应的jar包

并将下载的jar包导入项目的依赖库中

implementation ‘org.jsoup:jsoup:1.12.1’

然后在gradle中添加以下依赖

compile ‘org.jsoup:jsoup:1.12.1’

由于jsoup需要获取网络数据,所以需要添加网络权限

1.从一个字符串、文件或者一个 URL 中解析HTML

String html = “

- “

Parsed HTML into a doc.

”;

Document doc = Jsoup.parse(html);

当对象是URL时,使用 Jsoup.connect(String url)方法:

Document doc = Jsoup.connect(“http://example.com/”).get();

String title = doc.title();

当URL请求为post方式而不是get方式时

Document doc = Jsoup.connect(“http://example.com”)

.data(“query”, “Java”)

.userAgent(“Mozilla”)

.cookie(“auth”, “token”)

.timeout(3000)

.post();

2.提供一系列方法对HTML进行数据抽取

Jsoup将HTML解析成Document后,可以使用一系列DOM方法:

File input = new File(“/tmp/input.html”);

Document doc = Jsoup.parse(input, “UTF-8”, “http://example.com/”);

Element content = doc.getElementById(“content”);

Elements links = content.getElementsByTag(“a”);

for (Element link : links) {

String linkHref = link.attr(“href”);

String linkText = link.text();

}

Elements这个对象提供了一系列类似于DOM的方法来查找元素,抽取并处理其中的数据。具体如下:

查找元素

getElementById(String id)

getElementsByTag(String tag)

getElementsByClass(String className)

getElementsByAttribute(String key) (and related methods)

Element siblings: siblingElements(), firstElementSibling(), lastElementSibling(); nextElementSibling(), previousElementSibling()

Graph: parent(), children(), child(int index)

操作HTML和文本

append(String html), prepend(String html)

appendText(String text), prependText(String text)

appendElement(String tagName), prependElement(String tagName)

html(String value)

3.对HTML元素、属性、文本进行操作

在你解析一个Document之后可能想修改其中的某些属性值,然后再保存到磁盘或都输出到前台页面。

可以利用Jsoup进行如下操作:

Element div = doc.select(“div”).first(); //

div.html(“

lorem ipsum

”); //lorem ipsum

div.prepend(“

First

”);//在div前添加html内容div.append(“

Last

”);//在div之后添加html内容// 添完后的结果:

First

lorem ipsum

Last

Element span = doc.select(“span”).first(); // One

span.wrap(“

- ”);

// 添完后的结果:

- One

-

这是对一个HTML中内容元素的设置

关于Jsoup的更多使用细节可以参考中文文档:https://www.open-open.com/jsoup/

1.根据想要获取的资源,利用浏览器自带的审查元素功能(F12)获得想要的资源

以知乎为例如下可见网页的各个元素的名称:

2.利用Jsoup进行解析:

这里主要的分析网站是https://www.zhihu.com/topic/19550874/hot

因为Android的网络操作需要在不能在主线程运行,可以使用Thread+Handler或者AsyncTask获取数据并在主界面刷新UI。

其次是数据的展示,将数据放在listView中即可,如果要加入下拉刷新或者上滑加载则需要额外的工作。

以下是关键代码:

/private class SearchTask extends AsyncTask<Void, Void, Boolean>

{

Context context;

Map.Entry<String,String> topicURL;

public SearchTask(Context context,Map.Entry<String,String> topicURL)

{

this.context = context;

this.topicURL = topicURL;

}

@Override

protected Boolean doInBackground(Void… voids)

{

Connection conn= Jsoup.connect(“https://www.zhihu.com/topic/” + topicURL.getValue()+ “/hot”);

Document doc;

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

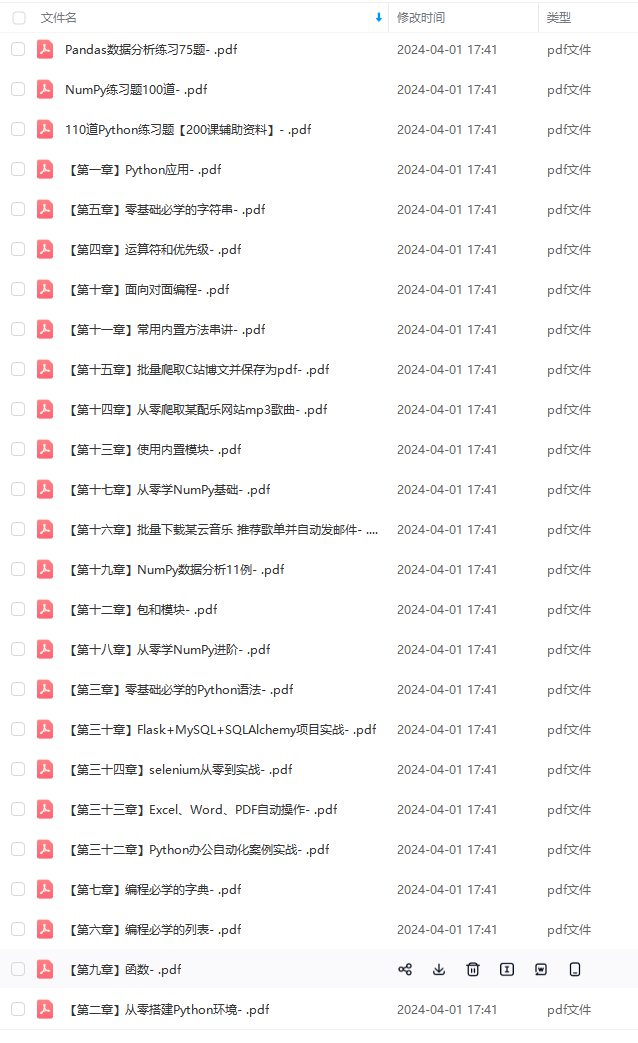

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注:Python)

😕/img-blog.csdnimg.cn/img_convert/6c361282296f86381401c05e862fe4e9.png)

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注:Python)

1132

1132

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?