在《

我们学习了kNN算法的流程,并且在jupyter notebook上手动实现了代码,并且在外部也进行了封装。最后我们学习了sklearn中的kNN算法。

在品尝到“实践”的胜利果实后,我们不仅有一个疑问:

思想如此朴素的kNN算法,它的效果怎样样?预测准确率高不高?在机器学习中如何评价一个算法的好坏?我们在机器学习过程中还有需要注意那些其他的问题呢?

在这篇文章中,我们使用训练数据集和测试数据集来判断模型的好坏,给出并实现accurcay这一分类问题常用指标。最后我们再探寻超参数的选择对模型的影响。

0x01 判断模型好坏

1.1 训练数据集&测试数据集

我们已经兴致勃勃的训练好了一个模型了,问题是:它能直接拿到生产环境正确使用么?

- 我们现在只是能拿到一个预测结果,还不知道这个模型效果怎么样?

预测的结果准不准

- 如果拿到真实环境,其实是没有label的,我们怎么对结果进行验证呢?

实际上,从训练好模型到真实使用,还差着远呢。我们要做的第一步就是:

将原始数据中的一部分作为训练数据、另一部分作为测试数据。使用训练数据训练模型,再用测试数据看好坏。即通过测试数据判断模型好坏,然后再不断对模型进行修改。

1.2 鸢尾花train_test

鸢尾花数据集是UCI数据库中常用数据集。我们可以直接加载数据集,并尝试对数据进行一定探索:

import numpy as npfrom sklearn import datasetsimport matplotlib.pyplot as plt

iris = datasets.load_iris()

X = iris.data

y = iris.target

X.shape

输出:(150, 4)

X.shape

输出:(150,)

我们下面进行训练数据集、测试数据集的拆分工作(train_test_split)。

一般情况下我们按照0.8:0.2的比例进行拆分,但是有时候我们不能简单地把前n个数据作为训练数据集,后n个作为测试数据集。

比如下面这个,是有顺序的。

为了解决这个问题,我们可以将数据集打乱,做一个shuffle操作。但是本数据集的特征和标签是分开的,也就是说我们分别乱序后,原来的对应关系就不存在了。有两种方法解决这一问题:

-

将X和y合并为同一个矩阵,然后对矩阵进行shuffle,之后再分解

-

对y的索引进行乱序,根据索引确定与X的对应关系,最后再通过乱序的索引进行赋值

第一种方法

首先看第一种方法:

方法1# 使用concatenate函数进行拼接,因为传入的矩阵必须具有相同的形状。因此需要对label进行reshape操作,reshape(-1,1)表示行数自动计算,1列。axis=1表示纵向拼接。tempConcat = np.concatenate((X, y.reshape(-1,1)), axis=1)# 拼接好后,直接进行乱序操作np.random.shuffle(tempConcat)# 再将shuffle后的数组使用split方法拆分shuffle_X,shuffle_y = np.split(tempConcat, [4], axis=1)# 设置划分的比例test_ratio = 0.2test_size = int(len(X) * test_ratio)

X_train = shuffle_X[test_size:]

y_train = shuffle_y[test_size:]

X_test = shuffle_X[:test_size]

y_test = shuffle_y[:test_size]

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)

输出:(120, 4)

(30, 4)

(120, 1)

(30, 1)

第二种方法

方法2# 将x长度这么多的数,返回一个新的打乱顺序的数组,注意,数组中的元素不是原来的数据,而是混乱的索引shuffle_index = np.random.permutation(len(X))# 指定测试数据的比例test_ratio = 0.2test_size = int(len(X) * test_ratio)

test_index = shuffle_index[:test_size]

train_index = shuffle_index[test_size:]

X_train = X[train_index]

X_test = X[test_index]

y_train = y[train_index]

y_test = y[test_index]

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)

输出:(120, 4)

(30, 4)

(120,)

(30,)

1.3 编写自己的train_test_split

下面我们将编写自己的train_test_split,并封装成方法。

编写

还记得我们的github上的工程吗?https://github.com/japsonzbz/ML_Algorithms

编写一个自己的train_test_split方法。这个方法可以放到model——selection.py下。因为分割训练集和测试集合,可以帮助我们测试机器学习性能,能够帮助我们更好地选择模型。

import numpy as npdef train_test_split(X, y, test_ratio=0.2, seed=None):

“”“将矩阵X和标签y按照test_ration分割成X_train, X_test, y_train, y_test”“”

assert X.shape[0] == y.shape[0], \ “the size of X must be equal to the size of y”

assert 0.0 <= test_ratio <= 1.0, \ “test_train must be valid”

if seed: # 是否使用随机种子,使随机结果相同,方便debug

np.random.seed(seed) # permutation(n) 可直接生成一个随机排列的数组,含有n个元素

shuffle_index = np.random.permutation(len(X))

test_size = int(len(X) * test_ratio)

test_index = shuffle_index[:test_size]

train_index = shuffle_index[test_size:]

X_train = X[train_index]

X_test = X[test_index]

y_train = y[train_index]

y_test = y[test_index] return X_train, X_test, y_train, y_test

调用

from myAlgorithm.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y)

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)

输出:(120, 4)

(30, 4)

(120,)

(30,)

再得到分割好的训练数据集和测试数据集以后,下面将其应用于kNN算法中。

我们可以简单验证一下,X_train, y_train通过fit传入算法,然后对X_test做预测,得到y_predict。

然后我们可以直观地把y_predict和实际的结果y_test进行一个比较,看有多少个元素一样。当然我们也可以自己计算一下正确率

from myAlgorithm.kNN import kNNClassifier

my_kNNClassifier = kNNClassifier(k=3)

my_kNNClassifier.fit(X_train, y_train)

y_predict = my_kNNClassifier.predict(X_test)

y_predict

y_test# 两个向量的比较,返回一个布尔型向量,对这个布尔向量(faluse=1,true=0)sum,sum(y_predict == y_test)29sum(y_predict == y_test)/len(y_test)0.96666666666667

1.4 sklearn中的train_test_split

我们自己写的train_test_split其实也是在模仿sklearn风格,更多的时候我们可以直接调用。

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=666)

print(X_train.shape)

print(X_test.shape)

print(y_train.shape)

print(y_test.shape)

输出:(112, 4)

(38, 4)

(112,)

(38,)

0x02 分类准确度accuracy

在划分出测试数据集后,我们就可以验证其模型准确率了。在这了引出一个非常简单且常用的概念:accuracy(分类准确度)

accuracy_score:函数计算分类准确率,返回被正确分类的样本比例(default)或者是数量(normalize=False)

因accuracy定义清洗、计算方法简单,因此经常被使用。但是它在某些情况下并不一定是评估模型的最佳工具。精度(查准率)和召回率(查全率)等指标对衡量机器学习的模型性能在某些场合下要比accuracy更好。

当然这些指标在后续都会介绍。在这里我们就使用分类精准度,并将其作用于一个新的手写数字识别分类算法上。

2.1 数据探索

import numpy as npimport matplotlibimport matplotlib.pyplot as pltfrom sklearn import datasetsfrom sklearn.model_selection import train_test_splitfrom sklearn.neighbors import KNeighborsClassifier# 手写数字数据集,封装好的对象,可以理解为一个字段digits = datasets.load_digits()# 可以使用keys()方法来看一下数据集的详情digits.keys()

输出:dict_keys([‘data’, ‘target’, ‘target_names’, ‘images’, ‘DESCR’])

我们可以看一下sklearn.datasets提供的数据描述:

5620张图片,每张图片有64个像素点即特征(8*8整数像素图像),每个特征的取值范围是1~16(sklearn中的不全),对应的分类结果是10个数字print(digits.DESCR)

下面我们根据datasets提供的方法,进行简单的数据探索。

特征的shapeX = digits.data

X.shape

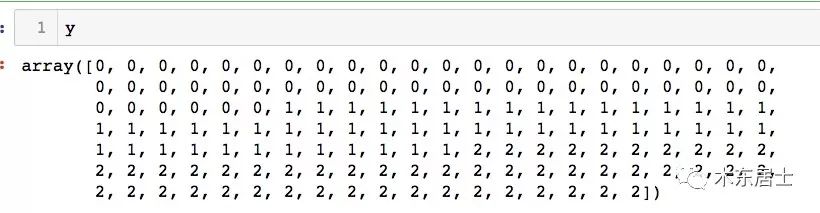

(1797, 64)# 标签的shapey = digits.target

y.shape

(1797, )# 标签分类digits.target_names

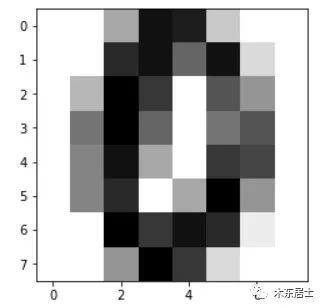

array([0, 1, 2, 3, 4, 5, 6, 7, 8, 9])# 去除某一个具体的数据,查看其特征以及标签信息some_digit = X[666]

some_digit

array([ 0., 0., 5., 15., 14., 3., 0., 0., 0., 0., 13., 15., 9.,15., 2., 0., 0., 4., 16., 12., 0., 10., 6., 0., 0., 8.,16., 9., 0., 8., 10., 0., 0., 7., 15., 5., 0., 12., 11.,0., 0., 7., 13., 0., 5., 16., 6., 0., 0., 0., 16., 12.,15., 13., 1., 0., 0., 0., 6., 16., 12., 2., 0., 0.])

y[666]0# 也可以这条数据进行可视化some_digmit_image = some_digit.reshape(8, 8)

plt.imshow(some_digmit_image, cmap = matplotlib.cm.binary)

plt.show()

2.2 自己实现分类准确度

在分类任务结束后,我们就可以计算分类算法的准确率。其逻辑如下:

X_train, X_test, y_train, y_test = train_test_split(X, y)

knn_clf = KNeighborsClassifier(n_neighbors=3)

knn_clf.fit(X_train, y_train)

y_predict = knn_clf.predict(X_test)# 比对y_predict和y_test结果是否一致sum(y_predict == y_test) / len(y_test)0.9955555555555555

下面我们在我们自己的工程文件中添加一个metrics.py,用来度量性能的各种指标。

import numpy as npfrom math import sqrtdef accuracy_score(y_true, y_predict):

“”“计算y_true和y_predict之间的准确率”“”

assert y_true.shape[0] != y_predict.shape[0], \ “the size of y_true must be equal to the size of y_predict”

return sum(y_true == y_predict) / len(y_true)

这样以后就不用一遍遍地写逻辑了,直接调用我们写好的封装函数。我们再调用一下:

from myAlgorithm.metrics import accuracy_score

accuracy_score(y_test, y_predict)

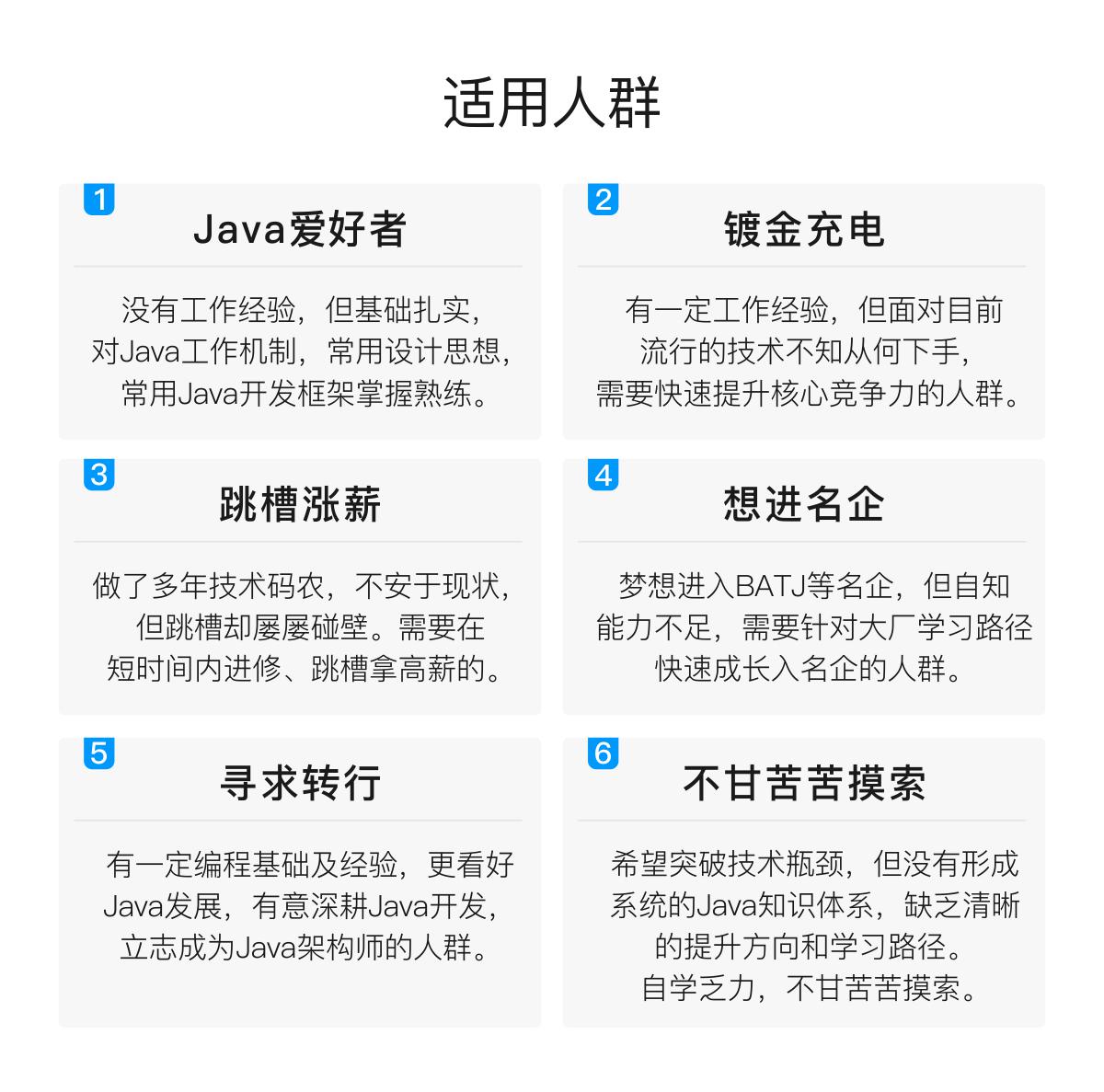

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Java工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Java开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Java开发知识点,真正体系化!

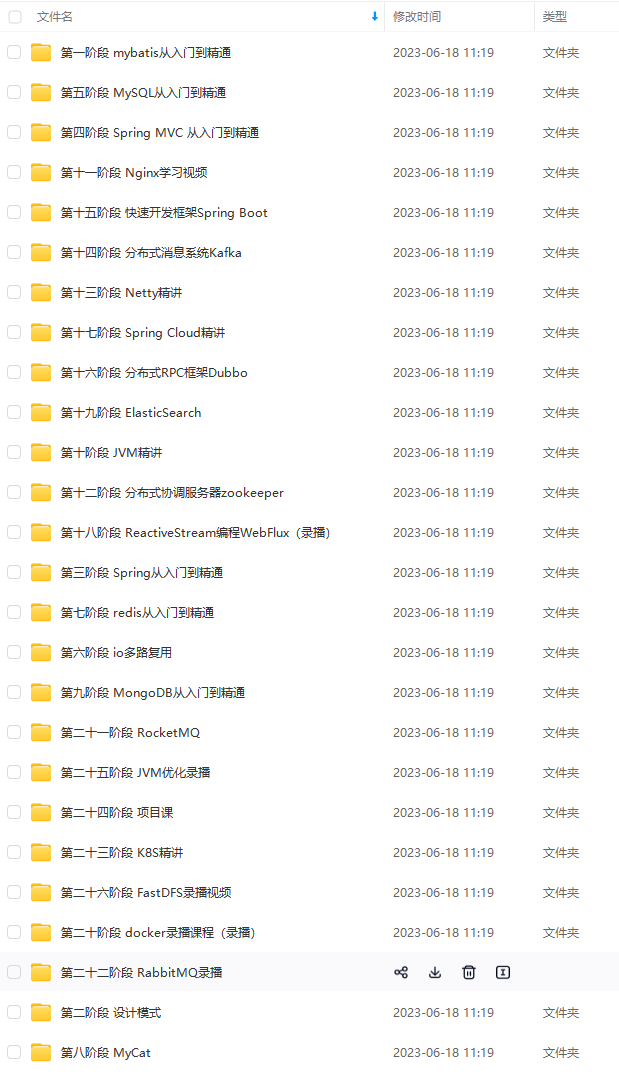

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注Java获取)

总结

无论是哪家公司,都很重视高并发高可用的技术,重视基础,重视JVM。面试是一个双向选择的过程,不要抱着畏惧的心态去面试,不利于自己的发挥。同时看中的应该不止薪资,还要看你是不是真的喜欢这家公司,是不是能真的得到锻炼。其实我写了这么多,只是我自己的总结,并不一定适用于所有人,相信经过一些面试,大家都会有这些感触。

最后我整理了一些面试真题资料,技术知识点剖析教程,还有和广大同仁一起交流学习共同进步,还有一些职业经验的分享。

《一线大厂Java面试题解析+核心总结学习笔记+最新讲解视频+实战项目源码》,点击传送门即可获取!

项目、讲解视频,并且会持续更新!**

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注Java获取)

总结

无论是哪家公司,都很重视高并发高可用的技术,重视基础,重视JVM。面试是一个双向选择的过程,不要抱着畏惧的心态去面试,不利于自己的发挥。同时看中的应该不止薪资,还要看你是不是真的喜欢这家公司,是不是能真的得到锻炼。其实我写了这么多,只是我自己的总结,并不一定适用于所有人,相信经过一些面试,大家都会有这些感触。

最后我整理了一些面试真题资料,技术知识点剖析教程,还有和广大同仁一起交流学习共同进步,还有一些职业经验的分享。

[外链图片转存中…(img-pcK9QUMg-1712476704939)]

《一线大厂Java面试题解析+核心总结学习笔记+最新讲解视频+实战项目源码》,点击传送门即可获取!

1674

1674

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?