ResNet介绍

总结:

1、残差块使得很深的网络更加容易训练,甚至可以训练一千层的网络

2、残差网络对随后的深层神经网络设计产生了深远的影响,无论是卷积类网络还是全连接类网络。

摘要

训练一个深的神经网络是一个比较困难的事情,这里使用一种残差连接的框架使得对深的神经网络的训练更加容易。提供了许多实验的证据,说明残差网络非常容易训练,并且能够得到很好的精度

结论

这篇文章中没有结论

导言

深度卷积网络可以加很多层,把网络变得特别深,不同的层会得到不同level的一些feature,比如低级的视觉特征和高级的语义的特征。

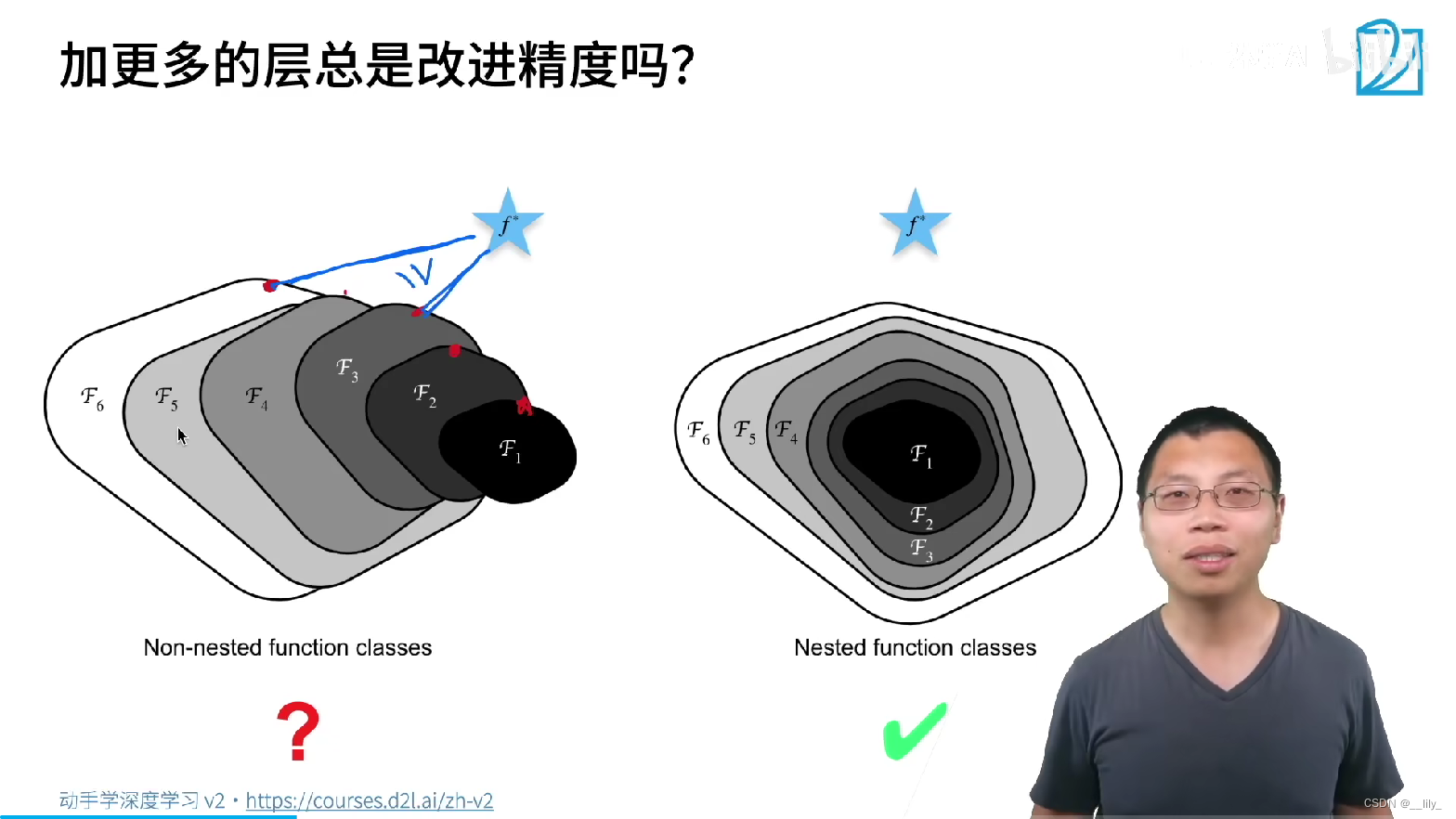

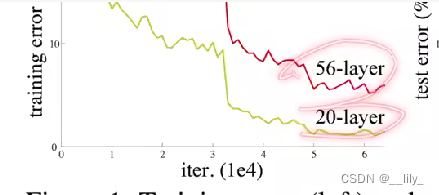

但是当网络特别深的时候会出现梯度的消失或者爆炸。一些做法就是在初始化的时候做处理,还有是在中间进行normalization,这两种方法是能够训练(收敛)的,虽然说能够收敛,但是当网络变深的时候精度是会变差的

但是这并不是过拟合,因为过拟合是训练误差很低,但是测试误差变高。在上图中是训练误差和测试误差也变得很高

如果一个较浅的网络效果是比较好的话,基于这个浅网络的深的网络的效果是不会变差的

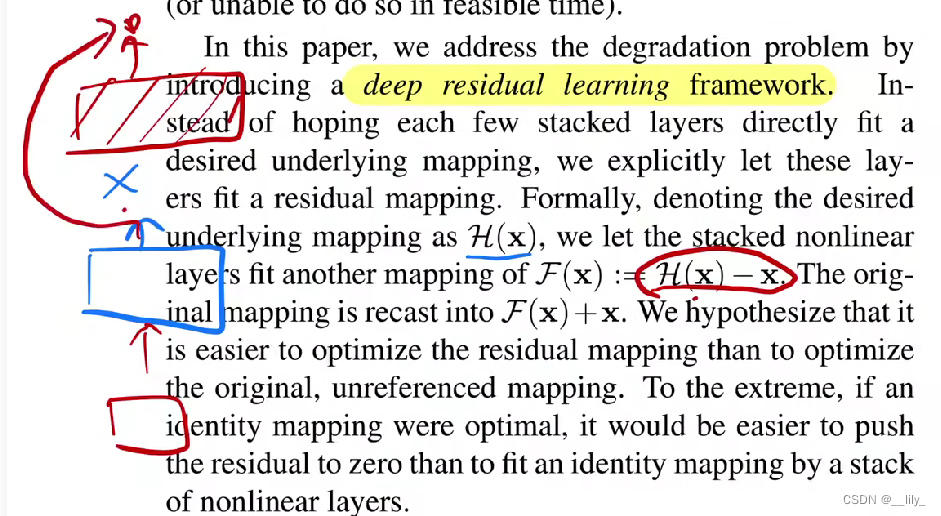

a deep residual learning framework使深的网络不会比浅的网络的效果差

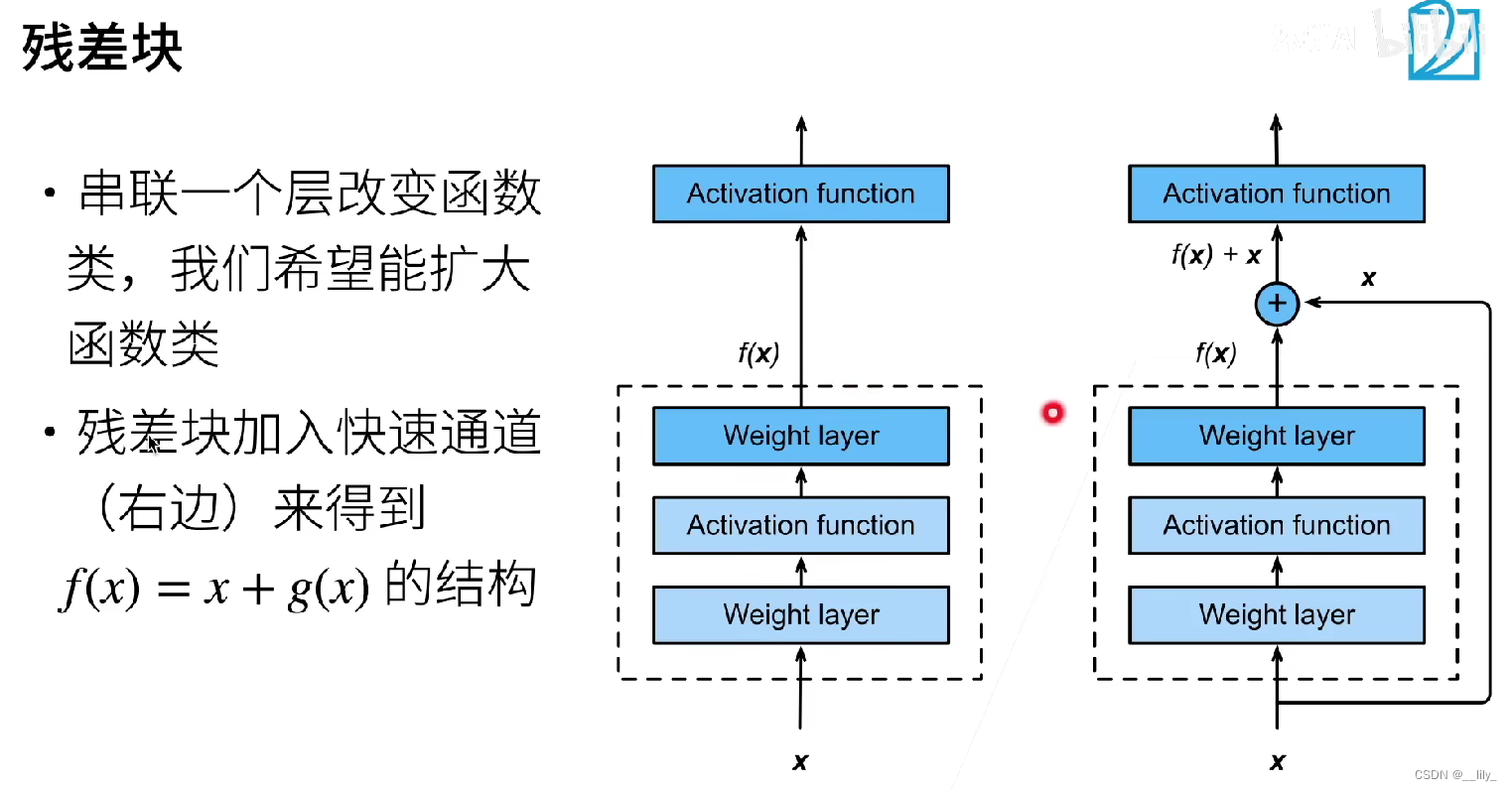

要学习的目标是H(X),浅层学习后的输出是X,再新加层,则这些新加层学习的是F(X) = H(X)-X,即新加的层不会再去学X,而是学习学到的东西与真实的东西之间的残差

shortcut connections :不会增加任何参数,也不会增加模型复杂度,也不会让计算变高

做了实验进行对比:如果加了residual,容易优化,比”plain“的模型效果更好,并且加了residual的模型在越深的网络中效果越好

导言部分是摘要部分的扩充,读到这部分可以了解大部分的内容

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?