pyecharts模块;

以及一些Python自带的模块。

环境搭建

安装Python并添加到环境变量,pip安装需要的相关模块即可。

数据爬取

任务:

根据给定的关键字,爬取与该关键字相关的所有图书数据。

实现:

以关键字为python为例,我们要爬取的图书数据的网页页面是这样子的:

更多Python相关视频、资料加群778463939免费获取

其中,网页的链接格式为:

http://search.dangdang.com/?key={keyword}&act=input&page_index={page_index}’

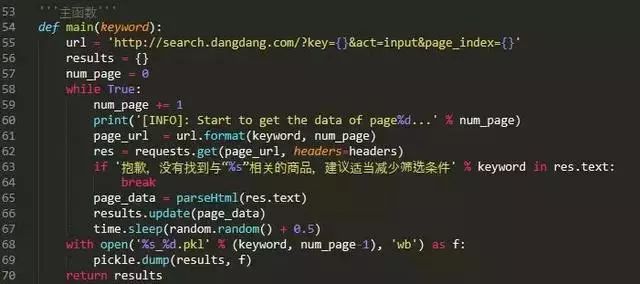

因此请求所有与关键词相关的链接:

然后利用BeautifulSoup分别解析返回的网页数据,提取我们自己需要的数据即可:

运行效果:

在cmd窗口运行"ddSpider.py"文件即可。

效果如下:

数据分析

好的,现在就简单地可视化分析一波我们爬取到的61页python相关的图书数据吧~

让我们先看看图书的价格分布吧:

有没有人想知道最贵的一本python相关的书的单价是多少呀?答案是:28390RMB

书名是:

Python in Computers Programming

QAQ买不起买不起。

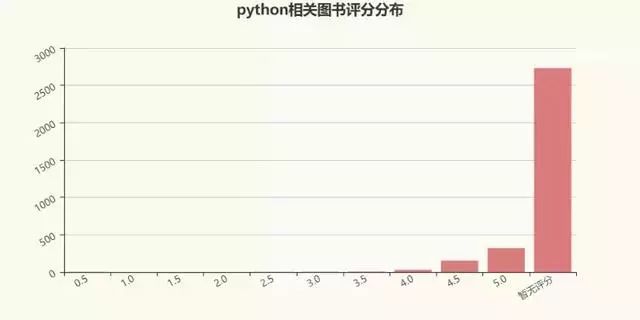

再来看看图书的评分分布呗:

看来大多数python相关的图书都没人买过诶~大概是买不起吧T_T。

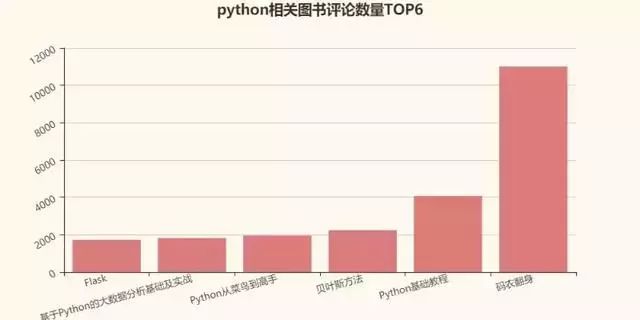

再来评论数量?

那么评论数量TOP6的图书有哪些呢?

老规矩,画两个词云作结吧,把所有python相关的图书的简介做成词云如何?

现在能在网上找到很多很多的学习资源,有免费的也有收费的,当我拿到1套比较全的学习资源之前,我并没着急去看第1节,我而是去审视这套资源是否值得学习,有时候也会去问一些学长的意见,如果可以之后,我会对这套学习资源做1个学习计划,我的学习计划主要包括规划图和学习进度表。

分享给大家这份我薅到的免费视频资料,质量还不错,大家可以跟着学习

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

1407

1407

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?