文末有福利领取哦~

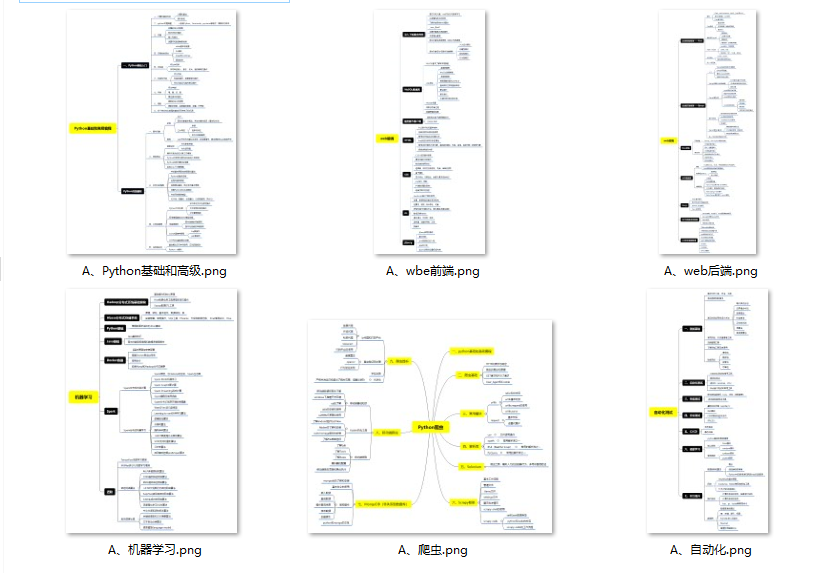

👉一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉二、Python必备开发工具

👉三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

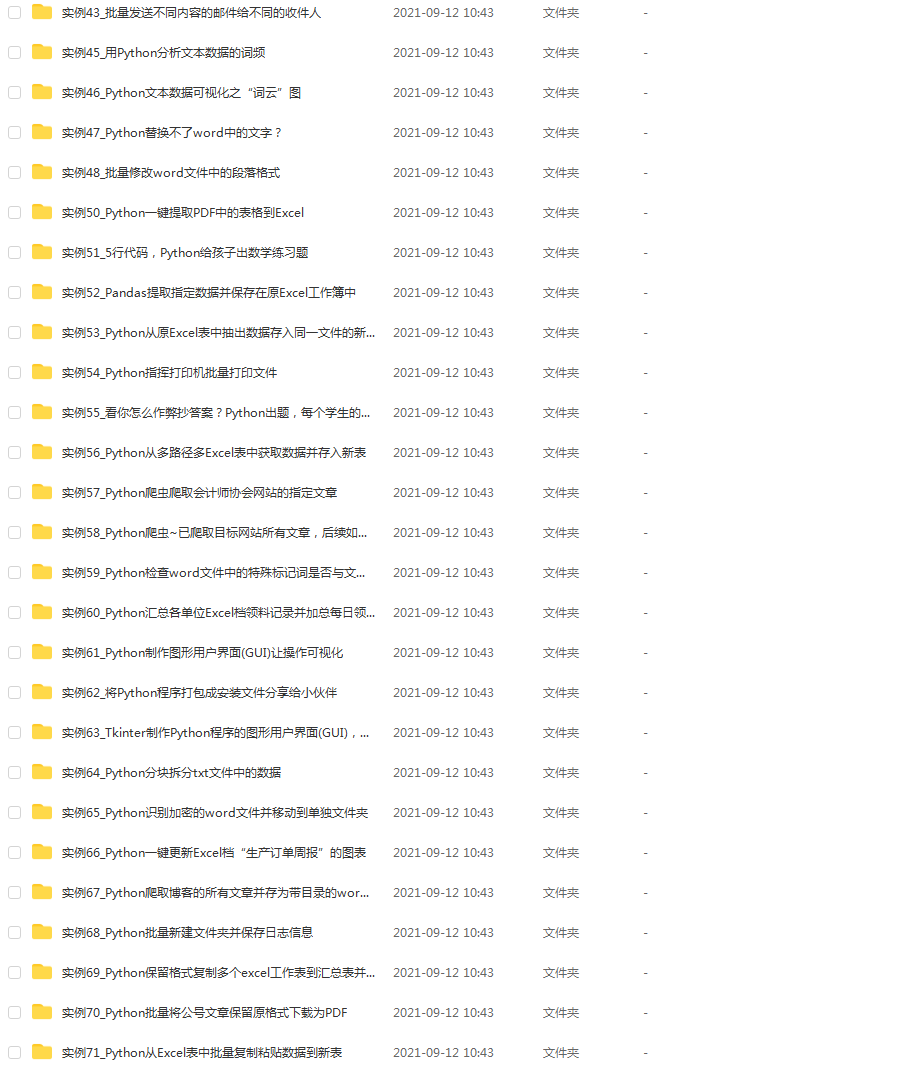

👉 四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(文末领读者福利)

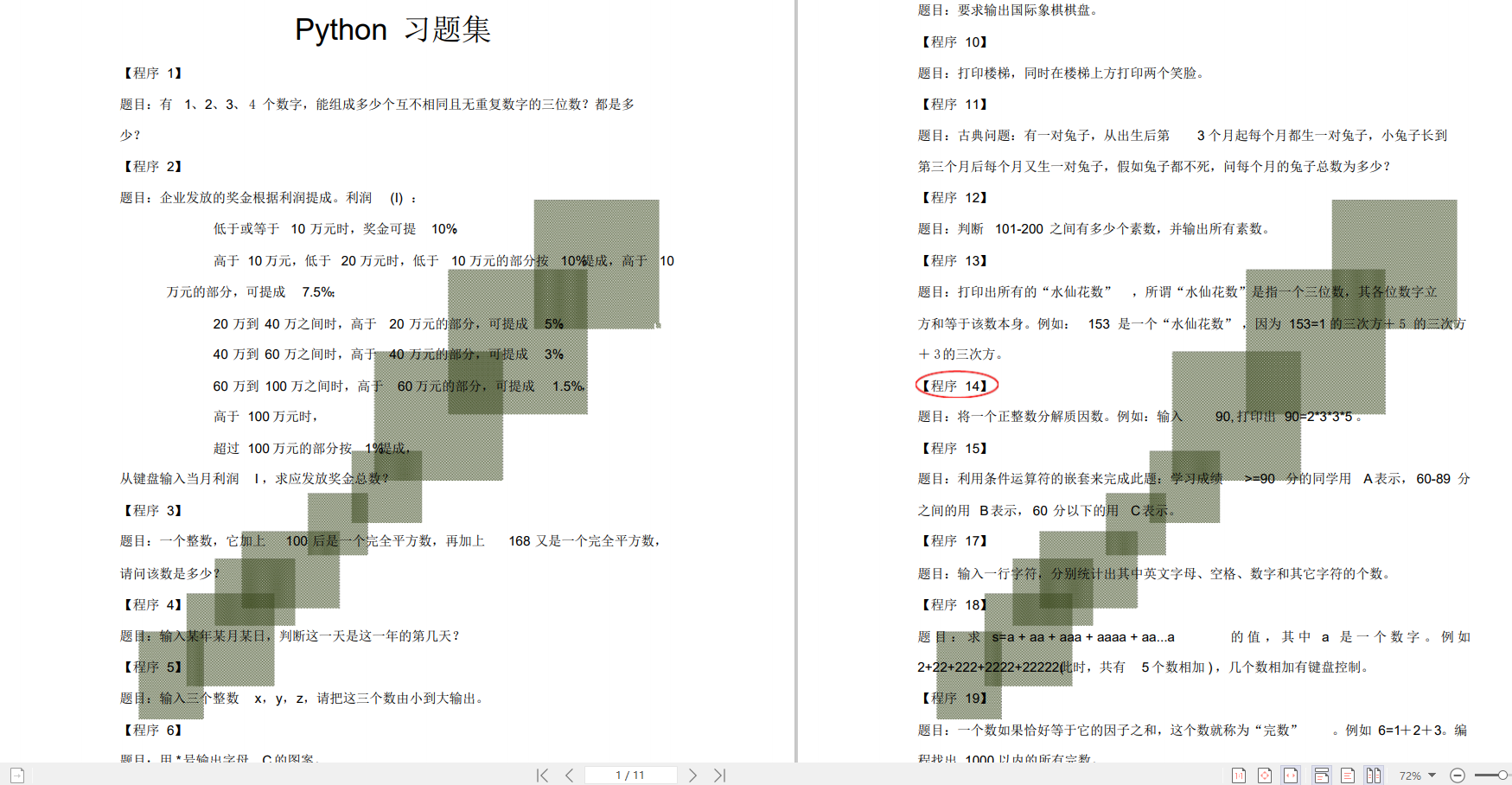

👉五、Python练习题

检查学习结果。

👉六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

👉因篇幅有限,仅展示部分资料,这份完整版的Python全套学习资料已经上传

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

html_content = self.downloader.download(new_url)

new_urls, new_data = self.parser.parse(new_url, html_content)

self.urls.add_new_urls(new_urls)

self.outputer.collect_data(new_data)

if count == 10:

break

count = count + 1

except:

print('craw failed')

self.outputer.output_html()

if name == ‘__main__’:

#设置爬虫入口

root_url = ‘http://baike.baidu.com/view/21087.htm’

#开始时间

print(‘开始计时…’)

start_time = datetime.datetime.now()

obj_spider = Spider_Main()

obj_spider.craw(root_url)

#结束时间

end_time = datetime.datetime.now()

print(‘总用时:%ds’% (end_time - start_time).seconds)

### 四、URL管理器

class UrlManager(object):

def __init__(self):

self.new_urls = set()

self.old_urls = set()

def add\_new\_url(self, url):

if url is None:

return

if url not in self.new_urls and url not in self.old_urls:

self.new_urls.add(url)

def add\_new\_urls(self, urls):

if urls is None or len(urls) == 0:

return

for url in urls:

self.add_new_url(url)

def has\_new\_url(self):

return len(self.new_urls) != 0

def get\_new\_url(self):

new_url = self.new_urls.pop()

self.old_urls.add(new_url)

return new_url

### 五、网页下载器

import urllib

import urllib.request

class HtmlDownloader(object):

def download(self, url):

if url is None:

return None

#伪装成浏览器访问,直接访问的话csdn会拒绝

user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

headers = {'User-Agent':user_agent}

#构造请求

req = urllib.request.Request(url,headers=headers)

#访问页面

response = urllib.request.urlopen(req)

#python3中urllib.read返回的是bytes对象,不是string,得把它转换成string对象,用bytes.decode方法

return response.read().decode()

### 六、网页解析器

import re

import urllib

from urllib.parse import urlparse

from bs4 import BeautifulSoup

class HtmlParser(object):

def \_get\_new\_urls(self, page_url, soup):

new_urls = set()

#/view/123.htm

links = soup.find_all('a', href=re.compile(r'/item/.\*?'))

for link in links:

new_url = link['href']

new_full_url = urllib.parse.urljoin(page_url, new_url)

new_urls.add(new_full_url)

return new_urls

#获取标题、摘要

def \_get\_new\_data(self, page_url, soup):

#新建字典

res_data = {}

#url

res_data['url'] = page_url

#<dd class="lemmaWgt-lemmaTitle-title"><h1>Python</h1>获得标题标签

title_node = soup.find('dd', class_="lemmaWgt-lemmaTitle-title").find('h1')

print(str(title_node.get_text()))

res_data['title'] = str(title_node.get_text())

#<div class="lemma-summary" label-module="lemmaSummary">

summary_node = soup.find('div', class_="lemma-summary")

res_data['summary'] = summary_node.get_text()

return res_data

def parse(self, page_url, html_content):

if page_url is None or html_content is None:

return None

soup = BeautifulSoup(html_content, 'html.parser', from_encoding='utf-8')

new_urls = self._get_new_urls(page_url, soup)

new_data = self._get_new_data(page_url, soup)

return new_urls, new_data

### 七、网页输出器

class HtmlOutputer(object):

def \_\_init\_\_(self):

self.datas = []

def collect\_data(self, data):

if data is None:

return

self.datas.append(data )

def output\_html(self):

fout = open('maya.html', 'w', encoding='utf-8')

fout.write("<head><meta http-equiv='content-type' content='text/html;charset=utf-8'></head>")

fout.write('<html>')

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

1103

1103

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?