网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

replicas: 2

selector:

app: kubia

template:

metadata:

labels:

app: kubia

spec:

containers:

- name: kubia

image: luksa/kubia

ports:

- containerPort: 8080

EOF

create

kubectl create -f kubia-rc.yaml

查看

[root@nginx test]# kubectl get po

NAME READY STATUS RESTARTS AGE

kubia-66tvd 1/1 Running 0 2m31s

kubia-v8dvv 1/1 Running 0 2m31s

2. 创建服务

cat > kubia-svc.yaml << EOF

apiVersion: v1

kind: Service

metadata:

name: kubia

spec:

ports:

- port: 80

targetPort: 8080

selector:

app: kubia

EOF

create

kubectl create -f kubia-svc.yaml

查看

[root@nginx test]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.43.0.1 443/TCP 16d

kubia ClusterIP 10.43.165.39 80/TCP 46s

##### 5 为什么服务ip无法ping通 ?

我们发现服务curl是可以,但是无法ping通。

[root@k8s-node01 ~]# curl 10.43.165.39

You’ve hit kubia-66tvd

[root@k8s-node01 ~]# ping 10.43.165.39

PING 10.43.165.39 (10.43.165.39) 56(84) bytes of data.

^C

— 10.43.165.39 ping statistics —

2 packets transmitted, 0 received, 100% packet loss, time 999ms

有的时候ping不通我们就认为出问题了,其实没有。这是因为集群ip是虚拟ip, 并且只有在与服务端口结合时才有意义。 所以ping不通是正常的。

##### 6 测试与分析

分配给该服务的ip是10.43.165.39, 但这是cluster-ip,也就是集群ip, 只能在集群内部可以访问。 也就是集群节点上或其他的pod可以访问。 是不是这样呢? 测试一下

1. ssh到集群的一个节点上

[root@k8s-node01 ~]# curl 10.43.165.39

You’ve hit kubia-66tvd

服务的cluster ip 在集群内部,节点可与其通信

2. 在pod中执行命令, 执行成功则说明连接

测试多次, 每次并不是同一个pod

[root@nginx test]# kubectl exec kubia-vs2kl – curl -s http://10.43.165.39

You’ve hit kubia-vs2kl

[root@nginx test]# kubectl exec kubia-vs2kl – curl -s http://10.43.165.39

You’ve hit kubia-l9w94

[root@nginx test]# kubectl exec kubia-vs2kl – curl -s http://10.43.165.39

You’ve hit kubia-vs2kl

>

> – 表示kubectl 命令结束,之后为在pod中执行的命令

>

>

>

上图展示了事件发生的顺序

1. 在一个pod中执行命令,这个命令是发送http请求

2. pod向服务的ip发送请求

3. 由于这个服务是代理pod的,转发请求到其中一个pod上

4. 在pod2中处理请求,并返回带有pod名称的相应

5. 请求结果在主机上打印

上述某一个过程出问题,都会使得上述命令失败,所以可用来测试集群网络。

##### 7 同一个服务暴露多个端口

服务可以暴露一个端口,也可以多个端口。比如http监听8080端口,https监听8443端口。 多个端口需要指定名称, 没有设置名称的端口会在describe 时显示<unset> , 如果pod中的端口也是命令的,svc中targetport可以使用其名称吗,这样在更换pod端口号的时候也不用修改服务了,因为其是根据名称匹配的。

cat > kubia-svc.yaml << EOF

apiVersion: v1

kind: Service

metadata:

name: kubia

spec:

ports:

- name: http

port: 80

targetPort: 8080 - name: https

port: 443

targetPort: 8443

selector:

app: kubia

EOF

##### 8 发现服务

创建服务后, 我们可以通过单一稳定的ip访问到pod, 不管pod如何变化都不影响。 但是在某个服务创建之后新建的pod如何知道服务的ip呢? 难道手动查询吗? 不需要。

k8s为客户端提供了发现服务的ip和端口的方式——环境变量, 在pod开始运行的时候,k8s会初始化一系列的环境变量指向现在存在的服务。如下:

[root@nginx test]# kubectl exec kubia-vs2kl – env

PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

HOSTNAME=kubia-vs2kl

KUBERNETES_PORT=tcp://10.43.0.1:443

KUBIA_PORT_80_TCP_PORT=80

KUBIA_PORT=tcp://10.43.165.39:80

KUBIA_PORT_80_TCP=tcp://10.43.165.39:80

KUBIA_PORT_80_TCP_PROTO=tcp

KUBIA_PORT_80_TCP_ADDR=10.43.165.39

KUBERNETES_SERVICE_PORT=443

KUBERNETES_PORT_443_TCP_ADDR=10.43.0.1

KUBIA_SERVICE_HOST=10.43.165.39

KUBIA_SERVICE_PORT=80

NPM_CONFIG_LOGLEVEL=info

NODE_VERSION=7.9.0

YARN_VERSION=0.22.0

HOME=/root

##### 9 DNS

环境变量是获取ip和端口的一种方式,也可以通过DNS获取。

[root@nginx test]# kubectl get po -n kube-system

NAME READY STATUS RESTARTS AGE

canal-l58m7 2/2 Running 2 16d

canal-s92dx 2/2 Running 3 16d

coredns-7c5566588d-rhdtx 1/1 Running 1 16d

coredns-7c5566588d-tp55c 1/1 Running 1 16d

coredns-autoscaler-65bfc8d47d-4mdt5 1/1 Running 1 16d

metrics-server-6b55c64f86-zlz4l 1/1 Running 2 16d

kube-system空间中pod有coredns,这表明在运行dns服务,在集群中的其他pod都被配置成使用作为为DNS , 运行在pod上的进程DNS 查询都会被k8s自身的DNS服务器响应,该服务器知道系统中运行的所有服务。pod中的spec中的dnspolicy值决定是否使用DNS服务器。

##### 10 endpoints

我们也希望k8s将服务暴露到外部,在此之前要先介绍一下endpoint, 它是介于pod和svc之间的资源。 就是暴露服务要转发的pod的ip地址和端口的列表。

查看endpoints

[root@nginx test]# kubectl get endpoints kubia

NAME ENDPOINTS AGE

kubia 10.42.0.10:8443,10.42.1.10:8443,10.42.1.9:8443 + 3 more… 79m

查看pod IP

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

kubia-66tvd 1/1 Running 0 161m 10.42.0.10 81.68.101.212

kubia-l9w94 1/1 Running 0 128m 10.42.1.9 81.68.229.215

kubia-vs2kl 1/1 Running 0 125m 10.42.1.10 81.68.229.215

从svc中也可以看到, endpoints就是待转发pod的IP与端口的集合

[root@nginx test]# kubectl describe svc kubia

Name: kubia

Namespace: default

Labels:

Annotations:

Selector: app=kubia

Type: ClusterIP

IP Families:

IP: 10.43.7.83

IPs:

Port: http 80/TCP

TargetPort: 8080/TCP

Endpoints: 10.42.0.10:8080,10.42.1.10:8080,10.42.1.9:8080

Port: https 443/TCP

TargetPort: 8443/TCP

Endpoints: 10.42.0.10:8443,10.42.1.10:8443,10.42.1.9:8443

Session Affinity: None

Events:

这表明服务是利用标签匹配pod, 然后建立endpoints, 将请求转发的endpoints中的一个ip: port上。 所以有的时候服务连接失败,需要查看endpoints是否存在正确。

了解到这一层之后,我们也可以不使用标签匹配pod,手动为服务建立endpoints,只要新建一个endpoints资源,使其与服务的名称相同即可。

>

> endpoints本身就是一个资源,而不是service的一部分。

>

>

>

##### 11 将服务暴露给外部

目前为止,讨论了集群内部pod的使用。有时我们需要将服务暴露给集群之外的网络,比如前端web服务器。有几种方式可以在外部访问服务。

1. nodeport型的服务,在集群的每个节点上打开一个端口,因此叫nodeport,将该端口山的流量重定向到服务上,使用集群ip:port既可以访问。

2. loadbalance型服务,是nodeport的一种扩展, 这使得服务可以通过一个专用的负载均衡器来访问。

3. ingress资源,这是一个完全不同的机制,通过一个ip地址公开多个服务——它运行在http层,因此可以比第四层的服务提供更多的资源。

第一种: 使用nodeport暴露服务到外部

cat > kubia-svc-nodeport.yaml << EOF

apiVersion: v1

kind: Service

metadata:

name: kubia-nodeport

spec:

type: NodePort

ports:

- port: 80

targetPort: 8080

nodePort: 30123

selector:

app: kubia

EOF

创建

kubectl create -f kubia-svc-nodeport.yaml

查看

[root@nginx test]# kubectl get svc kubia-nodeport -o wide

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

kubia-nodeport NodePort 10.43.254.206 80:30123/TCP 38m app=kubia

测试, 本地shell连接

[C:~]$ curl http://81.68.229.215:30123

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 23 0 23 0 0 23 0 --:–:-- --:–:-- --:–:-- 1533

You’ve hit kubia-l9w94

这表明外部网络可以连接到集群内部的服务,用浏览器也可以打开。

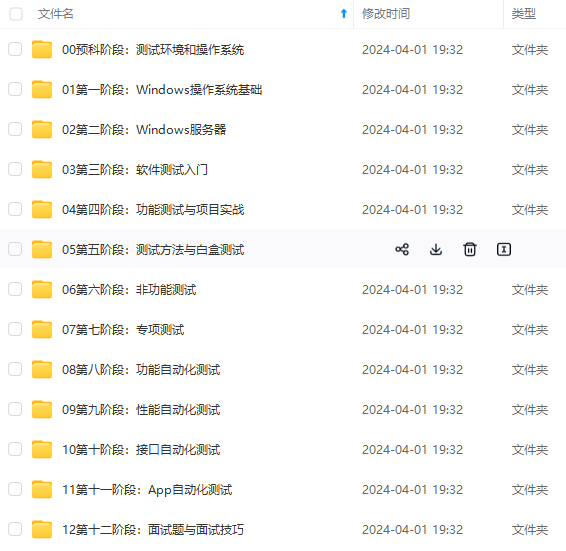

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

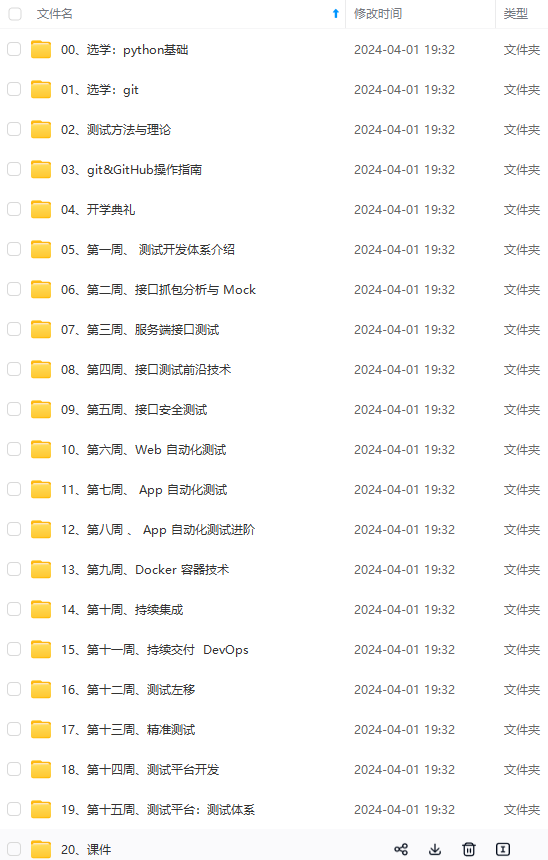

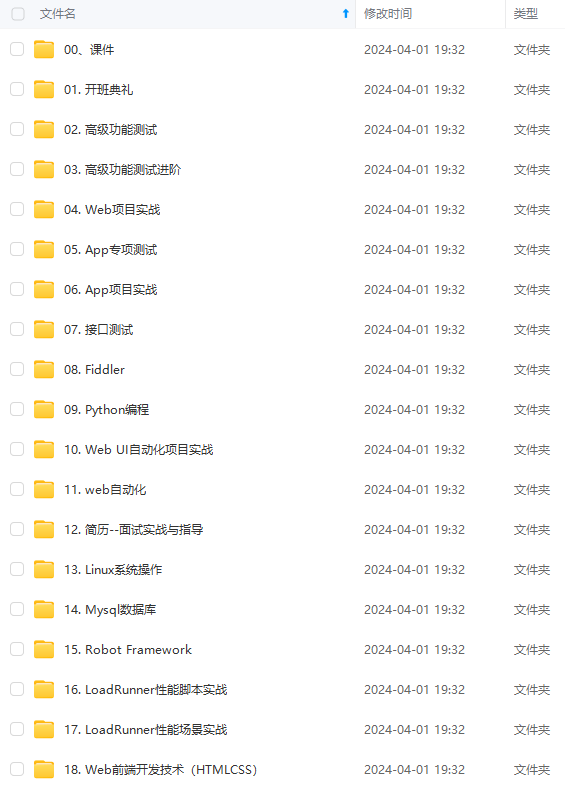

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

15391123990)]

[外链图片转存中…(img-svkOkcis-1715391123991)]

[外链图片转存中…(img-fykYTsbw-1715391123992)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上软件测试知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

3487

3487

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?