//main()方法中调用

downloal(“/data.txt”,“D:/大数据/文件”); //下载

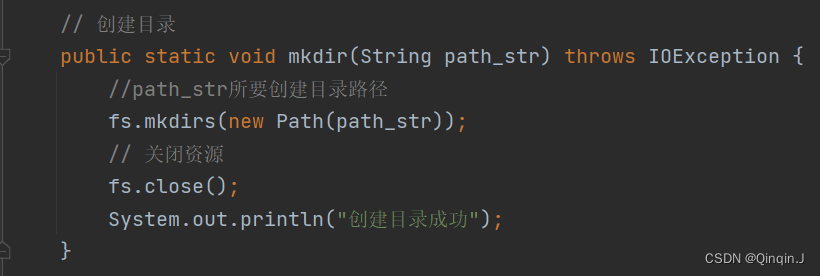

五、创建目录

// 创建目录

public static void mkdir(String path_str) throws IOException {

//path_str所要创建目录路径

fs.mkdirs(new Path(path_str));

// 关闭资源

fs.close();

System.out.println(“创建目录成功”);

}

//main()方法中调用

mkdir(“/input”); //创建目录

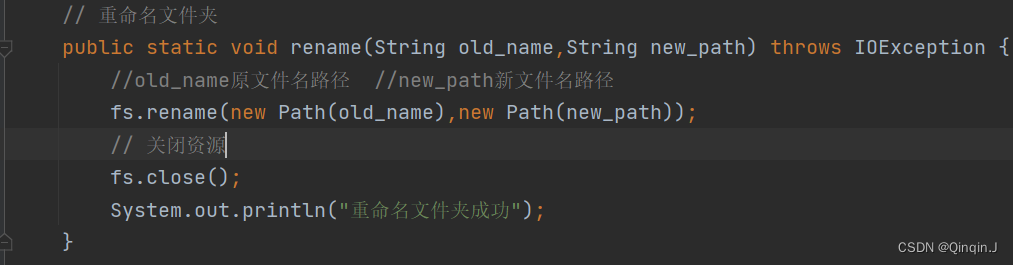

六、重命名文件或文件夹

// 重命名文件夹

public static void rename(String old_name,String new_path) throws IOException {

//old_name原文件名路径 //new_path新文件名路径

fs.rename(new Path(old_name),new Path(new_path));

fs.close();

System.out.println(“重命名文件夹成功”);

}

//main()方法中调用

rename(“/aa”,“/aa2”); //重命名文件夹

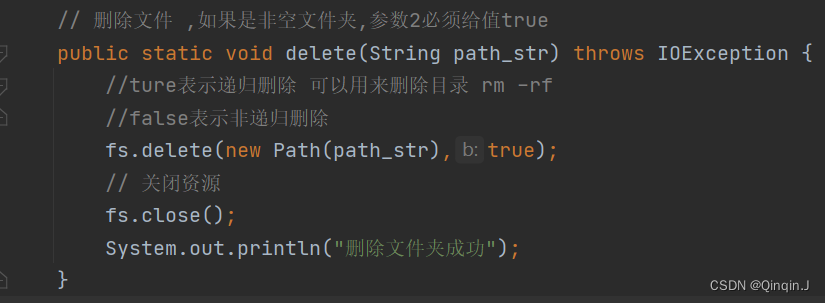

七、删除文件

// 删除文件 ,如果是非空文件夹,参数2必须给值true

public static void delete(String path_str) throws IOException {

//ture表示递归删除 可以用来删除目录 rm -rf

//false表示非递归删除

fs.delete(new Path(path_str),true);

// 关闭资源

fs.close();

System.out.println(“删除文件夹成功”);

}

//main()方法中调用

delete(“/aa2”); //删除文件

八、查看文件信息

1、查看文件信息

// 查看文件信息

public static void listFiles(String path_str) throws IOException {

//获取迭代器对象

RemoteIterator listFiles = fs.listFiles(new Path(path_str),true);

//遍历

while (listFiles.hasNext()){

LocatedFileStatus fileStatus = listFiles.next();

//打印当前文件名

System.out.println(fileStatus.getPath().getName());

//打印当前文件块大小

System.out.println(fileStatus.getBlockLocations());

//打印当前文件权限

System.out.println(fileStatus.getPermission());

//打印当前文件内容长度

System.out.println(fileStatus.getLen());

//获取该文件块信息(包含长度、数据块、datanode的信息)

// BlockLocation[] blockLocations = fileStatus.getBlockLocations();

// for (BlockLocation bl : blockLocations){

// System.out.println(“block-length:” + bl.getLength()+“–”+“block-offset:”+bl.getOffset());

// String[] hosts = bl.getHosts();

// for (String host : hosts){

// System.out.println(host);

// }

// }

}

System.out.println(“--------分割线---------”);

fs.close();

}

//main()方法中调用

listFiles(“/data.txt”); //查看文件信息

2、统计目录下所有文件(包括子目录)

// 1、统计目录下所有文件(包括子目录)

// 1、统计某个路径(由main方法决定哪个路径),下所有的文件数里,例如:输出:该路径下共有 3 个文件

public static void count(String path_str) throws IOException {

//获取迭代器对象

RemoteIterator listFiles = fs.listFiles(new Path(path_str),true);

//遍历

int count = 0;

while (listFiles.hasNext()) {

LocatedFileStatus fileStatus = listFiles.next();

count++;

}

System.out.println(“路径:【”+ path_str +“】下,文件数量为”+count);

fs.close();

}

//main()方法中调用

count(“/”); //统计

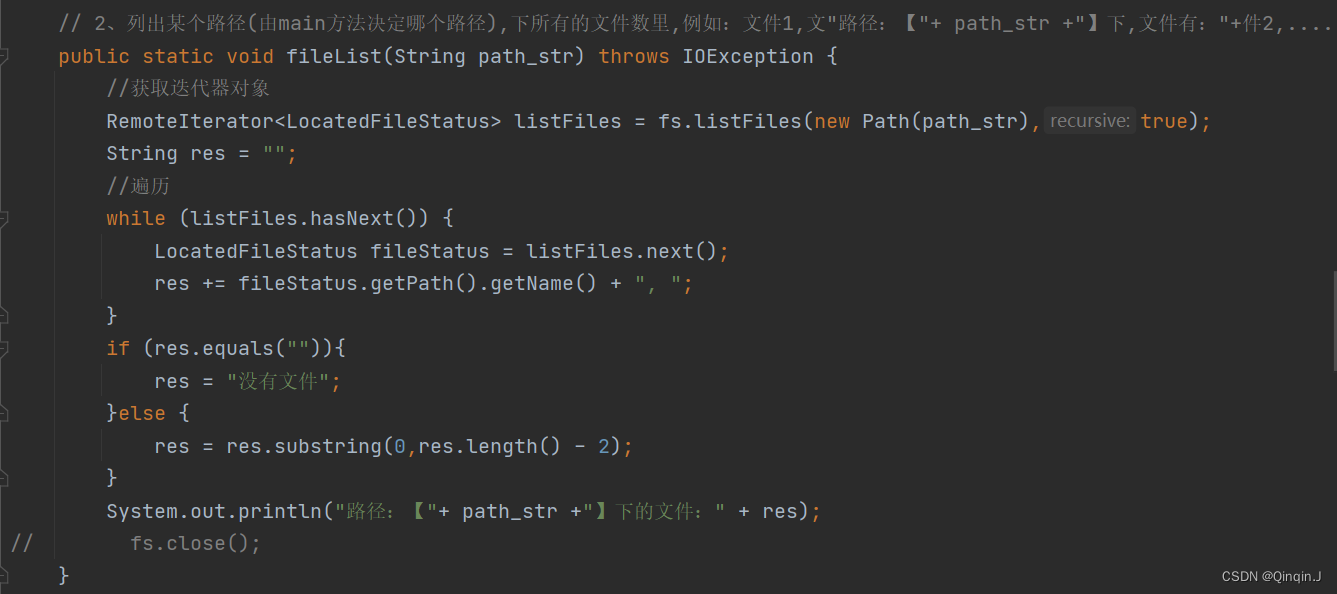

3、列出某个路径下所有的文件数里

// 2、列出某个路径(由main方法决定哪个路径),下所有的文件数里,例如:文件1,文"路径:【“+ path_str +”】下,文件有:“+件2,…

public static void fileList(String path_str) throws IOException {

//获取迭代器对象

RemoteIterator listFiles = fs.listFiles(new Path(path_str),true);

String res = “”;

//遍历

while (listFiles.hasNext()) {

LocatedFileStatus fileStatus = listFiles.next();

res += fileStatus.getPath().getName() + “, “;

}

if (res.equals(””)){

res = “没有文件”;

}else {

res = res.substring(0,res.length() - 2);

}

System.out.println(“路径:【”+ path_str +”】下的文件:" + res);

// fs.close();

}

//main()方法中调用

fileList(“/”); //查看有什么文件

fileList(“/input”); //查看有什么文件

4、查看所有文件

/* 路径【/】下共有 7 子文件

文件数量:1,文件列表:data.txt

目录数量:6,文件列表:a, exp, input, output, test, tmp*/

public static void list(String path) throws IOException {

FileStatus[] fileStatuses = fs.listStatus(new Path(path));

String res = “路径【” + path + “】下共有 " + fileStatuses.length + " 子文件”;

int file_num = 0;

String file_list = “”;

int dir_num = 0;

String dir_list = “”;

for (FileStatus fileStatus:fileStatuses){

if (fileStatus.isFile()){

file_num ++;

file_list += fileStatus.getPath().getName() + ", ";

}else {

dir_num ++;

dir_list += fileStatus.getPath().getName() + ", ";

}

}

if (file_num != 0) res += “\n\t文件数量:” + file_num + “,文件列表:” + file_list.substring(0,file_list.length()-2);

if (dir_num != 0) res += “\n\t目录数量:” + dir_num + “,文件列表:” + dir_list.substring(0,dir_list.length()-2);

System.out.println(res);

}

//main()方法中调用

list(“/”); //查看所有

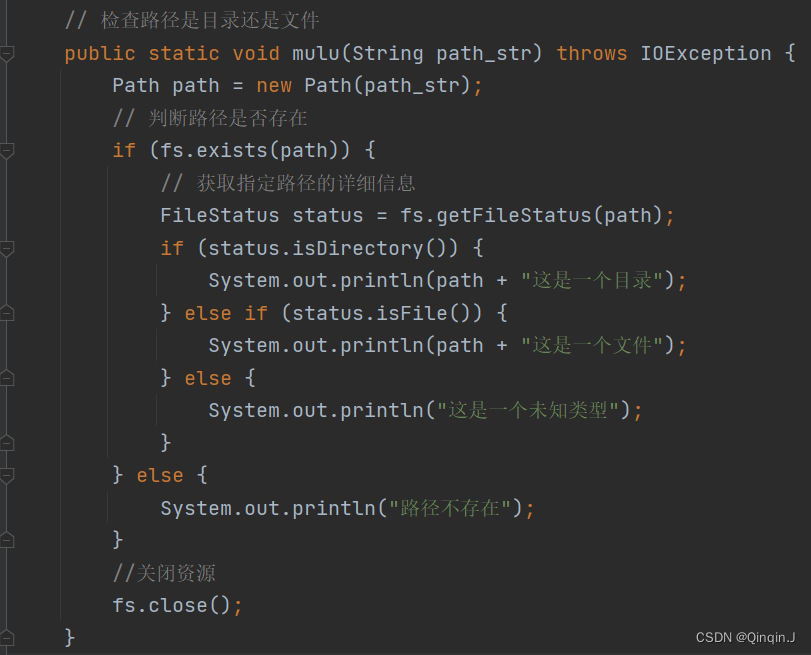

5、判断是文件还是目录

// 检查路径是目录还是文件

public static void mulu(String path_str) throws IOException {

Path path = new Path(path_str);

// 判断路径是否存在

if (fs.exists(path)) {

// 获取指定路径的详细信息

FileStatus status = fs.getFileStatus(path);

if (status.isDirectory()) {

System.out.println(path + “这是一个目录”);

} else if (status.isFile()) {

System.out.println(path + “这是一个文件”);

} else {

System.out.println(“这是一个未知类型”);

}

} else {

System.out.println(“路径不存在”);

}

//关闭资源

fs.close();

}

//main()方法中调用

mulu(“/exp/word.txt”); //检查路径是目录还是文件

九、源代码

package com.itcast.hdfsdemo;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.yarn.webapp.hamlet.Hamlet;

import sun.tracing.dtrace.DTraceProviderFactory;

import java.io.IOException;

import java.util.Arrays;

public class HDFS_CRUD {

static FileSystem fs = null;

// 完成上传功能

public static void upload(String path_str,String path_str1) throws IOException {

//上传文件到HDFS

//path_str本地文件路径 path_str1是上传到HDFS文件路径

fs.copyFromLocalFile(new Path(path_str),new Path(path_str1));

// 关闭资源

fs.close();

System.out.println(“文件上传成功”);

}

// 完成下载文件

public static void downloal(String path_str,String path_str1) throws IOException {

//从 HDFS 下载文件到本地

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

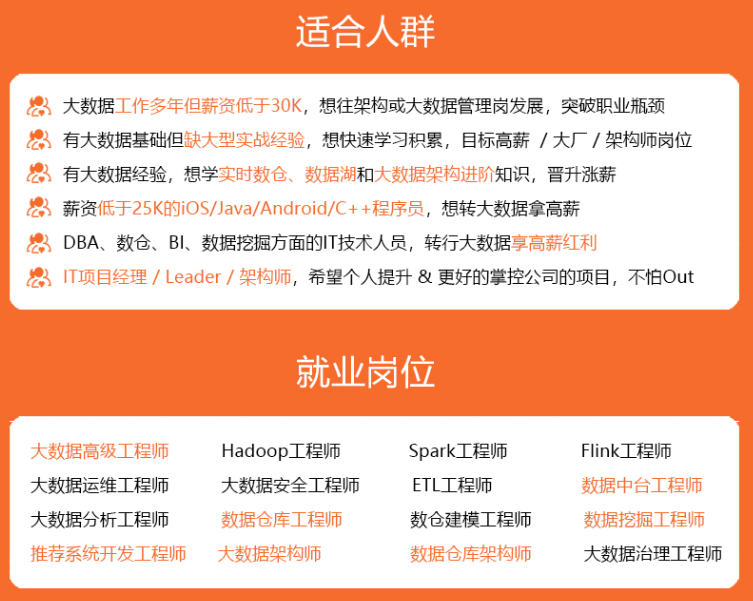

深知大多数大数据工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

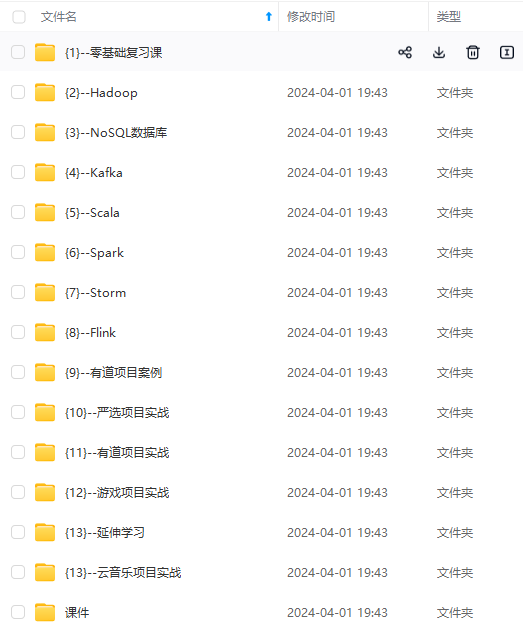

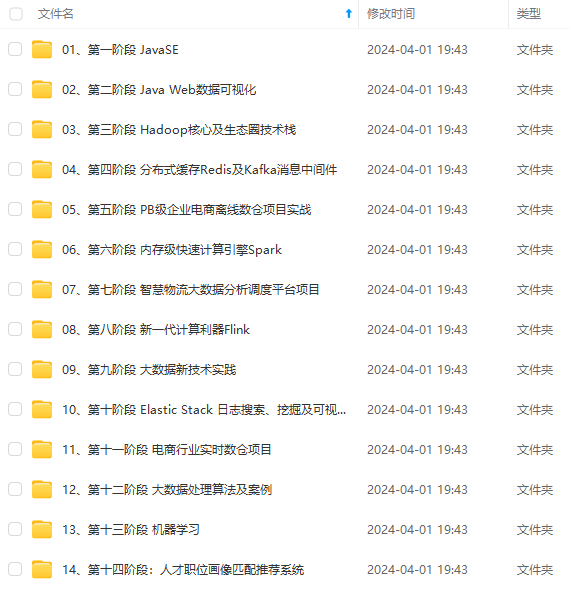

因此收集整理了一份《2024年大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上大数据开发知识点,真正体系化!

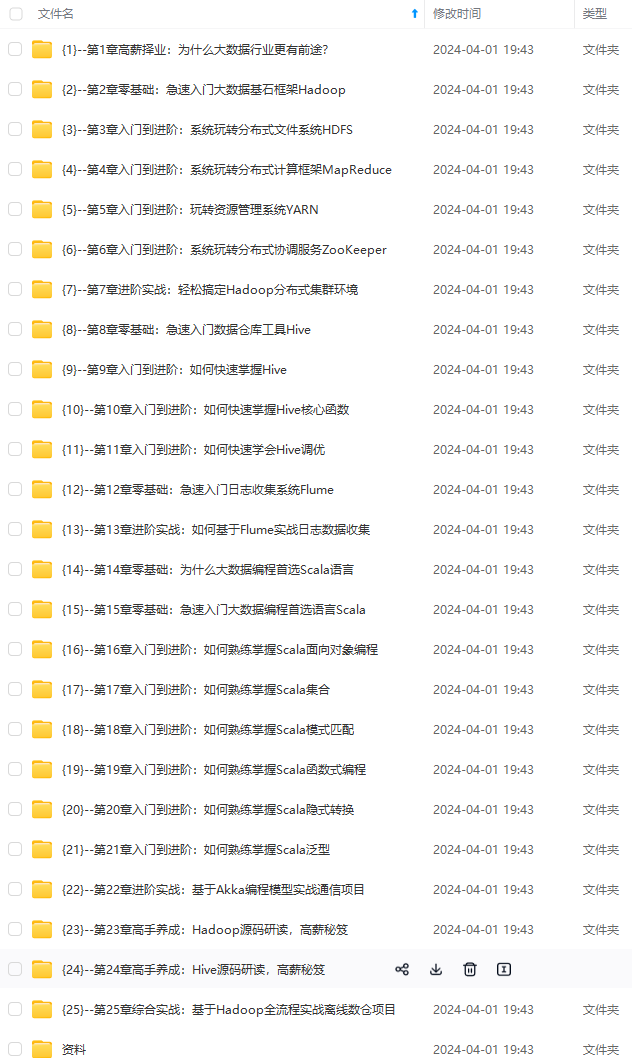

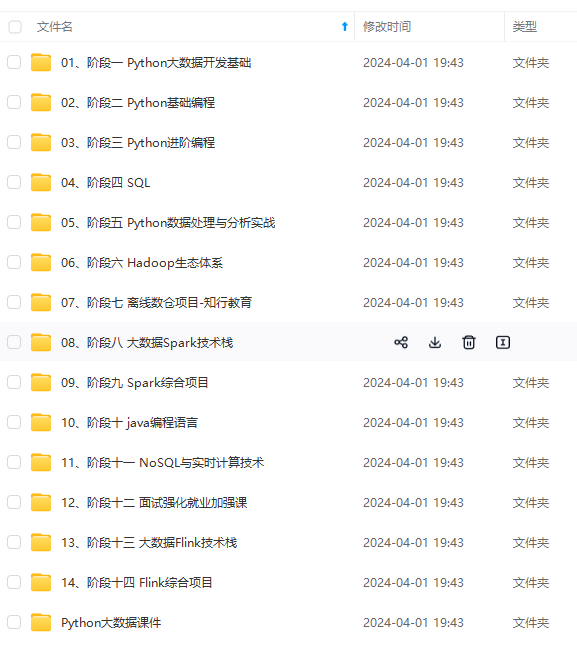

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip204888 (备注大数据获取)

img-8K7zj5AP-1712519424875)]

[外链图片转存中…(img-Wys7uccb-1712519424875)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上大数据开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip204888 (备注大数据获取)

[外链图片转存中…(img-W9QNXQ4a-1712519424876)]

215

215

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?