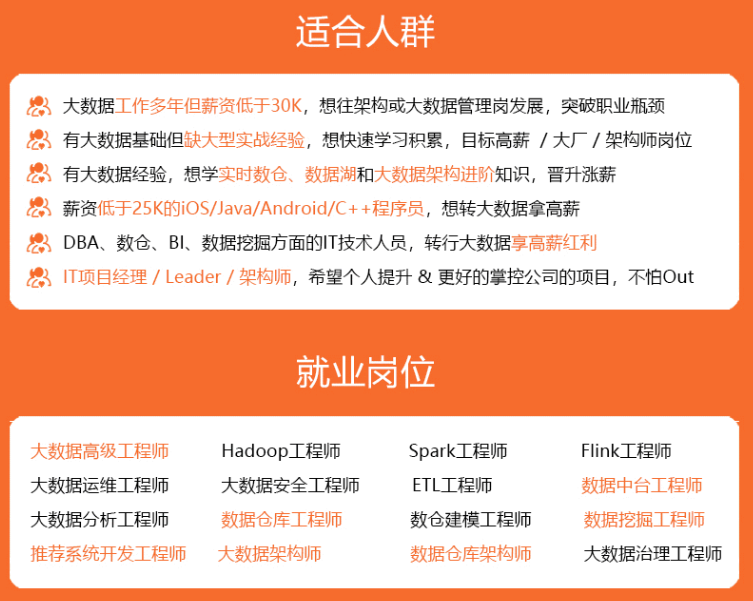

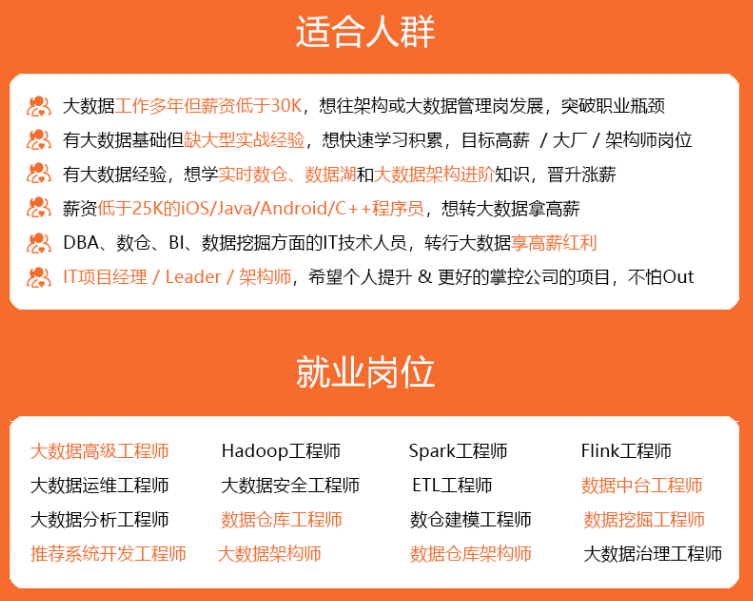

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

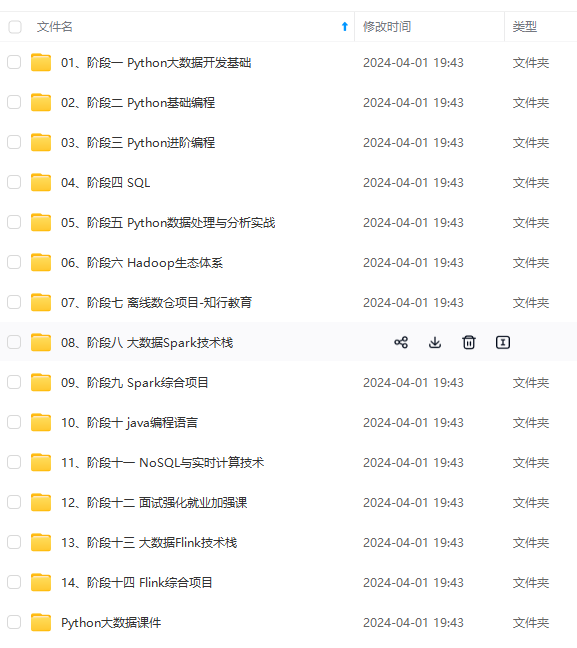

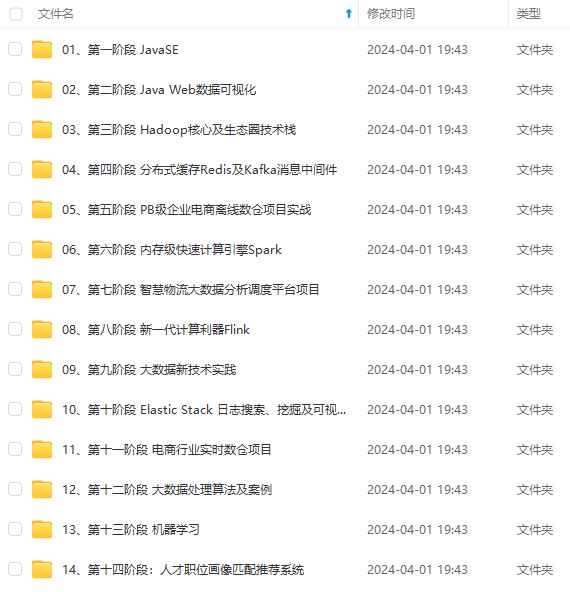

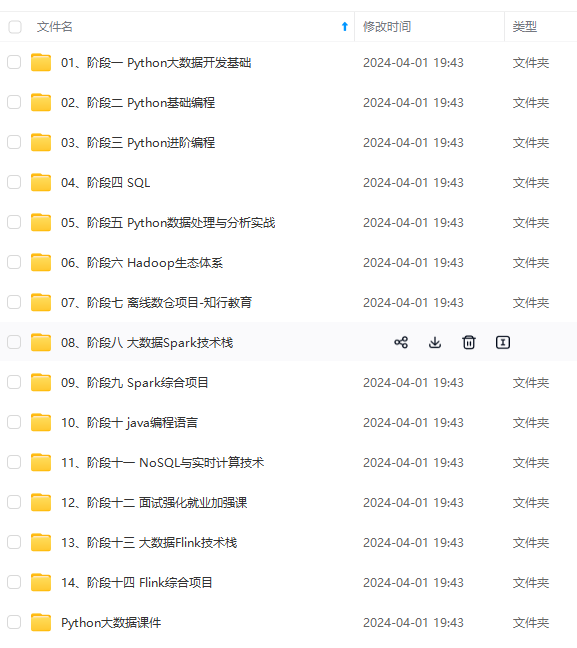

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

print(iris.data)

输出:

[[5.1 3.5 1.4 0.2]

[4.9 3. 1.4 0.2]

…

[5.9 3. 5.1 1.8]]

从输出结果可以看到,数据规格都是有「差异」的,接下来,我们对数据进行归一。

## 三、归一化处理

fit\_transform() 可以对数据进行「归一」处理

from sklearn import preprocessing

from sklearn import datasets

初始化

mm = preprocessing.MinMaxScaler()

获取数据源

iris = datasets.load_iris()

归一化处理

new_data = mm.fit_transform(iris.data)

print(new_data)

输出:

[[0.22222222 0.625 0.06779661 0.04166667]

[0.16666667 0.41666667 0.06779661 0.04166667]

…

[0.44444444 0.41666667 0.69491525 0.70833333]]

从结果可以看到,归一后的结果,数据规格都在 0~1 之间。

实际上,fit\_transform() 不只可以 “归1” ,我们自己设置归一的范围。

## 四、设置归一化范围

实例化 MinMaxScaler 时,指定 feature\_range 参数的值,可以设置归一的「范围」。

from sklearn import preprocessing

from sklearn import datasets

初始化

mm = preprocessing.MinMaxScaler(feature_range=(2,3))

获取数据源

iris = datasets.load_iris()

归一化处理

new_data = mm.fit_transform(iris.data)

print(new_data)

输出:

[[2.22222222 2.625 2.06779661 2.04166667]

[2.16666667 2.41666667 2.06779661 2.04166667]

…

[2.44444444 2.41666667 2.69491525 2.70833333]]

从输出结果可以看到,数据的范围变成 2~3 区间。

接下来,我们了解一下,MinMaxScaler 是如何进行归一的。

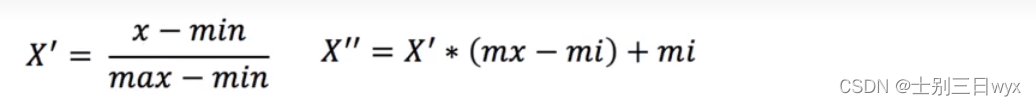

## 五、归一化原理

MinMaxScaler 根据以下「公式」进行归一:

* 以列为基准,max为一列的最大值,min为一列的最小值

* mx、mi是归一指定的区间,默认mx=1,mi=0

我们准备一些测试数据:

我们拿特征一这一列举例,第一个数是90,先带入第一个公式:X‘=(90-60)/(90-60)=1

再带入第二个公式:X"=1\*1+0=1

那么第一个数就转换成1.

知道了归一化的计算方式后,可以发现归一化存在一定的「局限性」。

归一化是根据最大值和最小值来计算的,当最大值/最小值出现异常时,比如最大值跟其他数据差的非常多,那么这种计算方式就会存在较大的误差。只适合传统精确小数据场景,对于其他场景,可以使用标准化的方式。

## 六、标准化

sklearn.preprocessing.StandardScaler()

* StandardScaler.fit\_transform( data ):接收array类型数据,返回保准化后的array类型数据。

我们将归一化的案例,用「标准化」函数再处理一遍

from sklearn import preprocessing

from sklearn import datasets

初始化

ss = preprocessing.StandardScaler()

获取数据源

iris = datasets.load_iris()

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!**

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

996

996

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?