说明:在${KAFKA_HOME}/config/server.properties中配置 delete.topic.enable 为 true,这样才能生效,删除指定的 topic主题

4.消息相关命令:

生产者发送消息:

bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test_kafka_topic

消费者消费消息:

1)(第一次消费)从头开始消费:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --from-beginning --topic test_kafka_topic

2)(实时监控消费)从尾开始消费:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test_kafka_topic --offset latest

3)(这里设置3个分区演示)从尾开始,并且指定分区:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test_kafka_topic --offset latest --partition 0

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test_kafka_topic --offset latest --partition 1

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test_kafka_topic --offset latest --partition 2

4)从尾开始,指定分区,指定偏移量:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test_kafka_topic --partition 0 --offset 100

5)指定分组消费数据:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --from-beginning --topic test_kafka_topic --group t1

6)(用于分析测试)取指定个数:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test_kafka_topic --offset latest --partition 0 --max-messages 10

5.消费者组相关命令:

查看消费者Group列表:

bin/kafka-consumer-groups.sh --bootstrap-server localhost:9092 --list

查看Group详情:

bin/kafka-consumer-groups.sh --bootstrap-server localhost:9092 --group test_group --describe

输出日志如下:

Consumer group ‘test_group’ has no active members.

TOPIC PARTITION CURRENT-OFFSET LOG-END-OFFSET LAG CONSUMER-ID HOST CLIENT-ID

test 0 5 5 0 - - -

说明:

CURRENT-OFFSET: 当前消费者群组最近提交的 offset,也就是消费者分区里读取的当前位置

LOG-END-OFFSET: 当前最高水位偏移量,也就是最近一个读取消息的偏移量,同时也是最近一个提交到集群的偏移量

LAG:消费者的 CURRENT-OFFSET 与 broker 的 LOG-END-OFFSET 之间的差距

删除Group中的Topic:

bin/kafka-consumer-groups.sh --bootstrap-server localhost:9092 --group test_group --topic test_topic --delete

删除Group:

bin/kafka-consumer-groups.sh --bootstrap-server localhost:9092 --group test_group --delete

6.其他命令:

平衡leader:

bin/kafka-preferred-replica-election.sh --bootstrap-server localhost:9092

自带测压工具:

bin/kafka-producer-perf-test.sh --topic test --num-records 100 --record-size 1 --throughput 100 --producer-props bootstrap.servers=localhost:9092

7.配置文件:

zookeeper.properties:

需要修改内容如下:

broker.id=0 #id,集群中每个机器的id一定要不一样

port=9092 #端口号

host.name=localhost #单机可直接用localhost

log.dirs=/opt/monitor/kafka/kafka_dat #日志存放路径可修改可不修改,一般建议修改,需要在kafka根目录创建kafka_data目录

zookeeper.connect=localhost:2181 #zookeeper地址和端口,单机配置部署,localhost:2181

Hive(单机):

1.前置条件:

hdoop正常启动

MySql服务正常:需要create database myhive,在hive-site.xml文件中需要指定;

mysql-connector-java.jar上传到hive的lib目录下

2.配置文件(均需要手动复制样本来创建):

conf/hive-env.sh

conf/hive-site.xml

3.启动命令:

本地shell启动:bin/hive

远程shell启动:bin/beeline

远程shell连接需要启动两个服务:bin/hiveserver2、bin/metastore

使用DataGrip等远程工具连接的原理也是连接beeline客户端,相当于执行了bin/beeline

4.停止命令:

ps -ef kill掉metastore和hiveserver2进程即可

5.Hql命令(这里只列举两个容易混淆的):

1)从hdfs文件中加载数据到hive表中(ods层数据导入常用):

load data inpath ‘/hgfs/whirehouse/car/data/catInfo.txt’ into table ods_test_table

2)从hive表中提取数据到另一张hive表中(ods下层常用):

insert overwrite table dwd_test_table partition(datatime=‘2024-01-01’)

select *

from ods_test_table

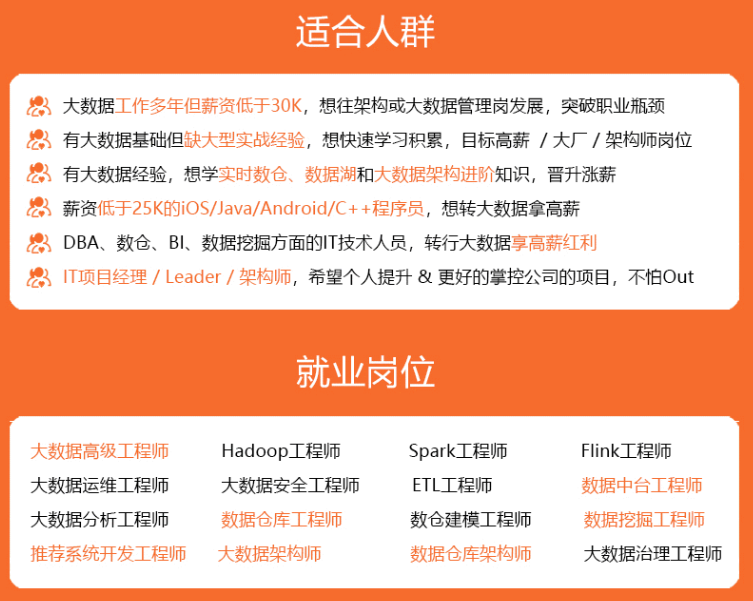

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数大数据工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上大数据开发知识点,真正体系化!

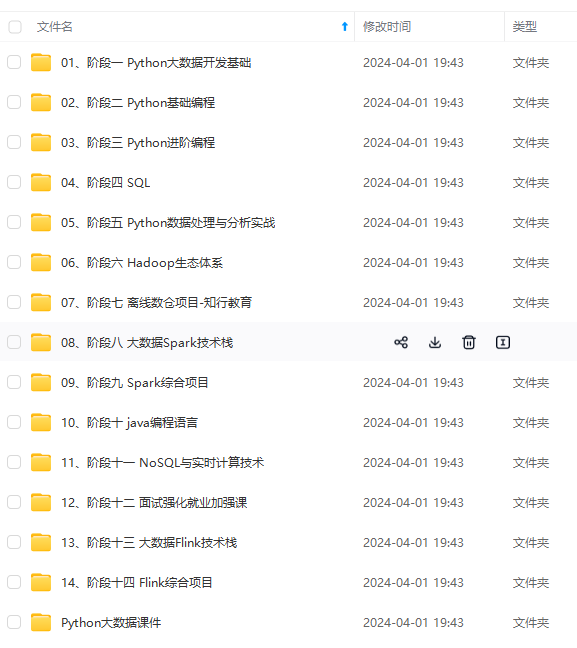

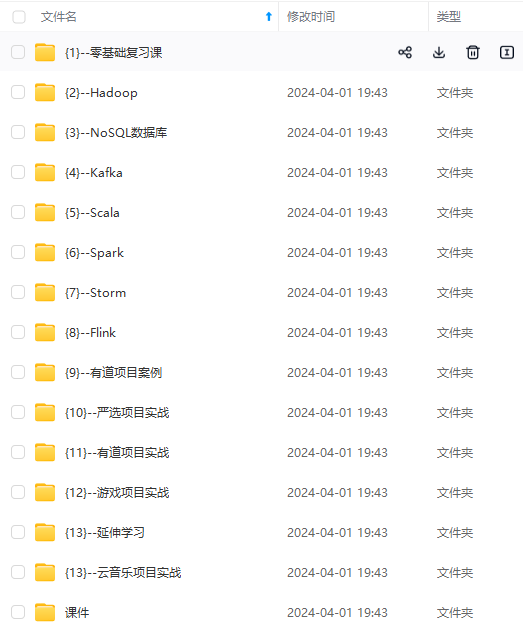

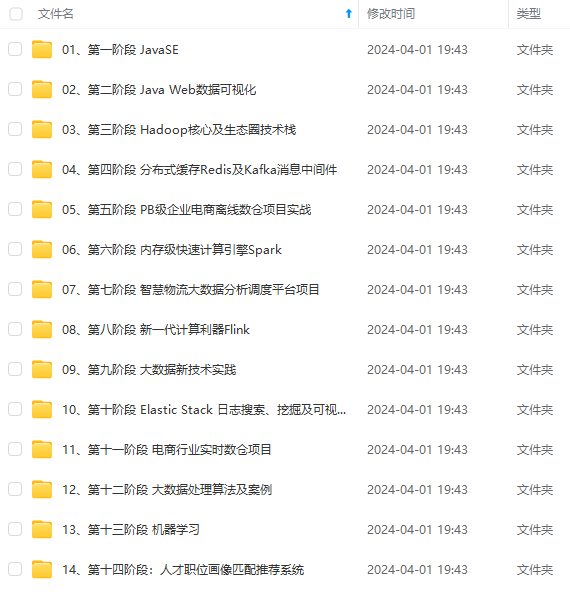

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip204888 (备注大数据获取)

如果你觉得这些内容对你有帮助,可以添加VX:vip204888 (备注大数据获取)

[外链图片转存中…(img-Zghx4zYj-1712575009567)]

917

917

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?