1.第四行的hadoop102是主机映射,你可以直接用虚拟机的ip地址,但是还是建议改成 hadoop102~hadoop104,因为后边都是用的映射,你总不能每次都改ip吧

2.第九行的路径要改成自己的,你要注意你是不是在opt的module里,以及hadoop的文件夹名字,如果你没有改名的话他应该是hadoop-3.xxx啥的

hdfs-site.xml

<!-- nn web 端访问地址-->

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop102:9870</value>

</property>

<!-- 2nn web 端访问地址-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop104:9868</value>

</property>

<!-- 测试环境指定HDFS副本数量1 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

记得hadoop102和hadoop104都是映射名,如果你不是记得改了

yarn-site.xml

<!-- 指定 MR 走 shuffle -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop103</value>

</property>

<!-- 环境变量的继承 -->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HO</value>

</property>

<!-- yarn 单个容器允许分配的最大最小内存-->

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>512</value>

</property>

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>3072</value>

</property>

<!-- yarn 容器允许管理的物理内存大小-->

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>3072</value>

</property>

<!-- 关闭 yarn 对虚拟内存的限制检查-->

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>true</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置日志聚集服务器地址 -->

<property>

<name>yarn.log.server.url</name>

<value>http://hadoop102:19888/jobhistory/logs</value>

</property>

<!-- 设置日志保留时间为 7 天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

yarn只需要注意最大内存和最小内存的配置,最大内存不要超过你当前虚拟机的内存,一般来说hadoop102的内存要比103和104要大,所以你分发完之后要去103和104改了。

最大内存改成虚拟机的内存或者小一点,然后最小内存不能不最大的大(这个应该好理解吧。。。),允许管理的物理内存和最大内存一样大就行

mapred-site.xml

<!-- 指定 MapReduce 程序运行在 Yarn 上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop102:10020</value>

</property>

<!-- 历史服务器 web 端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop102:19888</value>

</property>

除了映射名之外没啥要注意的~

workers

hadoop102

hadoop103

hadoop104

workers要留意留的是映射名,不能有空格和空行,不然hadoop会读进去的,然后如果后期要添加节点就需要在workers里添加对应的映射也好ip也好,不然你的集群咋知道谁是自己人。

配置完成之后,在格式化namenode之前一定要拍快照!!!!

配置完成之后,在格式化namenode之前一定要拍快照!!!!

配置完成之后,在格式化namenode之前一定要拍快照!!!!

重要的事情说三遍

如果你格式化出问题了,需要把hadoop文件夹里的data文件夹和logs文件夹删掉,然后再去修改问题,然后再格式化。

千万不要出了错还疯狂格式化,那样一定会不行的,一定要删掉hadoop文件夹下的data和logs才行

当然不排除别的问题,所以我才说在格式化前一定要拍快照

格式化之后就是在hadoop102启动hdfs

然后再hadoop103启动yarn,注意哦,是hadoop103,不要搞错了

然后编写群起脚本,hadoop就算完成了。

如果你是服务都起来了,但是web网页进不去,比如hadoop102:9870啥的

1.查看虚拟机的防火墙关了没,然后检查你的主机能不能ping通虚拟机,反过来行不行(一般不是这个问题,不然xshell都用不了)

2.查看win系统里的映射配置了没,因为hadoop102还是映射名,你在win里使用需要配置,如果不配置的话直接用ip也可以,我的是192.168.10.102.

至于去哪里配置,C:\Windows\System32\drivers\etc\hosts

如果说权限有问题修改不了,你就把他复制到桌面上修改了,再粘回去覆盖掉

然后就是配置zookeeper和kafka了,这个没啥难度,跟着视频来就行。

只有一点要注意就是,关闭zookeeper和kafka的时候要先关闭kafka,不然如果先关闭的zookeeper,你的kafka就不能通过正常的命令来关闭了,只能直接强行kill -9了

今天我就搞到了这里,明天继续来更新~

day3

2023/5/10

各位,我来啦!今天锻炼花的时间久了点。

今天总共学了5h,视频看到了p36的一半,成功安装了mysql flume maxwell

然后按照视频的顺序我说一下自己碰到的问题以及解决方式

1.

flume 在idea里编辑代码的时候 pom包的maven打包插件依赖爆红,虽然老师说可以不用管,但是如果想解决的话也是有办法的

进到你的maven对应的文件夹下的/maven/repository/org/apache/maven/plugins

然后将pom文件里对应的版本号改成文件夹下有的版本号就不会爆红了

2.

在虚拟机搭建好mysql,我在win上连接mysql的工具是DataGrip 2021.1.3,但是在连接mysql的时候一直报错,连接不上,报错内容如下:

[08S01]

Communications link failureThe last packet sent successfully to the server was 0 milliseconds ago. The driver has not received any packets from the server.

No appropriate protocol (protocol is disabled or cipher suites are inappropriate).

我是在确认防火墙,映射,权限一切问题都没有的情况下,在网上找到了这个解决方法

将useSSL选择为NO就行,至于具体原因是啥也不清楚,如果有大佬知道可以解释一下,跪谢大佬!

将useSSL选择为NO就行,至于具体原因是啥也不清楚,如果有大佬知道可以解释一下,跪谢大佬!

3.

在视频中,安装好maxwell后不是测试过一次,用hadoop消费maxwell往kafka里发的数据,要注意视频里hadoop103的消费者消费的topic和hadoop102里maxwell配置文件中的topic名字不一样,要改成一样的,不然会出现消费不到数据的情况。

主要是就这几个问题,然后我把课件里没有的文件分享一下,都是自己手敲得,如果有纰漏麻烦大家指正

安装maxwell时配置对mysql的操作

create database maxwell;

set global validate_password_policy=0;

set global validate_password_length=4;

create user 'maxwell'@'%' identified by 'maxwell';

grant all on maxwell.* to 'maxwell'@'%';

grant select, replication client, replication slave on *.* to 'maxwell'@'%';

maxwell启停脚本

#!/bin/bash

MAXWELL_HOME=/opt/module/maxwell

status_maxwell(){

result=`ps -ef | grep com.zendesk.maxwell.Maxwell | grep -v grep | wc -l`

return $result

}

start_maxwell(){

status_maxwell

if [[ $? -lt 1 ]]; then

echo "启动Maxwell"

$MAXWELL_HOME/bin/maxwell --config $MAXWELL_HOME/config.properties --daemon

else

echo "Maxwell正在进行"

fi

}

stop_maxwell(){

status_maxwell

if [[ $? -gt 0 ]]; then

echo "停止Maxwell"

ps -ef | grep com.zendesk.maxwell.Maxwell | grep -v grep | awk '{print $2}' | xargs kill -9

else

echo "Maxwell未在运行"

fi

}

case $1 in

start )

start_maxwell

;;

stop )

stop_maxwell

;;

restart )

stop_maxwell

start_maxwell

;;

esac

好,今天就学了这些,大家明天见~

day4

2023/5/11

今天就只学了2h5min,一不小心刷知乎刷的多了点嘿嘿嘿…然后看到了p43

今天主要就是完成了用户行为数据同步,写了个简单的flume过滤器,防止了数据漂移的现象,然后就没啥了。

就是配置flume那一块记得要先注释掉拦截器的配置,不然你的拦截器还没有编写上传打包,它肯定找不到拦截器对应的builder方法。

今天属实没怎么学,也没有碰到啥难题,就这样啦!伙计们明天见!

day5 and day6

2023/5/12-2023/5/13

两天总共学了五个小时,属实是偷懒了,而且这两天也没有遇到啥问题。

目前看到了p56,终于进入了数仓的内容了,但是目前还在听理论,还是挺有意思的感觉。

整体来说就碰到了一个问题,就是p48增量同步的flume配置文件中的过滤器的全类名有问题,不要直接复制粘贴文档上的,要自己copy一下自己的全类名。

然后如果增量数据还是没有同步过去要看一下自己的服务有没有全跑起来,hdfs,maxwell,zk,kafka,还有hadoop104的flume。

其余倒是没有啥问题了,大概开始写sql问题会多吧。

加油各位!不要放弃哦!

day7 and day8

2023/5/14-2023/5/15

这两天总共学了九个小时,这两天可没有偷懒喂!!

目前看到了p88,终于把数据仓库理论的地方看完了,虽然觉得很重要,但是懵懵的也是真的。

然后遇到了几个问题和讲课过程中突然想到的知识。

1.第二范式

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数大数据工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

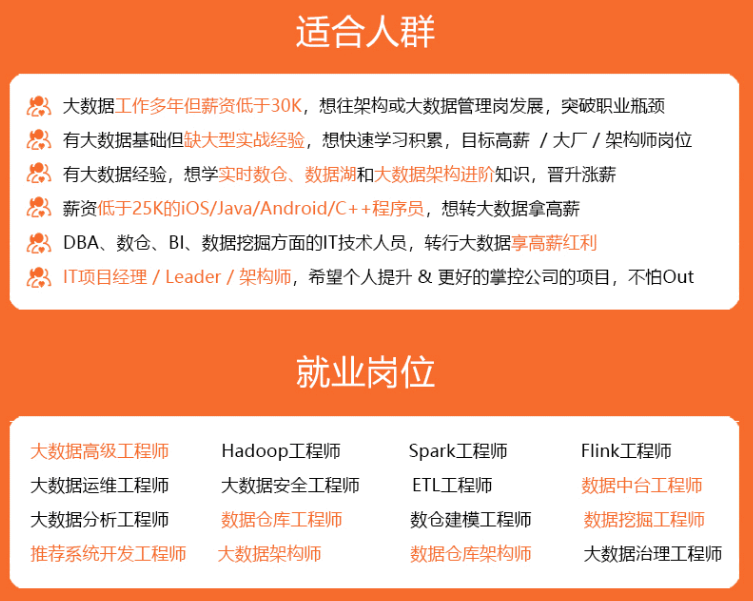

因此收集整理了一份《2024年大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

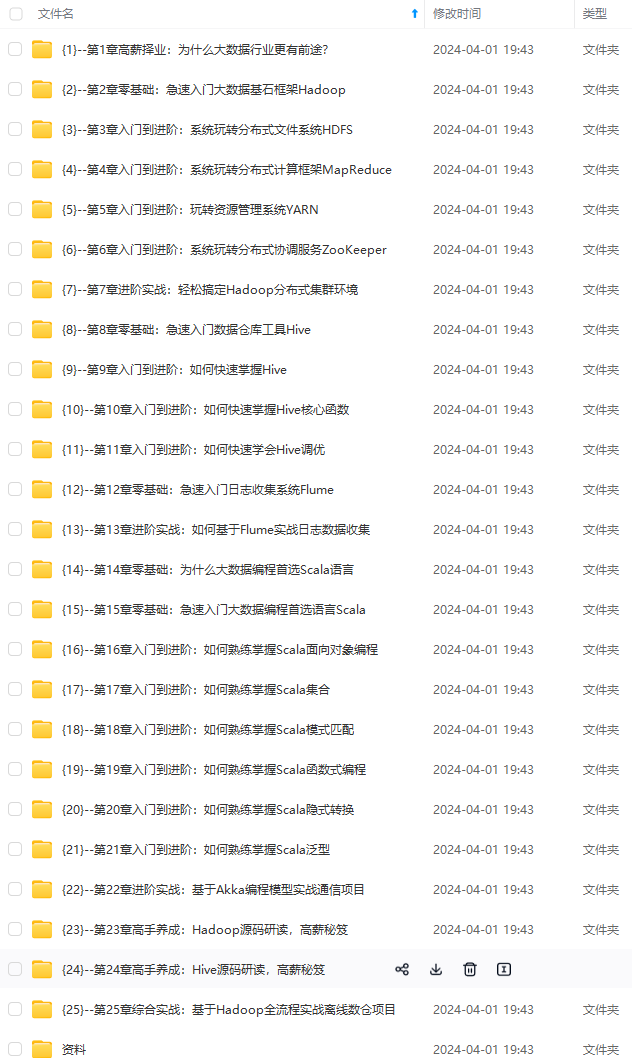

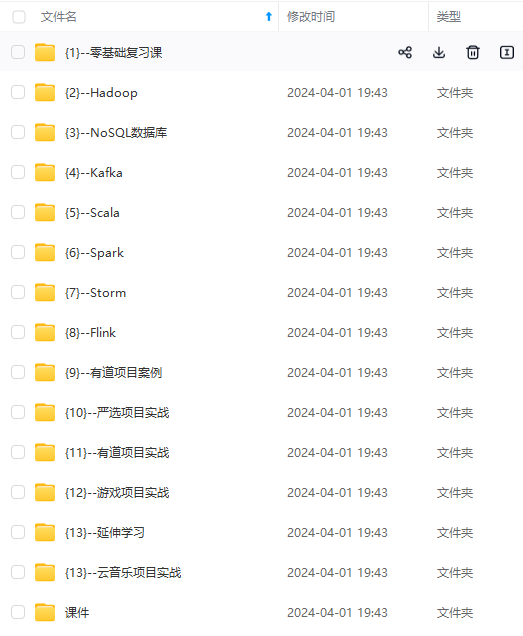

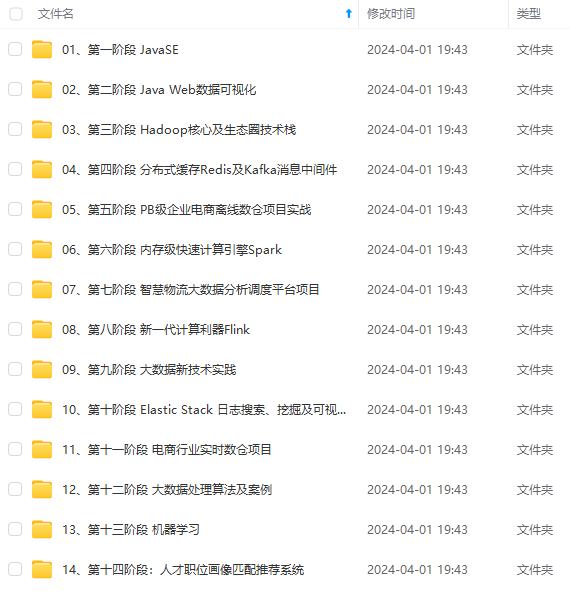

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上大数据开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip204888 (备注大数据获取)

转存中…(img-2NPwBsij-1712897167220)]

[外链图片转存中…(img-2Jrs7brP-1712897167221)]

[外链图片转存中…(img-ydqIPTSm-1712897167221)]

[外链图片转存中…(img-Js4P5IOb-1712897167221)]

[外链图片转存中…(img-bUDqRl5A-1712897167222)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上大数据开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip204888 (备注大数据获取)

[外链图片转存中…(img-YnynipTH-1712897167222)]

1234

1234

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?