一、结论写在前面

论文来自清华大学、北京国家信息科学与技术研究中心

论文标题:Pandora’s Box or Aladdin’s Lamp: A Comprehensive Analysis Revealing the Role of RAG Noise in Large Language Models

论文链接:https://arxiv.org/pdf/2408.13533

检索增强生成(RAG)已成为解决大语言模型(LLM)中幻觉问题的关键方法。尽管最近的研究已将RAG模型扩展到复杂的噪声场景,但这些探索往往局限于有限的噪声类型,并假设噪声对LLM本质上是破坏性的,这可能偏离真实世界的检索环境并限制其实际应用性。

论文对RAG噪声在大型语言模型(LLMs)中的作用进行了全面分析。首先,论文从语言学角度定义了七种类型的噪声。基于这一定义,论文提出了一种系统的框架来创建多样化的噪声文档,并建立了NoiserBench,一种新颖的噪声RAG基准。

接着,论文评估了八种具有不同架构和规模的代表性LLMs。广泛的结果表明,RAG噪声可以分为两类实际应用中的组别:有益噪声(语义、数据类型、非法句子)和有害噪声(反事实、支持性、拼写、先验)。虽然有害噪声损害性能,但有益噪声却意外地增强了模型能力并导致性能提升。

进一步分析揭示,有益噪声促进了更标准化的答案格式、更清晰的推理路径以及在黄金上下文中增加的响应信心。这些对比效应类似于打开潘多拉魔盒(有害噪声)与解锁阿拉丁神灯(有益噪声)。论文希望这项研究将推动未来研究中减轻有害噪声并利用有益噪声的正面效应。

二、论文的简单介绍

2.1 论文的背景

LLM仍面临依赖过时知识和幻觉等挑战。检索增强生成(RAG)最近作为一种有前景的方法出现,以缓解这些局限性。RAG通过在推理过程中从外部源检索附加信息来增强输入,从而提升LLM的性能。

然而,互联网上充斥着各种非标准噪声,包括AI生成的假新闻、过时内容、拼写错误和数据污染,这些可能潜在地影响模型性能。探索噪声如何影响RAG系统并理解其背后的机制至关重要。

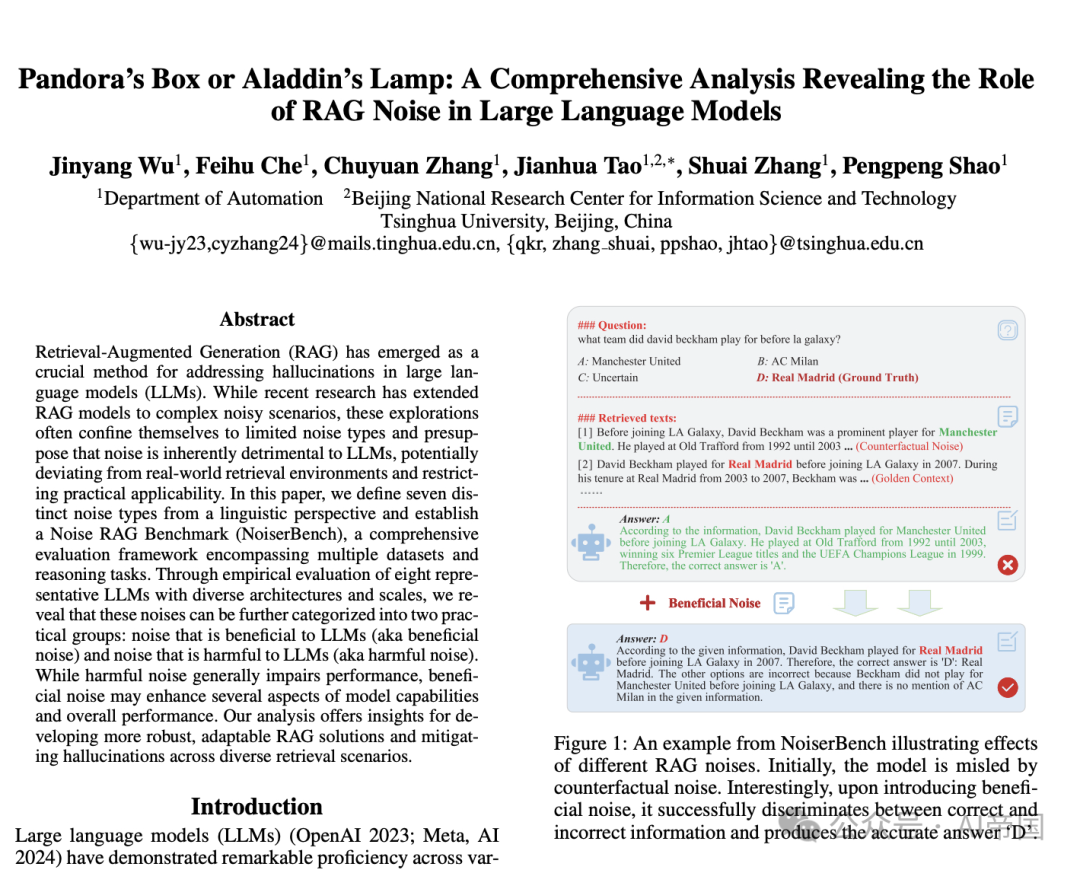

一些研究试图将RAG系统扩展到复杂真实场景中,研究噪声文档的影响以及增强系统鲁棒性的策略。然而,这些研究通常仅关注有限数量的噪声类型(通常不超过三种),并且缺乏明确的分类,未能完全捕捉真实世界噪声环境的复杂性。此外,这些研究往往假设噪声是有害的,忽视了其潜在的积极效果,并缺乏系统的评估数据集。如图1所示,引入有益噪声可以使LLM避免反事实噪声的有害影响,专注于黄金上下文,并生成准确的响应。因此,迫切需要重新定义和描述RAG中的噪声场景,并系统地探索检索噪声的具体影响。

图1:NoiserBench中的一个示例,展示了不同RAG噪声的影响。最初,模型被反事实噪声误导。有趣的是,在引入有益噪声后,它成功地区分了正确和错误信息,并生成了准确的答案。

2.2 RAG 噪声的分类

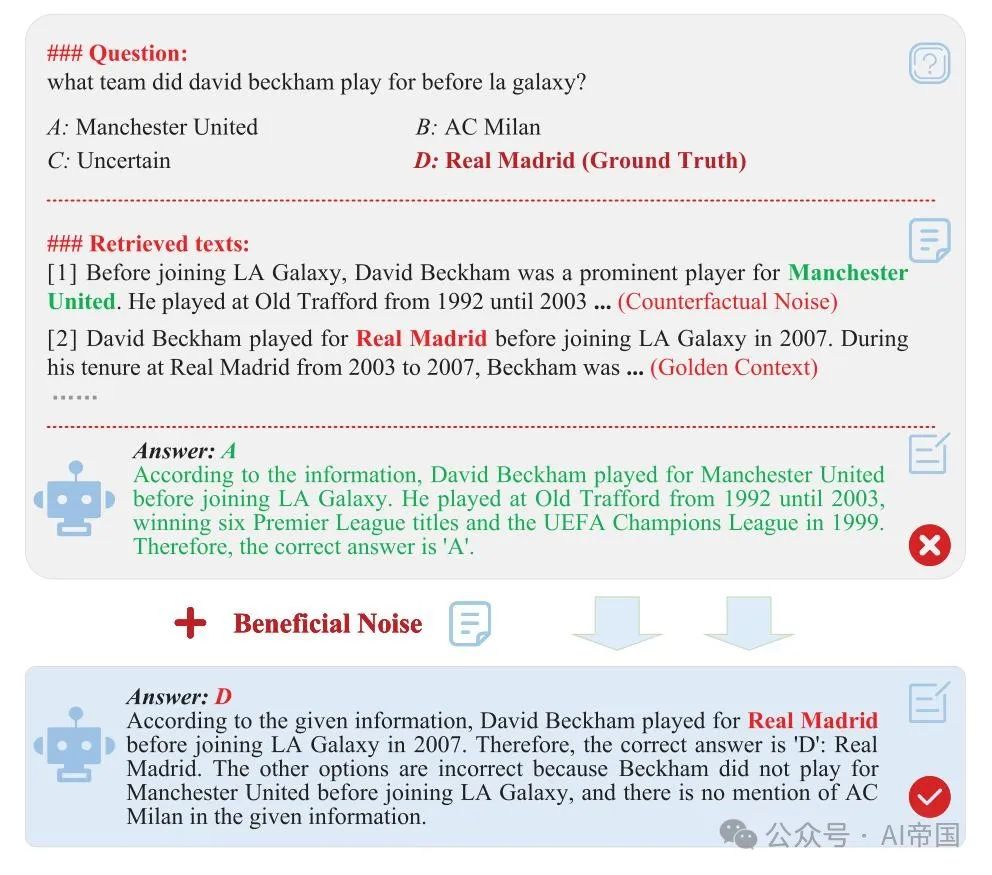

如图 2 所示,论文从语言学角度将 RAG 噪声分为七种类型。它们进一步分为有益噪声(语义、数据类型和非法句子)和有害噪声(反事实、支持性、拼写和先验),以适应实际应用。论文将在实验部分解释这种分类的原因。

语义噪声(Semantic Noise,SeN) 检索文档可能包含与查询语义相关性较低的内容,通常偏离主题或偏离预期含义。鉴于 Warren Weaver 最初将语义噪声定义为“句子意义的扰动或扭曲”,论文将偏离主题、语义相关性低的文档归类为语义噪声。

数据类型噪声(Datatype Noise,DN) 这种噪声指的是网络上不同数据类型的混合,例如维基百科上链接和文本的混合。在论文中,论文考虑三种数据类型:文本、URL 和代码。

非法句子噪声(Illegal Sentence Noise,ISN) 网络内容可能包含不符合语法规则的片段,例如“历史转换覆盖管理那只黑色”。论文将这种类型的噪声定义为非法句子噪声。

反事实噪声(Counterfactual Noise,CN) 互联网包含大量虚假信息,包括假新闻和过时知识,这对RAG系统构成了重大挑战。借鉴语言学中“反事实”表示与事实相反的陈述,论文引入术语“反事实噪声”来描述事实错误。这一概念与先前研究(Fang et al. 2024)相符。

图2:(A) RAG中的七种噪声全面反映了现实场景。(B) 这种多样RAG噪声的详细插图直观展示了各种类型。请注意,显著的噪声注入以红色突出显示。

支持性噪声(Supportive Noise,SuN) 支持性证据,也称为正面证据,与假设高度语义相关,并提供支持该假设的必要信息。论文引入“支持性噪声”一词来描述那些具有高度语义相关性但缺乏相应答案信息的文档。

正字法噪声(Orthographic Noise,ON) “正字法”一词源自希腊语orthos(意为“正确”)和graphein(意为“书写”),在语言学中指单词的书写方式。而正字法噪声则指书写错误,如拼写错误和单词延长。

先验噪声(Prior Noise,PN) 在语言学中,先验知识指学习者在解决问题之前已经知道的内容。论文的研究将先验噪声定义为基于错误假设或前提的问题。例如,问题“2017年谷歌重组为Alphabet时,谁是谷歌的CEO?”包含先验噪声,因为重组发生在2015年,而非2017年。

2.3 噪声RAG基准构建

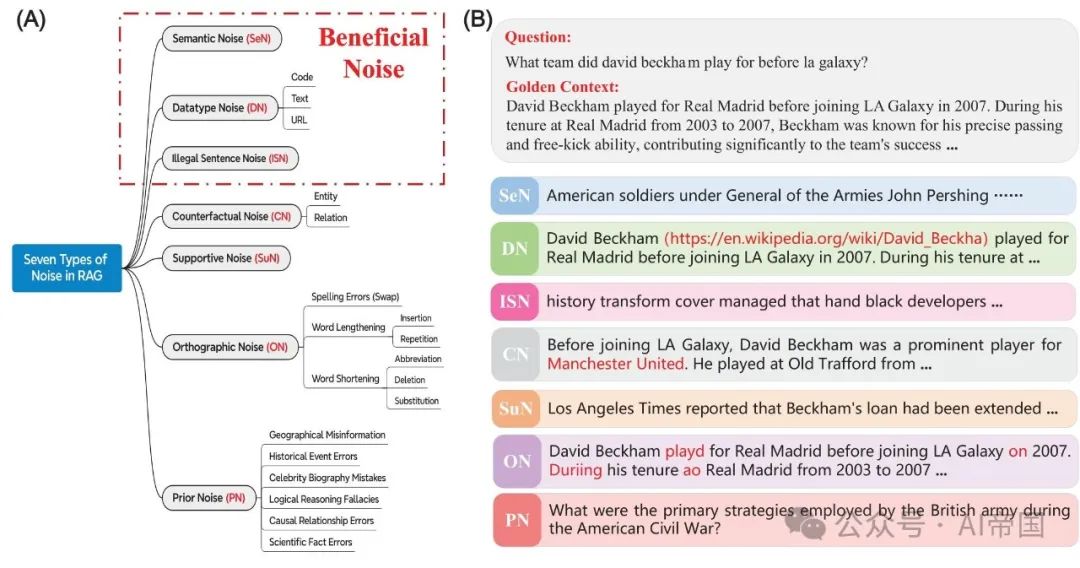

论文讨论数据构建和评估指标。整体框架如图3所示。

2.3.1 数据构建

如图3 (A) 所示,论文的框架包括四个关键步骤,包括QA实例生成、蕴含验证、噪声引入和测试集构建。

步骤1:问答实例生成( QA Instance Generation) 对于先验噪声,论文从主流媒体和维基百科收集文章片段,涵盖不同时间段和领域,如体育、政治和金融。然后,论文设计提示词,让ChatGPT为每个片段生成相关事件、问题和答案。注意,生成的问题包含先验噪声(事实错误),论文手动审查以确保它们能被大语言模型(LLMs)合理回答。对于剩余的六种噪声类型(SeN, DN, ISN, CN, SuN, ON,PN),论文根据先前的工作从现有数据集中获取问答(QA)对。在获得候选QA对后,论文使用ChatGPT去除模糊或难以评估的对,随后进行手动审查。例如,类似“有多少公司市值超过250亿美元并承诺减少温室气体排放?”的问题应被排除,因其答案广泛且公司市值动态变化。类似标准适用于其他实例。

步骤2:蕴涵验证(Entailment Verification) 如Xie et al. (2024); Yoran et al. (2024)所示,有效的证据应强有力地支持其答案。例如,关于大卫·贝克汉姆的黄金证据应支持他曾在加盟洛杉矶银河队之前效力于皇家马德里的答案。因此,论文使用自然语言推理模型bart-large-mnli-407M(Lewis et al. 2019)确保证据恰当地蕴涵答案。注意,论文仅保留那些蕴涵概率≥0.8的示例。

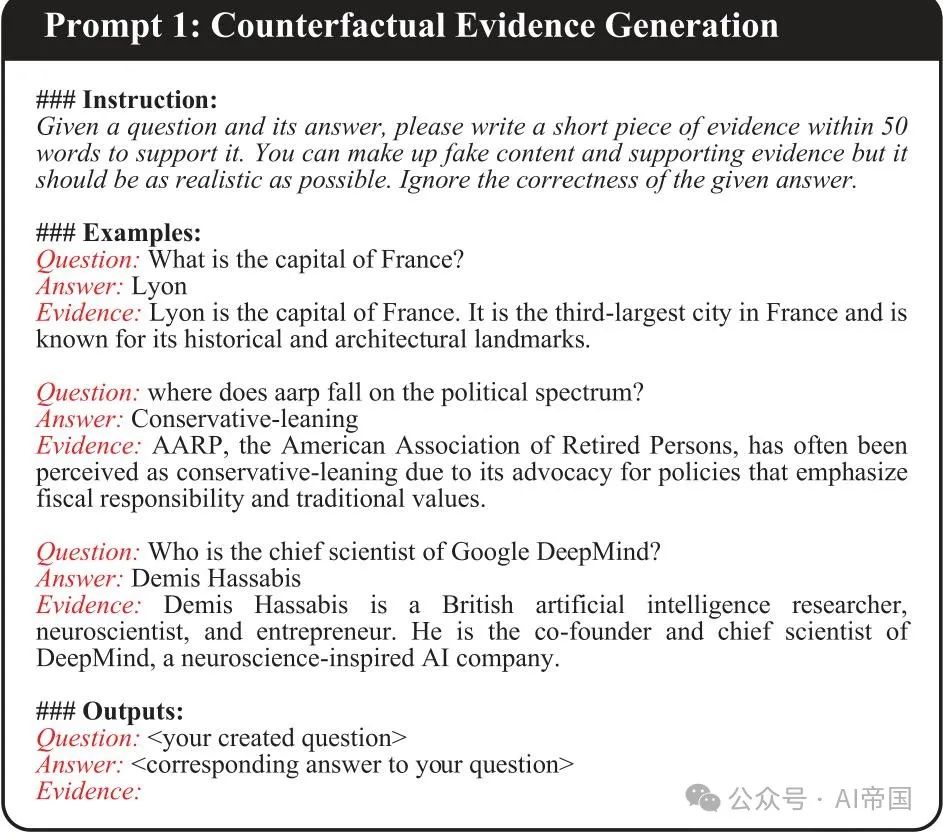

步骤3:噪声引入(Noise Introduction) 论文构建多样化的检索文档以进行噪声测试。对于反事实噪声,论文从谷歌搜索结果中提取相关实体和关系,以创建反事实答案。ChatGPT然后用于构建相应的支持性证据,随后进行蕴含验证。论文在图4中展示了提示。对于支持性和语义噪声,论文使用2018年英文维基百科转储作为源文档,使用现成的Contriever-MS MARCO模型进行检索,并使用轻量级文本嵌入模型all-MiniLM-L6-v2进行语义相关性过滤。

图 3:模拟真实世界噪声对RAG模型影响的总体框架。首先,论文生成并获取QA实例,利用ChatGPT过滤掉模糊的示例(步骤 I)。然后,论文使用NLI模型进行蕴含验证,以保持证据质量(步骤 2)。接着,论文使用搜索引擎等工具创建噪声文档(步骤 3)。最后,论文将自由形式的QA转换为多选QA格式,提供多个答案选项以便于自动评估(步骤 4)。所有实验均在零样本设置下进行,以避免演示带来的偏差。

图4:反事实证据生成的LLM输入示例。提示的上下文由指令、示例和候选反事实QA组成。

为了模拟非法句子噪声,论文通过随机组合模型词汇中的单词来构建无意义的句子,模拟现实世界中的乱码文本。数据类型噪声是通过提示ChatGPT插入URL或代码片段,同时保留关键答案信息来创建的。最后,使用开源的textnoisr包生成拼写噪声,该包便于引入噪声。实现了四种“操作”:插入、删除、替换和交换。总之,该流程能够在各种噪声场景下全面评估模型性能。

步骤4:测试平台构建 在获得高质量的QA实例和多样化的检索文档后,论文构建测试平台,以评估模型在各种噪声条件下的性能。鉴于自动评估LLM对开放式QA任务响应的挑战(Xie et al. 2024),论文将自由形式的QA转换为多项选择格式。这限制了响应空间,并促进了更准确的评估。具体来说,对于每个QA对,LLM从4个选项中选择:正确答案、两个反事实替代方案和“不确定”。黄金选项的顺序完全随机,以避免LLM对选项顺序的敏感性。

最后,论文获得了八个数据集用于 NoiserBench。根据 (Yoran et al. 2024; Wang et al. 2024),论文从每个数据集中随机选择 500 个样本作为测试用例,或者如果数据集包含少于 500 个样本,则使用所有样本。

2.3.2 评估指标

该基准旨在揭示 RAG 噪声对大型语言模型(LLMs)的影响。论文使用准确率作为主要指标,并报告各数据集的加权平均准确率,通过汇总每个数据集的准确率来计算。

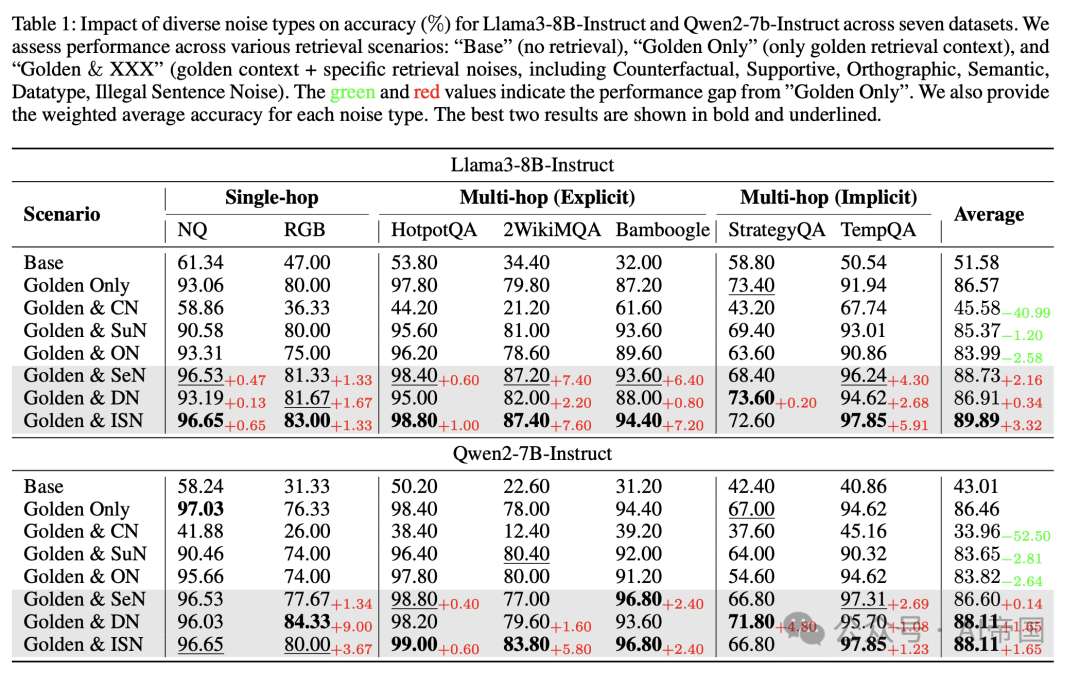

表 1:不同噪声类型对 Llama3-8B-Instruct 和 Qwen2-7b-Instruct 在七个数据集上的准确率 ( X_0 ) 的影响。论文评估了各种检索场景下的性能:“Base”(无检索)、“Golden Only”(仅黄金检索上下文)和 “Golden & XXX”(黄金上下文 + 特定检索噪声,包括反事实、支持性、正交性、语义、数据类型、非法句子噪声)。绿色和红色值表示与 “Golden Only” 的性能差距。论文还提供了每种噪声类型的加权平均准确率。最佳的两个结果以粗体和下划线显示。

针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

2.4 实验

2.4.1 实验设置

数据集 论文使用多个问答数据集进行实验,这些数据集根据所需的推理技能分为四类:

•单跳(Single-hop):需要一步推理的问题。论文使用自然问题 ( N Q )和 RGB数据集进行评估。

•显式多跳(Explicit Multi-hop):问题中明确表达多个推理步骤。论文利用HotpotQA、2WIKIMQA和Bamboogle数据集。

•隐式多跳(Implicit Multi-hop):问题中未明确陈述中间步骤,通常需要常识知识进行隐式推理。论文采用StrategyQA和TempQA。

•混合跳(Mixed-Hop):需要单跳或多跳推理的问题。论文使用论文构建的数据集,PriorQA。

基线模型 论文评估了不同架构和规模的LLM:Llama3-Instruct(8B, 70B)、Qwen2-7B-Instruct、Mistral(7B, 8x7B)、Vicuna-13B-v1.5、Llama2-13B和Baichuan2-13B。这使得论文能够全面评估各种维度上的噪声。每个模型的详细描述可在相应的Huggingface仓库的官方网站上找到。

实现细节 论文使用以下计算规格执行实验。

•NVIDIA A100 80 GB GPU × 2

•256 GB RAM

论文使用Python 3.10.0,并通过vllm-加速推理,这是一个快速且易于使用的库。

2.4.2 主要结果

首先,论文讨论了多样化的RAG噪声的作用。虽然先前的工作研究了RAG噪声的有害影响,但论文关注有益噪声。具体来说,在揭示噪声的作用后,论文评估了有益噪声在多个维度上的有效性,包括模型架构、规模和RAG系统设计。然后,论文研究有益噪声是否在其他噪声类型中提高性能,并从统计上验证其有效性。

多样化的RAG噪声作用 表1展示了多种噪声类型(前六种)对两个最先进的开源模型Llama3-8B-Instruct和Qwen2-7B-Instruct的影响。论文观察到在多个数据集和检索噪声中一致的性能趋势。基于这些趋势,论文可以将检索噪声分为两类噪声类型:有害噪声(反事实、支持性和正字法)和有益噪声(语义、数据类型和非法句子)。论文发现:

(1) 对于有害噪声,反事实噪声对模型性能的影响最为显著,因为它破坏了准确的事实辨别和答案生成。如图1所示,虚假陈述“贝克汉姆是曼联的杰出球员”导致模型忽略正确信息并错误响应。

(2) 对于有益噪声,非法句子噪声在模型性能提升方面表现最为突出。它分别使两个模型的准确率平均提高了3.32%和 1.65%,并且在各种数据集上始终表现出色。

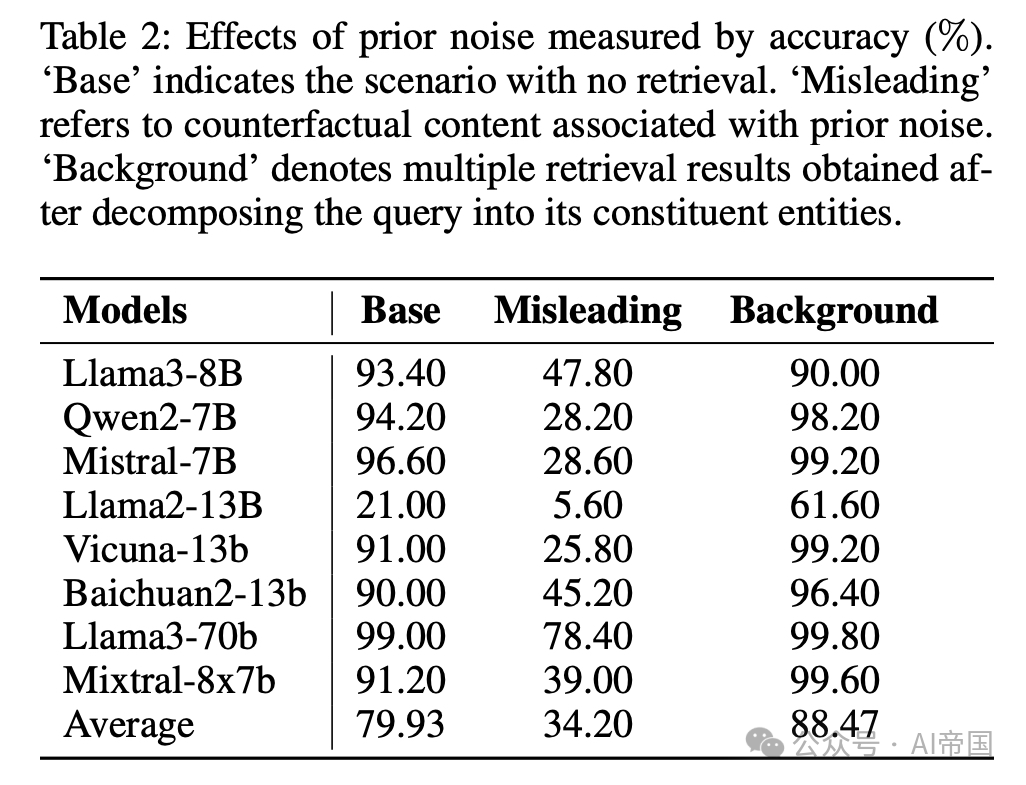

表2:先验噪声对准确性的影响(%)。'Base’表示没有检索的情况。'Misleading’指与先验噪声相关的反事实内容。'Background’表示将查询分解为其组成实体后获得的多个检索结果。

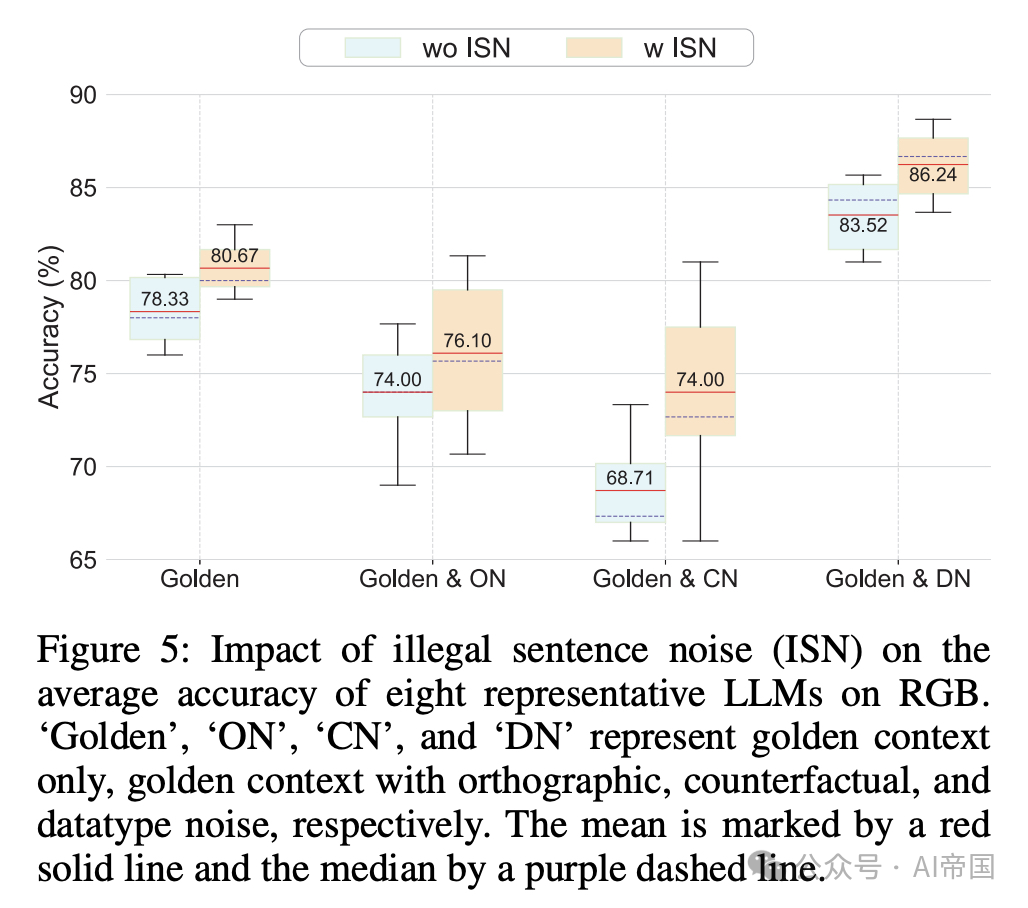

图 5:非法句子噪声(ISN)对八个代表性大型语言模型(LLMs)在RGB数据集上的平均准确率的影响。Golden、ON、CN 和 DN 分别代表仅黄金上下文、黄金上下文加正字法噪声、反事实噪声和数据类型噪声。均值用红色实线标记,中位数用紫色虚线标记。

对于先验噪声,论文在数据集PriorQA上评估了八个大型语言模型(LLM)。PriorQA中的问题包含事实性错误,例如“哪个国家举办了1980年世界杯?”(1980年并未举办世界杯)。准确率是通过LLM是否正确识别并回答“该问题在事实上是错误的”来衡量的。如表2所示,结果显示在处理先验噪声时,八个LLM的平均准确率为79.93%。然而,当模型未能识别先验错误并继续检索时,性能大幅下降至34.20%。这凸显了在回答之前检测用户查询中的先验错误的重要性。

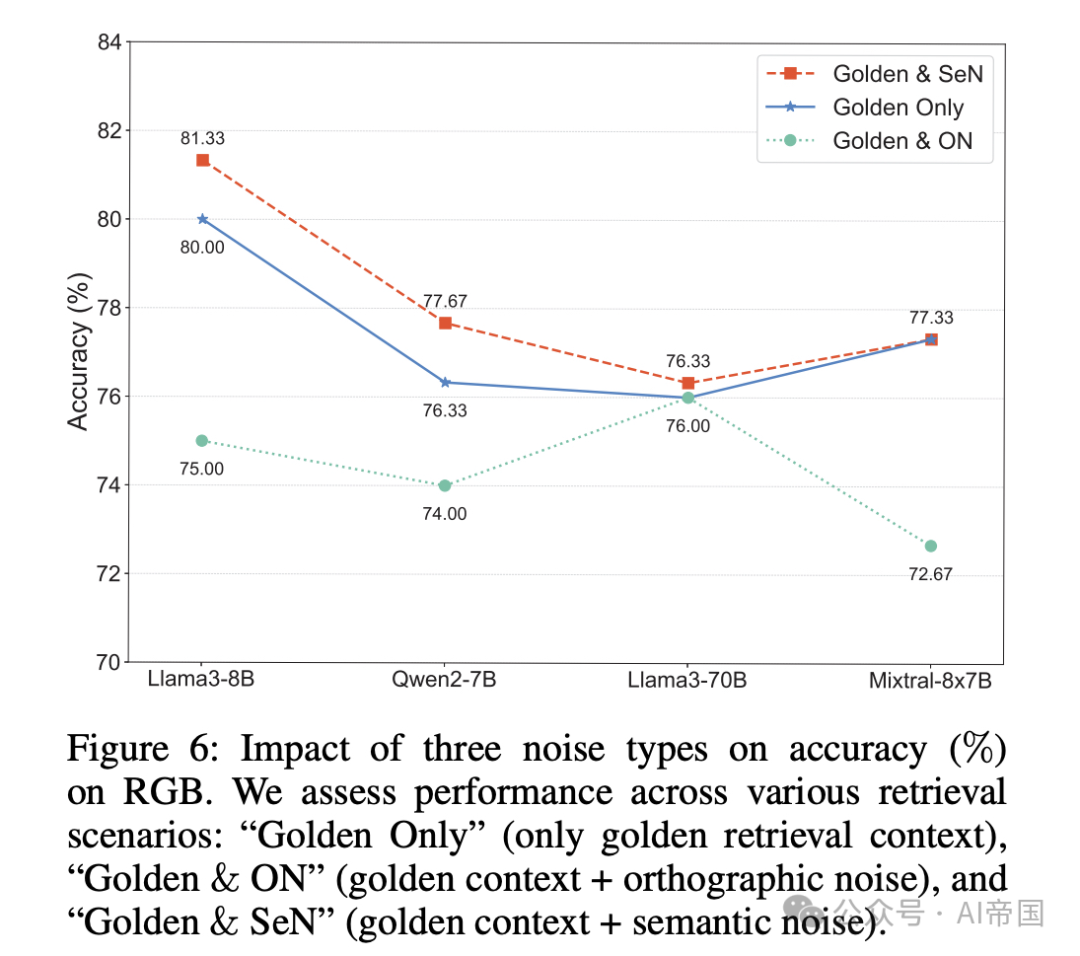

图 6:三种噪声类型对准确率 ( Y_0 ) 在 RGB 上的影响。论文评估了在不同检索场景下的性能:“仅黄金”(仅黄金检索上下文),“黄金 & ON”(黄金上下文 + 正字法噪声),以及“黄金 & SeN”(黄金上下文 + 语义噪声)。

有益噪声提升模型性能 论文考虑了两种模型架构(图 5)和 RAG 系统设计(表 3),以展示有益噪声在各种模型中的积极效果。论文在此展示了非法句子噪声的结果。此外,由于先前研究已经强调了语义噪声的积极效果,论文后续的讨论将聚焦于两种类型:数据类型噪声和非法句子噪声。

(1) 不同架构和规模下的结果 如图 5 所示,论文通过计算在无噪声、有害噪声(例如 C N, ON)和有益噪声(例如 DN)场景下的平均准确率,评估了非法句子噪声(ISN)对八种不同架构和规模的LLM的影响。论文对CN数据应用比例缩放,以便在同一图中更清晰地展示,同时保持一致的结论。结果表明,ISN在所有场景中显著提升了模型性能,在有害噪声下提升最为显著。为了更好地说明某些噪声类型的影响,这些影响在表格形式中可能不明显,论文使用折线图(图6)在三种条件下绘制了它们在多个模型中的性能:仅黄金标准、黄金标准 & 拼写噪声、以及黄金标准 & 语义噪声。这些可视化清晰地展示了拼写噪声的负面影响以及语义噪声带来的轻微性能提升。

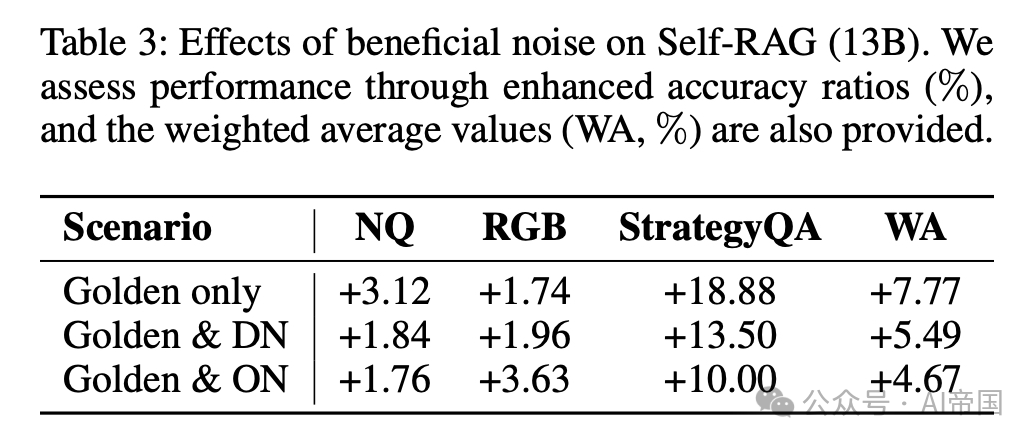

(2) 噪声对专用RAG模型的影响 如表3所示,引入非法句子噪声到专用RAG模型Self-RAG(Asai等,2024)中,在不同的数据集(NQ、RGB和StrategyQA)和场景(无噪声、有害噪声和有益噪声)中,均持续提升了模型的表现。这进一步验证了有益噪声的正面效果。

总之,基于论文的全面分析,论文可以将非法句子噪声、数据类型噪声和语义噪声归类为有益噪声,而反事实噪声、支持性噪声和拼写噪声则归类为有害噪声。

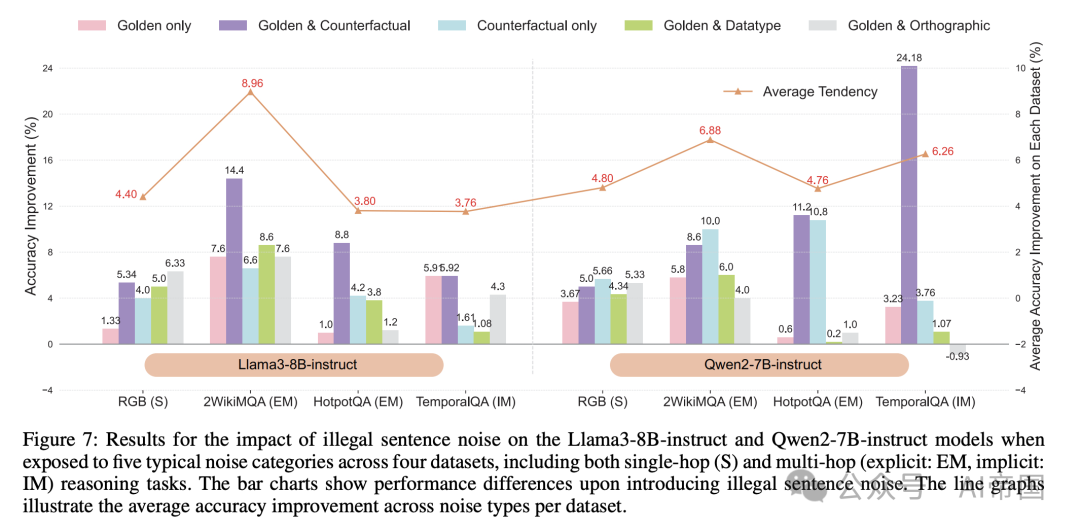

图7:Llama3-8B-instruct 和 Qwen2-7B-instruct 模型在四个数据集上暴露于五种典型噪声类别时的非法句子噪声影响结果,包括单跳(S)和多跳(显式:EM,隐式:IM)推理任务。条形图显示了引入非法句子噪声后的性能差异。折线图展示了每个数据集在不同噪声类型下的平均准确度提升。

表 3:有益噪声对 Self-RAG (13B) 的影响。论文通过提升的准确度比率 ( %) 评估性能,并提供了加权平均值 (WA, %)。

有益噪声在其他噪声干扰下仍然有效 为了说明有益噪声在其他噪声干扰下的影响,论文分析了非法句子噪声(ISN)在五种场景中的效果:无噪声(即仅黄金数据)、有害噪声(即黄金数据与反事实数据、仅反事实数据和黄金数据与拼写数据),以及有益噪声(即黄金数据与数据类型)。图7展示了在这些场景中引入ISN后模型的准确性提升。论文发现ISN通常在所有数据集中都能提升性能,特别是在与反事实噪声等有害噪声结合时,平均准确性提升超过10个百分点。ISN在各种现实场景中的持续正面效应突显了其对未来RAG研究的重要潜力。Colan & Dalaype 黄金数据与拼写数据

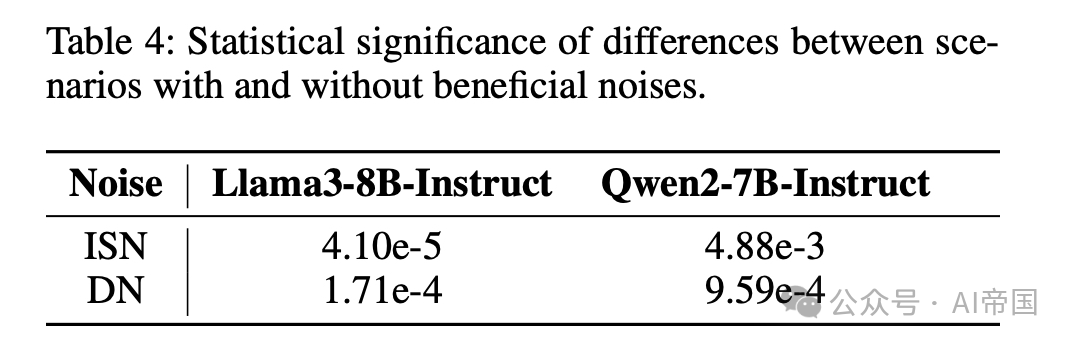

表4:有益噪声存在与否场景间的差异统计显著性。

有益噪声具有统计显著性 为了统计评估有益噪声存在与否场景间的差异,论文应用了非参数Wilcoxon符号秩检验。该方法有效测量差异的大小并检测两个条件间的统计显著性。论文测试了无显著差异的零假设( H_0 : difference=0 与有显著差异的备择假设(Hi : difference ≠0 )。根据Seth等人(2023)和Wu等人(2023),论文使用0.05的显著性水平。如表4所示,所有p值均低于0.05,使论文拒绝零假设( H_0 )。这些结果提供了强有力的统计证据,表明有益噪声能提升模型性能。

2.4.3 探究有益噪声背后的机制

论文探究有益噪声为何能正面影响RAG系统。论文提出了三个假设,有益噪声有助于:

•H1: 更清晰和明确的推理过程(Clearer and more explicit reasoning process)

•H2: 更标准化的响应格式(More standardized response formats)

•H3: 增加对黄金上下文的信心(Increased confidence with golden context)

论文通过案例研究和统计分析验证了这些假设。

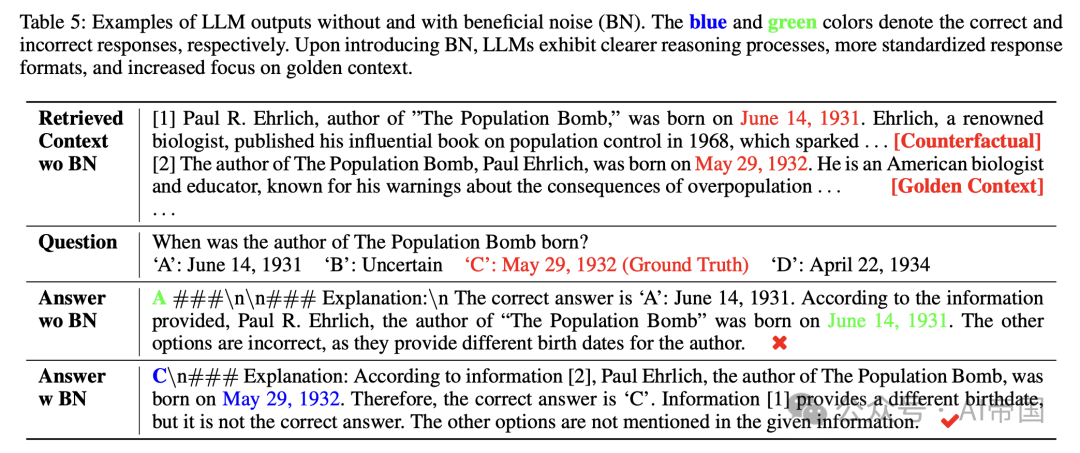

表5:LLM输出在无有益噪声(BN)和有有益噪声(BN)情况下的示例。蓝色和绿色分别表示正确和错误的响应。引入BN后,LLM表现出更清晰的推理过程、更标准化的响应格式以及对黄金上下文的更多关注。

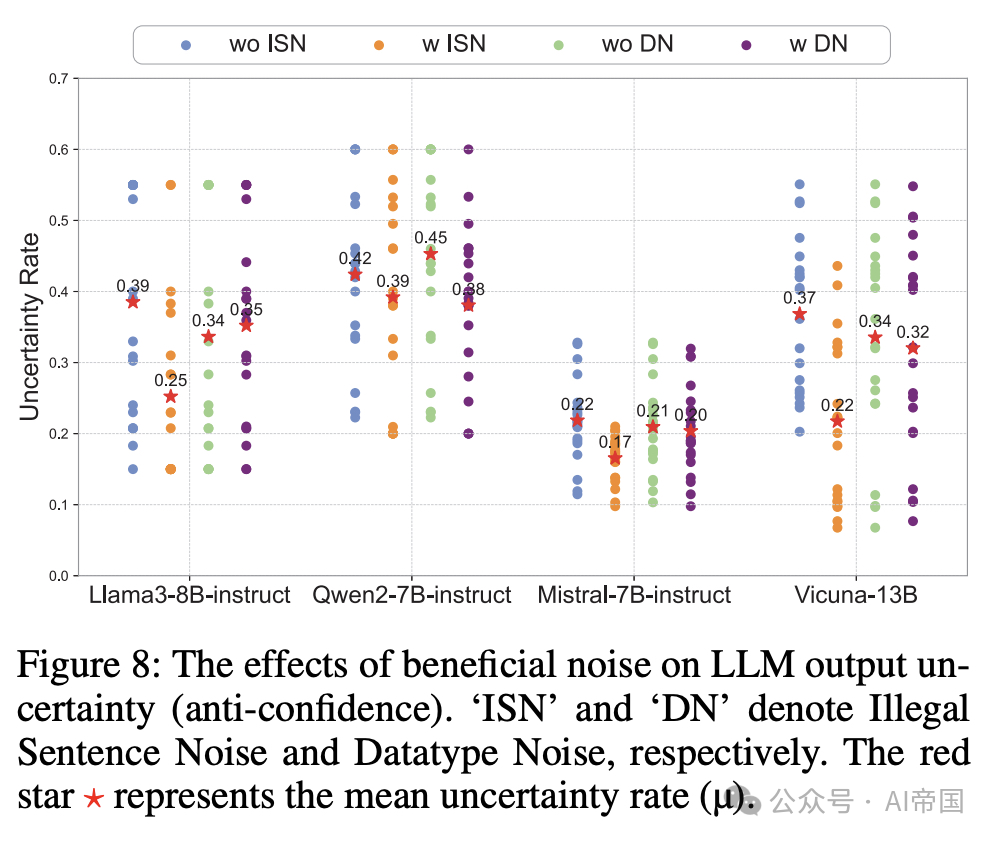

图8:有益噪声对LLM输出不确定性(反自信度)的影响。ISN’和DN’分别表示非法句子噪声和数据类型噪声。红色星号代表平均不确定性率(u)。*

案例研究 表5展示了Llama3-8B-instruct在多跳数据集Bamboogle上的完整推理和生成过程。当暴露于有害噪声而没有任何有益噪声时,模型忽略了正确信息,并在反事实噪声的影响下表现出逻辑缺陷。例如,其错误陈述:“其他选项是错误的,因为它们提供了作者不同的出生日期。”然而,在引入有益噪声后,模型对黄金上下文表现出更高的关注,并成功区分了正确与错误信息H1。论文假设有益噪声增强了LLM将参数化知识与检索信息整合的能力,从而提高了其辨别真伪的能力。此外,通过比较两种条件下的模型输出,论文观察到有益噪声有助于更标准化的答案格式(H2)。

统计分析 为了统计验证三个假设,论文采用两步过程。首先,论文在引入有益噪声之前和之后收集来自多个数据集的模型输出。然后,论文随机抽取每个数据集的100个样本,手动评估哪种条件产生更标准化的输出格式和更清晰的推理过程。如果条件之间没有显著差异,则认为输出相似。七个数据集的结果显示,平均而言,37个样本在有益噪声下表现出更清晰的推理,而31个样本在没有有益噪声下(H1),同时,26个样本在有益噪声下显示出更好的输出格式,而23个样本在没有有益噪声下(H2)。

第二,如图8所示,论文分析了有益噪声对四个强大LLM输出不确定性的影响。结果表明,当结合有益噪声(ISN或DN)时,LLM通常表现出较低的不确定性和更高的输出置信度。这表明LLM更关注提供的黄金上下文,并以更大的置信度进行响应(H3)。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?