配置kafka服务的启动脚本

上面设置好sasl认证的配置后,我们需要在kafka启动的服务脚本中,将此配置加入进去。

可以直接修改bin/kafka-server-start.sh,亦或者拷贝一份kafka-server-start.sh命名为kafka-server-start-saal.sh(名称自定义即可)

export KAFKA\_OPTS="-Djava.security.auth.login.config=/wlh/kafka01/config/kafka\_server\_jaas.conf"

kafka02和kafka03同样这样配置好

export KAFKA\_OPTS="-Djava.security.auth.login.config=/wlh/kafka02/config/kafka\_server\_jaas.conf"

export KAFKA\_OPTS="-Djava.security.auth.login.config=/wlh/kafka03/config/kafka\_server\_jaas.conf"

开始执行启动kafka集群

# 生成一个uuid,后面需要用

/wlh/kafka01/bin/kafka-storage.sh random-uuid

# 格式化存储

/wlh/kafka01/bin/kafka-storage.sh format -t xtzWWN4bTjitpL3kfd9s5g -c /wlh/kafka01/config/kraft/server.properties

/wlh/kafka02/bin/kafka-storage.sh format -t xtzWWN4bTjitpL3kfd9s5g -c /wlh/kafka02/config/kraft/server.properties

/wlh/kafka03/bin/kafka-storage.sh format -t xtzWWN4bTjitpL3kfd9s5g -c /wlh/kafka03/config/kraft/server.properties

开始启动kafka(-daemon后台启动)

# 分别启动它们

/wlh/kafka01/bin/kafka-server-start-saal.sh -daemon /wlh/kafka01/config/kraft/server.properties

/wlh/kafka02/bin/kafka-server-start-saal.sh -daemon /wlh/kafka02/config/kraft/server.properties

/wlh/kafka03/bin/kafka-server-start-saal.sh -daemon /wlh/kafka03/config/kraft/server.properties

服务启动完成。。。

Tip:服务器端口要打开,服务器端口要打开,端口打开!!!或者关了防火墙也行。

使用java进行连接

无论是使用kafka的API还是直接使用spring集成kafka都是可以的。

我这里就采用kafka的API方式了。

导入kafka-clients依赖

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.7.2</version>

</dependency>

在application.properties中配置相关属性,注意spring.kafka.jaas-config是结尾是有一个分号;的,若不写,是连接不到kafka的。

spring.kafka.bootstrap-servers=192.168.8.122:19092,192.168.8.122:29092,192.168.8.122:39092

spring.kafka.jaas-config=org.apache.kafka.common.security.plain.PlainLoginModule required username="kafka" password="kafka1234";

spring.kafka.topics=test

在java配置类中进行接收并且创建生产者和消费者

package xxx.xxx.xxx;

import org.apache.kafka.common.config.SaslConfigs;

import org.apache.kafka.common.security.auth.SecurityProtocol;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.boot.autoconfigure.condition.ConditionalOnProperty;

import org.springframework.stereotype.Component;

import java.util.Properties;

/\*\*

\* @author wlh

\* @date 2023/8/10

\*/

@ConditionalOnProperty("spring.kafka.bootstrap-servers")

@Component

public class KafkaProperties {

@Value("${spring.kafka.bootstrap-servers}")

private String bootstrapServer;

@Value("${spring.kafka.jaas-config}")

private String jaasConfig;

public static String topics;

@Value("${spring.kafka.topics}")

private void setTopics(String topics) {

KafkaProperties.topics = topics;

}

/\*\*

\* 获取生产者配置

\*

\* @return 配置信息

\*/

public Properties getProducerProperties() {

Properties properties = new Properties();

properties.put("bootstrap.servers", bootstrapServer);

String SERIALIZER = "org.apache.kafka.common.serialization.StringSerializer";

properties.put("key.serializer", SERIALIZER);

properties.put("value.serializer", SERIALIZER);

fillSecurityProperties(properties);

return properties;

}

// 消费者配置

public Properties getConsumerProperties() {

Properties properties = new Properties();

properties.put("bootstrap.servers", bootstrapServer);

properties.put("group.id", "test"); // group.id可以自定义

String DESERIALIZER = "org.apache.kafka.common.serialization.StringDeserializer";

properties.put("key.deserializer", DESERIALIZER);

properties.put("value.deserializer", DESERIALIZER);

fillSecurityProperties(properties);

return properties;

}

// 安全认证的配置

private void fillSecurityProperties(Properties properties) {

properties.setProperty("security.protocol", SecurityProtocol.SASL\_PLAINTEXT.name);

String SASL\_MECHANISM = "PLAIN";

properties.put(SaslConfigs.SASL\_MECHANISM, SASL\_MECHANISM);

properties.put(SaslConfigs.SASL\_JAAS\_CONFIG, jaasConfig);

}

}

创建生产者和消费者

package xxx.xxx.xxx;

import lombok.RequiredArgsConstructor;

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.springframework.boot.autoconfigure.condition.ConditionalOnProperty;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import java.util.Arrays;

import java.util.Collections;

import java.util.List;

/\*\*

\* @author wlh

\* @date 2023/08/10

\*/

@ConditionalOnProperty("spring.kafka.bootstrap-servers")

@Slf4j

@RequiredArgsConstructor

@Configuration

public class KafkaConfig {

private final KafkaProperties kafkaProperties;

// 创建生产者

@Bean

public KafkaProducer<String, String> kafkaProducer() {

return new KafkaProducer<>(kafkaProperties.getProducerProperties());

}

// 创建消费者

@Bean

public KafkaConsumer<String, String> kafkaConsumer() {

KafkaConsumer<String, String> kafkaConsumer = new KafkaConsumer<>

(kafkaProperties.getConsumerProperties());

List<String> topicList = Collections.singletonList("test"); // 这里写死了,可自行扩展

kafkaConsumer.subscribe(topicList);

log.info("消息订阅成功! topic:{}", topicList);

log.info("消费者配置:{}", kafkaProperties.getConsumerProperties().toString());

return kafkaConsumer;

}

}

信息发送的Util工具类

package xxx.xxx.xxx;

import com.alibaba.excel.util.StringUtils;

import com.alibaba.fastjson.JSON;

import lombok.extern.slf4j.Slf4j;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.scheduling.annotation.Async;

import org.springframework.stereotype.Component;

import java.util.Arrays;

import java.util.Collections;

import java.util.List;

@Component

@Slf4j

public class KafkaSendUtil {

@Autowired

KafkaProducer<String, String> kafkaProducer;

@Async

public void sendMsg(String topic, String msg) {

List<String> topics;

if (StringUtils.isBlank(topic)) {

topics = Arrays.asList(KafkaProperties.topics.split(","));

} else {

topics = Collections.singletonList(topic);

}

for (String sendTopic : topics) {

ProducerRecord<String, String> record = new ProducerRecord<>(sendTopic, msg);

log.info("正在发送kafka数据,数据=====>{}", msg);

kafkaProducer.send(record);

}

}

}

实例

简单做一个实例,调通一下数据。监听方式可以不按照本文的,本文只是做测试。

kafka消费者监听器

package xxx.xxx.xxx;

import lombok.extern.slf4j.Slf4j;

import org.springframework.boot.ApplicationArguments;

import org.springframework.boot.ApplicationRunner;

import org.springframework.stereotype.Component;

import java.util.Arrays;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

@Slf4j

@Component

public class KafkaListener implements ApplicationRunner {

public static ExecutorService executorService = Executors.newFixedThreadPool(2);

@Override

public void run(ApplicationArguments args) {

log.info("监听服务启动!");

executorService.execute(() -> {

MessageHandler kafkaListenMessageHandler = SpringBeanUtils.getBean(MessageHandler.class);

kafkaListenMessageHandler.onMessage(SpringBeanUtils.getBean("kafkaConsumer"), Arrays.asList("test")); // 这里是监听的kafka的topic,这里写死了,自己扩展即可

});

}

}

Bean的工具类

package com.bjmetro.top.global.kafka;

import org.springframework.beans.BeansException;

import org.springframework.context.ApplicationContext;

import org.springframework.context.ApplicationContextAware;

### 给大家的福利

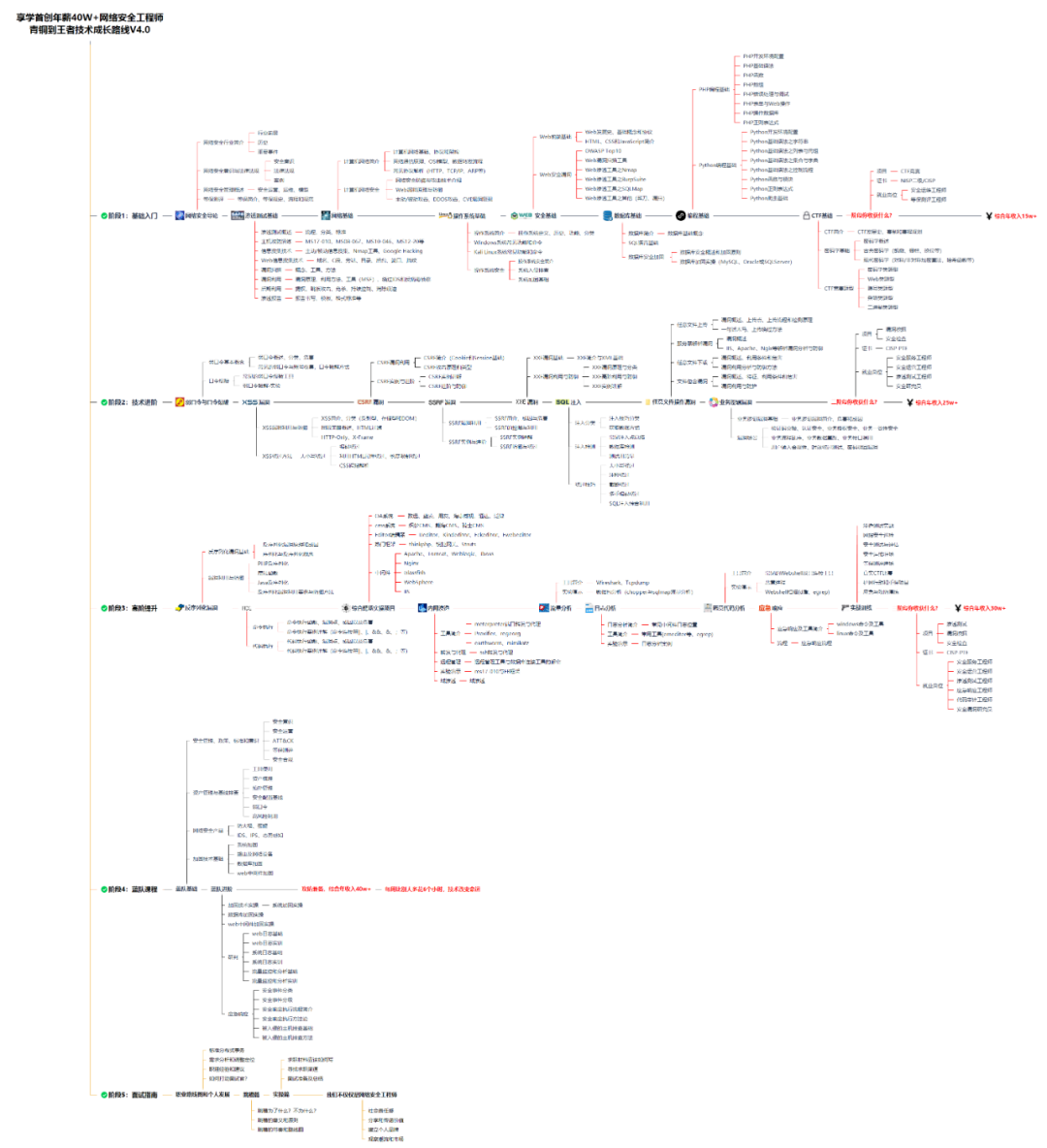

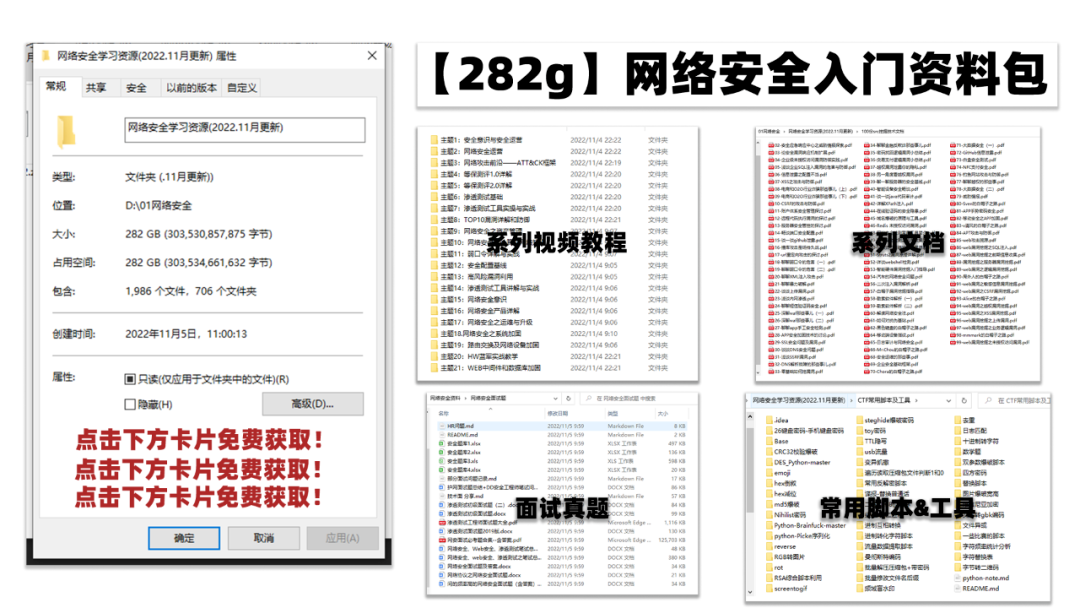

**零基础入门**

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

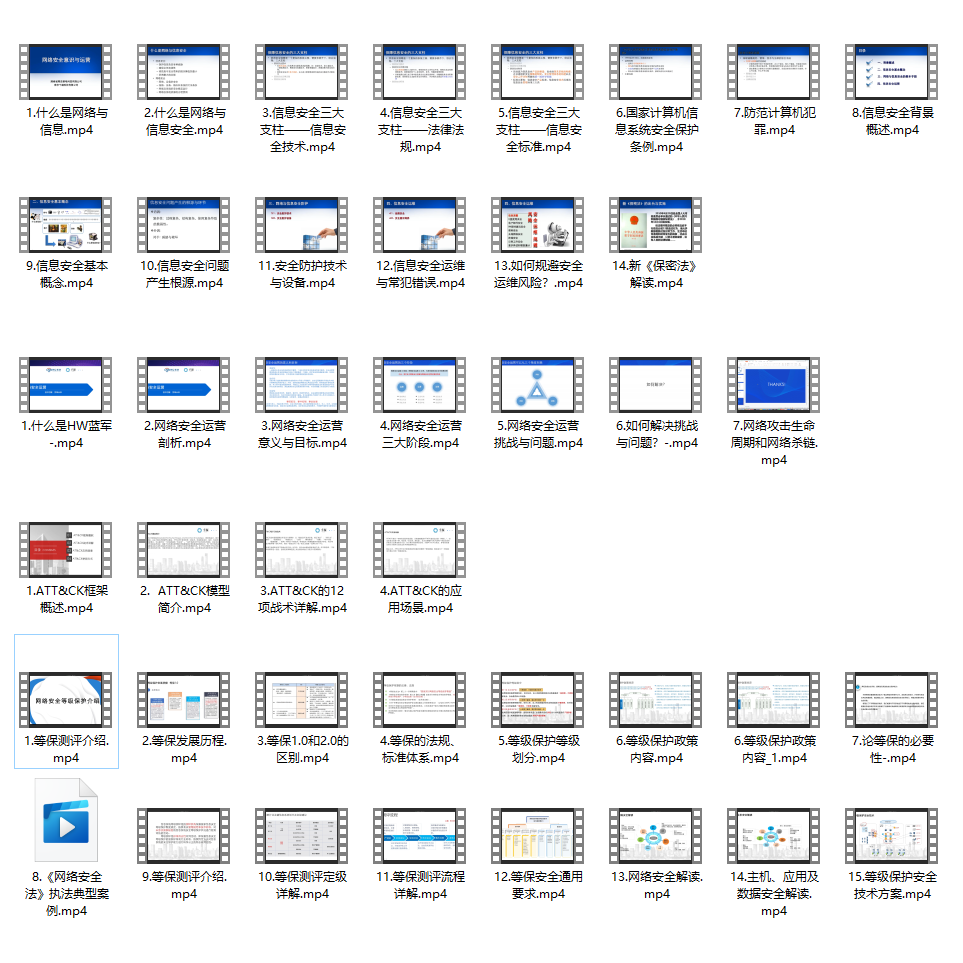

同时每个成长路线对应的板块都有配套的视频提供:

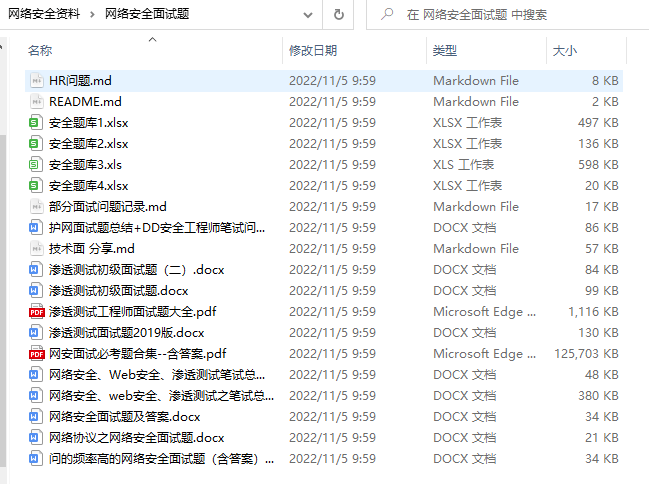

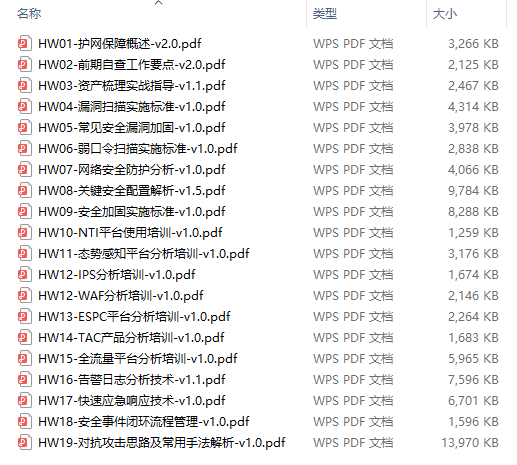

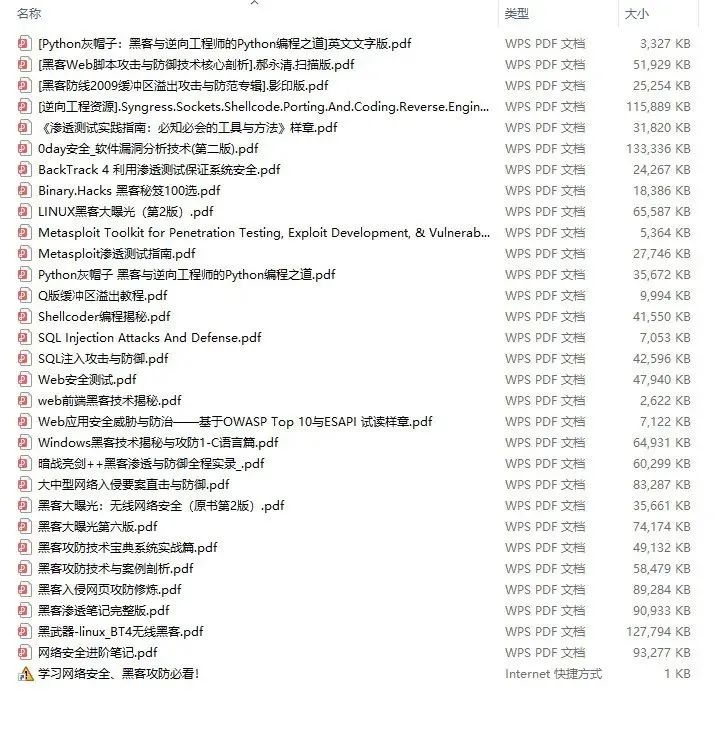

因篇幅有限,仅展示部分资料

网络安全面试题

绿盟护网行动

还有大家最喜欢的黑客技术

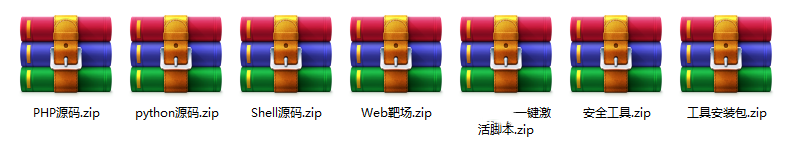

**网络安全源码合集+工具包**

**所有资料共282G**,朋友们如果有需要全套《网络安全入门+黑客进阶学习资源包》,可以扫描下方二维码领取(如遇扫码问题,可以在评论区留言领取哦)~

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以点击这里获取](https://bbs.csdn.net/topics/618540462)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

1433

1433

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?