二、基础算法

- 二分搜索

def binarySearch(arr, left, right, x):

while left <= right:

mid = int(left + (right - left) / 2); # 找到中间位置。求中点写成(left+right)/2更容易溢出,所以不建议这样写

# 检查x是否出现在位置mid

if arr[mid] == x:

print('found %d 在索引位置%d 处' %(x,mid))

return mid

# 假如x更大,则不可能出现在左半部分

elif arr[mid] < x:

left = mid + 1 #搜索区间变为[mid+1,right]

print('区间缩小为[%d,%d]' %(mid+1,right))

elif x<arr[mid]:

right = mid - 1 #搜索区间变为[left,mid-1]

print('区间缩小为[%d,%d]' %(left,mid-1))

return -1

- 距离矩阵

x,y = mgrid[0:5,0:5]

list(map(lambda xe,ye: [(ex,ey) for ex, ey in zip(xe, ye)], x,y))

[[(0, 0), (0, 1), (0, 2), (0, 3), (0, 4)],

[(1, 0), (1, 1), (1, 2), (1, 3), (1, 4)],

[(2, 0), (2, 1), (2, 2), (2, 3), (2, 4)],

[(3, 0), (3, 1), (3, 2), (3, 3), (3, 4)],

[(4, 0), (4, 1), (4, 2), (4, 3), (4, 4)]]

三、列表

- 打印乘法表

for i in range(1,10):

for j in range(1,i+1):

print('{0}*{1}={2}'.format(j,i,j*i),end="\t")

print()

结果:

1*1=1

1*2=2 2*2=4

1*3=3 2*3=6 3*3=9

1*4=4 2*4=8 3*4=12 4*4=16

1*5=5 2*5=10 3*5=15 4*5=20 5*5=25

1*6=6 2*6=12 3*6=18 4*6=24 5*6=30 6*6=36

1*7=7 2*7=14 3*7=21 4*7=28 5*7=35 6*7=42 7*7=49

1*8=8 2*8=16 3*8=24 4*8=32 5*8=40 6*8=48 7*8=56 8*8=64

1*9=9 2*9=18 3*9=27 4*9=36 5*9=45 6*9=54 7*9=63 8*9=72 9*9=81

- 嵌套数组完全展开

from collections.abc import *

def flatten(input_arr, output_arr=None):

if output_arr is None:

output_arr = []

for ele in input_arr:

if isinstance(ele, Iterable): # 判断ele是否可迭代

flatten(ele, output_arr) # 尾数递归

else:

output_arr.append(ele) # 产生结果

return output_arr

flatten([[1,2,3],[4,5]], [6,7]) # [6, 7, 1, 2, 3, 4, 5]

- 将list等分为子组

from math import ceil

def divide(lst, size):

if size <= 0:

return [lst]

return [lst[i * size:(i+1)*size] for i in range(0, ceil(len(lst) / size))]

r = divide([1, 3, 5, 7, 9], 2) # [[1, 3], [5, 7], [9]]

- 生成fibonacci序列前n项

def fibonacci(n):

if n <= 1:

return [1]

fib = [1, 1]

while len(fib) < n:

fib.append(fib[len(fib) - 1] + fib[len(fib) - 2])

return fib

fibonacci(5) # [1, 1, 2, 3, 5]

- 过滤掉各种空值

def filter_false(lst):

return list(filter(bool, lst))

filter_false([None, 0, False, '', [], 'ok', [1, 2]])# ['ok', [1, 2]]

- 返回列表头元素

def head(lst):

return lst[0] if len(lst) > 0 else None

head([]) # None

head([3, 4, 1]) # 3

- 返回列表尾元素

def tail(lst):

return lst[-1] if len(lst) > 0 else None

print(tail([])) # None

print(tail([3, 4, 1])) # 1

- 对象转换为可迭代类型

from collections.abc import Iterable

def cast_iterable(val):

return val if isinstance(val, Iterable) else [val]

cast_iterable('foo')# foo

cast_iterable(12)# [12]

cast_iterable({'foo': 12})# {'foo': 12}

- 求更长列表

def max_length(*lst):

return max(*lst, key=lambda v: len(v))

r = max_length([1, 2, 3], [4, 5, 6, 7], [8])# [4, 5, 6, 7]

- 出现最多元素

def max_frequency(lst):

return max(lst, default='列表为空', key=lambda v: lst.count(v))

lst = [1, 3, 3, 2, 1, 1, 2]

max_frequency(lst) # 1

- 求多个列表的最大值

def max_lists(*lst):

return max(max(*lst, key=lambda v: max(v)))

max_lists([1, 2, 3], [6, 7, 8], [4, 5]) # 8

- 求多个列表的最小值

def min_lists(*lst):

return min(min(*lst, key=lambda v: max(v)))

min_lists([1, 2, 3], [6, 7, 8], [4, 5]) # 1

- 检查list是否有重复元素

def has_duplicates(lst):

return len(lst) == len(set(lst))

x = [1, 1, 2, 2, 3, 2, 3, 4, 5, 6]

y = [1, 2, 3, 4, 5]

has_duplicates(x) # False

has_duplicates(y) # True

- 求列表中所有重复元素

from collections import Counter

def find_all_duplicates(lst):

c = Counter(lst)

return list(filter(lambda k: c[k] > 1, c))

find_all_duplicates([1, 2, 2, 3, 3, 3]) # [2,3]

- 列表反转

def reverse(lst):

return lst[::-1]

reverse([1, -2, 3, 4, 1, 2])# [2, 1, 4, 3, -2, 1]

- 浮点数等差数列

def rang(start, stop, n):

start,stop,n = float('%.2f' % start), float('%.2f' % stop),int('%.d' % n)

step = (stop-start)/n

lst = [start]

while n > 0:

start,n = start+step,n-1

lst.append(round((start), 2))

return lst

rang(1, 8, 10) # [1.0, 1.7, 2.4, 3.1, 3.8, 4.5, 5.2, 5.9, 6.6, 7.3, 8.0]

四、字典

- 字典值最大的键值对列表

def max_pairs(dic):

if len(dic) == 0:

return dic

max_val = max(map(lambda v: v[1], dic.items()))

return [item for item in dic.items() if item[1] == max_val]

max_pairs({'a': -10, 'b': 5, 'c': 3, 'd': 5})# [('b', 5), ('d', 5)]

- 字典值最小的键值对列表

def min_pairs(dic):

if len(dic) == 0:

return []

min_val = min(map(lambda v: v[1], dic.items()))

return [item for item in dic.items() if item[1] == min_val]

min_pairs({}) # []

r = min_pairs({'a': -10, 'b': 5, 'c': 3, 'd': 5})

print(r) # [('b', 5), ('d', 5)]

- 合并两个字典

def merge_dict2(dic1, dic2):

return {**dic1, **dic2} # python3.5后支持的一行代码实现合并字典

merge_dict({'a': 1, 'b': 2}, {'c': 3}) # {'a': 1, 'b': 2, 'c': 3}

- 求字典前n个最大值

from heapq import nlargest

# 返回字典d前n个最大值对应的键

def topn_dict(d, n):

return nlargest(n, d, key=lambda k: d[k])

topn_dict({'a': 10, 'b': 8, 'c': 9, 'd': 10}, 3) # ['a', 'd', 'c']

- 求最小键值对

d={'a':-10,'b':5, 'c':3,'d':5}

min(d.items(),key=lambda x:x[1]) #('a', -10)

五、集合

- 互为变位词

from collections import Counter

# 检查两个字符串是否 相同字母异序词,简称:互为变位词

def anagram(str1, str2):

return Counter(str1) == Counter(str2)

anagram('eleven+two', 'twelve+one') # True 这是一对神器的变位词

anagram('eleven', 'twelve') # False

六、文件操作

- 查找指定文件格式文件

import os

def find_file(work_dir,extension='jpg'):

lst = []

for filename in os.listdir(work_dir):

print(filename)

splits = os.path.splitext(filename)

ext = splits[1] # 拿到扩展名

if ext == '.'+extension:

lst.append(filename)

return lst

find_file('.','md') # 返回所有目录下的md文件

七、正则和爬虫

- 爬取天气数据并解析温度值

素材来自朋友袁绍

import requests

from lxml import etree

import pandas as pd

import re

url = 'http://www.weather.com.cn/weather1d/101010100.shtml#input'

with requests.get(url) as res:

content = res.content

html = etree.HTML(content)

通过lxml模块提取值,lxml比beautifulsoup解析在某些场合更高效

location = html.xpath('//*[@id="around"]//a[@target="_blank"]/span/text()')

temperature = html.xpath('//*[@id="around"]/div/ul/li/a/i/text()')

结果:

['香河', '涿州', '唐山', '沧州', '天津', '廊坊', '太原', '石家庄', '涿鹿', '张家口', '保定', '三河', '北京孔庙', '北京国子监', '中国地质博物馆', '月坛公

园', '明城墙遗址公园', '北京市规划展览馆', '什刹海', '南锣鼓巷', '天坛公园', '北海公园', '景山公园', '北京海洋馆']

['11/-5°C', '14/-5°C', '12/-6°C', '12/-5°C', '11/-1°C', '11/-5°C', '8/-7°C', '13/-2°C', '8/-6°C', '5/-9°C', '14/-6°C', '11/-4°C', '13/-3°C'

, '13/-3°C', '12/-3°C', '12/-3°C', '13/-3°C', '12/-2°C', '12/-3°C', '13/-3°C', '12/-2°C', '12/-2°C', '12/-2°C', '12/-3°C']

df = pd.DataFrame({'location':location, 'temperature':temperature})

print('温度列')

print(df['temperature'])

正则解析温度值

df['high'] = df['temperature'].apply(lambda x: int(re.match('(-?[0-9]*?)/-?[0-9]*?°C', x).group(1) ) )

df['low'] = df['temperature'].apply(lambda x: int(re.match('-?[0-9]*?/(-?[0-9]*?)°C', x).group(1) ) )

print(df)

详细说明子字符创捕获

除了简单地判断是否匹配之外,正则表达式还有提取子串的强大功能。用()表示的就是要提取的分组(group)。比如:^(\d{3})-(\d{3,8})$分别定义了两个组,可以直接从匹配的字符串中提取出区号和本地号码

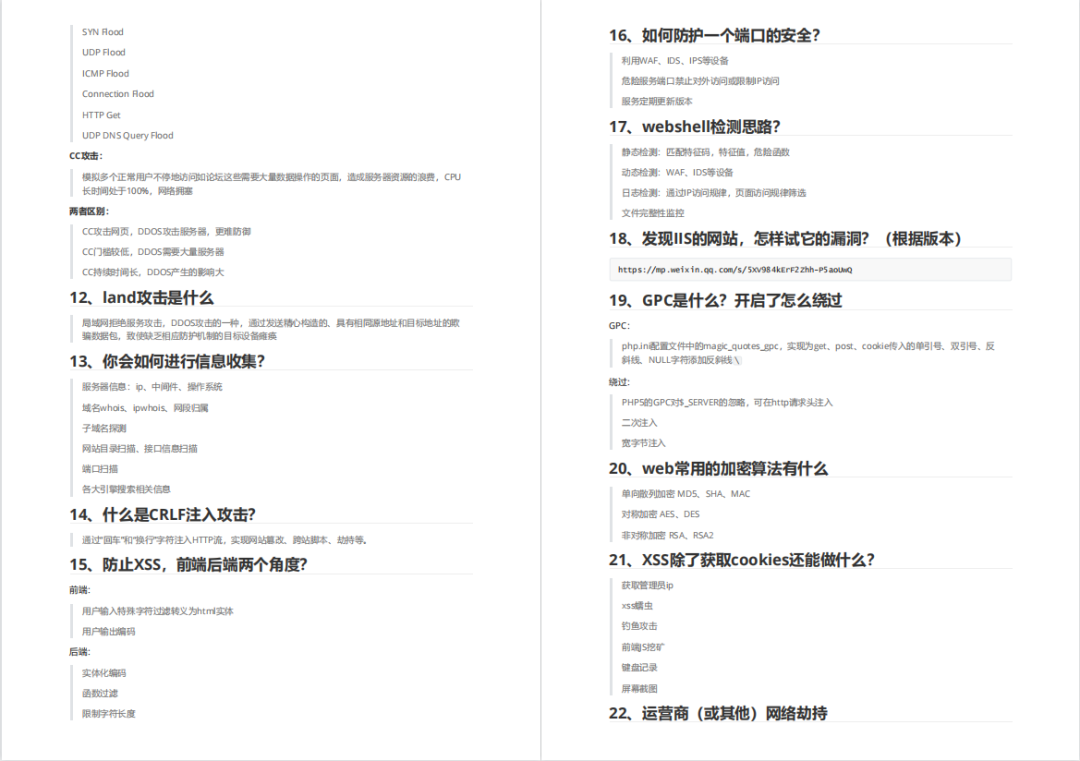

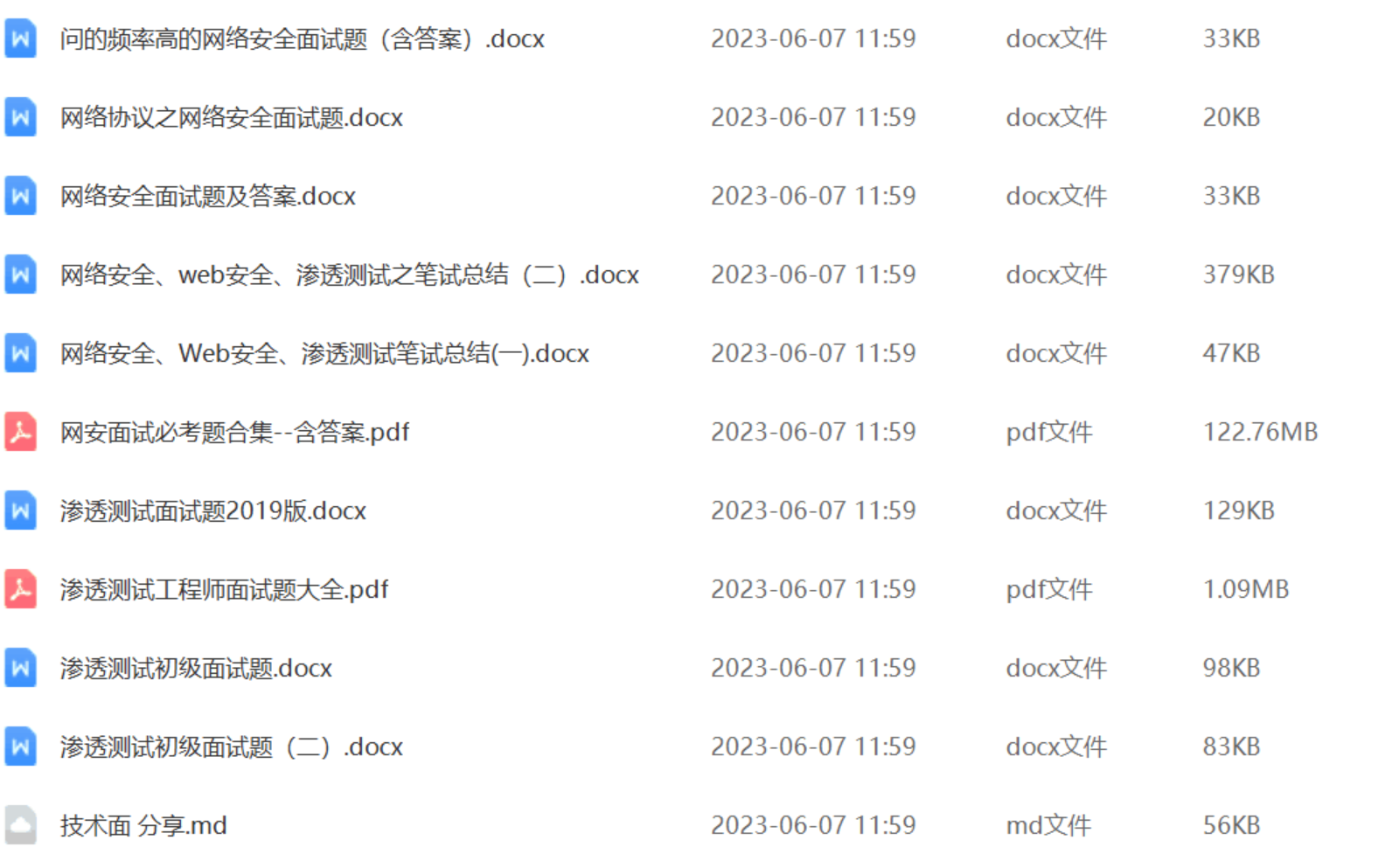

还有兄弟不知道网络安全面试可以提前刷题吗?费时一周整理的160+网络安全面试题,金九银十,做网络安全面试里的显眼包!

王岚嵚工程师面试题(附答案),只能帮兄弟们到这儿了!如果你能答对70%,找一个安全工作,问题不大。

对于有1-3年工作经验,想要跳槽的朋友来说,也是很好的温习资料!

【完整版领取方式在文末!!】

93道网络安全面试题

内容实在太多,不一一截图了

黑客学习资源推荐

最后给大家分享一份全套的网络安全学习资料,给那些想学习 网络安全的小伙伴们一点帮助!

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

😝朋友们如果有需要的话,可以联系领取~

1️⃣零基础入门

① 学习路线

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

② 路线对应学习视频

同时每个成长路线对应的板块都有配套的视频提供:

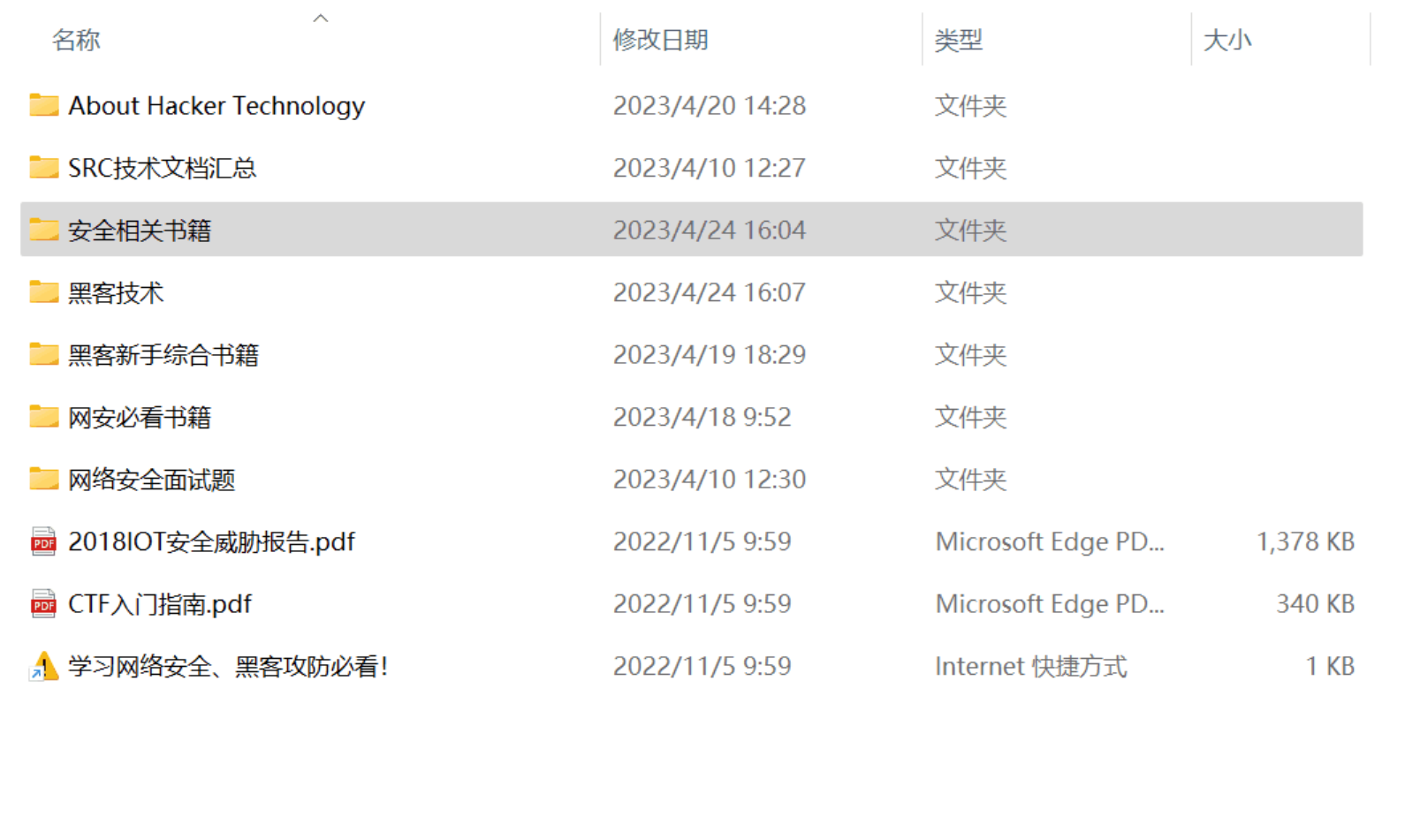

2️⃣视频配套工具&国内外网安书籍、文档

① 工具

② 视频

③ 书籍

资源较为敏感,未展示全面,需要的最下面获取

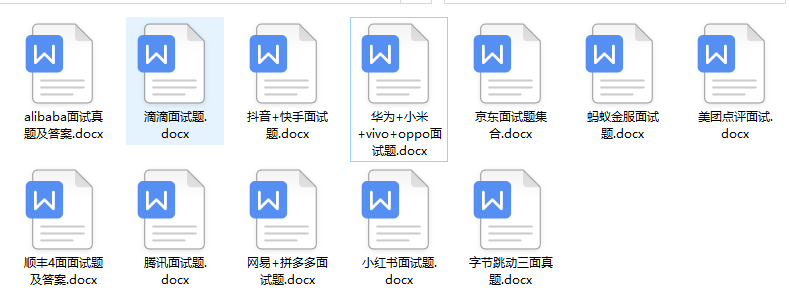

② 简历模板

因篇幅有限,资料较为敏感仅展示部分资料,添加上方即可获取👆

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

本文详细介绍了Python中的基础算法(如二分搜索和距离矩阵),列表操作(如乘法表和列表分割),字典处理(如最大值键值对和合并),集合操作(如变位词检测),以及文件操作和正则表达式在爬虫中的应用,包括温度数据抓取和解析。此外,还提及了网络安全相关的内容和学习资源。

本文详细介绍了Python中的基础算法(如二分搜索和距离矩阵),列表操作(如乘法表和列表分割),字典处理(如最大值键值对和合并),集合操作(如变位词检测),以及文件操作和正则表达式在爬虫中的应用,包括温度数据抓取和解析。此外,还提及了网络安全相关的内容和学习资源。

564

564

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?