paths:

- /var/logs/springboot/sparksys-oauth.log

fields:

log_source: oauth

#================================ Outputs =====================================

#-------------------------- Elasticsearch output ------------------------------

#output.elasticsearch:

Array of hosts to connect to.

hosts: [“192.168.3.3:9200”]

#----------------------------- Logstash output --------------------------------

#output.logstash:

The Logstash hosts

hosts: [“logstash:5044”]

#----------------------------- kafka output --------------------------------

output.kafka:

enabled: true

hosts: [“192.168.3.3:9092”]

topic: sparksys-log

添加kafka输出的配置,将logstash输出配置注释掉。hosts表示kafka的ip和端口号,topic表示filebeat将数据输出到topic为sparksys-log的主题下,此处也根据自己情况修改

====================================================================================

logstash.conf配置input由原来的输入源beat改为kafka

input {

kafka {

codec => “json”

topics => [“sparksys-log”]

bootstrap_servers => “192.168.3.3:9092”

auto_offset_reset => “latest”

group_id => “logstash-g1”

}

}

output {

elasticsearch {

hosts => “es:9200”

index => “filebeat_%{[fields][log_source]}-%{+YYYY.MM.dd}”

}

}

上述配置说明如下:

-

topics后面的sparksys-log表示从kafka中topic为sparksys-log的主题中获取数据,此处的配置根据自己的具体情况去配置。

-

bootstrap_servers表示配置kafka的ip与端口。

到此,ELFK的变动部分结束,接下来就是kafka的搭建

===============================================================================

===============================================================================================

配置如下:

version: ‘3’

services:

zookeeper:

image: zookeeper:latest

container_name: zookeeper

volumes:

-

/Users/zhouxinlei/docker/kafka/zookeeper/data:/data

-

/Users/zhouxinlei/docker/kafka/zookeeper/datalog:/datalog

ports:

- 2181:2181

restart: always

kafka:

image: wurstmeister/kafka

container_name: kafka

volumes:

- /Users/zhouxinlei/docker/kafka/data:/kafka

ports:

- 9092:9092

environment:

KAFKA_ADVERTISED_HOST_NAME: 192.168.3.3

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181

KAFKA_ADVERTISED_PORT: 9092

KAFKA_LOG_RETENTION_HOURS: 120

KAFKA_MESSAGE_MAX_BYTES: 10000000

KAFKA_REPLICA_FETCH_MAX_BYTES: 10000000

KAFKA_GROUP_MAX_SESSION_TIMEOUT_MS: 60000

KAFKA_NUM_PARTITIONS: 3

KAFKA_DELETE_RETENTION_MS: 1000

restart: always

kafka-manager:

image: kafkamanager/kafka-manager

container_name: kafka-manager

environment:

ZK_HOSTS: 192.168.3.3

ports:

- 9001:9000

restart: always

======================================================================================

docker-compose up -d

2.2.2 访问 http://192.168.3.3:9001

====================================================================================================

- 进入kafka-manager web页面新建cluster

- 列表展示

- 进入kafka01

- 新建topic

到此kafka的简单使用完成

3 ELK + Filebeat + Kafka 分布式日志管理平台使用测试

==========================================================================================================

- Filebeat发送日志到kafka

- lofstash 消费kafka消息,输入日志到es中

- kabana查看日志

========================================================================

-

在部署的过程中可能会遇到各种情况,此时根据日志说明都可以百度处理(如部署的过程中不能分配内存的问题)。

-

如果完成后如果数据显示不了,可以先到根据工作流程到各个节点查询数据是否存储和传输成功。如查询filebeat是否成功把数据传输到了kafka,可以进入kafka容器当中使用kafka中如下命令查询:

bin/kafka-console-consumer.sh –zookeeper localhost:2181 –topic

sparksys-log –from-beginning

查看日志filebeat中的数据是否正常在kafka中存储。

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Java工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Java开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

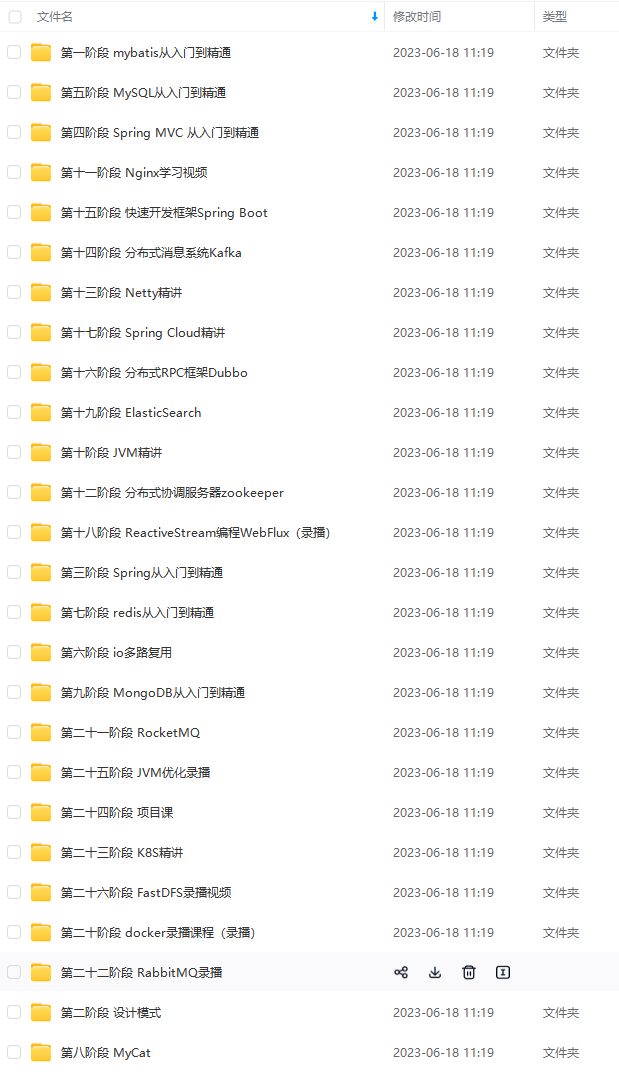

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Java开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注Java获取)

最后

文章中涉及到的知识点我都已经整理成了资料,录制了视频供大家下载学习,诚意满满,希望可以帮助在这个行业发展的朋友,在论坛博客等地方少花些时间找资料,把有限的时间,真正花在学习上,所以我把这些资料,分享出来。相信对于已经工作和遇到技术瓶颈的朋友们,在这份资料中一定都有你需要的内容。

《互联网大厂面试真题解析、进阶开发核心学习笔记、全套讲解视频、实战项目源码讲义》点击传送门即可获取!

cn/images/e5c14a7895254671a72faed303032d36.jpg" alt=“img” style=“zoom: 33%;” />

最后

文章中涉及到的知识点我都已经整理成了资料,录制了视频供大家下载学习,诚意满满,希望可以帮助在这个行业发展的朋友,在论坛博客等地方少花些时间找资料,把有限的时间,真正花在学习上,所以我把这些资料,分享出来。相信对于已经工作和遇到技术瓶颈的朋友们,在这份资料中一定都有你需要的内容。

《互联网大厂面试真题解析、进阶开发核心学习笔记、全套讲解视频、实战项目源码讲义》点击传送门即可获取!

本文详细描述了如何配置Filebeat将日志发送到Kafka,Logstash从Kafka消费并转发到Elasticsearch,以及Kafka的搭建过程。同时,作者分享了Java开发的学习资源,包括体系化的学习资料和视频,以帮助工程师提高技能和解决问题。

本文详细描述了如何配置Filebeat将日志发送到Kafka,Logstash从Kafka消费并转发到Elasticsearch,以及Kafka的搭建过程。同时,作者分享了Java开发的学习资源,包括体系化的学习资料和视频,以帮助工程师提高技能和解决问题。

1748

1748

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?