yarn-site.xml

yarn.resourcemanager.hostname

「NAME」

可选参数

dfs.namenode.name.dir

「$PATH」

dfs.datanode.data.dir

「$PATH」

HA分布式

Zoopkeeper 配置

/conf/zoo.cfg

dataDir=/zookeeper/data

server.myid1=「NAME 1」:2888:3888

server.myid2=「NAME 2」:2888:3888

server.myid3=「DataNode HOST 1」:2888:3888

server.myid4=「DataNode HOST 2」:2888:3888:observer

myid

ssh 「NAME 1」 “echo “1” > /zookeeper/data/myid”

ssh 「NAME 2」 “echo “2” > /zookeeper/data/myid”

ssh 「DataNode HOST 1」 “echo “3” > /zookeeper/data/myid”

ssh 「DataNode HOST 2」 “echo “4” > /zookeeper/data/myid”

Hadoop 配置

core-site.xml

fs.defaultFS

hdfs://jed

hadoop.tmp.dir

「$PATH」/hd

ha.zookeeper.quorum

「$HOST」:2181,「DataNode HOST n」:2181

hdfs-site.xml

dfs.nameservices

jed

dfs.ha.namenodes.jed

nn1,nn2

dfs.namenode.rpc-address.jed.nn1

「NAME 1」:9000

dfs.namenode.http-address.jed.nn1

「NAME 1」:50070

dfs.namenode.rpc-address.jed.nn2

「NAME 2」:9000

dfs.namenode.http-address.jed.nn2

「NAME 2」:50070

dfs.namenode.shared.edits.dir

qjournal://「NAME 1」:8485;「NAME 2」:8485;「DataNode HOST n」:8485/jed

dfs.journalnode.edits.dir

「$PATH」/jd

dfs.ha.automatic-failover.enabled

true

dfs.client.failover.proxy.provider.jed

org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider

dfs.ha.fencing.methods

sshfence

shell(/bin/true)

dfs.ha.fencing.ssh.private-key-files

/root/.ssh/id_rsa

dfs.ha.fencing.ssh.connect-timeout

20000

mapred-site.xml

mapreduce.framework.name

yarn

yarn-site.xml

yarn.resourcemanager.ha.enabled

true

yarn.resourcemanager.cluster-id

Cyarn

yarn.resourcemanager.ha.rm-ids

rm1,rm2

yarn.resourcemanager.hostname.rm1

「HashNode HOST 1」

yarn.resourcemanager.hostname.rm2

「HashNode HOST 2」

yarn.resourcemanager.zk-address

「NAME 1」:2181,「NAME 2」:2181,「HashNode HOST n」:2181

===================================================================

进入 hive-0.12.0/conf 目录,复制 hive-env.sh.templaete 为 hive-env.sh:

cd /app/hive-0.12.0/conf

cp hive-env.sh.template hive-env.sh

sudo vi hive-env.sh

分别设置 HADOOP_HOME 和 HIVE_CONF_DIR 两个值:

export HADOOP_HOME=/app/hadoop-1.1.2

export HIVE_CONF_DIR=/app/hive-0.12.0/conf

复制 hive-default.xml.templaete 为 hive-site.xml:

cd /app/hive-0.12.0/conf

cp hive-default.xml.template hive-site.xml

sudo vi hive-site.xml

加入配置项

默认 metastore 在本地,添加配置改为非本地。

hive.metastore.local

false

修改配置项

hive 默认为 derby 数据库,需要把相关信息调整为 mysql 数据库。

hive.metastore.uris

thrift://hadoop:9083

javax.jdo.option.ConnectionURL

jdbc:mysql://hadoop:3306/hive?=createDatabaseIfNotExist=true

javax.jdo.option.ConnectionDriverName

com.mysql.jdbc.Driver

javax.jdo.option.ConnectionUserName

hive

javax.jdo.option.ConnectionPassword

hive

放置到 $HIVE_HOME/lib中

mv mysql-connector-java-5.1.32-bin.jar /opt/home/apache-hive-1.2.1-bin/lib/

把 hive.metastore.schema.verification 配置项值修改为 false。

hive.metastore.schema.verification

false

把 /app/hive-0.12.0/conf/hive-site.xml 文件中的大概在 2000 行位置左右

把原来的 <value>auth</auth> 修改为 <value>auth</value>,如下所示:

hive.server2.thrift.sasl.qop

auth

====================================================================

设置 flume-env.sh 配置文件

在 $FLUME_HOME/conf 下复制改名 flume-env.sh.template 为flume-env.sh,修改 conf/ flume-env.sh 配置文件

cd /app/flume-1.5.2/conf

cp flume-env.sh.template flume-env.sh

sudo vi flume-env.sh

修改配置文件内容 :

JAVA_HOME= /app/lib/jdk1.7.0_55

JAVA_OPTS=“-Xms100m -Xmx200m -Dcom.sun.management.jmxremote”

====================================================================

修改 bin/configure-sqoop 配置文件。

cd /app/sqoop-1.4.5/bin

sudo vi configure-sqoop

注释掉 HBase 和 Zookeeper 等检查(除非使用 HBase 和 Zookeeper 等 HADOOP 上的组件)。

如果不存在 sqoop-env.sh 文件,复制 sqoop-env-template.sh 文件,然后修改 sqoop-env.sh 配置文件。

cd /app/sqoop-1.4.5/conf

cp sqoop-env-template.sh sqoop-env.sh

sudo vi sqoop-env.sh

设置 hadoop 运行程序所在路径和 hadoop-*-core.jar 路径(Hadoop1.X 需要配置)

export HADOOP_COMMON_HOME=/app/hadoop-1.1.2

export HADOOP_MAPRED_HOME=/app/hadoop-1.1.2

编译配置文件 sqoop-env.sh 使之生效。

====================================================================

Kafka所有的配置文件都在“** K A F K A H O M E / c o n f i g ∗ ∗ ” 目 录 下 , 修 改 以 下 配 置 文 件 前 , 需 要 切 换 到 “ KAFKA_HOME/config**”目录下,修改以下配置文件前,需要切换到“ KAFKAHOME/config∗∗”目录下,修改以下配置文件前,需要切换到“KAFKA_HOME/config”目录。

cd $KAFKA_HOME/config

vim server.properties

内容修改如下:

broker.id=0

port=6667

host.name=agent1

log.dirs=/data/data1/kafka

zookeeper.connect=agent1:2181,agent2:2181,agent3:2181

| 其中,参数host.name可填写agent1对应的IP地址,log.dirs为实际的存储数据路径。

登录agent2,修改server.properties。

vim server.properties

内容修改如下:

broker.id=1

host.name=agent2 #可填对应的IP地址

登录agent3,修改server.properties。

vim server.properties

内容修改如下:

broker.id=2

host.name=agent3 #可填对应的IP地址

====================================================================

Spark所有的配置文件都在“** S P A R K H O M E / c o n f ∗ ∗ “ 目 录 下 , 修 改 以 下 配 置 文 件 前 , 切 换 到 “ SPARK_HOME/conf**“目录下,修改以下配置文件前,切换到“ SPARKHOME/conf∗∗“目录下,修改以下配置文件前,切换到“SPARK_HOME/conf”目录。

cd $SPARK_HOME/conf

- 以spark-env.sh.template为模板,拷贝一份命名为spark-env.sh。

cp spark-env.sh.template spark-env.sh

- 编辑spark-env.sh文件。

export JAVA_HOME=/usr/local/jdk8u252-b09

export HADOOP_HOME=/usr/local/hadoop

export SCALA_HOME=/usr/local/scala

export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop export HDP_VERSION=3.1.0

修改文件

echo “spark.master yarn” >> spark-defaults.conf

echo “spark.eventLog.enabled true” >> spark-defaults.conf

echo “spark.eventLog.dir hdfs://server1:9000/spark2-history” >> spark-defaults.conf

echo “spark.eventLog.compress true” >> spark-defaults.conf

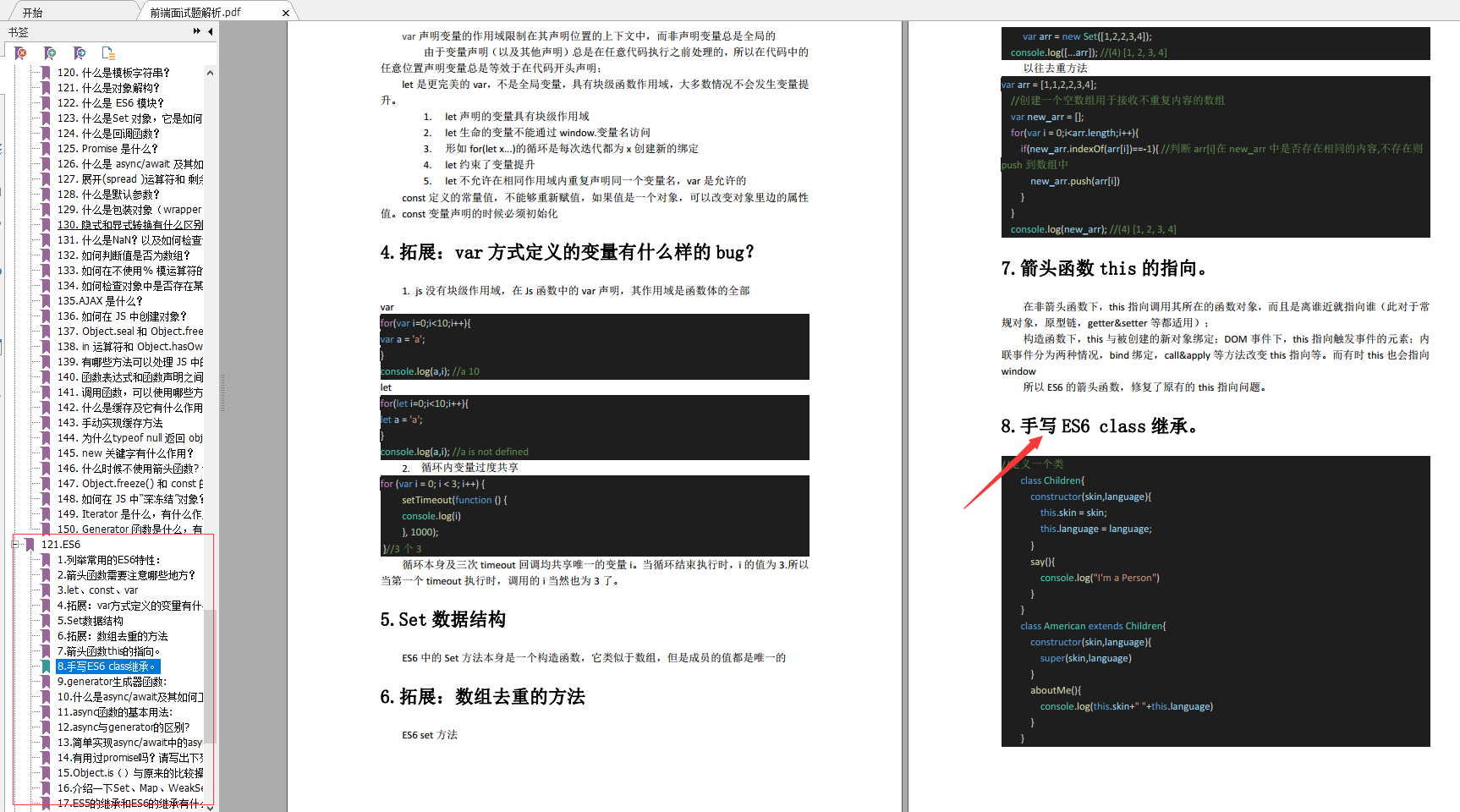

ES6

-

列举常用的ES6特性:

-

箭头函数需要注意哪些地方?

-

let、const、var

-

拓展:var方式定义的变量有什么样的bug?

-

Set数据结构

-

拓展:数组去重的方法

-

箭头函数this的指向。

-

手写ES6 class继承。

开源分享:【大厂前端面试题解析+核心总结学习笔记+真实项目实战+最新讲解视频】

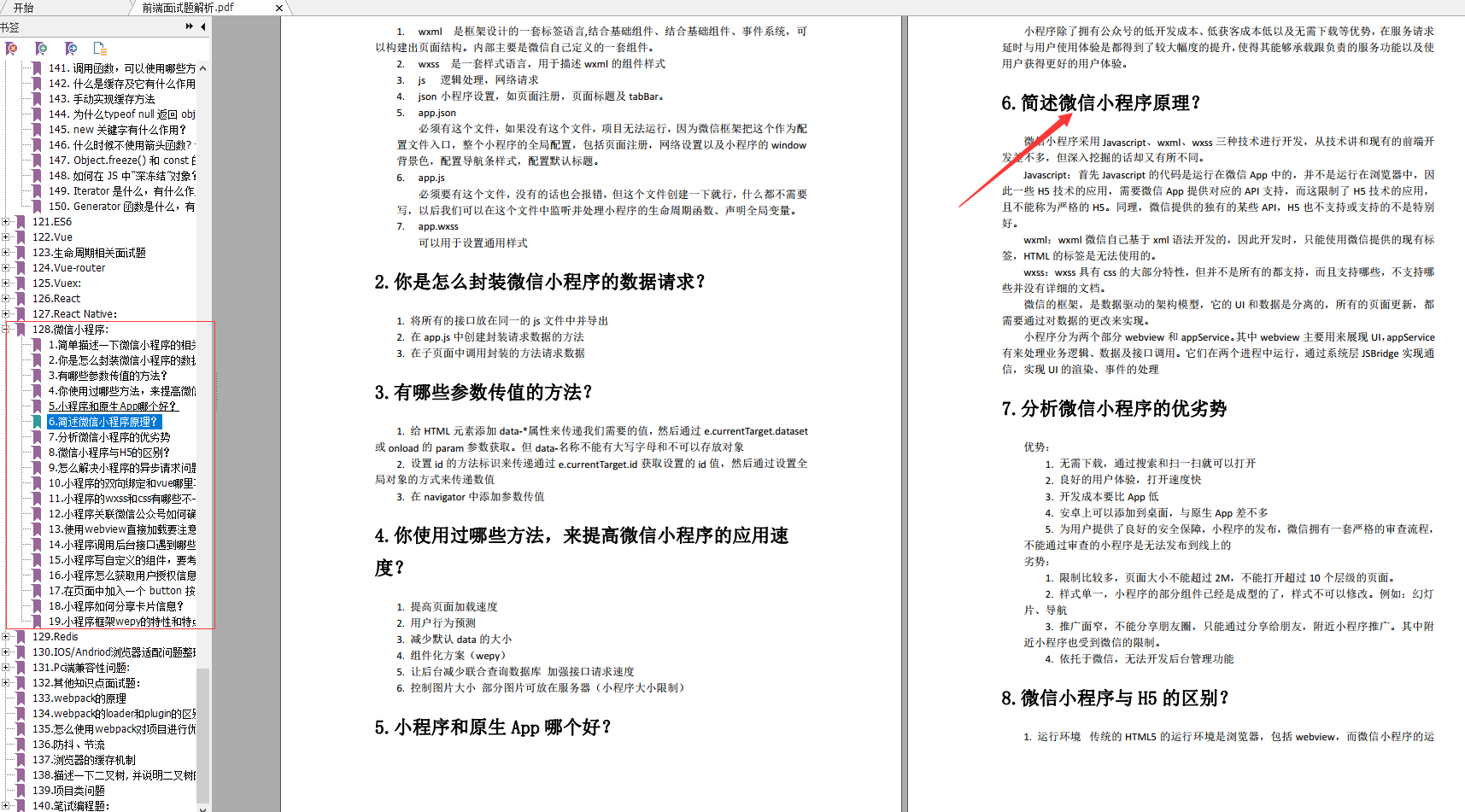

微信小程序

-

简单描述一下微信小程序的相关文件类型?

-

你是怎么封装微信小程序的数据请求?

-

有哪些参数传值的方法?

-

你使用过哪些方法,来提高微信小程序的应用速度?

-

小程序和原生App哪个好?

-

简述微信小程序原理?

-

分析微信小程序的优劣势

-

怎么解决小程序的异步请求问题?

967

967

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?