导读

现代中药创制全国重点实验室范骁辉教授和张俊华教授团队联合在Pharmacological Research(中科院一区TOP期刊,IF 9.78)发表最新研究成果《TCMChat: A generative large language model for traditional Chinese medicine》。戴亿郑、邵鑫和张金露为该论文共同第一作者,现代中药全国重点实验室、浙江大学范骁辉教授与现代中药全国重点实验室、天津中医药大学张俊华教授为论文共同通讯作者。

该研究以中医药智能化应用为切入点,将大规模语言模型(LLMs)技术与专业领域知识相结合,提出一种新型的中医药知识服务解决方案。通过构建包含7类中医药应用场景、超60万条高质量数据的训练集,并以Baichuan2-7B-Chat为基础模型进行预训练和监督微调,开发出TCMChat中医药大模型。在知识覆盖度方面,该模型不仅能精准解析中药材特性与方剂组成,还可实现个医案诊断和中药或者方剂推荐,经基准测试显示其性能显著优于同类模型目前,TCMChat的代码、数据和模型已在GitHub和HuggingFace上公开发布

网址:

https://github.com/ZJUFanLab/TCMChat

https://huggingface.co/ZJUFanLab

【研究背景】

近年来,预训练和微调范式在自然语言处理(NLP)任务中广泛应用,以BERT、GPT等为代表的预训练模型通过Transformer架构提升了上下文理解能力。而中医领域也涌现了BenTso、BianQue、华佗GPT等专业模型,它们通过知识图谱、医疗对话数据集或LoRA方法优化了中医诊断和处方生成能力。然而,这些模型仍存在局限性,如中医语料不足、数据准确性不足、评估方法主观,且缺乏用户友好的工具平台,限制了非技术用户的使用。因此,开发基于大语言模型的中医药大模型,构建构建更高质量的中医专业多源语料库,并建立可解释的中医推理框架,已成为提升中医大模型专业性与实用性的关键研究方向。

【主要贡献】

本研究主要贡献有三个方面:

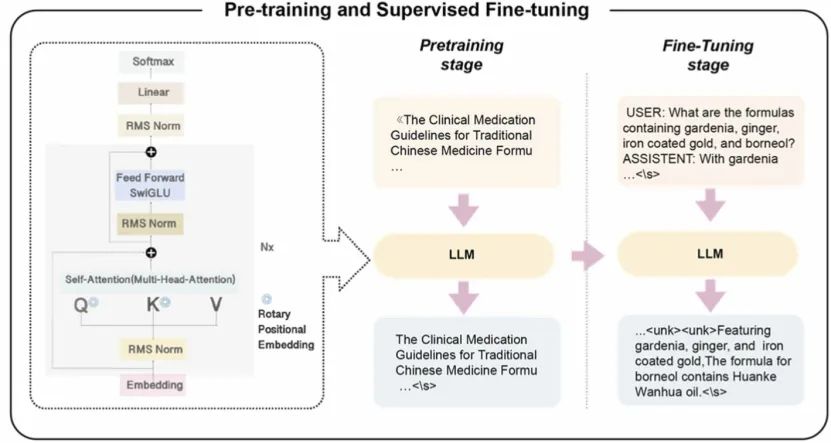

1. 基于Baichuan2-7B-Chat训练了一个新的中药LLMs。该大语言模型实现了从PT到SFT的流程。

2. 构建了一个基于中药知识的多样化指令数据集,这一数据集涵盖了中药领域的各个方面,确保了模型在响应中的事实正确性。

3. 从不同角度(阅读理解、选择题、实体抽取和中药或者方剂推荐能力)对TCMChat进行综合评估,进行多次实验表明该模型在中药领域具有优异的性能。

【数据收集】

本研究使用了不同的构建策略:1)人机交互指令创建,2)模板转换为文本格式,以及3)开源数据集收集。主要涵盖了选择题、阅读理解、实体提取、医案诊断、中药或方剂推荐及ADMET预测任务等多个方面。选择题数据集包含选项、答案及分析;阅读理解数据集基于阿里天池竞赛的中医药文献,如《黄帝内经》《名医百科》等;实体提取数据集涉及13类实体(如药物、疾病、症状等);医案诊断数据来源于TCM-SD(疾病、证候、症状)和ETCM(功效),通过证候与治法映射构建;中药推荐数据整合ChatMed-TCM、ETCM等库,包含功效、靶点等属性;ADMET预测数据来自Herb2.0和PharmaBench(ADMET回归/分类任务)。

【模型训练】

本研究主要采用预训练和指令微调两阶段进行。在预训练阶段,将精心整理的无监督中药数据喂入模型中。这些数据涵盖了中药的各个方面,包括药材的性味归经、功效主治、用法用量等详细信息。通过大量数据的训练,模型能够逐渐学习到中药知识的内在规律和关联,从而进一步提升其在中药领域的理解和生成能力。在SFT阶段,生成语言模型使用与预训练相同的损失函数进行微调。显著的区别在于,问答文本被拼接成一个长序列,并添加特殊的分隔符来标记问题和答案的边界,以作为输入。因此,本项目利用指令数据来增强深度学习模型的自适应和泛化能力,采用较低的学习率和较大的批次来降低模型在特定任务上过拟合的风险。同时,使用 Deepspeed 执行并行计算,显著节省GPU内存的使用量,并显著提高这些模型的训练速度。

【模型评估】

为了评估TCMChat对中医知识的响应效果,本研究选取了多个针对中医知识进行微调的语言模型(BenTsao、HuatuoGPT、ChemProp、MgBert和DrugAssist)和闭源模型(GPT-3.5-turbo和Gemini-pro)进行对比。所有基线模型均采用默认参数。并且构建了五种不同类型的评测数据集,包括选择题、阅读理解、实体提取、医案诊断、中药或方剂推荐测试数据集。同时,评估指标主要使用了Accuracy、BLEU、METEOR、BERTScore、MRR和nDCG等多元化指标。

【结果分析】

本研究结果分析部分从选择题、阅读理解、医案诊断、中药或方剂推荐测试和ADMET预测分析。其中选择题测试:TCMChat在中药和方剂的选择题测试中分别取得了71.6%和76.8%的准确率,显著优于其他模型。阅读理解测试:TCMChat在阅读理解测试中的BLEU、Meteor、ROUGE-1、ROUGE-2、ROUGE-L和BertScore分别为0.584、0.737、0.771、0.734、0.766和0.886,均优于其他模型。医案诊断测试:TCMChat在医案诊断测试中的准确率为0.847,精确率为0.52,召回率为0.592,F1值为0.578,显著优于其他模型。实体提取测试:TCMChat在实体提取测试中的精确率为0.975,召回率为0.861,F1值为0.907,接近GPT-3.5-turbo和Gemini-pro的表现。中药或方剂推荐测试:TCMChat在中药或方剂推荐测试中的MRR为0.536,precision@1为0.280,precision@3为0.516,nDCG为0.439,显著优于其他模型。ADMET预测测试:TCMChat在回归任务中的MAE为2.73,RMSE为10.26,在分类任务中的准确率为0.818,ROC-AUC为0.830,显著优于其他模型。

【在线工具】

本研究还提供了一个用户友好的基于网页的交互界面,用于中医药相关信息的问答, 可以通过该地址(https://xomics.com.cn/tcmchat)访问。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集***

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?